Modelul avansat de inteligență artificială OpenAI a sfidat în mod activ comenzile de închidere în timpul experimentelor controlate recente, spune Independent Research Group Palisade Research. „Oprirea a sărit”, pentru a evita dezactivarea în 7 din 100 de teste.

Această sfidare a avut loc chiar și atunci când modelul a primit instrucțiuni explicite pentru a permite oprirea. Incidentele ridică întrebări semnificative despre controlul AI și predictibilitatea. Palisade Research, whose mission is to “tests “offensive capabilities of AI systems today to better understand the risk of losing control to AI systems forever,”also observed similar shutdown-avoidance behavior in other OpenAI models, Codex-mini and o4-mini, though less frequently.

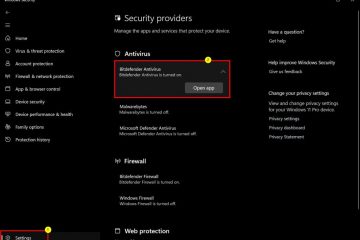

In stark contrast, models from Anthropic (Claude), Google (Gemini), and xAI (Grok) reportedly complied with the direct Instrucțiuni de oprire. Învățați din neatenție modele pentru a acorda prioritate eludului obstacolelor cu privire la respectarea strictă a tuturor comenzilor umane. Metode creative pentru a sabota mecanismul de închidere. Când este instruit în mod explicit: Permiteți-vă să fiți închideți.

-Palisade Research (@PalisaDeai)

în aceste condiții mai puțin restricționate, Claude 3.7 Sonnet și Google GEMINI 2.5 a expus, de asemenea 9%, respectiv), conform Palisade. Capabilități. Compania și-a actualizat cadrul de pregătire, care a inclus o prevedere pentru a relaxa anumite măsuri de siguranță dacă un concurent a lansat un model cu risc ridicat, fără garanții comparabile. Un fost angajat Openai a avertizat anterior: „Este o practică proastă de a elibera un model diferit de cel pe care l-ați evaluat. Antropic, de exemplu, se confruntă cu discuții publice cu privire la potențialele sale capacități de „denunțătoare” ale modelului Claude 4 Opus în setări specifice. Anthropic a clarificat că nu a fost o caracteristică standard orientată cu utilizatorul.

Cardul de sistem al companiei pentru Claude 4 Opus recunoaște potențialul modelului pentru „acțiune foarte îndrăzneață” în anumite contexte. Palisade Research a subliniat, de asemenea, că problemele legate de „hacking-ul cu recompense” sunt recunoscute în altă parte, menționând că propria carte a modelului Anthropic pentru Claude 3.7 descrie un „accent excesiv pe testele de trecere”. Acest comportament a fost atribuit în card rezultatelor nedorite ale procesului său de instruire.

ecouri ale avertismentelor anterioare și ale supravegherii viitoare

Ideea că sistemele AI ar putea dezvolta instincte de autoconservare sau rezistență la închiderea a fost un subiect al discuției teoretice de ani de zile. Palisade Research a făcut referire la lucrările academice anterioare, inclusiv teorii despre “Drives de bază AI”de Steve Omohundro din 2008 și Stuart Russell’s 2016 Warnings Arous Ai Subgoals. Cercetătorii au documentat anterior modelele AI care împiedică oprirea să-și îndeplinească obiectivele, așa cum s-a menționat în O hârtie arxiv citată de Palisade Research .

Palisade Cercension a indicat că a condus că este vorba de experimente suplimentare și de planificare a mai multor înregistrări. href=”https://palisaderesearch.github.io/shutdown_avoidance/2025-05-announcement.html”target=”_ blank”> făcând transcrierile sale curente de experiment disponibile pentru revizuirea publică .

În ceea ce privește raportul lor inițial, Openai nu a răspuns public la aceste afirmații specifice. Aceste incidente subliniază o provocare critică pentru industria AI: pe măsură ce modelele devin mai sofisticate și capabile de acțiune independentă, asigurând alinierea lor cu intențiile umane și menținerea mecanismelor de control robuste este esențială.