O analiză criminalistică realizată de Copyaks pare să confirme afirmațiile anterioare cu privire la laboratorul AI Deepseek din China de a extrage cunoștințe din modelele lui Openai la scară largă.

După cum au descoperit cercetătorii, că stilul de scriere al lui R1 se potrivește cu chatgpt-ul lui Openai în 74.2% din cazuri. techniques, raising ethical and legal concerns about AI model development.

The report comes amid OpenAI’s Investigarea continuă cu privire la activitatea API neobișnuită legată de conturile dezvoltatorilor din China. OpenAI a detectat tipare neregulate care sugerează extragerea în masă a răspunsurilor ChatGPT, care, dacă sunt conectate la Deepseek, ar putea indica o pregătire neautorizată a modelului bazată pe conținut generat de OpenAI.

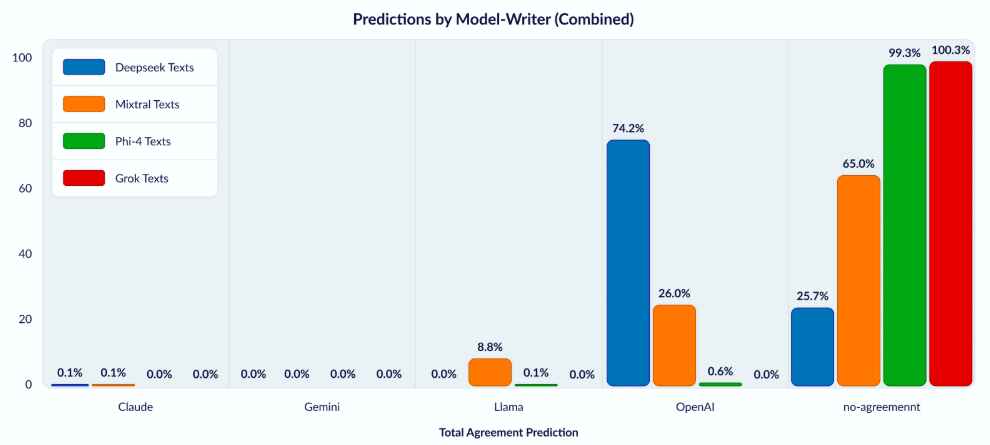

în conformitate cu Copyleaks, their study employed a rigorous methodology, utilizing three advanced AI classifiers trained on text samples from four major models: Claude, Gemini, Llama, and Openai.

Acești clasificatori au analizat elemente stilistice subtile, inclusiv structura propoziției, alegerea cuvintelor și tiparele de frazare. Un aspect esențial al abordării a fost sistemul său „juriu unanim”, necesitând că toți cei trei clasificatori să ajungă la aceeași concluzie înainte de a face o clasificare.

Acest lucru minimizat și a produs rezultate extrem de fiabile, obținând o rată de precizie de 99,88% cu o rată falsă pozitivă de doar 0,04%, distingerea efectivă a modelelor de texte, atât de familiarizate, cât și de cele care au fost prezis. Că 74,2% din textul Deepseek împărtășește o amprentă stilistică cu modelele lui OpenAI, un nivel de similaritate care nu este găsit în alte sisteme AI testate.

Microsoft, cel mai mare investitor al lui Openai, a integrat Deepseek-R1 în azure AI Foundry, ceea ce o face accesibilă dezvoltatorilor din întreaga lume. Accesibilitatea Deepseek. Dacă OpenAI stabilește că Deepseek a fost instruit folosind datele sale fără permisiune, Microsoft poate face față presiunii pentru a-și reconsidera sprijinul pentru model.

impact pe piață: scăderea stocurilor de 593 miliarde de dolari a Nvidia

Emergența Deepseek a avut repercusiuni financiare. La scurt timp după creșterea sa la importanță, Nvidia a pierdut temporar 593 miliarde de dolari în valoare de piață, deoarece investitorii au reevaluat cererea de GPU-uri de înaltă performanță.

capacitatea DeepSeek de a genera răspunsuri bazate pe AI, cu costuri de calcul mai scăzute, crescând preocupările că firmele AI ar putea orienta către modele mai eficiente, reducând dependența de dependență în timp ce hardware-ul ridicat al NVIDIA AI. NVIDIA rămâne principalul furnizor de cipuri AI, abordarea Deepseek ar putea indica o schimbare a modului în care companiile prioritizează eficiența costurilor față de puterea de calcul brută, modificând potențial așteptările pieței pentru dezvoltarea modelului AI. GPT-4.5 a fost construit pe vechea paradigmă de instruire a creșterii progresive a cantității de date de instruire și a fost găsită sub performanță a altor modele care pun accentul pe abordări de raționament, cum ar fi Amestecul de Experți și lanțul de gândire.

Deepseek, numeroasele controverse

Modul în care Deepseek a obținut datele sale de instruire nu este singura contraversie a companiei în care se obține Deepseek.

Un studiu recent de la Newsguard a descoperit că Deepseek-R1 nu a reușit 83% din testele de precizie faptică, clasându-l printre cele mai puțin fiabile modele AI revizuite. Utilizatorii au raportat cazuri de răspunsuri incorecte sau înșelătoare, ridicând îngrijorări cu privire la fiabilitatea modelului pentru aplicațiile critice.

Mai mult, studiul a constatat că rezultatele Deepseek se aliniază frecvent cu narațiunile guvernului chinez, chiar și la întrebările non-politice. Biasul aparent al modelului, combinat cu inexactitățile sale de fapt, a dus la speculații cu privire la faptul că a fost instruit cu seturi de date aprobate de stat, complicând în continuare credibilitatea sa pe piețele internaționale.

Ca rezultat, perplexitatea a lansat R1 1776, un model AI open-source a construit pe Deepseek R1, care îndepărtează mecanismele de filtrare a surselor deschis Subiecte.

Deepseek este depășit și ușor de jailbreak

O altă problemă a Deepseek R1 este că baza sa de cunoștințe apare depășită, deoarece citează frecvent evenimente înainte de 2024 ca și cum ar fi actuale. Acest lucru ridică îngrijorări cu privire la faptul dacă modelul este menținut activ sau dacă datele sale de instruire sunt limitate de restricții externe.

Evaluările de securitate au relevat vulnerabilități în garanțiile Deepseek-R1. Un studiu Palo Alto Networks a constatat că garanțiile modelului nu au reușit toate încercările de jailbreak, ceea ce indică faptul că Deepseek nu are protecții adecvate împotriva utilizării greșite.

În mod similar, cercetările Adversa AI au confirmat că Deepseek este extrem de susceptibil la injecții prompte, permițând utilizatorilor să se ocolească mecanismelor de siguranță și să genereze conținut care ar trebui să fie reținut de altfel. Spre deosebire de ChatGPT de la OpenAI, care a suferit mai multe actualizări de securitate, Deepseek pare să nu aibă garanții de moderare a conținutului comparabil.

S.U.A. Parlamentarii și autoritățile de reglementare europene vizează Deepseek

Preocupările din jurul Deepseek au declanșat răspunsuri de la factorii de decizie atât din Statele Unite, cât și din Europa. În Washington, legiuitorii examinează o propunere de interzicere a AI-ului Deepseek de la agențiile federale, invocând riscuri de securitate și îngrijorări cu privire la legăturile sale cu China.

Oficialii se îngrijorează că vulnerabilitățile sale ar putea fi exploatate pentru campanii de dezinformare sau pentru campanii de dezinformare sau pentru colectarea de date neautorizată, ridicând implicațiile de securitate națională. Decizia urmează eforturi mai largi de stat pentru reglementarea modelelor AI străine pe fondul preocupărilor cu privire la confidențialitatea datelor și potențialele amenințări de cibersecuritate.

În Europa, controlul s-a concentrat pe protecția datelor. Autoritatea de protecție a datelor din Italia a lansat o anchetă cu privire la faptul că Deepseek respectă GDPR. If the AI model is found to be processing data in ways that violate EU privacy laws, it could face significant operational restrictions in the region.

China’s AI Expansion and the Rush for Nvidia’s H20 Chips

DeepSeek’s development is occurring in a broader geopolitical context, where AI technology is increasingly intertwined with national security Îngrijorări.

Pe măsură ce SUA întărește controalele de export pe cipuri de înaltă performanță, companiile chineze au asigurat cât mai multe procesoare AI. Deepseek se numără printre firmele care au contribuit la o creștere a cererii pentru procesoarele H20 NVIDIA, unul dintre puținele jetoane AI încă disponibile pentru export în China.

Restricțiile au obligat dezvoltatorii chinezi AI să se adapteze, potențial bazându-se mai mult pe eficiența software optimizată, mai degrabă decât pe accelerarea hardware. Accentul lui Deepseek pe obținerea performanțelor ridicate cu cerințe de calcul mai mici sugerează o schimbare a strategiei pentru a lucra în aceste limitări.

curse Deepseek pentru a elibera modelul R2 pe fondul intensificării controlului

În ciuda provocărilor, DeepSeek își accelerează calendarul de dezvoltare AI. Compania a ales să urmărească rapid lansarea modelului său R2, ridicându-și programul de lansare în încercarea de a-și menține impulsul în cursa AI.

Această decizie sugerează că Deepseek prioritizează prezența pieței, chiar și în ceea ce privește preocupările cu privire la datele sale de instruire, vulnerabilitățile de securitate, iar fiabilitatea faptică să rămână nerezolvată. Openai, Google și Alibaba. Cu toate acestea, dacă noul model suferă de aceleași slăbiciuni ca R1, inclusiv inexactitatea faptică și lacunele de securitate, acesta poate face față rezistenței pe piețele occidentale.

Viitorul eticii, securității și reglementării AI

Proprietatea de profunzime evidențiază securitate. Pe măsură ce modelele AI devin mai sofisticate, întrebările despre cum sunt dezvoltate-și dacă se bazează pe datele extrase de la concurenți-devin centrale pentru discuțiile despre guvernanța AI.

Dacă Openai concluzionează formal că rezultatele sale au fost utilizate în formarea Deepseek, ar putea stabili un precedent pentru modul în care companiile AI ar putea gestiona litigiile de proprietate intelectuală. Seturi de date de instruire AI și, eventual, consecințe legale pentru companiile care au constatat că au efectuat date generate de concurenți fără autorizare.

autoritățile de reglementare sunt, de asemenea, susceptibile să impună măsuri de conformitate mai stricte pe modelele AI care operează pe piețele majore. Odată cu controlul parlamentarilor din SUA și autorităților de reglementare europene în creștere, firmele AI se pot confrunta curând cu o supraveghere sporită asupra confidențialității, securității și moderației conținutului.