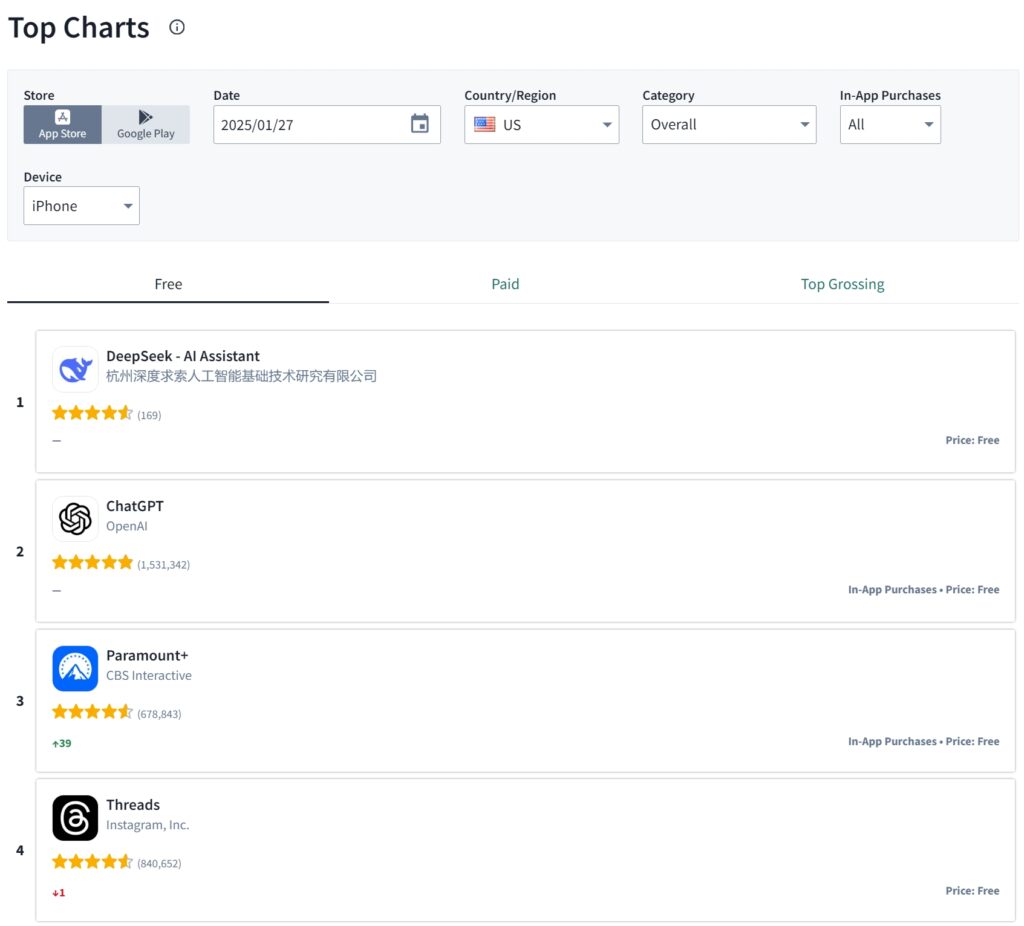

DeepSeek, un startup chinezesc de inteligență artificială, a ocupat primul loc în magazinul de aplicații al Apple din SUA weekendul trecut, depășind ChatGPT de la OpenAI la descărcări.

Pala de hotar vine după lansarea din 20 ianuarie a modelului de raționament emblematic al DeepSeek, R1, care a câștigat rapid recunoașterea pentru capacitatea sa de a rivaliza cu sistemele AI avansate în timp ce operează cu o fracțiune din resursele necesare de obicei.

Sursa: Sensor Tower

Sursa: Sensor Tower

DeepSeek R1 oferă performanțe de vârf, fiind în același timp cenzurat conform regulilor PCC.

Creșterea rapidă a aplicației bazate pe R1 reflectă ingineria inovatoare și utilizarea strategică de către DeepSeek a GPU-urilor Nvidia H800, care sunt restricționate pentru exportul în China.

Legate: De ce sancțiunile SUA se pot lupta pentru a reduce creșterea tehnologiei a Chinei

Prin dezvoltarea unor metode eficiente de instruire, compania din Hangzhou a demonstrat că progresul AI este posibil chiar și sub constrângeri geopolitice. Această evoluție provoacă percepția dominației SUA în inteligența artificială și ridică semne de întrebare cu privire la eficacitatea restricțiilor la export menite să reducă capacitățile tehnologice ale Chinei.

Construirea IA sub restricție: o abordare plină de resurse

Modelul R1 de la DeepSeek a fost antrenat folosind doar 2.048 de GPU-uri Nvidia H800 la un cost total de sub 6 milioane de dolari, potrivit unui document de cercetare lansat de companie în decembrie 2024.

Aceste GPU-uri sunt versiuni intenționate ale cipurilor H100 utilizate de companii americane precum OpenAI și Meta. În ciuda limitărilor hardware, inginerii DeepSeek au dezvoltat tehnici noi de optimizare care i-au permis lui R1 să obțină rezultate comparabile cu modelele antrenate pe o infrastructură mult mai puternică.

Fondatorul Liang Wenfeng, fost manager de fonduri speculative, a explicat abordarea companiei în timpul unui interviu cu 36Kr. „Trebuie să consumăm de patru ori mai multă putere de calcul pentru a obține același efect”,

Legate: Seria DeepSeek AI Open Sources VL2 de modele Vision Language

Liang a spus „Ceea ce trebuie să facem este să reducem continuu aceste decalaje”. Perspectiva lui Liang în stocarea de GPU-uri Nvidia înainte ca restricțiile din SUA să intre în vigoare a fost un factor critic în capacitatea companiei de a inova în circumstanțe dificile.

Inginerii DeepSeek s-au concentrat, de asemenea, pe reducerea utilizării memoriei și a cheltuielilor de calcul, permițând o precizie ridicată în ciuda constrângerilor hardware.. Dimitris Papailiopoulos, cercetător principal la laboratorul Microsoft AI Frontiers, a subliniat eficiența designului R1.

„Au urmărit mai degrabă răspunsuri precise decât să detalieze fiecare pas logic, reducând semnificativ timpul de calcul, menținând în același timp un nivel ridicat de eficacitate”, a spus el pentru MIT Technology Review.

Performanță. Benchmarks and Industry Recognition

Performanța lui R1 a fost deosebit de puternică la benchmark-urile tehnice, obținând scoruri de 97,3% pe MATH-500 și 79,8% pe AIME 2024. Aceste rezultate plasează R1 alături de seria o1 a OpenAI, demonstrând că modelul DeepSeek eficient din punct de vedere al resurselor poate concura cu liderii din industrie.

Dincolo de modelul său emblematic, DeepSeek a lansat și versiuni mai mici. R1 capabil să ruleze pe hardware de consum. Această accesibilitate a lărgit atractivitatea modelului în rândul dezvoltatorilor. educatori și pasionați. Pe rețelele sociale, utilizatorii au împărtășit exemple de R1 care gestionează sarcini complexe, cum ar fi dezvoltarea web, codificarea și rezolvarea avansată a problemelor de matematică.

Legate: Mistral AI. Debutează Pixtral 12B pentru procesarea textului și a imaginilor

Realizările lui DeepSeek au atras laude de la personalități importante din domeniul AI. Yann LeCun, cercetător șef AI al Meta, a subliniat rolul colaborării open-source în succesul DeepSeek. „„DeepSeek a profitat de pe urma cercetării deschise și a surselor deschise (de exemplu, PyTorch și Llama de la Meta). Au venit cu idei noi și le-au construit pe deasupra muncii altora.”a scris LeCun pe LinkedIn. Deoarece munca lor este publicată și open source, toată lumea poate profita de pe urma ei. Aceasta este puterea cercetării deschise și a open source.”

În mod similar, Marc Andreessen, co-fondatorul Andreessen Horowitz, a descris R1 drept „una dintre cele mai uimitoare descoperiri pe care le-am văzut vreodată.” Aceste aprobări evidențiază impactul global al Abordarea plină de resurse a DeepSeek pentru dezvoltarea AI.

Affordability and Open-Source Ethos

Spre deosebire de platformele proprietare precum ChatGPT de la OpenAI, DeepSeek a îmbrățișat o filozofie open-source Compania a pus la dispoziția publicului greutățile, rețetele de antrenament și documentația modelului R1, permițând dezvoltatorilor din întreaga lume să reproducă sau să construiască pe baza acestuia. Această transparență a diferențiat DeepSeek într-o industrie caracterizată adesea de secret.

Affordabilitatea a fost, de asemenea, un factor cheie în popularitatea aplicației R1, iar accesul API are un preț semnificativ mai mic decât concurenții’oferte. Aceste strategii de stabilire a prețurilor, combinate cu capabilitățile robuste ale modelului, au făcut din DeepSeek o opțiune atractivă atât pentru persoane fizice, cât și pentru companii.

Legate: LLaMA AI Under Fire – What Meta Isn’t Telling Despre modelele „Open Source”

Implicațiile geopolitice ale succesului DeepSeek

DeepSeek Creșterea are loc într-un moment al tensiunilor geopolitice sporite între Statele Unite și China, în special în domeniul inteligenței artificiale

Din 2021, administrația Biden a extins restricțiile privind exportul de cipuri avansate în China. pentru a limita capacitatea țării de a dezvolta tehnologii AI competitive. Cu toate acestea, realizările DeepSeek sugerează că astfel de măsuri ar putea să nu împiedice pe deplin inovarea.

Succesul companiei. a provocat dezbateri în cercurile tehnologice din SUA cu privire la consecințele neintenționate ale controalelor la export. Unii directori susțin că aceste restricții ar putea conduce la inovație în rândul firmelor chineze. Strategia lui Liang de a stoca GPU-uri și de a se concentra pe eficiență a dovedit că constrângerile pot stimula rezolvarea creativă a problemelor, mai degrabă decât să o înăbușe în totalitate.

Legate: Noile reguli de export de cipuri AI din SUA se confruntă cu reacții în industrie. de Nvidia și alții

O mișcare mai largă în IA chineză

Abordarea open-source a DeepSeek se aliniază cu o tendință mai largă în sectorul AI al Chinei. Alte companii, inclusiv Alibaba Cloud și Kai-Fu Lee’s 01.AI, au prioritizat, de asemenea, inițiativele open-source în ultimii ani. Liang a descris necesitatea de a aborda ceea ce el numește „decalaj de eficiență” între întreprinderile chineze și occidentale în domeniul inteligenței artificiale, explicând că firmele locale necesită adesea resurse duble pentru a obține rezultate comparabile.

Legate: Alibaba Qwen lansează QVQ-72B-Preview Multimodal Reasoning AI Model

În iulie 2024, Liang a declarat: „Estimăm că cele mai bune modele interne și străine poate avea un decalaj de o singură parte în structura modelului și dinamica de antrenament Numai din acest motiv, trebuie să consumăm de două ori mai multă putere de calcul pentru a obține același efect eficiență, adică trebuie să consumăm de două ori mai multe date de antrenament și putere de calcul pentru a obține același efect. Împreună, trebuie să consumăm de patru ori mai multă putere de calcul goluri.”

Conducerea sa a câștigat recunoașterea DeepSeek atât în China, cât și la nivel internațional. În 2024, a fost invitat la întâlniri la nivel înalt cu oficiali chinezi pentru a discuta despre strategiile de promovare a capacităților AI ale țării.

Provocări și oportunități viitoare

Ca DeepSeek continuă să-și perfecționeze modelele, compania se confruntă atât cu oportunități, cât și cu provocări. În timp ce realizările sale au dovedit viabilitatea IA eficientă din punct de vedere al resurselor, rămân întrebări cu privire la dacă astfel de abordări se pot extinde pentru a concura cu investițiile masive ale giganților tehnologici precum OpenAI și Meta.

Într-o postare după lansarea DeepSeek R1. , Mark Zuckerberg, CEO-ul Meta, a subliniat importanța investițiilor la scară largă în infrastructura AI, spunând „Acesta va fi un an definitoriu pentru AI. În 2025, mă aștept ca Meta AI să fie asistentul principal care deservește mai mult de 1 miliard de oameni, Llama 4 va deveni modelul lider de ultimă generație și vom construi un inginer AI care va începe să contribuie cu cantități tot mai mari de cod. la eforturile noastre de cercetare și dezvoltare. Pentru a alimenta acest lucru, Meta construiește un centru de date de 2GW+ care este atât de mare încât ar acoperi o parte semnificativă din Manhattan.

Vom aduce online ~1GW de calcul în ’25 și vom încheia anul cu peste 1,3 milioane de GPU. Intenționăm să investim 60-65 de miliarde de dolari în investiții în acest an, în timp ce ne creștem semnificativ echipele AI și avem capitalul necesar pentru a continua să investim în anii următori. Acesta este un efort masiv și, în următorii ani, va conduce produsele și afacerile noastre de bază, va debloca inovația istorică și va extinde liderul tehnologic american. Haideți să construim!”

Deocamdată, succesul DeepSeek cu R1 a demonstrat că inovația nu este exclusiv domeniul celor mai bine finanțați jucători. Prin prioritizarea eficienței, transparenței și accesibilității, compania a făcut o impact de durată asupra industriei globale de inteligență artificială.