Cercetătorii de la Google au introdus un nou cadru numit Chain-of-Agents (CoA), conceput pentru a aborda una dintre cele mai persistente limitări ale modelelor de limbaj mari (LLM): gestionarea sarcinilor cu context lung.

CoA folosește un model de colaborare cu mai mulți agenți pentru a îmbunătăți semnificativ eficiența și acuratețea raționamentului în sarcini precum rezumarea, răspunsul la întrebări și completarea codului.

Prin împărțirea intrărilor lungi în intrări mai mici, ușor de gestionat fragmente și alocându-le agenților specializați, cadrul oferă rezultate mai bune decât abordările tradiționale precum Retrieval-Augmented Generation (RAG) și Full-Context modele.

Legate: Google dezvăluie Agentspace pentru Provocați ecosistemul AI în creștere al Microsoft

Ecosistemul cadru CoA oferă o schimbare de paradigmă pentru AI, în special în capacitatea sa de a procesa intrări extinse care altfel ar depăși limitările LLM-urilor. Google a subliniat simplitatea și eficacitatea abordării, descriind-o ca fiind „fără antrenament, agnostic sarcinii/lungime, interpretabil și rentabil.”

Provocările sarcinilor AI în context lung

Unul dintre obstacolele majore în dezvoltarea capabilităților AI constă în gestionarea intrărilor în context lung Majoritatea LLM-urilor operează cu a Fereastra de context fix care limitează capacitatea lor de a procesa seturi mari de date fără trunchiere

Metodele de reducere a intrărilor, cum ar fi RAG, încearcă să depășească acest lucru prin preluarea doar a celor mai relevante părți ale intrării de la o precizie scăzută de recuperare, ceea ce duce la informații incomplete

Legate: NVIDIA avansează AI Agentic cu Llama și Cosmos Nemotron. Modele

Pe de altă parte, modelele Full-Context își extind capacitatea de procesare, dar se confruntă cu ineficiențe de calcul, în special pe măsură ce lungimea intrării crește informațiile critice din mijlocul setului de date sunt deprioritate.

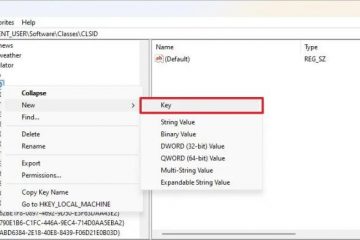

Cadru Google CoA abordează aceste probleme prin folosirea unui sistem colaborativ în care agenții lucrători procesează segmente specifice ale intrării. secvenţial. Fiecare agent lucrător își rafinează și își transferă constatările la următorul, asigurându-se că nu se pierde contextul.

Un agent manager sintetizează apoi toate informațiile adunate pentru a produce un răspuns final. Această abordare treptată imită rezolvarea problemelor umane, în care sarcinile sunt împărțite în părți mai mici pentru o concentrare și o precizie mai bune.

Imagine: Google

Imagine: Google

Cercetătorii Google au evidențiat motivația din spatele cadrului, afirmând: „Când fereastra devine mai lungă chiar decât capacitățile lor extinse de intrare, astfel de LLM-uri încă se luptă să se concentreze pe informațiile necesare pentru a rezolva sarcina și suferă de utilizarea ineficientă a contextului, cum ar fi problema „pierdut în mijloc”.

Cum funcționează lanțul de agenți

The Cadrul Chain-of-Agents funcționează în două etape distincte. În prima etapă, agenții lucrători procesează bucăți de intrare atribuite, efectuând sarcini precum extragerea dovezilor de susținere sau transmiterea constatărilor relevante

Acest lanț de comunicare fiecare lucrător se bazează pe cunoștințele celei anterioare. În a doua etapă, agentul manager agreează toate dovezile colectate și generează un rezultat final coeziv. Această structură ierarhică nu numai că îmbunătățește acuratețea raționamentului, ci și reduce costurile de calcul.

Legate: Salesforce dezvăluie Agentforce 2.0, extinderea agenților AI dincolo de CRM

Google a explicat design-ul framework-ului ca „intercalarea citirii și raționamentului, atribuind fiecărui agent un context scurt.” Această abordare permite CoA să gestioneze contexte lungi fără a necesita LLM să proceseze toate token-urile simultan

Prin reducerea complexității computaționale, CoA oferă o soluție mai eficientă și mai scalabilă pentru sarcini de context lung.

Performanță superioară în cadrul benchmarkurilor

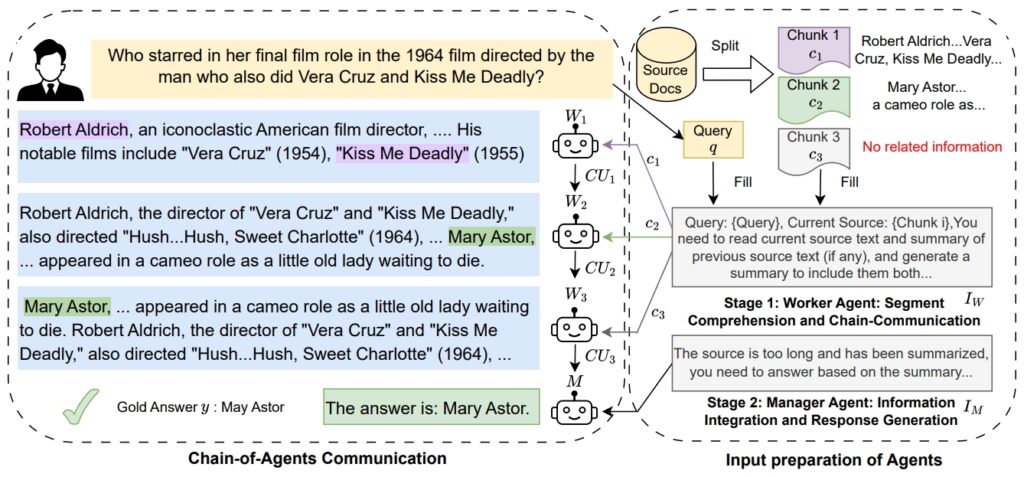

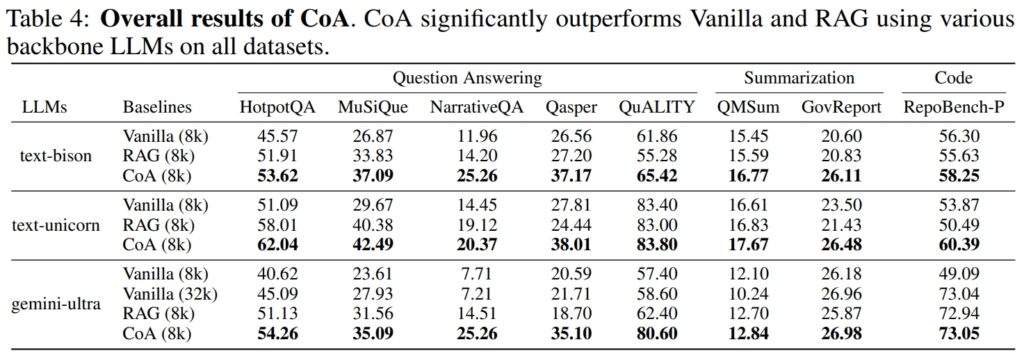

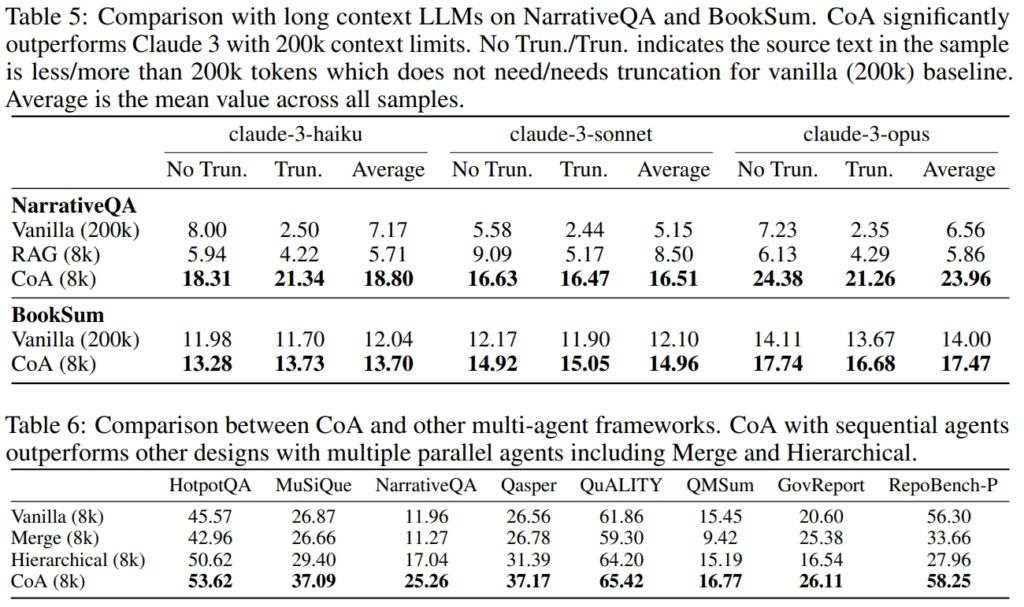

Google a efectuat experimente extinse pe nouă seturi de date pentru a evalua performanța CoA Aceste seturi de date au acoperit diferite domenii, inclusiv răspunsul la întrebări (de exemplu, HotpotQA, MuSiQue), rezumarea (de exemplu, QMSum, GovReport) și completarea codului (de exemplu, RepoBench-P)

CoA a depășit în mod constant modelele RAG și Full-Context atât în ceea ce privește acuratețea, cât și eficiența.

Sursa: Google

Sursa: Google

De exemplu, pe setul de date HotpotQA, CoA a excelat în raționamentul multi-hop, o sarcină care necesită sintetizarea informațiilor din mai multe surse pentru a ajunge la un proces precis. răspuns.

În timp ce RAG nu a reușit adesea să conecteze piese de informații disjunse din punct de vedere semantic, dar relevante din punct de vedere contextual, CoA a reunit în mod sistematic informații din fiecare fragment de intrare. Google a remarcat: „Rezultatele noastre arată că pentru toate cele nouă seturi de date, CoA obține o îmbunătățire față de toate liniile de bază cu până la 10%.”

Pe setul de date NarrativeQA, CoA și-a demonstrat capacitatea de a depăși modelele cu context complet, chiar și cei capabili să gestioneze 200.000 de jetoane Limitând fereastra de context la 8.000 de jetoane și folosind abordarea multi-agent, CoA a menținut performanța ridicată, reducând în același timp semnificativ. costuri de calcul.

Sursa:

Sursa:

Aplicații Google în scenarii din lumea reală

Aplicațiile practice ale CoA se extind în mai multe industrii În analiza juridică, CoA poate procesa documente juridice extinse și poate identifica informații critice fără a pierde detaliile cheie. În asistența medicală, cadrul ar putea agrega înregistrările pacienților din diverse surse pentru a oferi informații cuprinzătoare de diagnostic.

Instituțiile academice și guvernamentale ar putea folosi CoA pentru rezumarea cercetării, sintetizând constatările din seturi mari de date.

Abilitatea CoA de a gestiona sarcinile de completare a codului evidențiază, de asemenea, potențialul său în dezvoltarea de software. Analizând baze de cod mari și identificând dependențe, cadrul poate optimiza fluxurile de lucru pentru dezvoltatorii care lucrează cu sisteme complexe.

Legate: Cognition.ai lansează Inginerul de software Devin AI pentru 500 USD/lună

Comparații cu concurenții din industrie

Introducerea de către Google a CoA reflectă un accent tot mai mare pe IA unică agenți și cadre colaborative de agenți AI din industria tehnologiei. OpenAI tocmai a lansat Operator, un agent AI bazat pe browser, conceput pentru automatizarea sarcinilor, în timp ce Microsoft a dezvăluit AutoGen v0.4 cu cadrul Magentic-One pentru fluxuri de lucru cu mai mulți agenți.

CoA Google se deosebește concentrându-se în mod special pe raționamentul în context lung și pe procesarea sarcinilor.

Conform cercetătorilor Google, LLM-urile primesc adesea context incomplet din cauza limitărilor metodelor tradiționale, dar CoA abordează acest lucru prin procesarea întregii intrări în colaborare prin mai mulți agenți.

Acest accent pe sarcini de context lung oferă CoA un avantaj unic în domeniile care necesită informații extinse sinteză.

O privire asupra viitorului AI

Introducerea CoA evidențiază o tendință mai largă în dezvoltarea AI către sisteme modulare și colaborative. Permițând agenților specializați să lucreze împreună, CoA demonstrează modul în care împărțirea sarcinilor poate îmbunătăți acuratețea și scalabilitatea.

Cadrul ar putea deschide calea pentru progrese în inteligența generală artificială (AGI), unde sistemele sunt capabile să raționeze la nivel uman și să rezolve probleme.

Eforturile Google subliniază, de asemenea, importanța de soluții rentabile și interpretabile în IA pentru întreprinderi.