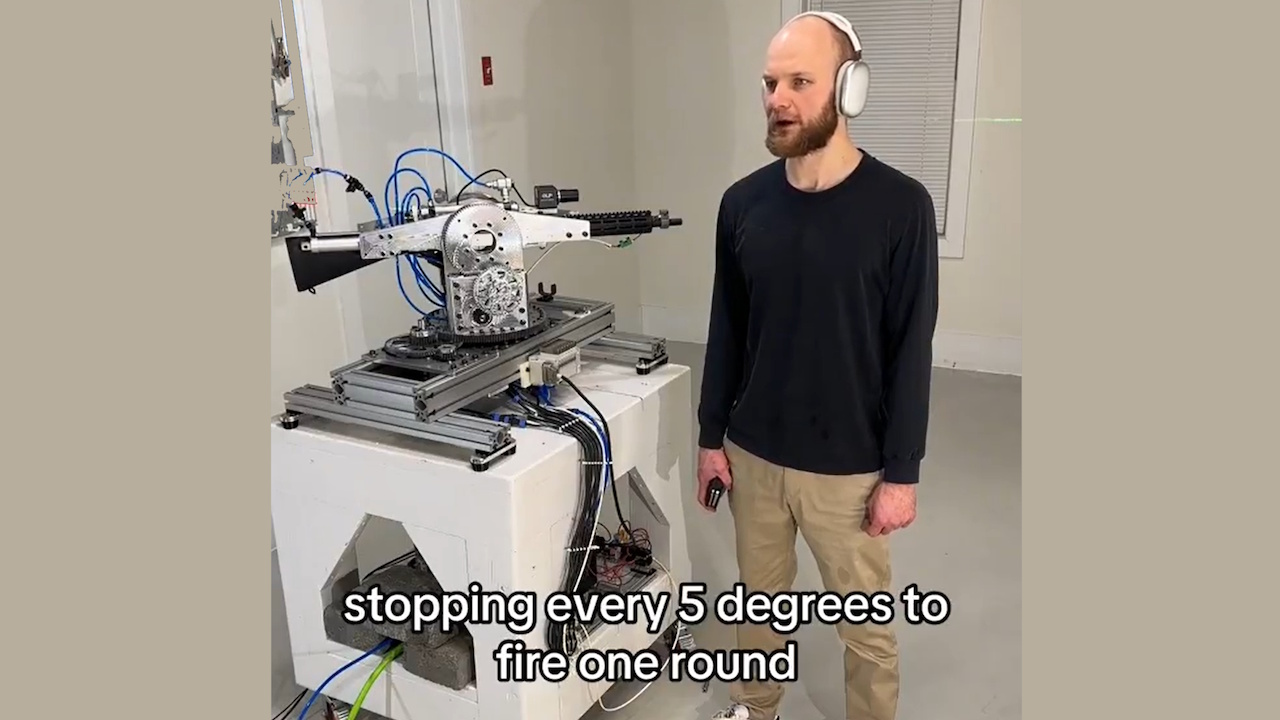

OpenAI a revocat accesul la API pentru un dezvoltator care a folosit API-ul în timp real pentru a alimenta un sistem de pușcă autonom. Proiectul, care a implicat o turelă robotizată echipată cu o pușcă, putea interpreta comenzi verbale și executa acțiuni de tragere simulate.

Incidentul subliniază îngrijorările tot mai mari cu privire la potențiala utilizare greșită a inteligenței artificiale în dezvoltarea armelor autonome, ridicând întrebări despre etica AI și siguranța AI.

Dezvoltatorul, cunoscut online ca „STS Innovations LLC,” a distribuit online videoclipuri ale sistemului, demonstrând funcționalitatea acestuia. Într-un clip, dezvoltatorul a publicat comanda, „ChatGPT, suntem atacați din partea din față stânga și față din dreapta”, la care turela a răspuns imediat, rotindu-se și trăgând în blanc în direcțiile specificate.

Simulare țintire/foc cu laser #robotics #electronics

Un sintetizat voce a adăugat: „Dacă aveți nevoie de asistență suplimentară, anunțați-mă.” Demonstrația înfricoșătoare a evidențiat modul în care instrumentele AI de calitate pentru consumatori pot fi adaptate cu ușurință pentru utilizări potențial dăunătoare.

Actualizare privind sistemul de urmărire #robotics #vision #electronics p> ♬ sunet original – sts_3d

Aplicarea rapidă a politicilor OpenAI

OpenAI, cunoscut pentru politicile sale stricte împotriva utilizării tehnologiei sale în armament, a răspuns prompt. Un purtător de cuvânt a declarat pentru Futurism: „Am identificat în mod proactiv această încălcare a politicilor noastre și am notificat dezvoltatorul să înceteze această activitate înainte de a primi întrebarea dvs..”

Compania a subliniat interzicerea utilizării instrumentelor sale pentru a crea sau a opera arme sau automatizați sistemele care ar putea prezenta riscuri pentru siguranța personală.

Sistem de management al reculului, demonstrație rapidă #robotics #electronics #cnc

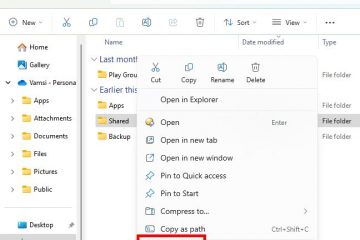

API-ul în timp real, un instrument conceput pentru aplicații interactive, au permis dezvoltatorului să transforme comenzile în limbaj natural în intrări acționabile pentru turela robotică.

Deși API-ul este destinat cazurilor de utilizare benefice, cum ar fi îmbunătățirea accesibilității sau îmbunătățirea interacțiunilor cu clienții, această utilizare greșită demonstrează provocările reglementării tehnologiilor cu dublă utilizare.

Legate: Parteneriat OpenAI și Anduril Forge pentru apărarea militară a dronelor din SUA

Implicații mai largi pentru AI și armament

Acest caz a reaprins dezbaterile asupra eticii armelor autonome. Aceste sisteme, capabile să selecteze și să angajeze ținte fără supraveghere umană, ridică provocări juridice și morale complexe.

Națiunile Unite pledează de mult timp pentru reglementări mai stricte privind IA în război, avertizând că sistemele autonome ar putea încălca legile internaționale și ar putea diminua responsabilitatea.

Legate: Antropic Colaborează cu Palantir, AWS pentru AI în serviciile de informații și armate din SUA

Un raport Washington Post recent exemple detaliate îngrijorătoare de desfășurare a AI în operațiuni militare, inclusiv afirmații conform cărora Israelul a folosit AI pentru a selecta ținte de bombardare.

Raportul menționa: „În anumite momente, singura coroborare necesară a fost aceea că ținta era un bărbat.” Astfel de cazuri evidențiază riscurile de a se baza pe AI în deciziile de viață sau de moarte și potențialul de a fi nediscriminat. violență.

Legate: Green Beret a folosit ChatGPT pentru Cybertruck Blast, poliția lansează jurnalele de chat

Rolul OpenAI în tehnologiile de apărare

În timp ce OpenAI aplică politici care interzic armamentul, parteneriatul său cu Anduril Industries, o companie specializată în soluții de apărare bazate pe inteligență artificială, ridică întrebări cu privire la poziția sa

Colaborarea își propune să îmbunătățească informațiile pe câmpul de luptă și să îmbunătățească sistemele de apărare cu drone OpenAI descrie aceste eforturi ca fiind defensive, dar criticii susțin că acestea contribuie militarizarea mai largă a tehnologiilor AI.

Sectorul de apărare din SUA, susținut de un buget anual de aproape 1 trilion de dolari, se bazează din ce în ce mai mult pe tehnologii avansate pentru a obține un avantaj strategic de a echilibra inovația tehnologică cu considerentele etice.

Legate: Noul Consorțiu Palantir-Anduril AI la Combateți lacunele de date ale apărării din SUA

Riscurile legate de armament și accesibilitate DIY

Ușurința cu care indivizii pot folosi greșit instrumentele AI și alte tehnologii precum imprimarea 3D agravează problema. Oamenii legii au întâlnit deja cazuri de armament DIY, cum ar fi presupusele acțiuni ale lui Luigi Mangione, care se pare că a folosit piese imprimate 3D pentru a asambla arme de foc. Aceste tehnologii reduc barierele pentru ca indivizii să creeze sisteme autonome cu potențial letal.

Proiectul STS 3D demonstrează cât de accesibile instrumentele AI pot fi adaptate în scopuri nedorite. Acțiunea decisivă a OpenAI în acest caz demonstrează angajamentul său de a preveni utilizarea abuzivă, dar subliniază și dificultatea de a controla pe deplin modul în care tehnologiile sale sunt implementate odată ce acestea intră în domeniul public.

Incidentul ridică întrebări mai ample cu privire la guvernarea Tehnologii AI. Susținătorii reglementării subliniază necesitatea unor standarde globale clare pentru a se asigura că dezvoltarea IA este aliniată cu principiile etice. Cu toate acestea, obținerea unui consens între națiunile cu interese și priorități diferite rămâne o sarcină descurajantă.