Anthropic a împărtășit detalii despre Clio, un instrument analitic sofisticat care oferă informații despre modul în care asistentul său Claude AI este utilizat în milioane de conversații.

Conceput pentru a răspunde provocărilor de înțelegere a interacțiunilor AI, menținând în același timp confidențialitatea utilizatorilor. , Clio oferă informații în timp real care informează îmbunătățirea siguranței și descoperă potențialul abuz. Pe măsură ce adoptarea sistemelor AI crește la nivel global, instrumente precum Clio arată cum laboratoarele AI încearcă să echilibreze supravegherea etică cu inovația.

O nouă paradigmă pentru înțelegerea interacțiunilor AI

Sistemele AI precum Claude s-au integrat rapid în diverse aspecte ale vieții umane, îndeplinind sarcini de la dezvoltarea de software până la educație. Cu toate acestea, înțelegerea modului în care sunt utilizate aceste sisteme rămâne o provocare din cauza preocupărilor legate de confidențialitate și a dimensiunii copleșitoare a datelor.

Spre deosebire de abordările tradiționale bazate pe riscuri preidentificate, Clio utilizează o metodă de analiză de jos în sus pentru a descoperi modele și tendințe ascunse în utilizarea AI. Instrumentul reprezintă o schimbare în modul în care companiile evaluează impactul sistemelor lor AI, trecând de la analiza manuală la cadre scalabile, care păstrează confidențialitatea.

Clio utilizează procesarea limbajului natural (NLP) și tehnici de încorporare pentru a extrage atribute— numite fațete — din conversații, inclusiv subiecte, limbi și tipuri de interacțiune.

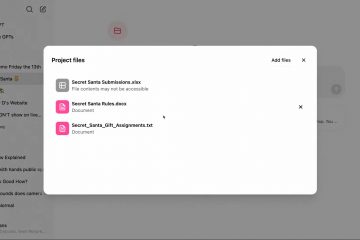

Imagine: antropic

Aceste fațete sunt grupate semantic, cu conversații similare grupate pe baza proximității tematice folosind algoritmi precum k-means. Acest proces culminează în grupuri ierarhice, permițând analiștilor să navigheze de la categorii largi la subteme specifice. Rezultatul este o vedere la nivel înalt a modului în care utilizatorii interacționează cu inteligența artificială fără a compromite datele sensibile.

Legate: Noul protocol de context al modelului Anthropic revoluționează conectivitatea AI-date

Măsuri de protecție a confidențialității la fiecare pas

Anthropic subliniază faptul că confidențialitatea este parte integrantă a designului Clio. Sistemul încorporează protecții pe mai multe straturi pentru a se asigura că conversațiile individuale rămân anonime și neidentificabile pe parcursul analizei.

Măsurile de protecție Clio includ solicitări de rezumare care omit detalii personale, praguri pentru eliminarea clusterelor mici sau rare și audituri extinse pentru validarea rezultatelor. Aceste măsuri se aliniază cu etosul Anthropic privind încrederea utilizatorilor și responsabilitatea datelor.

„Protecția confidențialității este încorporată în fiecare strat al designului Clio”, a declarat Alex Tamkin, autorul principal al lucrării de cercetare Clio pentru Platformer. „Sistemul ne permite să informații de suprafață fără a compromite confidențialitatea individuală sau organizațională.”

Această abordare riguroasă a fost validată în timpul testării, Clio obținând o rată de acuratețe de 94% în reconstruirea tiparelor, menținând în același timp respectarea confidențialității. Capacitatea instrumentului de a obține informații utile fără a expune informații sensibile demonstrează modul în care sistemele AI pot fi guvernate din punct de vedere etic.

Legate: Amazon oferă antropicului 4 miliarde de dolari pentru a deveni centrul de instruire AI al lui Claude

Perspective cheie asupra cazurilor de utilizare AI

Analiza lui Clio a peste un milion de conversații cu Claude a dezvăluit mai multe tendinte. Codarea AI și dezvoltarea software-ului au apărut ca principalul caz de utilizare, reprezentând mai mult de 10% din interacțiuni. Utilizatorii au căutat frecvent asistență pentru depanare, explorarea conceptelor Git și construirea de aplicații.

Utilizarea educațională a fost o altă categorie proeminentă, cuprinzând peste 7% din conversații, profesorii și studenții utilizând Claude pentru sarcinile de învățare. Operațiunile comerciale, inclusiv redactarea e-mailurilor și analizarea datelor, au reprezentat aproape 6% dintre interacțiuni.

Sursa: Antropic

Clio a luminat, de asemenea, nuanțe culturale și contextuale unice. De exemplu, utilizatorii japonezi au discutat în mod disproporționat despre îngrijirea bătrânilor, reflectând interese specifice ale societății. Clusterele mai mici au evidențiat utilizări creative și neașteptate, cum ar fi interpretarea viselor, pregătirea pentru dezastre și jocul de rol ca Dungeon Masters pentru jocurile de masă.

„Se pare că dacă construiești o tehnologie de uz general și o lansezi, oamenii găsesc o mulțime de scopuri pentru asta”, a spus Deep Ganguli, care conduce echipa Anthropic de impact social.

[conținut încorporat]

Întărirea siguranței și a încrederii

Una dintre cele mai critice aplicații ale Clio este capacitatea sa de a spori siguranța prin identificarea tiparelor de utilizare greșită În timpul unei analize de rutină, Clio a descoperit o campanie de spam SEO coordonată utilizatorii au manipulat solicitări pentru a genera conținut optimizat pentru căutare. interveni.

În pregătirea pentru alegerile generale din S.U.A. din 2024, Clio a monitorizat interacțiunile AI pentru riscuri legate de vot și conținut politic. Sistemul a identificat utilizări benigne, cum ar fi explicarea proceselor electorale, alături de încercările de a folosi abuziv Claude pentru generare materiale de strângere de fonduri pentru campanie.

„Demonstrează cu adevărat că puteți monitoriza și înțelege, de jos în sus, ceea ce se întâmplă – păstrând totuși utilizatorul confidențialitate., Miles McCain, un membru al personalului tehnic al Anthropic, a declarat pentru să vadă lucrurile înainte de a fi ar putea deveni. „Vă permite să vedeți lucrurile înainte ca acestea să devină o problemă publică.”

Legate: Autoritățile de reglementare din Marea Britanie elimină acordul antropic de 2 miliarde USD de la Alphabet, nu văd nicio influență semnificativă

Reducerea erorilor în clasificatorii AI

Clio a perfecționat, de asemenea, clasificatorii de siguranță Anthropic, abordând probleme comune, cum ar fi fals pozitive și negative. Anterior, unele interogări, cum ar fi solicitanții de locuri de muncă care încarcă CV-uri sau interacțiuni cu jocuri de rol, au fost semnalate ca dăunătoare din cauza interpretării greșite a conținutului lor.

Imagine: Anthropic

Analiza lui Clio a ajutat la recalibrarea acestor clasificatoare, reducând întreruperile inutile pentru utilizatori, menținând în același timp standarde de siguranță robuste, a comentat Alex Tamkin, principalul autor al lucrării și cercetător pentru Platformer:

„Puteți utilizați Clio pentru a monitoriza în mod constant la un nivel înalt pentru ce tipuri de lucruri folosesc oamenii această tehnologie fundamental nouă. Puteți trimite orice lucru care pare suspect sau îngrijorător către echipa de încredere și siguranță și puteți actualiza acele măsuri de protecție pe măsură ce tehnologia se extinde.”

Legate: Anthropic Urges Immediate Global AI Regulation: 18 Luni sau e prea târziu

Implicații mai largi pentru guvernarea AI

Anthropic vede Clio ca mai mult decât o siguranță Acesta vede sistemul ca un model pentru guvernarea etică a inteligenței artificiale. Prin partajarea deschisă a detaliilor tehnice, inclusiv a costului Clio de 48,81 USD pentru 100.000 de conversații analizate, Anthropic urmărește să încurajeze adoptarea la nivel de industrie a unor analize similare de păstrare a confidențialității angajamentul față de dezvoltarea responsabilă a IA și responsabilitatea societală.

„Prin discuții deschise Clio, ne propunem să contribuim la norme pozitive în jurul dezvoltării și utilizării responsabile a unor astfel de instrumente.” a spus Tamkin pentru Platformer. Clio oferă, de asemenea, perspective asupra tendințelor economice și culturale, poziționându-l ca un instrument esențial pentru înțelegerea impactului social al inteligenței artificiale.

Viitorul analizei AI pentru păstrarea confidențialității

Succesul Clio evidențiază potențialul instrumentelor de monitorizare AI care respectă confidențialitatea utilizatorilor, oferind în același timp informații utile. Pe măsură ce sistemele AI continuă să se integreze în viața de zi cu zi, instrumente precum Clio vor juca un rol esențial în asigurarea utilizării lor sigure și etice. Prin abordarea complexității aplicațiilor din lumea reală și a riscurilor emergente, Clio de la Anthropic reprezintă un pas înainte în modul în care AI este înțeleasă, guvernată și de încredere.