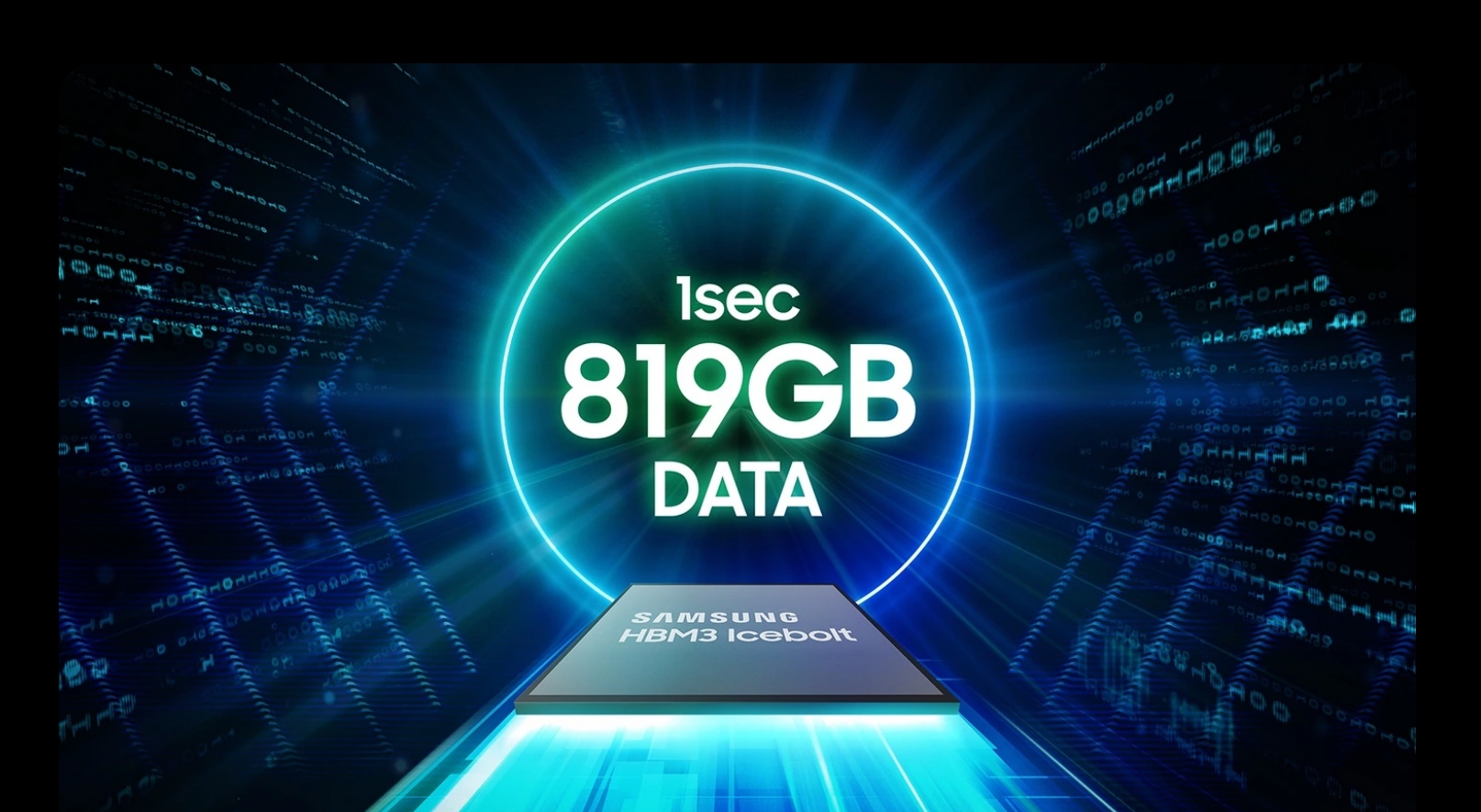

Chipurile HBM3 DRAM de la Samsung, concepute pentru a fi utilizate în acceleratoarele AI de la Nvidia, au întâmpinat probleme de performanță în timpul testarea. Preocupările principale se învârt în jurul generării excesive de căldură și consumului mare de energie, care au ridicat îndoieli cu privire la adecvarea lor pentru nevoile de calcul de înaltă performanță ale Nvidia. HBM reprezintă High Bandwidth Memory, folosind un design de cip care oferă o lățime de bandă mai mare decât modulele DDR4 sau GDDR5, folosind mai puțină putere și într-un factor de formă substanțial mai mic. Acest lucru se realizează prin stivuirea a până la opt DRAM moare și o matriță de bază opțională care poate include circuite tampon și logica de testare.

Preocupări legate de consumul de căldură și energie

Problemele raportate legate de consumul de căldură și energie nu sunt izolate doar de cipurile HBM3. Cipurile HBM3E de la Samsung, care au fost prezentate în urmă cu câteva luni, se confruntă și ele cu probleme similare. Aceste probleme au devenit evidente atunci când rezultatele cipurilor HBM3E cu 8 și 12 straturi de la Samsung au fost lansate în aprilie 2024.

În contrast, SK Hynix a început să furnizeze cipuri HBM3E Nvidia în martie 2024, poziționându-se ca un jucător cheie pe piața HBM. SK Hynix este în prezent cel mai mare furnizor Nvidia de cipuri HBM, care sunt esențiale pentru funcționarea acceleratoarelor AI. Dominația Nvidia pe piața AI, cu o cotă de 80%, face ca certificarea sa să fie crucială pentru orice producător de cipuri HBM.

Eforturile de optimizare ale Samsung

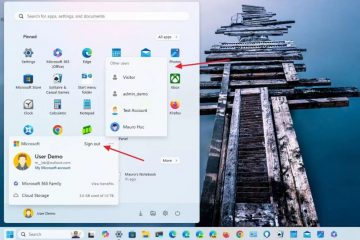

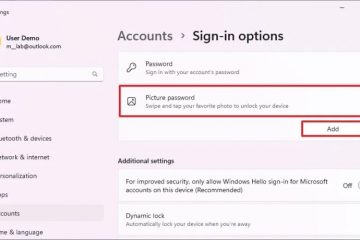

Samsung a recunoscut nevoia de optimizare în tandem cu cerințele clienților. Compania a lucrat îndeaproape cu clienții pentru a rezolva aceste probleme și s-a străduit de peste un an să treacă testele stricte ale Nvidia. Modificările recente de conducere ale Samsung, inclusiv numirea unui fost expert în dezvoltarea DRAM și NAND flash, subliniază angajamentul său de a rezolva aceste provocări.

Certificarea de la Nvidia este vitală pentru ambițiile Samsung pe piața HBM. Problemele nerezolvate legate de consumul de căldură și energie au aruncat o umbră asupra perspectivelor Samsung. Rămâne nesigur dacă aceste probleme pot fi rezolvate prompt. Aprobarea CEO-ului Nvidia, Jensen Huang, pentru chipul de memorie HBM3E 12H (12 straturi) de la Samsung la conferința GTX AI 2024, unde a scris „Jensen Approved” pe cip, evidențiază importanța acestui parteneriat.

Capacitatea Samsung de a depăși aceste provocări nu este critică doar pentru afacerea sa, ci și pentru industria mai largă. Atât AMD, cât și Nvidia sunt dornici ca Samsung să rezolve aceste probleme pentru a asigura o aprovizionare stabilă de cipuri HBM de la mai mulți furnizori, ceea ce ar ajuta la menținerea prețurilor competitive. Samsung furnizează deja cipuri HBM către AMD, subliniind și mai mult nevoia de soluții de memorie fiabile și eficiente.

Samsung își propune să înceapă producția în masă de cipuri HBM3E înainte de sfârșitul celui de-al doilea trimestru al anului Eforturile de a-și optimiza cipurile HBM în colaborare cu clienții reflectă hotărârea sa de a-și asigura un loc pe piața competitivă a hardware-ului AI. Rezultatul acestor eforturi va avea un impact semnificativ pe viitorul acceleratoarelor AI și al calculului de înaltă performanță.