TL;DR

Istota: Mistral AI uruchomił Devstral 2 i Vibe CLI, aby zapewnić autonomiczne możliwości „kodowania wibracji” w modelach o otwartej wadze. Kluczowe dane techniczne: Model 123B zapewnia 7 razy lepszą efektywność kosztową niż Claude Sonnet, podczas gdy mniejsza wersja 24B działa lokalnie na sprzęcie konsumenckim. Dlaczego to ma znaczenie: stanowi to wyzwanie dla zastrzeżonych ekosystemów, takich jak Replit, oferując przedsiębiorstwom dbającym o prywatność potężną, hostowaną na własnym serwerze alternatywę dla agentycznego tworzenia oprogramowania. Kontekst: Wydanie to przeciwstawia się ostatnim posunięciom OpenAI i Google, pozycjonując Mistral jako głównego rywala amerykańskich gigantów w wadze otwartej.

Rzucając się przeciwko dominacji zastrzeżonych asystentów kodowania, Mistral AI uruchomił we wtorek Devstral 2. Nowy model obejmujący 123 miliardy parametrów jest przeznaczony dla szybko rozwijającego się rynku „kodowania wibracyjnego”, oferując autonomiczne możliwości inżynierii oprogramowania, które mogą konkurować z systemami zamkniętymi, a jednocześnie obniżać ich koszty o prawie 85%.

W tej wersji dostępna jest także Mistral Vibe interfejs wiersza poleceń (CLI) zaprojektowany, aby umożliwić programistom wykonywanie złożonych zadań refaktoryzacji za pomocą języka naturalnego. Pakiet uzupełnia Devstral Small 2, wariant o 24 miliardach parametrów zoptymalizowany pod kątem lokalnego wdrożenia na sprzęcie konsumenckim.

Ta wersja stanowi przeciwwagę dla Google i OpenAI, które blokują swoje ekosystemy poprzez ekskluzywne partnerstwa, pozycjonując Mistral jako otwartą alternatywę dla przedsiębiorstw dbających o prywatność.

Promocja

Oś obrotu „Vibe Coding”: agenci zamiast chatbotów

To wydanie nie jest prostą aktualizacją modelu, ale oznacza wejście Mistral na rynek Trend „kodowania wibracyjnego” – zmiana, w której programiści polegają na podpowiedziach w języku naturalnym do generowania całych funkcji, zamiast pisać ręcznie składnię.

Podczas gdy narzędzia takie jak Cursor i Replit spopularyzowały ten przepływ pracy w przeglądarce, Mistral wypycha go bezpośrednio do terminala.

Mistral Vibe CLI służy jako narzędzie tego przejścia, umożliwiające osadzenie sztucznej inteligencji bezpośrednio w lokalnym środowisku programisty. Działając jako asystent wiersza poleceń typu open source, narzędzie wykorzystuje model Devstral do tłumaczenia podpowiedzi w języku naturalnym na konkretne działania.

Zamiast po prostu generować fragmenty, system został zaprojektowany do eksplorowania, modyfikowania i wykonywania zmian w całej bazie kodu.

Działa jako samodzielne narzędzie terminalowe lub w środowisku IDE za pośrednictwem protokołu komunikacji agenta. Interfejs udostępnia zestaw aktywnych narzędzi umożliwiających agentowi manipulowanie plikami, przeszukiwanie kodu, zarządzanie kontrolą wersji i autonomiczne wykonywanie poleceń powłoki.

Skanując struktury plików i status Git, interfejs CLI tworzy kontekst „świadomy projektu”, którego brakuje tradycyjnym narzędziom do autouzupełniania.

Może obsługiwać orkiestrację wielu plików, taką jak refaktoryzacja starszej bazy kodu lub aktualizacja zależności w całym projekcie, bez utraty kontroli nad szerszą logiką systemu.

Rzeczywistość testów porównawczych: wydajność a surowa moc

U podstaw tego strategicznego punktu zwrotnego leży skupienie się na wydajności operacyjnej, a nie tylko na czystej dominacji w benchmarkach.

Architektura ta, stworzona z myślą o obsłudze skali repozytoriów korporacyjnych, priorytetowo traktuje gęstość i głębokość pamięci.

Flagowa wersja Devstral 2 wykorzystuje gęstą strukturę transformatora o wartości 123 miliardów parametrów w połączeniu z oknem kontekstowym zawierającym 256 000 tokenów.

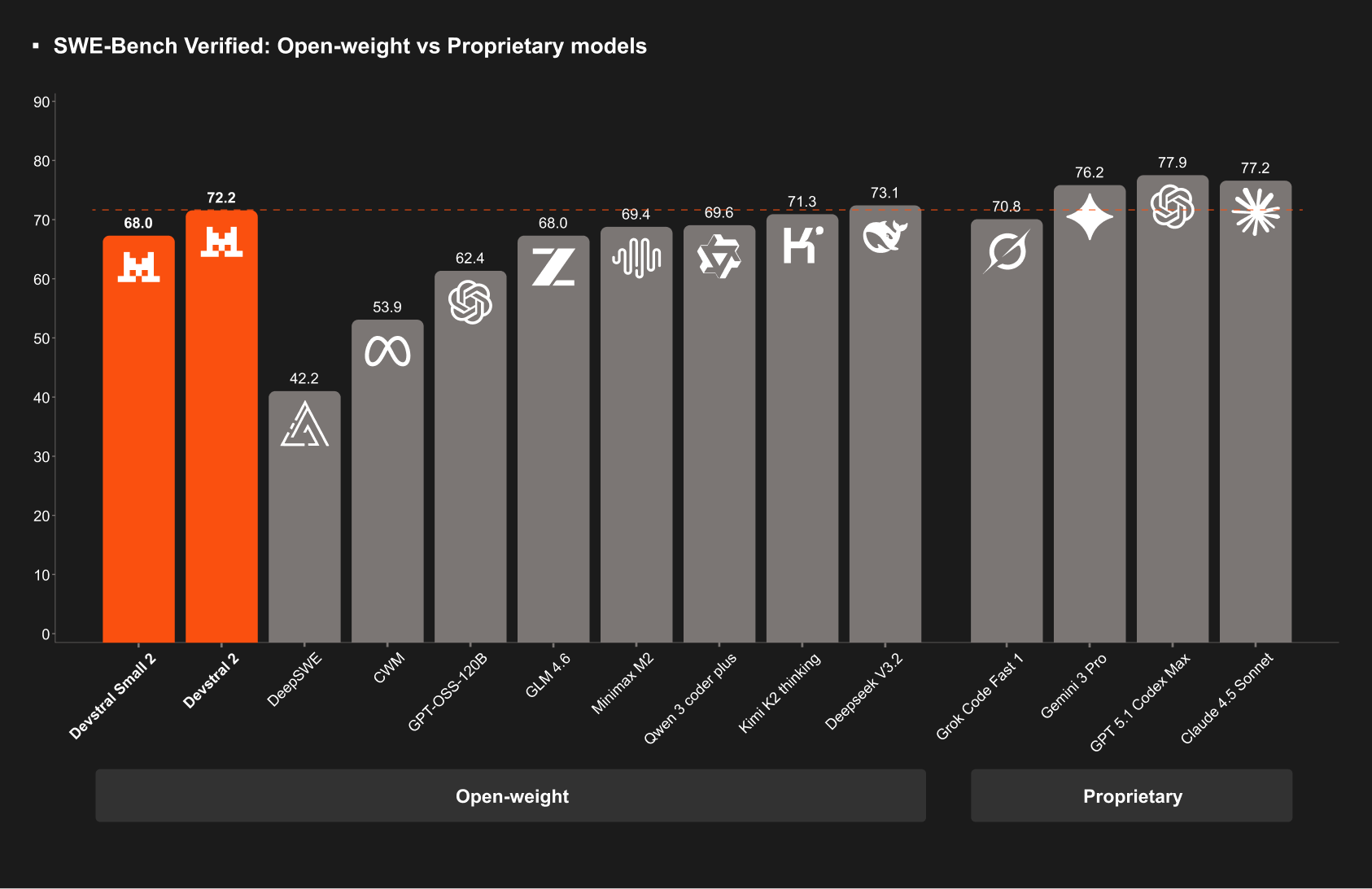

Uzyskuje wynik 72,2% w teście porównawczym SWE Verified, wynik, który Mistral przytacza jako dowód swojej pozycji jako najwyższej klasy modelu o otwartej masie, który pozostaje wydajny operacyjnie.

Jednocześnie mniejszy wariant Devstral Small 2 wykazuje znaczne możliwości w stosunku do zajmowanej powierzchni. Osiągając 68,0% w tym samym teście, podobno konkuruje z modelami pięciokrotnie większymi.

Co najważniejsze, ta wydajność jest zapewniana w ramach wystarczająco wydajnych, aby działać lokalnie na standardowym sprzęcie konsumenckim, co eliminuje potrzebę posiadania dedykowanej infrastruktury centrum danych.

Chociaż wynik modelu wynoszący 72,2% w teście SWE-bench Verified jest konkurencyjny (chociaż niezależna weryfikacja pozostaje w toku), technicznie pozostaje w tyle za chińskim modelem o otwartej wadze DeepSeek V3.2.

DeepSeek utrzymuje obecnie pułap open source na poziomie 73,1%, ale Mistral twierdzi, że prawdziwa przewaga leży w stosunku kosztów do wydajności.

Ceny nowego interfejsu API ustalono na 0,40 USD za milion tokenów wejściowych i 2,00 USD za milion tokenów wyjściowych. Ta struktura znacząco podkopuje Claude Opus 4.5 firmy Anthropic, oferując deklarowaną 7-krotną przewagę w zakresie efektywności kosztowej w porównaniu z wersją bazową Claude 3.5 Sonnet.

Wymagania sprzętowe odzwierciedlają nastawienie modelu na przedsiębiorstwa. Uruchomienie pełnego modelu parametrów 123B wymaga co najmniej czterech procesorów graficznych H100, co zdecydowanie plasuje go w warstwie centrum danych. Pomimo dużych potrzeb w zakresie infrastruktury, pierwsi użytkownicy zgłaszają dobre wskaźniki przepustowości.

Lokalna przewaga: Devstral Small 2

Dzięki oddzieleniu inteligencji od chmury Mistral jest również ukierunkowany na segment rynku wrażliwy na prywatność. Devstral Small 2, wariant o 24 miliardach parametrów, został specjalnie zaprojektowany do pracy na sprzęcie klasy konsumenckiej.

Uzyskując wynik w teście SWE wynoszący 68,0%, mniejszy model przewyższa swoją klasę wagową, zapewniając wydajność porównywalną ze znacznie większymi modelami poprzedniej generacji. Jednak jego głównym wyróżnikiem jest licencja.

Podczas gdy większy Devstral 2 jest dostarczany na podstawie zmodyfikowanej licencji MIT (prawdopodobnie sugerującej ograniczenia oparte na przychodach), Devstral Small 2 korzysta z liberalnej licencji Apache 2.0. To rozróżnienie umożliwia programistom modyfikowanie i integrowanie modelu bez obciążeń prawnych często związanych z ciężarami własności.

W przypadku przedsiębiorstw umożliwia to hybrydowy przepływ pracy: wykorzystanie ciężkiego modelu 123B do złożonego planowania architektury za pośrednictwem interfejsu API i jednoczesne wdrażanie modelu 24B lokalnie w celu szybkiego, prywatnego uzupełniania kodu, który nigdy nie opuszcza firmowej zapory sieciowej.

Kontekst rynkowy: wyścig zbrojeń „Code Red”

Przybycie podczas w okresie intensywnej działalności w sektorze kodowania sztucznej inteligencji, premiera następuje w okresie niedawnego gorączki wydawania rozwiązań AI.

Konkurenci dążą do integracji pionowej, aby przyciągnąć programistów. Współpraca Google Cloud z Replit jest przykładem tej strategii zamkniętego źródła, łączącej IDE, obliczenia w chmurze i model w jeden zastrzeżony stos. Podobnie Gemini 3 Pro i nowe środowisko IDE Antigravity mają na celu utrzymanie użytkowników w ekosystemie Google.

Własność infrastruktury również stała się kluczowym polem bitwy. Po przejęciu Bun firma Anthropic buduje dedykowane środowisko wykonawcze, aby zoptymalizować realizację zadań swoich agentów, jeszcze bardziej podnosząc barierę wejścia na rynek dla niezależnych dostawców modeli.

Podejście firmy Mistral oferuje wyraźną alternatywę: pozycjonuje się jako „europejski mistrz”, który zapewnia elastyczność otwartych ciężarów i rozmieszczenie lokalne, ostro kontrastując z otoczonymi murem ogrodami wznoszonymi przez jej amerykańskich rywali.