Kilka miesięcy po wprowadzeniu narzędzi do podsumowań opartych na technologii Gemini firma Google staje w obliczu ponownej analizy tego, w jaki sposób napędza modele sztucznej inteligencji. Raporty wskazują, że firma po cichu domyślnie włączyła „Inteligentne funkcje” dla użytkowników spoza Europy, udzielając pozwolenia na skanowanie prywatnych e-maili i załączników w celu potencjalnego szkolenia swoich generatywnych systemów sztucznej inteligencji.

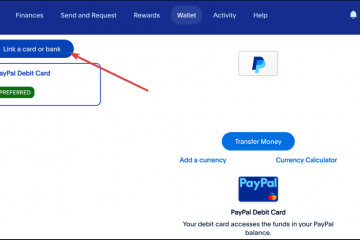

Ta zmiana wymusza ostry kompromis: użytkownicy muszą albo pozwolić na wykorzystywanie ich danych do ulepszenia modelu, albo całkowicie wyłączyć podstawowe narzędzia zwiększające produktywność, takie jak synchronizacja kalendarza i śledzenie przesyłek.

Podczas gdy przepisy europejskie nakładają rygorystyczne zasady zgody, użytkownicy z USA automatycznie rejestrują się w programie ekosystem udostępniania danych, który stanowi podstawę agresywnej ekspansji sztucznej inteligencji Google.

„Cicha” rejestracja i pułapka narzędziowa

Techniczny YouTuber i bloger Dave Jones zauważył znaczącą zmianę w domyślnych ustawieniach Google dla użytkowników spoza Europy, co oznacza odejście od poprzednich norm dotyczących prywatności.

W centrum kontrowersji znajduje się ustawienie „Inteligentne funkcje i personalizacja”, które zapewnia Google szeroki dostęp do skanowania treści prywatnych wiadomości e-mail, dzienników czatów i załączników.

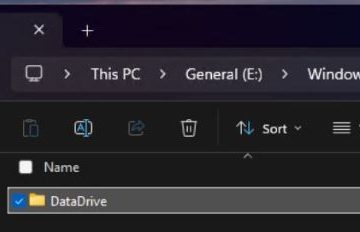

WAŻNA wiadomość dla wszystkich użytkowników Gmaila.

Zostałeś automatycznie WŁĄCZONY, aby umożliwić Gmailowi dostęp do wszystkich Twoich prywatnych wiadomości i załączników w celu uczenia modeli sztucznej inteligencji.

Musisz ręcznie wyłączyć funkcje inteligentne w menu Ustawienia w DWÓCH lokalizacjach.Prześlij dalej, aby każdy wiedział. pic.twitter.com/54FKcr4jO2

— Dave Jones (@eevblog) 19 listopada 2025 r.

Jako Pieter Arntz z Malwarebytes uwagi: „Google dodał pod radarem funkcje, które umożliwiają Gmailowi dostęp do wszystkich prywatnych wiadomości i załączników w celu szkolenia modeli sztucznej inteligencji”, podkreślając brak towarzyszących fanfar zmiana.

W przeciwieństwie do poprzednich wersji zasad wykorzystania danych, to pozwolenie jest wyraźnie powiązane z „udoskonalaniem” generatywnych modeli sztucznej inteligencji, co budzi obawy, czy korespondencja osobista jest wykorzystywana do uczenia podstawowych modeli, takich jak Gemini.

Wdrożenie tworzy to, co krytycy nazywają „pułapką użyteczności”, w której udostępnianie danych jest nierozerwalnie powiązane z podstawowymi narzędziami zwiększającymi produktywność. Wyłączenie ustawienia udostępniania danych AI powoduje pojawienie się szeregu uszkodzonych funkcji, w tym Smart Compose, automatycznego tworzenia wpisów w kalendarzu na podstawie e-maili i śledzenia przesyłek.

Użytkownicy próbujący chronić swoje dane muszą przejść złożony, dwuetapowy proces rezygnacji, wyłączając zarówno „Inteligentne funkcje w Gmailu, czacie i Meet”, jak i „Inteligentne funkcje w Google Workspace”, aby całkowicie odciąć łącze danych. Arntz zauważa:

„Aby w pełni zrezygnować, musisz wyłączyć „Inteligentne funkcje” Gmaila w dwóch oddzielnych miejscach w swoich ustawieniach. Nie przegap żadnej, w przeciwnym razie szkolenie AI może być kontynuowane.”

Projekt interfejsu użytkownika aktywnie zniechęca do rezygnacji, przedstawiając listę ostrzegawczą funkcji, które zostaną utracone, tworząc ultimatum „prywatność kontra użyteczność”.

To podejście kontrastuje ze szczegółową kontrolą często wymaganą przez zwolenników ochrony prywatności, zmuszanie użytkowników do wyboru między funkcjonalną skrzynką odbiorczą a prywatną.

Głód danych: dlaczego Google potrzebuje Twojej skrzynki odbiorczej

Oficjalna dokumentacja pomocy Google określa podstawę prawną tego przetwarzania, która obejmuje „tworzenie nowych produktów i funkcji”.

Firma oświadcza, że „włączając inteligentne funkcje w Gmailu, Czacie i Meet, zgadzasz się, aby Gmail, Czat i Meet korzystały z Twoich treści i aktywności w tych usługach w celu personalizowania Twoich doświadczeń w tych aplikacjach”, uznając dostęp do danych za niezbędny element umowy o świadczenie usług.

„Aby ulepszyć nasze usługi. Jeśli włączyłeś którekolwiek z ustawień inteligentnych funkcji, możemy również przetwarzać Twoje treści i aktywność w Workspace, aby ulepszyć te funkcje.”

„Przetwarzanie informacji w tym celu jest konieczne ze względu na uzasadnione interesy Google i naszych użytkowników w zakresie: świadczenia, utrzymywania i ulepszania usług… opracowywania nowych produktów i funkcji… przeprowadzania badań, które przynoszą korzyści naszym użytkownikom i społeczeństwu.”

Dwuznaczność „personalizacji”, która może obejmować „dostrajanie” modeli lokalnych (z korzyścią dla użytkownika) i „szkolenie” podstawowych modeli (z korzyścią dla Google) pozostaje krytycznym punktem spornym. Chociaż Google twierdzi, że dane są wykorzystywane do „ulepszania” funkcji, brak jasnego rozróżnienia pozostawia otwartą możliwość, że dane użytkowników przyczyniają się do szerszej inteligencji ekosystemu Gemini.

„Podział prywatności” powstał ze względu na położenie geograficzne: Google potwierdza, że te ustawienia są domyślnie wyłączone w EOG, Wielkiej Brytanii, Szwajcarii i Japonii ze względu na bardziej rygorystyczne przepisy, takie jak RODO.

„Po włączeniu inteligentnych funkcji w Google Workspace, zgadzasz się, aby Google Workspace korzystało z Twoich treści i aktywności w Workspace w celu personalizacji usług Workspace.”

„Po wyłączeniu tego ustawienia nie będziesz mieć możliwości korzystania z usług wymienionych powyżej w usługach Google Workspace. Aby nadal korzystać z tych funkcji, musisz ponownie włączyć to ustawienie.”

W przypadku użytkowników w Stanach Zjednoczonych, które nie mają podobnych zabezpieczeń federalnych, domyślną postawą jest włączenie do ekosystemu udostępniania danych. Ta rozbieżność uwydatnia, jak presja regulacyjna, a nie życzliwość korporacji, dyktuje domyślny poziom prywatności Big Tech.

Kontekst historyczny podkreśla ryzyko wdrażania tych modeli na prywatnych danych: błąd związany z tłumaczeniem AI Gmaila w Google Gmail z lipca 2025 r. służy jako przestroga. W wyniku tego incydentu firma Gemini błędnie przetłumaczyła niemieckie e-maile, zamieniając politycznego „asa” w „tyłek”, powodując znaczną szkodę wizerunkową wydawców.

Pomimo tych zagrożeń dynamika branży sugeruje, że gromadzenie danych staje się standardowym kosztem dostępu do bezpłatnych usług.

Ron Richards z podcastu Android Faithful opisał szerszy trend na początku tego roku, mówiąc: „ten statek wypłynął. I nie tylko od Google, ale w całej branży… Sztuczna inteligencja jest tu… i to nie zniknie”, co odzwierciedla rosnącą rezygnację wśród obserwatorów technologii, że integracja sztucznej inteligencji jest nieunikniona.

Prywatność jako produkt luksusowy

Wyłania się wyraźna segmentacja rynku, w którym prywatność staje się cechą premium, a nie standardowym prawem. Konkurenci tacy jak Perplexity czerpią z tego korzyści, oferując plan „Max” za 200 USD miesięcznie, który wyraźnie obiecuje nie trenować modeli na podstawie danych użytkowników.

To ostro kontrastuje z bezpłatnym modelem Google wspieranym reklamami, który polega na zarabianiu na danych użytkowników poprzez reklamy lub szkolenie modeli. Pieter Arntz argumentował, że „brak wyraźnej zgody wydaje się krokiem wstecz dla osób, które chcą mieć kontrolę nad sposobem wykorzystywania ich danych osobowych”, wskazując na ograniczenie swobody użytkownika w obliczu ustawień domyślnych.