Google zwiększa swoje starania o dominację w sprzęcie AI. W czwartek firma ogłosiła, że jego najpotężniejszy, niestandardowy układ, Ironwood TPU, staje się teraz ogólnie dostępny dla klientów korzystających z chmury.

Stworzony, aby sprostać rosnącemu zapotrzebowaniu na wnioskowanie AI, ten nowy procesor radzi sobie z pracą w czasie rzeczywistym za chatbotami. Aby wspierać te systemy sztucznej inteligencji, firma Google wprowadziła także nowe, ekonomiczne procesory Axion do codziennych zadań obliczeniowych.

To strategiczne posunięcie jest skierowane do kluczowych klientów, takich jak Anthropic, i zaostrza wyzwanie rzucone przez Google liderowi rynku Nvidii w krytycznej bitwie o infrastrukturę sztucznej inteligencji.

Ironwood: niestandardowa krzemowa elektrownia na miarę epoki wnioskowania

Aby zasilić nową generację modeli sztucznej inteligencji, Google stawia na opiera się na strategii zintegrowanej pionowo.

Głównym elementem tych wysiłków jest jednostka przetwarzająca Tensor siódmej generacji, Ironwood, która została zaprezentowana po raz pierwszy w kwietniu.

W chwili wprowadzenia do powszechnej dostępności, chip został zaprojektowany specjalnie z myślą o tym, co Google nazywa „erą wnioskowania”, czyli przejściem od uczenia ogromnych modeli do wdrażania ich w celu uzyskania użytecznych, responsywnych interakcji na dużą skalę.

Ironwood zapewnia znaczący wzrost wydajności, zaprojektowany z myślą o sprostaniu złożonym wymaganiom zarówno szkolenie, jak i obsługa największych współczesnych modeli sztucznej inteligencji.

Według Google nowa architektura zapewnia 10-krotnie wyższą wydajność szczytową w porównaniu z poprzedniczką TPU v5p i ponad czterokrotnie lepszą wydajność na chip w porównaniu z poprzednią generacją Trillium.

W swojej największej konfiguracji system Ironwood może osiągnąć zdumiewającą 42,5 exaFLOPS mocy obliczeniowej 8 PR, co jest wskaźnikiem niezbędnym dla arytmetyki o niskiej precyzji, która dominuje we współczesnych obciążeniach AI.

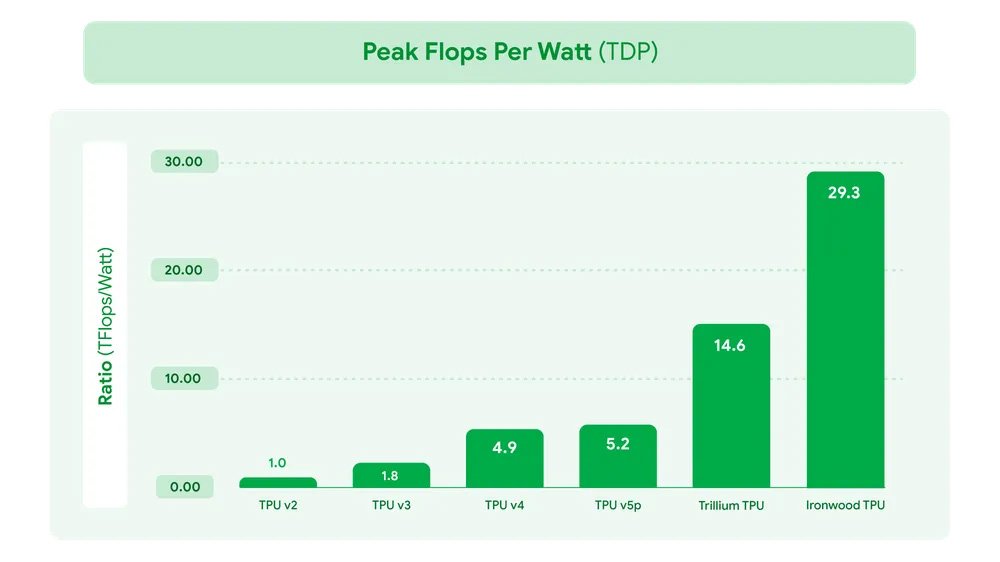

Ta surowa moc jest połączona z naciskiem na wydajność; Ironwood może poszczycić się dwukrotnie większą wydajnością na wat niż Trillium, co czyni go najbardziej energooszczędnym jak dotąd chipem Google.

Google TPU Peak Flops per Watt (źródło: Google)

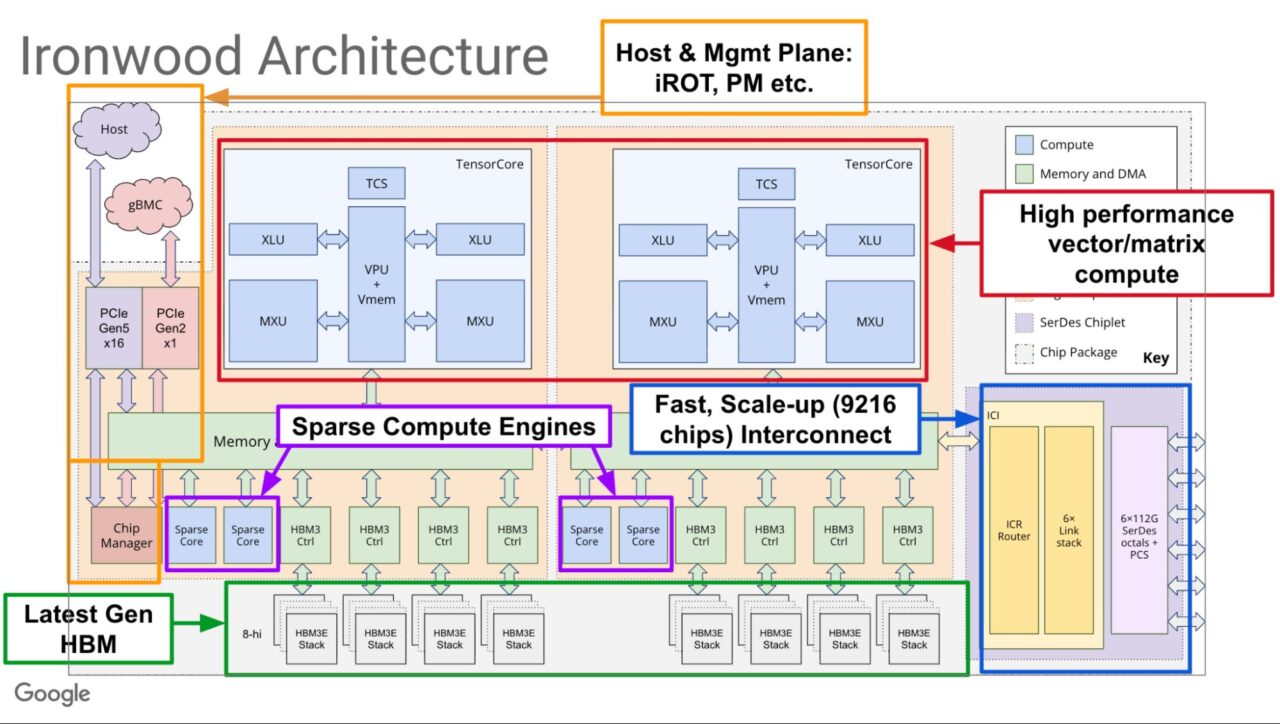

Ten poziom wydajności jest użyteczny tylko wtedy, gdy można go skalować, a architektura Ironwood została zaprojektowana z myślą o masywnej, spójnej pracy.

Pojedynczy „superpod” Ironwood może połączyć do 9216 pojedynczych chipów, dzięki czemu mogą działać jako pojedynczy, zunifikowany superkomputer. Podstawą tego systemu jest szybka struktura Inter-Chip Interconnect (ICI), która zapewnia przepustowość między chipami do 9,6 terabajta na sekundę, tworząc gęstą topologię 3D Torus.

Ta sieć umożliwia chipom dostęp do kolosalnej, współdzielonej puli 1,77 petabajtów pamięci o dużej przepustowości (HBM), eliminując wąskie gardła w danych, które mogą sparaliżować zadania AI na dużą skalę.

Aby połączyć te klastry chipów, Google wykorzystuje dynamiczną sieć przełączników obwodów optycznych (OCS). Ta konfigurowalna struktura ma kluczowe znaczenie zarówno dla skali, jak i odporności.

Jak szczegółowo opisano w przeglądzie technicznym firmy, OCS może optycznie ominąć każdy uszkodzony sprzęt i ustanowić nowe, kompletne obwody łączące tylko zdrowe jednostek.

Architektura TPU Google Ironwood (źródło: Google)

Architektura TPU Google Ironwood (źródło: Google)

Dla klientów wykonujących zadania szkoleniowe, które mogą trwać tygodniami, ta dynamiczna odporność na awarie jest krytyczną funkcją, która zapobiega kosztownym przestojom i maksymalizuje wydajność produktywny czas pracy całego systemu.

Co najważniejsze, ten zaawansowany sprzęt jest głęboko zintegrowany ze wspólnie zaprojektowanym stosem oprogramowania zbudowanym w oparciu o filozofię optymalizacji na poziomie systemu. Jego rdzeniem jest opracowany przez Google kompilator przyspieszonej algebry liniowej (XLA), który tłumaczy kod wysokiego poziomu z popularnych frameworków, takich jak JAX i PyTorch, na wysoce zoptymalizowane instrukcje maszynowe.

Kompilator został specjalnie zaprojektowany z myślą o wyspecjalizowanym sprzęcie TPU, w tym jego gęstych jednostkach mnożenia macierzy (MXU) i jednostkach przetwarzania wektorowego (VPU). Automatycznie łącząc operacje w wydajne jądra, XLA zapewnia potężną wydajność „od razu po wyjęciu z pudełka”.

Można wywnioskować, że firma dodatkowo zoptymalizowała stos, włączając najnowocześniejsze silniki obsługujące, takie jak vLLM w Ironwood dzięki nowemu, ujednoliconemu backendowi, dzięki czemu jego ogromne możliwości będą bardziej dostępne dla programistów wdrażających modele w środowisku produkcyjnym.

Rozwój sprzętowy Google jest elementem znacznie większej, wielopłaszczyznowej strategii infrastrukturalnej.

W ostatnich raportach podkreśliliśmy niektóre ambitne plany Google, od geopolitycznie strategicznego centrum danych AI na australijskiej Wyspie Bożego Narodzenia po „moonshot” Project Suncatcher, którego celem jest budowa kosmicznych centrów danych wyposażonych w TPU.

Inicjatywy podkreślają kolosalne zasoby wymagane do utrzymania się w czołówce sztucznej inteligencji.

[treść osadzona]

Rozbudowa Axion: nowa definicja obliczeń ogólnego przeznaczenia

Oprócz wyspecjalizowanych akceleratorów sztucznej inteligencji nowoczesne aplikacje wymagają potężnego i wydajnego szkieletu do codziennych obciążeń.

Google stara się rozwiązać ten problem, rozszerzając niestandardowy Axion oparty na ARM Portfolio procesorów. Firma ogłosiła, że jej nowe maszyny wirtualne N4A są już dostępne w wersji zapoznawczej, wraz ze zbliżającą się zapowiedzią C4A metal, pierwszych instancji bare-metal opartych na architekturze ARM.

Procesory te, zaprojektowane z myślą o zapewnieniu wyjątkowej ceny do wydajności, obsługują zadania ogólnego przeznaczenia obsługujące aplikacje AI, w tym przygotowywanie danych, skonteneryzowane mikrousługi i serwowanie stron internetowych.

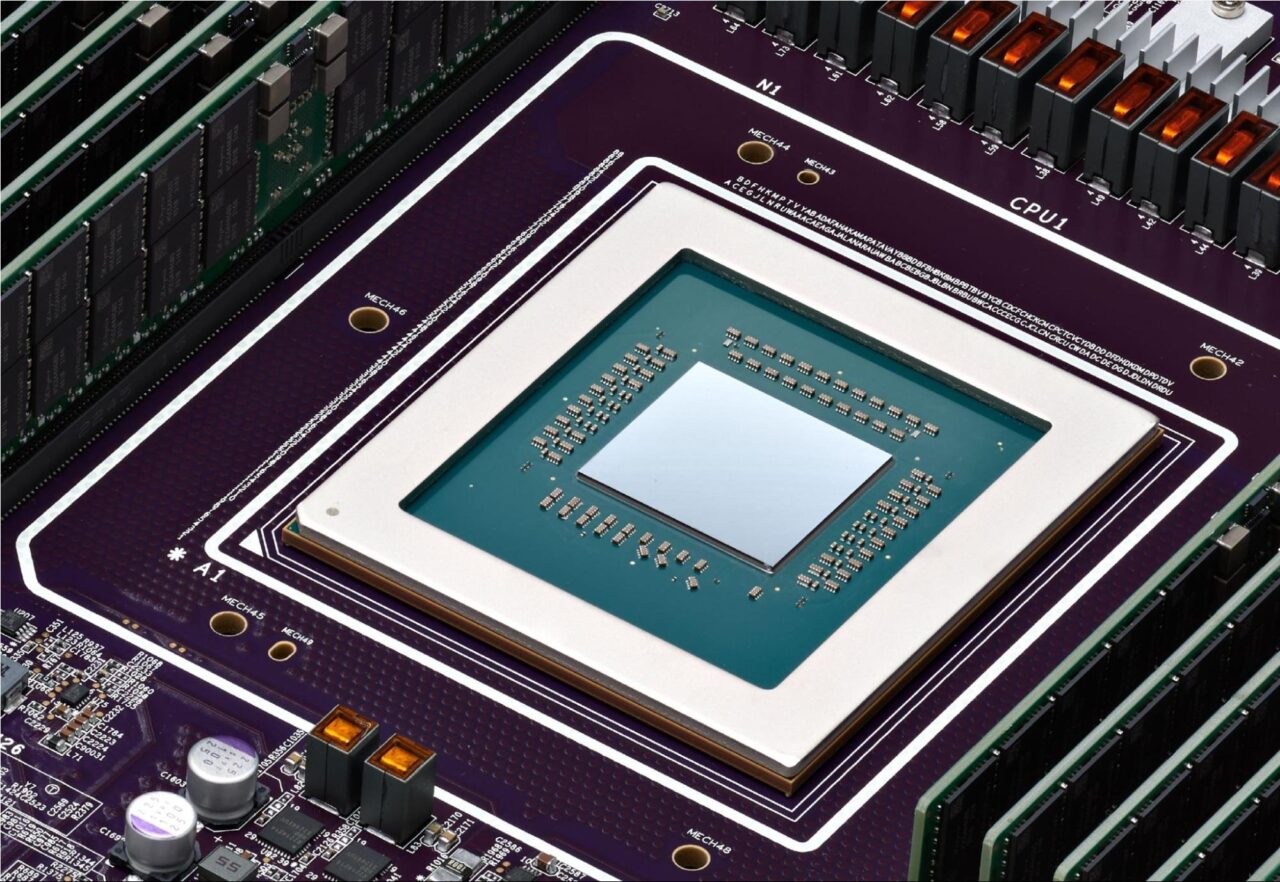

Procesor Google Axion (źródło: Google)

Procesor Google Axion (źródło: Google)

Wczesne opinie klientów podkreślają znaczne korzyści. Siergiej Koren, główny architekt infrastruktury w ZoomInfo, pochwalił nowe instancje, stwierdzając: „W naszej wersji zapoznawczej nowych instancji N4A zaobserwowaliśmy 60% poprawę stosunku ceny do wydajności dla tych kluczowych obciążeń w porównaniu z ich odpowiednikami opartymi na architekturze x86″.

Podobnie Vimeo odnotowało 30% poprawę wydajności swojego podstawowego obciążenia transkodowaniem wideo w porównaniu z maszynami wirtualnymi opartymi na architekturze x86.

Google pozycjonuje Axion jako wyraźną i wydajniejszą alternatywę dla tradycyjnych procesorów.

Według Marka Lohmeyera, wiceprezesa i dyrektora generalnego ds. sztucznej inteligencji i infrastruktury obliczeniowej w Google Cloud: „Będą miały o 50% wyższą wydajność niż porównywalne procesory generacji x86 i o 60% lepszą efektywność energetyczną niż porównywalne instancje oparte na architekturze x86.”

Wdrożenia strategiczne a wyścig zbrojeń AI

Ogromne zaangażowanie firmy Anthropic stanowi potężną walidację niestandardowego krzemu Google. Laboratorium AI, twórca rodziny modeli Claude, planuje uzyskać dostęp do nawet 1 miliona TPU, co sygnalizuje duże zaufanie do możliwości platformy zarówno w zakresie uczenia, jak i wnioskowania.

James Bradbury, dyrektor ds. obliczeń w firmie, wyjaśnił korzyści: „Ulepszenia Ironwood w zakresie wydajności wnioskowania i skalowalności uczenia pomogą nam efektywnie skalować przy jednoczesnym zachowaniu szybkości i niezawodności, jakiej oczekują nasi klienci.”

Jednak ta ważna transakcja ma miejsce w złożonej rzeczywistości obejmującej wiele chmur. Chociaż partnerstwo to znaczące zwycięstwo dla Google, raporty wyjaśniają, że Anthropic utrzymuje strategię zróżnicowanej infrastruktury, a głównym dostawcą usług w chmurze pozostaje Amazon Web Services.

Odzwierciedla ono szerszy trend branżowy, w którym główne laboratoria sztucznej inteligencji unikają uzależnienia od jednego dostawcy, co było strategią obserwowaną wcześniej, gdy OpenAI zaczęło korzystać z Google Cloud w celu uzupełnienia swojej podstawowej infrastruktury Microsoft Azure.

Rozwijając się w obliczu intensywnego wyścigu zbrojeń w zakresie sztucznej inteligencji, wysiłki Google dotyczące niestandardowych krzemów mają na celu wyłącznie przezwyciężenie wyzwań Dominacja rynkowa Nvidii. Konkurencja wymaga ogromnych inwestycji.

Aby sprostać rosnącemu popytowi, Google podniosło niedawno górną granicę swojej prognozy wydatków kapitałowych na ten rok do 93 miliardów dolarów z 85 miliardów dolarów.

Tak ogromne zaangażowanie finansowe pokazuje, że kontrolowanie podstawowego sprzętu jest obecnie postrzegane jako kluczowa przewaga konkurencyjna.

Wprowadzając zarówno wysoce wyspecjalizowane TPU Ironwood, jak i wydajne, uniwersalne procesory Axion, Google prezentuje kompleksowy, wspólnie zaprojektowane rozwiązanie.

Firma zakłada, że zaoferowanie klientom zoptymalizowanego i opłacalnego stosu sprzętu, od chipa po centrum danych, będzie kluczem do wygrania kolejnej fazy rewolucji AI.