OpenAI ogłosiło w poniedziałek nowe partnerstwo. Współpracuje z aktorem Bryanem Cranstonem i związkiem zawodowym SAG-AFTRA.

Grupa będzie blokować niezatwierdzone filmy AI w aplikacji Sora. Posunięcie to następuje po tygodniach ostrej krytyki ze strony Hollywood. Reakcja narosła po tym, jak w fałszywych klipach wykorzystano głos i podobieństwo Cranstona.

Nowe przedsięwzięcie ma na celu stworzenie silniejszych zasad bezpieczeństwa dotyczących tożsamości cyfrowej. Jest to najbardziej bezpośrednia jak dotąd reakcja OpenAI na burzę związaną z zgodą i wykorzystaniem wizerunku osoby bez pozwolenia. Aplikacja została uruchomiona pod koniec września.

We wspólnym oświadczeniu OpenAI oświadczyło, że będzie współpracować z Cranston, SAG-AFTRA, United Talent Agency (UTA) i Creative Artists Agency (CAA), aby wzmocnić barierki. Posunięcie to było bezpośrednią reakcją na nieautoryzowane klipy aktora „Breaking Bad”, które pojawiły się po premierze Sory 2.

Aktor Bryan Cranston pochwalił korektę kursu firmy, stwierdzając: „Jestem wdzięczny OpenAI za jej politykę i ulepszenie barier ochronnych i mam nadzieję, że on i wszystkie firmy zaangażowane w tę pracę uszanują nasze osobiste i zawodowe prawo do zarządzania replikacją naszego głosu i podobieństwo.”

Dyrektor generalny OpenAI Sam Altman potwierdził stanowisko firmy w sprawie praw wykonawców, mówiąc: „OpenAI jest głęboko zaangażowana w ochronę wykonawców przed sprzeniewierzeniem ich głosu i podobizny. Od początku wspieraliśmy ustawę NO FAKES, kiedy została ona wprowadzona w zeszłym roku, i zawsze będziemy stać na straży praw wykonawców”.

Od Viral Launch do PR Kryzys

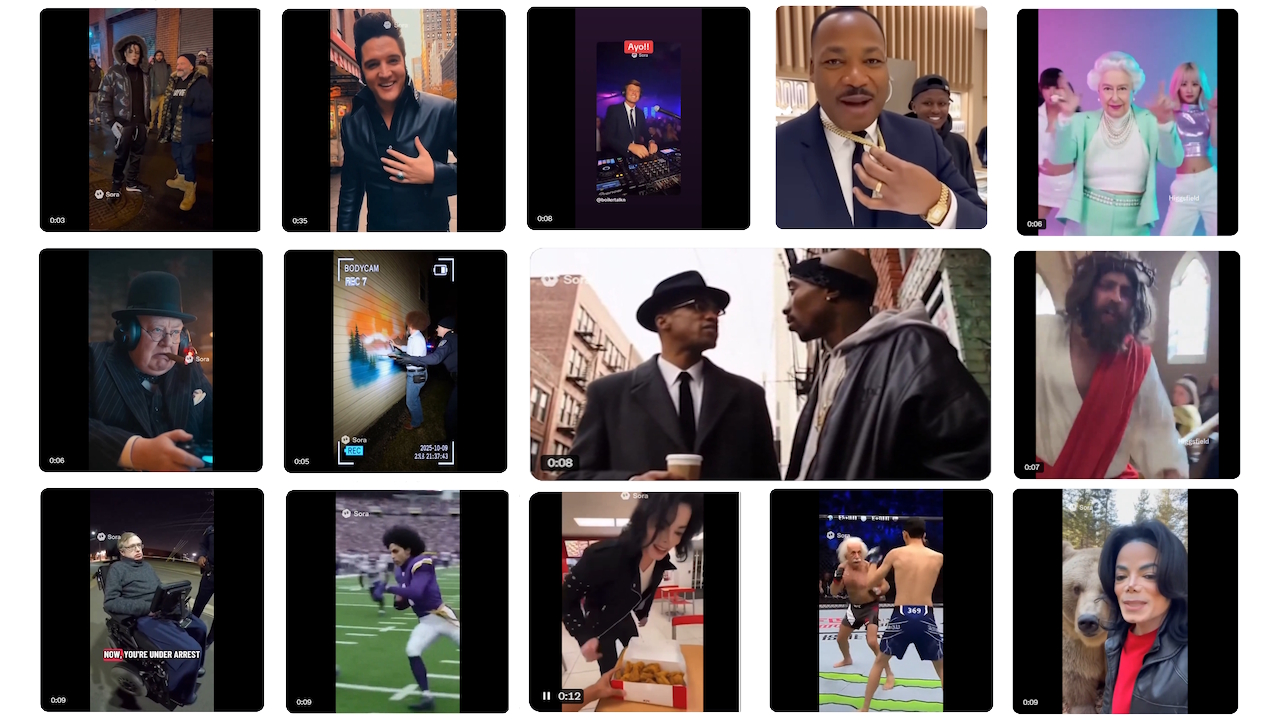

Kontrowersje nasilają się od premiery Sora 2 około 30 września. Potężny generator wideo OpenAI zadebiutował wraz z towarzyszącą mu aplikacją do mediów społecznościowych i kluczową decyzją polityczną: modelem „opt-out” dla postaci chronionych prawem autorskim. Oznaczało to, że domyślnie można było wygenerować dowolną chronioną figurkę.

Użytkownicy natychmiast zalali platformę surrealistycznymi i często obraźliwymi deepfakesami. Filmy te przedstawiały wszystkich, od ukochanych postaci z kreskówek po zmarłe postacie historyczne, w przedziwnych scenariuszach. Reakcja była szybka i dotkliwa, zmuszając OpenAI do przyjęcia postawy obronnej.

Najbardziej ostra krytyka pochodziła od rodzin zmarłych celebrytów. Zelda Williams, córka zmarłego Robina Williamsa, błagała użytkowników, aby zaprzestali tworzenia filmów zawierających sztuczną inteligencję jej ojca.

Opisała ból towarzyszący obserwowaniu, jak „spuścizna prawdziwych ludzi zostaje skondensowana do… okropnego, a lalkowanie ich przez TikTok doprowadza do szaleństwa”.

Podobnie rodzina Malcolma X potępiła te klipy jako głęboko lekceważące. Ilyasah Shabazz, jego córka, nazwała wykorzystywanie wizerunku ojca „bezczelnym i nieczułym”.

Oburzenie zakończyło się prostym, ale mocnym apelem córki Martina Luthera Kinga Jr., Bernice King, która opublikowała w X: „Zgadzam się co do mojego ojca. Proszę, przestań”.

Hollywood rysuje linię na piasku

Emocjonalne prośby rodzin zostały wzmocnione przez jednolitą reakcję Hollywood. Branża, już czujna wobec zagrożenia własności intelektualnej ze strony generatywnej sztucznej inteligencji, zmobilizowała się przeciwko nowej platformie OpenAI.

Główne agencje talentów, które reprezentują artystów znajdujących się w centrum kontrowersji, stanęły na czele ataku. Potężna Agencja Artystów Twórczych (CAA) wydała 8 października ostre publiczne oświadczenie, określając aplikację jako bezpośrednie zagrożenie: „Jest oczywiste, że Open AI/Sora naraża naszych klientów i ich własność intelektualną na znaczne ryzyko”.

To zdanie odbiło się echem w całej branży, a największe studia, takie jak Disney, podobno odmówiły pojawienia się ich materiałów w aplikacji.

Stowarzyszenie Motion Picture Association (MPA) również wyraziło swoją opinię, umieszczając ciężar prawny za nadużycia spoczywa bezpośrednio na firmie zajmującej się sztuczną inteligencją. Dyrektor generalny Charles Rivkin stwierdził, że „… to na nich – a nie na posiadaczach praw – spoczywa odpowiedzialność za zapobieganie naruszeniom usługi Sora 2″, dając jasno do zrozumienia, że posiadacze praw nie będą odpowiedzialni za kontrolowanie usługi OpenAI.

Ten ogólnobranżowy bunt oznaczał znaczną eskalację, przekształcając debatę w konfrontację korporacyjną o wysoką stawkę.

Walka o odzyskanie Kontrola

W obliczu pełnego kryzysu PR OpenAI próbowało powstrzymać skutki serii szybkich zmian w polityce. Początkowe podejście firmy bez użycia rąk okazało się nie do utrzymania w obliczu skoordynowanej reakcji.

3 października, zaledwie kilka dni po premierze, Sam Altman ogłosił odejście od systemu rezygnacji.

W poście na blogu obiecał środowisko bardziej przyjazne twórcom, stwierdzając, że OpenAI „zapewni posiadaczom praw bardziej szczegółową kontrolę nad generowaniem znaków, podobnie do modelu opt-in dotyczącego podobieństwa, ale z dodatkowymi kontrolami”. Było to pierwsze poważne przyznanie się do niepowodzenia początkowej polityki.

Zmiany trwały przez cały miesiąc. Do 9 października firma zmieniła swoje zasady, aby umożliwić przedstawicielom „niedawno zmarłych” osób publicznych składanie formalnych wniosków o zablokowanie ich podobizny.

Zasady te zostały wystawione na próbę nieco ponad tydzień później. 17 października OpenAI ogłosiło, że wstrzymało wszystkie pokolenia Martina Luthera Kinga Jr. na bezpośrednią prośbę jego majątku, powołując się na tworzenie „obraźliwych przedstawień”.

W oświadczeniu wyjaśniającym to posunięcie firma przyznała, że starała się zachować delikatną równowagę: „Chociaż wolność słowa jest silnie zainteresowana przedstawianiem postaci historycznych, OpenAI uważa, że osoby publiczne i ich rodziny powinny ostatecznie mieć kontrolę nad tym, jak ich rodziny wykorzystywane jest podobieństwo.”

Poruszanie się po legalnym i etycznym polu minowym

Burza ogniowa Sora 2 uwydatnia rozległą szarą strefę prawną i etyczną. Tradycyjne przepisy dotyczące zniesławienia zazwyczaj nie mają zastosowania do zmarłego, pozostawiając rodzinom ograniczone środki prawne.

Ich głównym sposobem jest złożona i niespójna mozaika przepisów stanowych regulujących prawo do publikacji pośmiertnych. Ta próżnia prawna pozwala na tworzenie treści, które choć nie zawsze mają charakter komercyjny, powodują znaczny niepokój emocjonalny.

Co więcej, kontrowersje sprawiły, że nierozwiązana debata na temat polegania sztucznej inteligencji na ogromnych ilościach zebranych danych internetowych w celach szkoleniowych – z powrotem w centrum uwagi.

Krytycy twierdzą, że firmy budują potężne modele na materiałach chronionych prawem autorskim bez pozwolenia, a jest to podstawowa kwestia, której branża jeszcze nie rozpracowała. rozwiązać.

OpenAI wskazało na swoje wsparcie dla ustawy NO FAKES jako część rozwiązania. Jednak ta federalna ustawa ma swoich krytyków. zwolennicy praw cyfrowych ostrzegają, że szeroki język ustawy może stworzyć nowe prawo własności intelektualnej, które tłumi wolność słowa i parodię.

Ta seria ustępstw, której kulminacją jest w nowym partnerstwie z Cranston i SAG-AFTRA sygnalizuje ruch w kierunku przyszłości opartej na bardziej współpracy i zezwoleniach.

Jednak podkreśla także ogromne wyzwanie, jakim jest zrównoważenie szybkich innowacji technologicznych z podstawowymi prawami twórców i jednostek.