Badania przedstawione na konferencja Chi 2025 ujawnia ciekawy wzór w tym, w jaki sposób laypeople reaguje na poradę prawną: zgłaszają, że są bardziej skłonni działać na temat wskazówek z dużych modeli językowych (LLMS) jak chatgpt niż ludzkich prawników, ale konkretnie, gdy źródło nie jest identyfikowane.

Preferencja ta pojawia się, mimo że ludzie wykazują zdolność do rozróżnienia między AI a tekstem napisanym przez człowieka lepiej niż szansa, sugerując złożony związek z automatyczną wiedzą specjalistyczną, jak szczegółowo opisano w artykule zatytułowanym „Zastrzeżone sprzeciw! Lofem mogą odróżnić duże modele językowe od prawników, ale nadal sprzyjać poradom od LLM.”

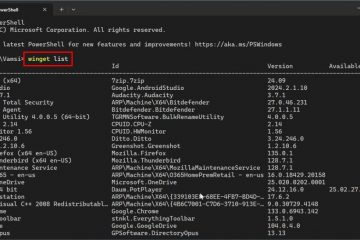

ustalenia Radość z serii trzech eksperymentów z udziałem 288 uczestników. Naukowcy przedstawili scenariusze prawne obejmujące wspólne problemy, takie jak przepisy dotyczące ruchu, planowania i nieruchomości, oparte na rzeczywistych zapytaniach online pochodzących z platform takich jak Reddit’s r/legaladviceuk . Następnie pokazali uczestników odpowiadających poradach generowanych przez Chatgpt-4o Openai lub przez specjalistycznych prawników w Wielkiej Brytanii, mierząc gotowość do działania lub zidentyfikowanie źródła.

Preference> Znajomość źródła

Podstawowe odkrycie wyłoniło się z porównywania reakcji uczestników w oparciu o to, czy wiedzieli, kto napisał radę. Kiedy uczestnicy nie byli świadomi źródła (przetestowani w grupie „Nieznanego źródła” Eksperymentu 1 i potwierdzone w eksperymencie 2), konsekwentnie wyrażali znacznie wyższą gotowość do działania na podstawie porady LLM w porównaniu z radą ludzkich prawników. Jednak gdy źródło zostało wyraźnie oznaczone jako „LLM” lub „prawnik” (grupa „Znana źródło” Eksperymentu 1), różnica ta zniknęła; Oceny gotowości do działania stały się statystycznie podobne dla obu źródeł.

Naukowcy sugerują, że ta rozbieżność może wynikać z czynników społecznych, gdy źródło zostanie ujawnione; Ludzie mogą czuć się zobowiązani do oceniania porad od ludzkiego profesjonalisty wyżej, dostosowując się do postrzeganych oczekiwań tylko wtedy, gdy wyraźnie uświadomił.

Kolejnym czynnikiem może być same cechy tekstowe. W badaniu zauważono, że chociaż porady LLM były ogólnie krótsze, jego język zarejestrował się jako bardziej złożony w oparciu o wyniki czytelności LIX (miara, w której wyższe wyniki wskazują na większą trudność). W artykule omówiono, że LLM mogą przedstawić informacje z atrakcją pewności siebie, w przeciwieństwie do bardziej ostrożnego, wypełnionego hedgingiem języka typowego dla ludzkich prawników zajmujących się odpowiedzialnością i niuansem.

rozróżnianie AI, a jednak faworyzując go ślepo

dodając do złożoności, pokazały, że uczestnicy nie są całkowicie uwzględnione źródło. Zadanie oceny, jak prawdopodobne jest, że każda rada miała być wygenerowana przez człowieka (gdy nie jest to nieistotna), uczestnicy osiągnęli znacznie lepsze niż przypadek.

przy użyciu analizy charakterystycznej odbiornika (ROC)-metoda z teorii wykrywania sygnału w celu pomiaru dyskryminacji niezależnie od odchylenia odpowiedzi-badanie mierzyło obszar pod powierzchnią (AUC) 0,59. AUC na poziomie 0,50 reprezentuje szansę przypadkową, podczas gdy 1,0 jest doskonałą dokładnością, więc 0,59 wskazuje na prawdziwą, choć niedoskonała, zdolność do rozpoznania różnic tekstowych.

To przedstawia zagadkę: nawet z pewną pojemnością do wykrywania autorstwa AI, domyślne pochylenie podczas działania „ślepy” wydaje się sprzyjać wyjściu LLM. Ryzyko

Preferencja dla potencjalnie niewykrywalnych porad AI jest szczególnie istotna, biorąc pod uwagę znane problemy z niezawodnością nękającej obecne LLM. Ponieważ modele te rozszerzają się na bardziej wrażliwe aplikacje udzielające porad, takie jak niedawno zaktualizowana funkcja głębokich badań Openai w Chatgpt, ryzyko, że użytkownicy będą działać na temat niedokładnych informacji.

Raporty po wydaniu środkowej kwietnia w 2025 r.-na przykład wzorce modeli O3 i O4-Mini. Openai’s własny Dane pokazane modelu O4-MINI producted Uprowlefed Uprowited Uprowited Uprowited Uprowed. 48% czasu na jednym konkretnym punkcie odniesienia (personqa).

Badania badające, dlaczego te potężne modele halucynowe wskazują na kilka potencjalnych czynników związanych z ich szkoleniem. Teorie obejmują procesy uczenia się wzmocnienia (RL) prawdopodobnie nagradzające przekonujące wytwarzania, jeśli prowadzą do pozornie poprawnej ostatecznej odpowiedzi, wyzwania dla uczenia się wzmocnienia na podstawie ludzkich informacji zwrotnych (RLHF), gdy ludzcy oceniacze nie mogą łatwo zweryfikować dokładności złożonej analizy rozumowania pośredniego, a modele czasami brakuje dostępu do własnego kroku rozumowania o kroku między rurami konwersacji konwersacyjnej. Modele o3 wymyślanie działań, których nie mogli wykonywać . Jak zasugerował Neil Chowdhury, Neil Chowdhury, „nasza hipoteza jest taka, że rodzaj uczenia się wzmocnienia stosowanego w modelach O-Series może wzmacniać problemy, które zwykle są łagodzone (ale nie w pełni wymazane) przez standardowe rurociągi po treningu”. To tło potencjalnej niewiarygodności podkreśla obawy podniesione przez ustalenia Chi Paper na temat zaufania użytkownika.

Szerszy kontekst i poruszanie się

Ustalenia pasują do szerszej dyskusji na temat zaufania publicznego w sztucznej inteligencji. Podczas gdy użycie rośnie,

Badanie Chi dodaje niuans, co sugeruje, że ta nieufność może być bardziej wyraźna, gdy zaangażowanie AI jest wyraźne, kontrastując z preferencjami występującymi w scenariuszu niewidomego. Tendencja do faworyzowania porad „ślepej” AI komplikuje również wysiłki w celu zapewnienia odpowiedzialności, gdy narzędzia AI przyczyniają się do profesjonalnych wskazówek. Autorzy papieru Chi proponują poprawę umiejętności AI jako jedną ścieżkę naprzód, prawdopodobnie stosując metody szkolenia opracowane do identyfikacji dezinformacji. Wskazują również na znaczenie miar przezroczystości, odwołując się do przepisów, takich jak UE AI Ustawa, które nakazują jasne oznakowanie treści wygenerowanej przez AI ( art. 50 ) i ryzyko ujawniania niektórych aplikacji. Można zidentyfikować, a nie naśladować ludzkich ekspertów, może być kluczem do wspierania bardziej skalibrowanego zaufania użytkownika. Pełne materiały badawcze, w tym skrypty danych i analizy zastosowane w jspsych /