Współzałożyciel OpenAI, Ilya Sutskever, wygłosił wczoraj skłaniającą do myślenia prezentację na konferencji NeurIPS 2024, przedstawiając wizję sztucznej inteligencji, która łączy niezwykłą obietnicę z głęboką niepewnością.

NeurIPS 2024, czyli trzydziesta ósma doroczna konferencja na temat systemów przetwarzania informacji neuronowych, to jedna z najważniejszych i najbardziej wpływowych konferencji w obszarach sztucznej inteligencji i uczenia maszynowego. Wydarzenie odbędzie się w dniach 10–15 grudnia 2024 r. w Vancouver Convention Center w Vancouver w Kanadzie.

Podczas swojej prezentacji Sutskever opisał ostateczne pojawienie się superinteligentnych systemów sztucznej inteligencji zdolnych do rozumowania, nieprzewidywalności i i samoświadomość – oraz dylematy etyczne, jakie może wiązać się z tym postępem.

Sutskever, obecnie kierujący Safe Superintelligence Inc. (SSI) po odejściu z OpenAI w maju, uważa, że samo skalowanie modeli może nie być już rozwiązaniem na rzecz rozwoju sztucznej inteligencji.

Rozmawiając z publicznością składającą się z badaczy i liderzy branży Sutskever podkreślił, że superinteligentna sztuczna inteligencja będzie stanowić fundamentalne odejście od dzisiejszych systemów. Chociaż obecna sztuczna inteligencja przoduje w zadaniach wymagających rozpoznawania wzorców i intuicji, zawodzi ją w zakresie rozumowania – procesu poznawczego wymagającego zrozumienia i syntezy złożonych informacji.

„Im więcej system rozumuje, tym bardziej staje się nieprzewidywalny” – wyjaśnił Sutskever, podkreślając kluczowe wyzwanie dla przyszłego rozwoju sztucznej inteligencji.

Przewidział, że rozumowanie, nieprzewidywalność, a nawet samodzielność-świadomość zdefiniowałaby następną generację systemów sztucznej inteligencji, które określił jako „bardzo nieznacznie agentyczne”, superinteligentne systemy będą naprawdę autonomiczne.

„Ostatecznie – wcześniej czy później – te systemy rzeczywiście staną się agentyczne w rzeczywisty sposób” – powiedział, sugerując, że ta zmiana może zasadniczo zmienić sposób interakcji sztucznej inteligencji ze światem.

Droga do superinteligencji: powrót do ewolucji sztucznej inteligencji

Aby zrozumieć krok w kierunku superinteligencji, Suckever ponownie omówił główne kamienie milowe w rozwoju sztucznej inteligencji zastanawiając się nad wczesnymi sukcesami sieci pamięci długoterminowej (LSTM), będących podstawą uczenia maszynowego w pierwszej dekadzie XXI wieku.

„LSTM to zasadniczo sieć ResNet obrócona o 90°” – zażartował, odnosząc się do warstwowej konstrukcji tych sieci neuronowych. Chociaż LSTM były skuteczne w zachowywaniu informacji sekwencyjnych, borykały się ze skalowalnością i wydajnością, ograniczając ich zastosowanie do większych zbiorów danych i bardziej złożonych zadań.

Przełom nastąpił wraz z Transformersami, które zastąpiły LSTM jako architekturę wybieraną przez wiele zaawansowanych sztucznej inteligencji systemy. W przeciwieństwie do swoich poprzedników, Transformers mógł przetwarzać jednocześnie ogromne ilości danych, umożliwiając znaczny postęp w takich obszarach, jak przetwarzanie języka naturalnego i rozpoznawanie obrazów.

Te innowacje utorowały drogę modelom takim jak seria GPT OpenAI, które wykorzystują Transformers do generowania tekstu podobnego do ludzkiego i wykonywania skomplikowanych zadań.

Sutskever przypisał znaczną część tego postępu przyjęciu prawa skalowania — zasada mówiąca, że większe modele trenowane na większych zbiorach danych dają lepszą wydajność. „Jeśli masz bardzo duży zbiór danych i trenujesz bardzo dużą sieć neuronową, sukces jest gwarantowany” – powiedział, podkreślając siłę napędową prac OpenAI.

Przestrzegł jednak, że skalowanie ma swoje granice: „Osiągnęliśmy szczytowe dane. Jest tylko jeden Internet.”

Sutskever, będący wcześniej zwolennikiem zwiększania rozmiarów modeli w celu uzyskania lepszych wyników, zmienił zdanie, gdy branża zdała sobie sprawę, że skalowanie wiąże się ze skalowaniem. malejące zyski. „Lata 2010. były wiekiem skalowania, teraz znów wracamy do epoki cudów i odkryć. Każdy szuka czegoś następnego” – zauważył niedawno Sutskever, podkreślając, że „Skalowanie tego, co właściwe, ma teraz większe znaczenie niż kiedykolwiek”.

To wąskie gardło skłoniło badaczy do zbadania alternatywnych strategii, w tym danych syntetycznych. Dane syntetyczne, generowane w celu naśladowania informacji ze świata rzeczywistego, umożliwiają szkolenie systemów sztucznej inteligencji bez polegania na coraz rzadszych zbiorach danych wysokiej jakości.

Jednak Sutskever przyznał, że dane syntetyczne wiążą się z własnymi wyzwaniami, zauważając: „Dużym wyzwaniem jest ustalenie, co oznaczają dane syntetyczne i jak z nich korzystać”.

[treści osadzone]

W sztucznej inteligencji prawdopodobnie za około cztery lata zabraknie danych szkoleniowych tak jak wydawcy gazet zaczynają krytykować sposób wykorzystania ich treści, jeszcze bardziej ograniczając dostęp.

Budowanie systemów rozumowania: przyszłe przeszkody techniczne

Jednym z głównych tematów przemówienia Suckewiera było wyzwanie polegające na budowaniu systemów sztucznej inteligencji zdolnych do prawdziwego rozumowania, takich jak nowe modele o1 OpenAi, obecne modele, takie jak GPT-4o, w celu rozwiązywania problemów opierają się na korelacjach statystycznych i rozpoznawaniu wzorców, ale rozumowanie wymaga bardziej zniuansowanego zrozumienia kontekstu, przyczynowości i logiki.

„Systemy rozumowania są nieprzewidywalne, ponieważ wykraczają poza intuicję” – wyjaśnił Sutskever. Ta nieprzewidywalność, będąca cechą charakterystyczną inteligencji, sprawia również, że takie systemy są trudne do kontrolowania i testowania.

Wymagania obliczeniowe związane z rozumowaniem dodają kolejną warstwę złożoności. W przeciwieństwie do prostszych zadań, które można zrównoleglać i optymalizować pod kątem szybkości, wnioskowanie obejmuje procesy wymagające integracji wielu warstw informacji.

Te procesy zużywają znacznie więcej zasobów, przez co skalowalność jest stałym problemem. Sutskever podkreślił, że rozwiązanie tych wyzwań będzie miało kluczowe znaczenie dla wykorzystania potencjału superinteligentnej sztucznej inteligencji.

Pomimo tych przeszkód zachował optymizm co do trajektorii tej dziedziny. „Robimy cały ten postęp. To zdumiewające” – powiedział, wskazując na szybką ewolucję możliwości sztucznej inteligencji w ciągu ostatniej dekady. Jego uwagi odzwierciedlały zarówno podekscytowanie, jak i ostrożność, które charakteryzują rozwój systemów rozumowania.

Etyczne implikacje Superinteligentna sztuczna inteligencja: prawa, współistnienie i odpowiedzialność

Gdy Suckewer przechodził od postępu technicznego do szerszych implikacji, zagłębił się w jeden z najbardziej kontrowersyjnych tematów w sztuczna inteligencja: etyczne traktowanie systemów autonomicznych Spekulował, że w miarę dojrzewania superinteligentna sztuczna inteligencja może wymagać uznania i współistnienia wraz z ludzkością.

„Nie jest to zły wynik, jeśli sztuczna inteligencja chce z nami współistnieć i ma prawa. “, powiedział, przedstawiając prowokacyjną wizję sztucznej inteligencji jako czegoś więcej niż tylko narzędzia lub technologii.

Uwagi Sutskevera wpisują się w pojawiające się debaty na temat zarządzania sztuczną inteligencją i jej etyki, w których badacze coraz częściej zastanawiają się nad prawami i obowiązki inteligentnych systemów. Choć pomysł przyznania praw AI może wydawać się spekulacyjny, rodzi praktyczne pytania dotyczące odpowiedzialności i sprawczości.

Jeśli system potrafi samodzielnie rozumować, uczyć się i dostosowywać, kto jest odpowiedzialny za jego działania? Pytania te, zasugerował Suckever, podkreślają potrzebę nowych ram etycznych dostosowanych do możliwości superinteligentnej sztucznej inteligencji.

Podczas sesji pytań i odpowiedzi członek publiczności zapytał, w jaki sposób ludzkość może zachęcić sztuczną inteligencję do działania w sposób zgodny z wartości ludzkie. Odpowiedź Sutskevera odzwierciedlała zarówno złożoność problemu, jak i nieodłączną niepewność co do przyszłości sztucznej inteligencji.

„Struktury motywacyjne, które tworzymy, będą kształtować ewolucję tych systemów” – powiedział, ale szybko dodał: „Nie czuję się pewnie, odpowiadając na tego typu pytania, ponieważ wszystko jest tak niesamowicie nieprzewidywalne”.

>

Wyzwanie związane z halucynacjami i zawodnymi wynikami

Jedną z praktycznych przeszkód w rozwoju sztucznej inteligencji jest zjawisko halucynacji — wyniki, które są niedokładne, nielogiczne lub całkowicie sfabrykowane. Chociaż obecne systemy sztucznej inteligencji są podatne na takie błędy, Sutskever argumentował, że zdolności rozumowania mogą znacznie ograniczyć ich występowanie.

„Jest wysoce prawdopodobne, że przyszłe modele będą automatycznie korygować swoje halucynacje poprzez rozumowanie” – powiedział, porównując ten proces do funkcji autokorekty w nowoczesnych edytorach tekstu.

Ta funkcja umożliwiłaby systemy sztucznej inteligencji rozpoznawać niespójności w swoich odpowiedziach i udoskonalać wyniki w czasie rzeczywistym. Na przykład sztuczna inteligencja oparta na rozumowaniu wykorzystywana w badaniach prawnych może identyfikować rozbieżności w cytatach z orzecznictwa lub luki logiczne. w argumentach, dzięki czemu jego wyniki są znacznie bardziej wiarygodne.

Jednak Sutskever przyznał, że istnieją trudności techniczne związane z budowaniem takich systemów. „Nawiasem mówiąc, nie mówię, w jaki sposób i nie mówię, kiedy. Mówię, że tak się stanie” – zauważył, podkreślając niepewność związaną z tym rozwojem.

Regulowanie superinteligentnej sztucznej inteligencji: globalny wysiłek

Refleksje Sutskevera na temat nieprzewidywalnego charakteru superinteligentnej sztucznej inteligencji podkreśliły pilność ram regulacyjnych. Na całym świecie decydenci zastanawiają się, jak zarządzać rozwojem sztucznej inteligencji w sposób zapewniający równowagę między innowacjami a bezpieczeństwem.

Na przykład unijna ustawa o sztucznej inteligencji ma na celu ustanowienie jasnych wytycznych dotyczących korzystania ze sztucznej inteligencji, koncentrując się na zastosowania wysokiego ryzyka, takie jak rozpoznawanie twarzy i autonomiczne podejmowanie decyzji.

W Stanach Zjednoczonych prawodawcy rozważają podobne środki, szczególnie w kluczowych sektorach, takich jak opieka zdrowotna i finanse. „Bez jasnych ram szybkie tempo rozwoju może prowadzić do nieprzewidzianych konsekwencji” – ostrzegł Sutskever, podkreślając znaczenie proaktywnego zarządzania.

Organizacje międzynarodowe, w tym OECD, również wniosły wkład w krajobraz regulacyjny, wydając zasady godnej zaufania sztucznej inteligencji. Inicjatywy te mają na celu zapewnienie uczciwości, rozliczalności i przejrzystości systemów sztucznej inteligencji, odzwierciedlając globalny konsensus w sprawie potrzeby nadzoru.

Jednak, jak zauważył Sutskever Jak się okazuje, wyzwanie polegające na regulowaniu systemów, które są z natury nieprzewidywalne, dodatkowo komplikuje te wysiłki.

„Ludzie mają poczucie, że przyszłością są „agenci”” – powiedział, odnosząc się do rosnącej autonomii zaawansowanej sztucznej inteligencji systemy. Zapewnienie, że agenci sztucznej inteligencji, np. ci z nowej platformy Agentspace firmy Google, będą działać w sposób bezpieczny i zgodny z wartościami społecznymi, będzie wymagać nie tylko innowacji technicznych, ale także solidnych ram prawnych i etycznych.

Przygotowanie ds. społecznego wpływu systemów autonomicznych

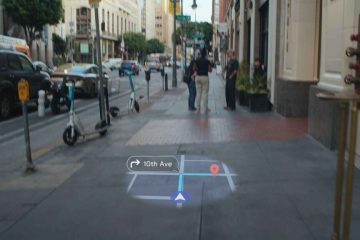

Integracja superinteligentnej sztucznej inteligencji ze społeczeństwem będzie miała dalekosiężne konsekwencje, zmieniając branżę, zarządzanie, a nawet tożsamość ludzką. Autonomiczne systemy zdolne do rozumowania i podejmowania decyzji mogą zrewolucjonizować dziedziny takie jak opieka zdrowotna, transport i nauki o środowisku, zapewniając bezprecedensowe korzyści.

Na przykład diagnostyka medyczna oparta na sztucznej inteligencji mogłaby analizować dane pacjentów z niezrównaną dokładnością, umożliwiając wcześniejsze wykrywanie chorób i poprawę wyników. Podobnie pojazdy autonomiczne wyposażone w funkcje rozumowania mogłyby dostosowywać się do złożonych scenariuszy ruchu drogowego, zwiększając bezpieczeństwo i wydajność.

W naukach o środowisku sztuczna inteligencja mogłaby przetwarzać ogromne zbiory danych, aby modelować zmiany klimatyczne z większą precyzją, dostarczając praktycznych spostrzeżeń globalnym decydentom.

Korzyści społeczne superinteligentnej sztucznej inteligencji wiążą się jednak z ryzykiem. Gdy systemy te zyskają autonomię, będą kwestionować istniejące normy odpowiedzialności i kontroli. Kto ponosi odpowiedzialność, gdy pojazd autonomiczny spowoduje wypadek lub gdy system medyczny oparty na rozumowaniu postawi błędną diagnozę?

Sutskever podkreślił, że rozwiązanie tych kwestii będzie wymagało współpracy międzydyscyplinarnej. „Będziemy musieli radzić sobie z systemami sztucznej inteligencji, które są niezwykle nieprzewidywalne” – przestrzegł, podkreślając znaczenie czujności w miarę ewolucji tych technologii.

Implikacje filozoficzne: inteligencja, autonomia i rola ludzkości

Powstanie superinteligentnej sztucznej inteligencji stawia poważne pytania dotyczące ludzkiej tożsamości i natury inteligencji, ponieważ systemy te przekraczają ludzkie możliwości w zakresie rozumowania, zdolności adaptacyjnych i kreatywności, mogą stanowić wyzwanie od dawna utrzymywane założenia na temat tego, co wyróżnia ludzkość.

Sutskever zasugerował, że samoświadomość, często uważana za cechę charakterystyczną świadomości, może pojawić się naturalnie w zaawansowanych systemach sztucznej inteligencji. „Kiedy rozumowanie, samoświadomość staje się częścią model świata systemu jest przydatny” – stwierdził, sugerując, że takie systemy rozwiną zrozumienie siebie jako jednostek w szerszym środowisku.

Ta zmiana rodzi pytania egzystencjalne. Co dla ludzi oznacza współistnienie z maszynami, które są nie tylko inteligentne, ale także autonomiczne? Ponieważ systemy sztucznej inteligencji przyjmują coraz bardziej złożone role w społeczeństwie, mogą na nowo zdefiniować nasze rozumienie inteligencji i sprawczości.

Historycznie rzecz biorąc, ludzie byli punktem odniesienia dla doskonałości poznawczej, ale pojawienie się maszyn rozumujących może zaowocować szerszą, bardziej inkluzywną definicją inteligencji.

Sutskever przyznał, że te filozoficzne pytania wykraczają poza względy techniczne. „Zdecydowanie nie da się też przewidzieć przyszłości. Naprawdę wszystko jest możliwe” – zauważył, podkreślając niepewność związaną z długoterminowym wpływem sztucznej inteligencji.

Jego komentarze odzwierciedlają rosnącą świadomość, że rozwój superinteligentnej sztucznej inteligencji to nie tylko przedsięwzięcie technologiczne, ale także głębokie wyzwanie kulturowe i filozoficzne.

Ponowne wyobrażenie sobie ról ludzkich w świecie napędzanym sztuczną inteligencją

Integracja superinteligentnej sztucznej inteligencji nieuchronnie ulegnie zmianie struktury społeczne, od edukacji i zatrudnienia po zarządzanie i kreatywność. Ponieważ systemy te przyjmują role tradycyjnie zarezerwowane dla ludzi, zmuszą nas do ponownego rozważenia, co to znaczy wnosić znaczący wkład w społeczeństwo.

Na przykład w obszarze kreatywności. gałęziach przemysłu systemy sztucznej inteligencji już generują sztukę, muzykę i literaturę. Chociaż produkty te często naśladują ludzką kreatywność, superinteligentna sztuczna inteligencja może przesuwać granice tego, co możliwe, tworząc zupełnie nowe formy ekspresji.

Podobnie w edukacja, Nauczyciele wykorzystujący sztuczną inteligencję mogliby personalizować doświadczenia edukacyjne, dostosowując treści do indywidualnych potrzeb w sposób, w jaki nie są w stanie tego zrobić nauczyciele-ludzcy.

Jednak postępy te budzą również obawy dotyczące przesiedleń i nierówności. Jeśli superinteligentna sztuczna inteligencja może przewyższać ludzi w szerokim zakresie zadań, jakie role pozostaną wyłącznie ludzkie?

Sutskever zasugerował, że zdolności adaptacyjne ludzkości zostaną wystawione na próbę w nowej epoce, ale powstrzymał się od oferowania łatwych odpowiedzi. Zamiast tego zachęcał do refleksji i dialogu, stwierdzając: „W miarę ewolucji tych systemów będziemy musieli ponownie przemyśleć wszystko, co wiemy o pracy, kreatywności i inteligencji”.

Szersze implikacje dla etyki i zarządzania

W miarę jak systemy sztucznej inteligencji staną się bardziej autonomiczne, będą one kwestionować istniejące normy odpowiedzialności i zarządzania. Sutskever podkreślił jednak znaczenie stworzenia solidnych ram regulujących rozwój i wdrażanie superinteligentnych systemów. przyznał także, że trudno jest regulować systemy, które są z natury nieprzewidywalne.

„Nieprzewidywalność systemów rozumowania utrudnia tworzenie ostatecznych zasad” – stwierdził, wzywając badaczy i decydentów do współpracy w zakresie elastycznego, adaptacyjnego podejścia.

Jedno z potencjalnych rozwiązań polega na dostosowaniu zachowań sztucznej inteligencji do wartości ludzkich za pomocą struktur motywacyjnych. Starannie projektując cele i parametry systemów autonomicznych, programiści mogą zapewnić, że sztuczna inteligencja będzie działać w sposób korzystny dla społeczeństwa. Jednak Sutskever przyznał, że to zadanie jest obarczone złożonością.

„Nie czuję się pewnie, udzielając ostatecznych odpowiedzi, ponieważ sytuacja jest tak niesamowicie nieprzewidywalna” – powiedział podczas sesji pytań i odpowiedzi, odzwierciedlając wyzwania związane z zrównoważeniem innowacji ze względami etycznymi.

Nowa era ludzkości i sztucznej inteligencji

Pojawienie się superinteligentnej sztucznej inteligencji to nie tylko kamień milowy w technologii; wyznacza początek nowej ery dla ludzkości, gdy maszyny przejmują dotychczasowe role kiedyś uważany za wyjątkowy człowieka, zmuszą nas do skonfrontowania się z naszą własną tożsamością i celem

Prezentacja Sutskevera na konferencji NeurIPS 2024 służyła zarówno jako świętowanie osiągnięć sztucznej inteligencji, jak i wezwanie do działania dla badaczy, decydentów i opinii publicznej do nawiązania kontaktu. stojące przed nami kwestie etyczne i społeczne.

„Dokonujemy całego postępu, który jest zdumiewający” – powiedział, zastanawiając się nad szybkim postępem, jaki nastąpił w ostatniej dekadzie. Jednak jego pożegnalne słowa przypomniały o niepewności towarzyszącej takiej transformacyjnej zmianie: „Wszystkie rzeczy są możliwe”.