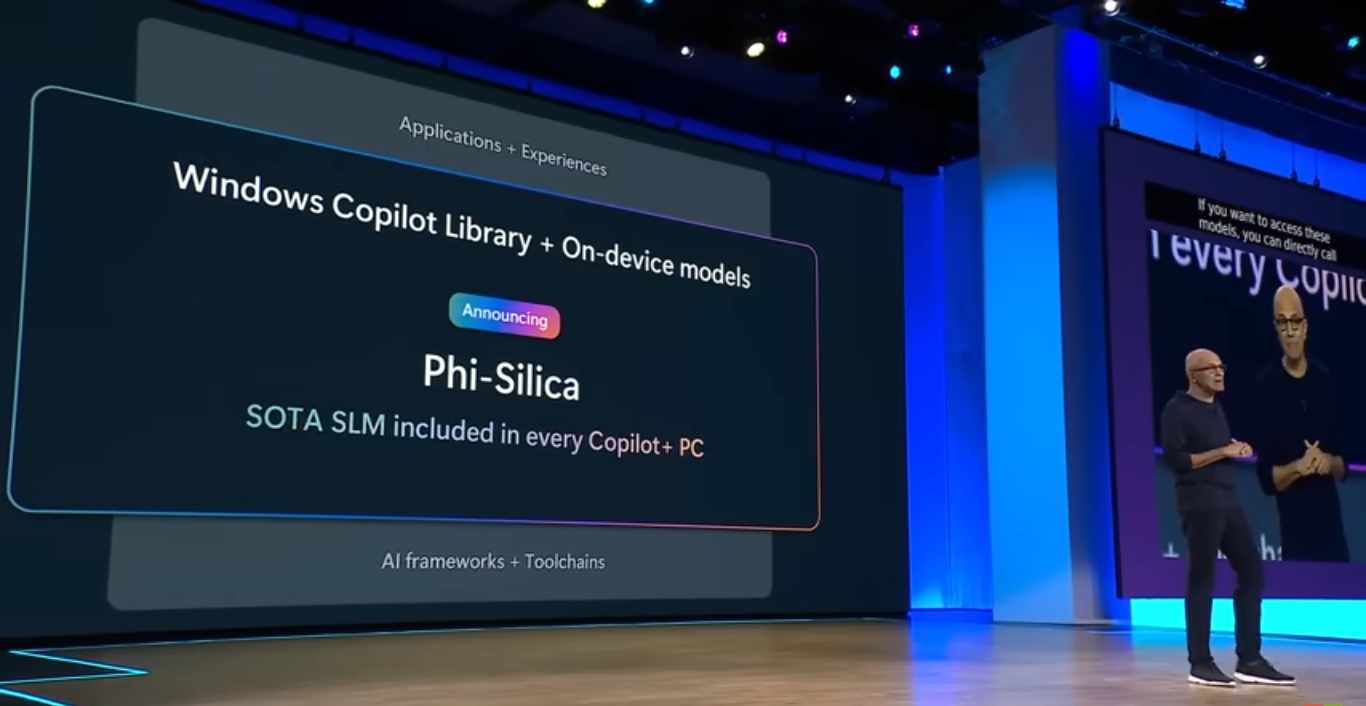

Jak wczoraj informowaliśmy, na konferencji programistów Build 2024 firma Microsoft przedstawiła Phi-3-Vision, nowy dodatek do rodziny małych modeli językowych AI Phi-3. Ten model multimodalny ma na celu ulepszenie pakietu narzędzi AI firmy, zapewniając programistom solidniejsze możliwości. W innym ogłoszeniu dyrektor generalny Microsoft Satya Nadella ujawnił Phi Silica, kolejnego członka małego języka Phi rodzina modeli.

Dzięki 3,3 miliardom parametrów Phi Silica jest najmniejszym modelem w rodzinie, zaprojektowanym z myślą o optymalnej wydajności jednostek przetwarzania neuronowego (NPU) w komputerach Copilot+. Model ten umożliwia lokalne wnioskowanie i poprawia wydajność opóźnienia pierwszego tokena, oferując programistom interfejs API umożliwiający tworzenie doświadczeń użytkownika w całym ekosystemie Windows.

Rozszerzenie biblioteki Windows Copilot

Model Phi Silica jest zintegrowany z nową biblioteką Microsoft Windows Copilot Library, kompleksowym zestawem interfejsów API obsługiwanych przez ponad 40 modeli urządzeń dołączonych do systemu Windows. Biblioteka ma na celu zwiększenie możliwości programistów w zakresie wykorzystania sztucznej inteligencji w środowisku Windows. Dostępne interfejsy API w wydaniu Windows App SDK w czerwcu będą obejmować takie funkcje, jak efekty Studio, tłumaczenia napisów na żywo, Phi Silica, optyczne rozpoznawanie znaków (OCR) i przywoływanie aktywności użytkownika. Dodatkowe interfejsy API, takie jak podsumowywanie tekstu, osadzanie wektorów i generowanie wspomagane pobieraniem (RAG), zostaną udostępnione w przyszłej wersji.

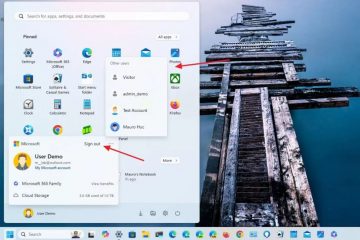

Komputery Copilot+ i plany na przyszłość

Komputery Copilot+, marka komputerów PC z systemem Windows wyposażonych w wyspecjalizowaną sieć neuronową Wysyłka chipów do obsługi aplikacji AI, takich jak Copilot i Phi Silica, rozpocznie się w połowie czerwca. Urządzenia te będą wyposażone w procesory Qualcomm Snapdragon X Elite i Plus oparte na architekturze ARM. Microsoft wraz z kilkoma głównymi producentami komputerów PC planuje wprowadzić te laptopy latem tego roku. Intel przygotowuje się także do wprowadzenia na rynek własnego procesora dla komputerów PC Copilot+ o nazwie kodowej Lunar Lake, którego premiera ma nastąpić w trzecim kwartale 2024 r.

Początkowo firma Microsoft skupiła się na dużych modelach językowych (LLM), które działają w Chmura. Jednak w kwietniu firma wprowadziła Phi-3-mini, mniejszy model przeznaczony do lokalnego działania na komputerach PC. Phi Silica jest pochodną Phi-3-mini, specjalnie dostosowaną do komputerów Copilot+. To przejście w kierunku modeli małych języków (SLM) eliminuje ograniczenia LLM, które wymagają znacznej ilości pamięci i pamięci masowej, co czyni je niepraktycznymi dla typowych komputerów PC. SLM, takie jak Phi Silica, równoważą dokładność i szybkość za pomocą modelu o 3,3 miliardach parametrów.

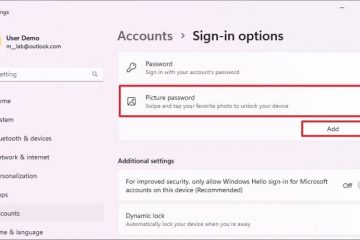

Lokalne przetwarzanie AI zapewniające prywatność

Większość interakcji AI odbywa się w chmurze, z usługi takie jak istniejący Copilot firmy Microsoft komunikujący się ze zdalnymi serwerami. Jednak nadchodząca wyszukiwarka Recall PC będzie działać lokalnie na jednostkach NPU ze względu na ochronę prywatności i unikanie indeksowania wyszukiwań incognito lub anonimowych. Ta zdolność lokalnego przetwarzania jest kluczową cechą nowych modeli sztucznej inteligencji, zapewniającą większą prywatność i wydajność.

Microsoft podkreślił, że Windows jest pierwszą platformą zawierającą model małego języka stworzony specjalnie dla jednostek NPU i dołączony do zestawu-z pudełka. Nie jest jasne, czy Phi Silica będzie preinstalowana na komputerach Copilot+ jako lokalna wersja Copilot, na tę kwestię Microsoft ma czas do 23 czerwca. To osiągnięcie podkreśla zaangażowanie Microsoftu w integrację zaawansowanych możliwości sztucznej inteligencji bezpośrednio ze swoim systemem operacyjnym, oferując użytkownikom lepszą funkcjonalność i wydajność.