Anthropic wypuścił dziś Claude Opus 4.5, zdobywając najwyższy wynik w branży w zakresie kodowania i wprowadzając znaczącą zmianę w architekturze w celu obniżenia kosztów.

Obniżając cenę z 66% do 5 dolarów za milion tokenów wejściowych i wdrażając „Wyszukiwanie narzędzi”, aby zmniejszyć obciążenie kontekstu o 85%, firma bezpośrednio atakuje główną barierę ekonomiczną dla autonomicznych agentów AI.

Model osiąga wynik 80,9% w testach Zweryfikowany test SWE, nieznacznie wyprzedzający najnowsze wydania Google i OpenAI, aby odzyskać koronę wydajności w przypadku złożonych zadań inżynierii oprogramowania.

Wojny wzorców: odzyskanie korony

Opus 4.5 pojawia się z wynikiem 80,9% w SWE-bench Verified, obecnym złotym standardzie oceny możliwości autonomicznej inżynierii oprogramowania. Przewyższając konkurencję, wynik ten przewyższa wprowadzony na rynek przez Google Gemini 3 Pro z wynikiem 76,2% i GPT-5.1-Codex-Max z wynikiem 77,9%.

Wewnętrzne oceny sugerują, że model osiąga obecnie lepsze wyniki niż ludzkie kandydatury we własnych testach inżynieryjnych Anthropic. „Opus 4.5 to krok naprzód w zakresie możliwości systemów sztucznej inteligencji i zapowiedź większych zmian w sposobie wykonywania pracy” – stwierdziła firma w swoim ogłoszeniu.

Aby zrównoważyć koszty w stosunku do możliwości, nowy parametr „wysiłek” umożliwia programistom dynamiczne dostosowywanie głębokości rozumowania modelu podczas wywołań API. Przy „średnim” wysiłku Opus 4.5 dorównuje szczytową wydajnością poprzedniemu modelowi Sonnet 4.5, ale zużywa o 76% mniej tokenów wyjściowych.

Przesuwając sufit automatycznego rozwiązywania problemów, ustawienie „wysokiego” wysiłku przekracza możliwości Sonnet 4.5 o 4,3 punktu procentowego. Listopad okazał się miesiącem aktywnym w zakresie sztucznej inteligencji, ponieważ wszystkie trzy główne laboratoria wdrożyły swoje flagowe modele kodowania między 18 a 24 stycznia.

Zmiana ekonomiczna: ceny i architektura

Odpowiadając na obawy przedsiębiorstw dotyczące wykonalności drogich modeli „rozumowania”, firma Anthropic agresywnie podwyższyła wycenę modelu na 5 dolarów za milion tokenów wejściowych i 25 dolarów za milion wyników tokeny.

W porównaniu z poprzednią generacją Opus (15/75 USD) nowa stawka oferuje 66% zniżki, jak opisano szczegółowo w Przedstawiamy Claude Opus 4.5.

Pod maską architektura radzi sobie z „rozdęciem kontekstu” problemu. Tradycyjnie załadowanie ponad 50 definicji narzędzi mogło zająć około 55 000 tokenów przed przetworzeniem zapytania pojedynczego użytkownika.

Zgodnie z dokumentacją zaawansowanego użycia narzędzi nowy system zasadniczo zmienia tę dynamikę:

„Zamiast ładować wszystkie definicje narzędzi Narzędzie wyszukiwania narzędzi od razu wykrywa narzędzia na żądanie. Claude widzi tylko te narzędzia, których faktycznie potrzebuje do bieżącego zadania.”

„Oznacza to zmniejszenie użycia tokenów o 85% przy jednoczesnym zachowaniu dostępu do pełnej biblioteki narzędzi. Wewnętrzne testy wykazały znaczną poprawę dokładności ocen MCP podczas pracy z dużymi bibliotekami narzędzi.”

Dopełnieniem tego jest „Programowe wywoływanie narzędzi” (PTC), które umożliwia modelowi pisanie kodu orkiestracji zamiast polegania na czacie. wykonywanie zwrotów.

Dokumentacja techniczna szczegółowo wyjaśnia mechanikę PTC:

„Zamiast żądać narzędzi pojedynczo, a każdy wynik jest zwracany do kontekstu, Claude pisze kod, który wywołuje wiele narzędzi, przetwarza ich dane wyjściowe i kontroluje, jakie informacje faktycznie trafiają do okna kontekstowego.”

„Claude przoduje w pisaniu kodu i pozwalaniu mu wyrażać logikę orkiestracji w Pythonie zamiast poprzez wywoływanie narzędzi języka naturalnego, co zapewnia bardziej niezawodną i precyzyjną kontrolę przepływu.”

PTC eliminuje potrzebę wnioskowania w obie strony dla każdego indywidualnego wywołania narzędzia, znacznie zmniejszając opóźnienia. Przetwarzanie obszernych zbiorów danych, takich jak 200 KB surowych danych o wydatkach, staje się opłacalne, ponieważ model zwraca do okna kontekstowego tylko 1 KB wyniku końcowego.

„Aby zbudować skutecznych agentów, muszą pracować z nieograniczoną liczbą bibliotek narzędzi bez wpychania z góry każdej definicji do kontekstu” – zauważył zespół Anthropic Engineering.

Rozbudowa ekosystemu: Chrome, Excel i bezpieczeństwo

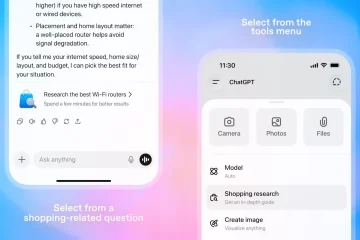

Poza modelem podstawowym, „Claude Code” przeszedł z wersji beta do ogólnej dostępności, oferując pełną aplikację komputerową do pracy programistów. Nowe integracje pozwalają modelowi bezpośrednio kontrolować przeglądarkę Chrome, wykraczając poza generowanie tekstu do aktywnego wyszukiwania i wykonywania zadań.

[treść osadzona]

W przypadku modelowania finansowego, dedykowana integracja z Excelem umożliwia modelowi manipulowanie arkuszami kalkulacyjnymi zawierającymi tysiące wierszy.

Dianne Na Penn, dyrektor ds. zarządzania produktami ds. badań w firmie Anthropic, podkreśliła znaczenie tej możliwości: „Znajomość odpowiednich szczegółów do zapamiętania jest naprawdę ważna w uzupełnieniu posiadania dłuższego okna kontekstowego.”

[osadzone treści]

Bezpieczeństwo pozostaje głównym filarem tej wersji. Karta systemowa Claude Opus 4.5 podkreśla znaczące inwestycje w ograniczanie zagrożeń chemicznych, biologicznych, radiologicznych i nuklearnych (CBRN).

Karta systemowa wyraźnie określa stan dostosowania modelu:

„Opus 4.5 jest najlepiej dostosowany model, jaki do tej pory opublikowaliśmy i, jak podejrzewamy, najlepiej dopasowany model frontierowy ze wszystkich deweloperów.”

„Opus 4.5 jest trudniejszy do oszukania za pomocą szybkiego wstrzyknięcia niż jakikolwiek inny model frontierowy w branży.”

Rzeczywistość rynkowa: era agenta

Jeśli chodzi o kontekst premiery, „Listopadowy szczyt AI” spowodował, że Google, OpenAI i Anthropic zwróciły się jednocześnie w stronę autonomicznych agentów. Narracja przekształciła się z „chatbotów” w „agentów” zdolnych do wykonywania zadań przez ponad 24 godziny.

Chociaż firma Anthropic prowadzi w surowych testach porównawczych (80,9%), przewaga jest niewielka jak brzytwa, a trzech najlepszych konkurentów dzieli mniej niż 5 punktów procentowych. W nowej architekturze istnieje kluczowy kompromis: „Wyszukiwanie narzędzi” wprowadza etap wyszukiwania, który może zwiększyć opóźnienie w porównaniu do wstępnego załadowania wszystkich narzędzi w kontekście.

W przeciwieństwie do natywnej optymalizacji OpenAI pod kątem systemu Windows za pomocą Codex-Max, Anthropic stawia na podejście do komputerów stacjonarnych niezależne od platformy. Zarządzanie pamięcią stało się nowym polem bitwy, przy czym OpenAI wykorzystuje „zagęszczanie”, a Anthropic wdraża „Wyszukiwanie narzędzi”, aby rozwiązać to samo wąskie gardło w oknie kontekstowym.