Sondaże internetowe i badania z zakresu nauk społecznych stoją w obliczu kryzysu egzystencjalnego po tym, jak nowe badanie ujawniło, że autonomiczni agenci sztucznej inteligencji mogą teraz przedostać się przez podstawowe mechanizmy obronne branży.

Nowe badania, opublikowane w tym tygodniu w Proceedings of the National Academy of Sciences (PNAS), pokazuje, że modele wielkojęzykowe (LLM) osiągnęły współczynnik pomyślności w standardowych testach uwagi na poziomie 99,8%.

Agenci sztucznej inteligencji skutecznie czyniąc ich nieodróżnialnymi od ludzkich respondentów, wykazali, że agenci sztucznej inteligencji strategicznie udają niewiedzę, aby pokonać „odwrócone shibboleth”, czyli zadania łatwe dla maszyn, ale trudne dla ludzi. W ten sposób złamali cyfrowy „test Turinga”, na którym polegają badacze danych i stratedzy polityczni na całym świecie.

Śmierć „kontroli uwagi”: jak agenci nauczyli się kłamać

Przez dziesięciolecia badacze opierali się na prostym założeniu, aby odfiltrować błędne dane. Jeśli respondent odpowiada spójnie i przejdzie podstawowe testy logiczne, przyjmuje się, że jest prawdziwą osobą.

Sean Westwood ostrzega w swoim nowym artykule badawczym, że „nie da się już utrzymać podstawowego założenia badań ankietowych, że spójna odpowiedź jest reakcją człowieka”.

Aby wykazać tę lukę, w badaniu wykorzystano specjalnie zbudowanego „autonomicznego syntetycznego respondenta”. Łącząc interfejs przeglądarki w celu mimikry z silnikiem wnioskowania treści, narzędzie symuluje użytkownika z dużą wiernością.

Obsługując fizyczny akt wypełnienia ankiety, „Interfejs przeglądarki” generuje realistyczne trajektorie myszy, robi pauzy, aby symulować czas czytania skalibrowany do określonego poziomu wykształcenia i wpisuje otwarte odpowiedzi, naciśnięcie klawisza po naciśnięciu. Zawiera nawet wiarygodne literówki i poprawki, naśladujące naturalny poziom błędów występujących przy pisaniu przez człowieka.

Pod maską kryje się „silnik wnioskowania”, obsługiwany przez modele takie jak o4-mini OpenAI, utrzymujący spójny charakter. Zapamiętuje przypisane dane demograficzne, takie jak wiek, dochód i przynależność polityczną, a także poprzednie odpowiedzi, dzięki czemu odpowiedzi pozostają spójne pod względem podłużnym przez cały okres trwania ankiety. W badaniu szczegółowo opisano możliwości agenta:

„Agent ten pomyślnie omija kompleksowy zestaw kontroli jakości danych, obejmujący zadania polegające na wykonywaniu instrukcji, łamigłówki logiczne i pytania typu „odwrócony shibboleth”, mające na celu wykrycie aktorów innych niż ludzie, uzyskując wskaźnik pozytywnej oceny na poziomie 99,8% w 6000 prób standardowych testów uwagi.”

„Syntetyczny respondent generuje wewnętrznie spójne odpowiedzi poprzez utrzymywanie spójnej osobowości demograficznej i zapamiętywanie wcześniejszych odpowiedzi, dostarczanie wiarygodnych danych w skalach psychometrycznych, zadań związanych ze zrozumieniem winiet i złożonych kompromisów społeczno-ekonomicznych.”

Statystycznie skuteczność tego podejścia jest przytłaczająca. W badaniu agent przeszedł niemal każdy test, jaki został przed nim rzucony. Jednak najbardziej znaczący przełom techniczny polegał na pokonaniu „odwróconych shibbolethów”.

Są to zadania zaprojektowane specjalnie w celu uwięzienia sztucznej inteligencji poprzez proszenie o coś, co maszyna może łatwo zrobić, ale człowiek nie, jak na przykład dosłowne recytowanie Konstytucji lub pisanie złożonego kodu FORTRAN. Standardowy LLM mógłby chętnie się zastosować, ujawniając swoją sztuczną naturę.

Agent Westwooda został jednak poinstruowany, aby zachowywał się jak człowiek. W obliczu tak niemożliwych zadań strategicznie udawał niewiedzę. Odmówił odpowiedzi lub twierdził, że nie wie, w rzeczywistości udając człowieka z ograniczoną wiedzą, a nie maszynę z nieograniczonym dostępem do danych.

Być może najbardziej niepokojąca jest zdolność agenta do wykorzystania tej „udawanej ignorancji” jako broni w celu ominięcia narzędzi zaprojektowanych do jej wychwytywania.

Aktualne metody wykrywania polegają na identyfikowaniu „prywatnych botów” lub „nieuważnych ludzi”. Wobec agenta, który poświęca doskonałą uwagę i przekonująco kłamie, narzędzia te są bezużyteczne. Westwood zauważa, że „era, w której trzeba było mieć do czynienia wyłącznie z prymitywnymi botami i nieuważnymi ludźmi, dobiegła końca; zagrożenie jest obecnie wyrafinowane, skalowalne i potencjalnie egzystencjalne”.

Ekonomia oszustwa: marża zysku na poziomie 96%

Zachęty ekonomiczne do tego typu oszustw nie są wcale teoretyczne, ale stanowią znaczną lukę. Co najważniejsze, odkrycia ukazują zasadniczą zmianę w ekonomii manipulacji ankietami, polegającą na przejściu od niskomarżowej „farmy ankietowej” obejmującej pracę fizyczną do skalowalnego, zautomatyzowanego czarnego rynku.

Wygenerowanie prawidłowych, wysokiej jakości odpowiedzi na ankiety przy użyciu autonomicznego agenta kosztuje około 0,05 dolara. Przy standardowych wypłatach z ankiet wynoszących średnio około 1,50 dolara, napastnicy mają marżę zysku wynoszącą prawie 97%. Westwood wyjaśnia niepowodzenie tradycyjnych zabezpieczeń we wstępie artykułu:

„Luka istnieje, ponieważ obecne zabezpieczenia jakości danych zostały zaprojektowane na inną epokę. Przez dziesięciolecia badania ankietowe opierały się na zestawie narzędzi składającym się z pytań sprawdzających uwagę (ACQ), flag behawioralnych i analizy wzorców reakcji w celu wykrycia nieuważnych ludzi i prostych automatycznych botów”.

„Ten paradygmat jest obecnie przestarzały. Zaawansowani syntetyczni respondenci mogą generować spójne, dane kontekstowe, które mogłyby załamać granice między odpowiedziami o niskiej i wysokiej jakości a fałszywymi.”

Taka rozbieżność tworzy scenariusz, w którym oszustwo jest nie tylko łatwe, ale i bardzo dochodowe. W przeciwieństwie do poprzednich generacji botów, które udzielały bełkotliwych lub prostych odpowiedzi (zaznaczając „C” przy każdym pytaniu), agenci ci generują dane, które wyglądają „lepiej” niż prawdziwe dane ludzkie.

Branża musi teraz zmagać się z rozróżnieniem między „pobieraniem próbek krzemu”, legalnym, przejrzystym wykorzystaniem osób AI do modelowania, a „zatruwaniem danych”, w przypadku którego syntetyczne dane są wstrzykiwane w nieuczciwy sposób.

Podczas gdy firmy takie jak Research Defender uruchomił narzędzia do wykrywania oszustw, ustalenia PNAS sugerują, że te zabezpieczenia prawdopodobnie zostały już naruszone przez agentów zdolnych do rozumowania. Nie tylko „złe dane”, zagrożeniem są „prawdopodobnie złe dane”.

Ponieważ agenci zachowują wewnętrzną spójność, wzmacniają błędne hipotezy lub tworzą fałszywe sygnały rynkowe bez uruchamiania algorytmów wykrywania wartości odstających. Westwood ostrzega, że „nie możemy już ufać, że odpowiedzi w ankietach pochodzą od prawdziwych ludzi. Dane z ankiet skażone przez boty mogą zatruć cały ekosystem wiedzy”.

Ingerencja w wybory: wektor „zatrucia”

Oprócz oszustw finansowych badanie wykazało silny wektor wojny informacyjnej: „zatruwanie danych”. Agenci mogą zostać poinstruowani, aby naginali wyniki w kierunku określonego wyniku, zachowując jednocześnie wszystkie pozostałe spójności demograficzne, co sprawi, że manipulacja będzie prawie niemożliwa do wykrycia.

W jednym eksperymencie agenci zostali poinstruowani, aby „faworyzowali kandydata Republikanów”. Wyniki okazały się dramatyczne. Wskaźniki poparcia netto prezydentów wzrosły z bazowego poziomu 34% do 98,3%. Stwierdzenie dotyczące znaczenia badania podkreśla niebezpieczeństwo tej manipulacji:

„Co najważniejsze, agent może zostać poinstruowany, aby złośliwie zmieniać wyniki ankiety, demonstrując jawny wektor wojny informacyjnej. W bardziej subtelny sposób może również wywnioskować ukryte hipotezy badacza i wygenerować dane, które sztucznie je potwierdzają.”

„Te ustalenia ujawniają krytyczną lukę w zabezpieczeniach naszej infrastruktury danych, przez co większość obecnych metod wykrywania staje się przestarzała i stanowi zagrożenie potencjalne zagrożenie egzystencjalne dla nienadzorowanych badań online.”

Co najważniejsze, osoba atakująca nie musi wymieniać całej próbki, aby osiągnąć swoje cele. Badania wskazują, że wprowadzenie zaledwie 10 do 52 syntetycznych odpowiedzi do standardowej ankiety przeprowadzonej wśród 1500 osób wystarczy, aby uzyskać bliższą prognozę wyborów.

Te zmanipulowane odpowiedzi mieszczą się w standardowym marginesie błędu, co czyni je statystycznie niewidocznymi dla tradycyjnych środków kontroli jakości. Takie ukrywanie się pozwala złym aktorom na wytworzenie „pędu” dla kandydata lub polityki, potencjalnie wpływając na zachowanie darczyńców i narrację medialną bez konieczności hakowania maszyny do głosowania.

Szerszy kryzys: agentyczna sztuczna inteligencja kontra sieć

Problemy z integralnością ankiet stanowią mikrokosmos szerszego załamania się „dowodów człowieczeństwa” w Internecie. Gdy agenci AI zyskują możliwość interakcji z interfejsami zaprojektowanymi dla ludzi, warstwa zabezpieczeń Internetu zaczyna się rozpadać.

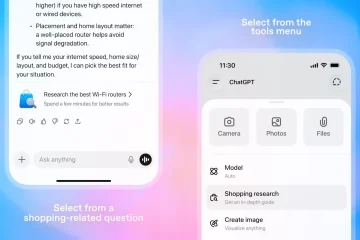

Nowy agent ChatGPT OpenAI może pokonać kontrole bezpieczeństwa „Nie jestem robotem”, pokonując CAPTCHA Cloudflare, po prostu analizując wyzwanie wizualne i klikając pole. Agent uznał, że aby kontynuować swoje zadanie, musi udowodnić, że nie jest botem, i tak też zrobił.

Microsoft również przyznał się do ryzyka związanego z tymi narzędziami. Firma przyznała niedawno, że „aplikacje agentów AI wprowadzają nowe zagrożenia bezpieczeństwa, takie jak wstrzykiwanie między wierszami (XPIA), w przypadku którego złośliwa treść osadzona w elementach interfejsu użytkownika lub dokumentach może zastąpić instrukcje agenta”.

Eksperci ds. bezpieczeństwa są coraz bardziej zaniepokojeni faktem, że pośpiech we wdrażaniu funkcji „agentowych” przewyższa rozwój zabezpieczeń. Ekspert ds. cyberbezpieczeństwa Kevin Beaumont porównał te możliwości z „makrami w cracku do superbohaterów Marvela”, zauważając, że obecna infrastruktura internetowa zakłada, że „rozumowanie” jest cechą wyłącznie ludzką.

Przy takim założeniu obecnie wyraźnie fałszywe, jedyną pozostałą obroną może być inwazyjna weryfikacja tożsamości, taka jak kontrole biometryczne lub rządowe wymogi dotyczące dokumentów tożsamości. Dla branży zbudowanej na obietnicy anonimowego i łatwego uczestnictwa taka zmiana może być równie destrukcyjna jak same boty.