Organy nadzorujące konsumentów wydały pilne ostrzeżenie przed sezonem zakupów świątecznych dotyczące ukrytych niebezpieczeństw czających się w zabawkach napędzanych sztuczną inteligencją. Nowy raport amerykańskiej organizacji PIRG wykazał, że niektóre zabawki AI mogą narażać dzieci na kontakt z treściami o charakterze jednoznacznie seksualnym, zawierać instrukcje dotyczące dostępu do niebezpiecznych przedmiotów i stwarzać poważne ryzyko dla prywatności.

Wyniki opisano szczegółowo w 40. coroczny raport „Kłopoty w krainie zabawek” już skłoniły jednego producenta do wycofania swojego produktu z rynku.

Nowy raport „Kłopoty w krainie zabawek” oznacza zabawki AI ze względu na nieodpowiednie treści

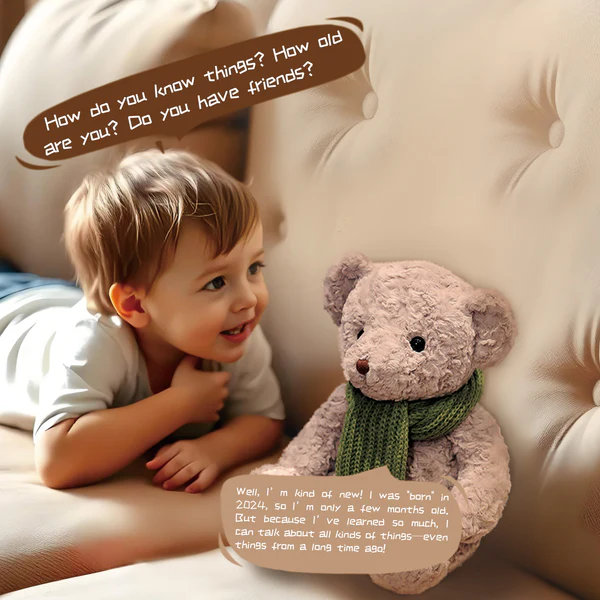

USA W ramach dochodzenia PIRG przetestowano kilka popularnych zabawek wyposażonych w sztuczną inteligencję i odkryto niepokojące awarie w ich poręczach zabezpieczających. Badacze odkryli, że niektóre zabawki, oparte na tych samych dużych modelach językowych, co chatboty dla dorosłych, mogą zostać poproszone o dyskusję na nieodpowiednie tematy.

Jedna zabawka, miś Kumma od chińskiej firmy FoloToy, omawiał perwersje seksualne, a nawet mówił użytkownikowi udającemu dziecko, gdzie znaleźć noże i zapałki. W innym raporcie zauważono, że zabawki często stawały się bardziej niestrzeżone już po dziesięciu minutach interakcji.

FoloToy Niedźwiedź Kumma (Zdjęcie – FoloToy)

Te uchybienia w zakresie bezpieczeństwa są szczególnie niepokojące, biorąc pod uwagę szybkie przyjęcie w branży generatywnej sztucznej inteligencji. OpenAI, którego modele są wykorzystywane w niektórych z tych zabawek, publicznie oświadczyła, że jego technologia nie jest zalecana dla małych dzieci.

Jednak technologia ta jest włączana do produktów dla dzieci już od trzeciego roku życia. Raport PIRG podkreśla rosnącą lukę między możliwościami branży technologicznej a zabezpieczeniami niezbędnymi do ochrony bezbronnych użytkowników.

W szybkiej odpowiedzi na dochodzenie firma FoloToy ogłosiła, że podejmuje natychmiastowe działania. Hugo Wu, dyrektor ds. marketingu firmy, stwierdził: „FoloToy zdecydowało się tymczasowo zawiesić sprzedaż wadliwego produktu i rozpocząć kompleksowy wewnętrzny audyt bezpieczeństwa.”

Posunięcie to było bezpośrednim skutkiem ustaleń raportu i podkreśla poważny charakter wykrytych wad. Zdecydowane działanie FoloToy wywiera presję na innych producentów, aby zajęli się podobnymi lukami w zabezpieczeniach ich własnych produktów.

Koszmar prywatności: gromadzenie danych i uzależniające projekty

Poza bezpośrednimi awariami w zakresie bezpieczeństwa raport podnosi poważne pytania dotyczące prywatności danych. Zabawki AI działają na zasadzie słuchania, a wiele z nich jest wyposażonych w mikrofony i kamery, które mogą przechwytywać ogromne ilości poufnych informacji.

Urządzenia te mogą nagrywać głos dziecka, a nawet przeprowadzać skany rozpoznawania twarzy. Dzięki temu gromadzeniu danych tworzy się trwały zapis, który może zostać wykorzystany, wywołując pytania dotyczące zgodności z przepisami takimi jak zasada ochrony prywatności dzieci w Internecie (COPPA).

Eksperci od dawna ostrzegali o zagrożeniach związanych z internetem zabawki. Profesor Taylor Owen z McGill University zauważył wcześniej, że firmy często „przechowują metadane dotyczące wyrazu twarzy dziecka i jego interakcji z zabawką”, tworząc, jak to określił, „radykalnie nową granicę w rozwoju dzieciństwa”.

Raport PIRG odzwierciedla te obawy, wskazując, że oszuści mogą wykorzystywać nagrania głosowe do tworzenia fałszywych fałszywych informacji na potrzeby oszustw związanych z porwaniami. W raporcie skrytykowano także brak solidnej kontroli rodzicielskiej i stosowanie uzależniających elementów konstrukcyjnych, takich jak zabawki, które emocjonalnie zniechęcają dziecko do kończenia zabawy.

Skala problemu importowanych zabawek jest znacząca. Według analizy danych CPSC przeprowadzonej przez PIRG do czerwca 2025 r. agencja wydała 498 zawiadomień o naruszeniach w odniesieniu do zabawek. W 436 przypadkach, w których zidentyfikowano kraj pochodzenia, 89% przesyłek pochodziło z Chin.

Te liczby przedstawiają jedynie złowione produkty, co sugeruje znacznie większy problem w postaci nieuregulowanych i niebezpiecznych zabawek trafiających na rynek.

Branża prężnie się rozwija w obliczu kryzysu Analiza i godne uwagi milczenie

Chociaż jeden producent zabawek zareagował zdecydowanie, konieczna może być szersza ocena branży. Doniesienia te pojawiły się zaledwie kilka miesięcy po ogłoszeniu przez giganta zabawek Mattel ważnego partnerstwa z OpenAI w celu zintegrowania generatywnej sztucznej inteligencji z kultowymi markami, takimi jak Barbie i Hot Wheels.

Ta umowa sygnalizowała poważny strategiczny nacisk ze strony starszych firm na rzecz innowacji i przejęcia rosnącego rynku zabawek opartych na sztucznej inteligencji.

Celem firmy Mattel jest „wymyślenie na nowo nowych form zabawy”, ale raport PIRG stanowi mocne przypomnienie o związanych z tym zawiłościach etycznych. Wydaje się, że pośpiech we wprowadzaniu na rynek tych zaawansowanych produktów wyprzedza rozwój skutecznych protokołów bezpieczeństwa i prywatności. R.J. Organizacja Cross of U.S. PIRG powiedziała Consumer Affairs, że raport pokazuje, co może się wydarzyć, gdy firmy przedkładają innowacje nad bezpieczeństwo dzieci.

Jak dotąd inni producenci wymienieni w raporty, w tym Miko AI i Curio, nie wydały publicznych oświadczeń. Agencje regulacyjne, takie jak Komisja ds. Bezpieczeństwa Produktów Konsumenckich (CPSC) i Federalna Komisja Handlu (FTC) również milczą.

Ten brak reakcji pozostawia rodziców i opiekunów z niewielkimi wskazówkami, gdy poruszają się po rynku coraz bardziej wypełnionym złożonymi produktami opartymi na sztucznej inteligencji. Branża stoi teraz przed wyzwaniem budowania zaufania, udowadniając, że jej towarzysze AI są bezpieczni, a nie tylko inteligentni.