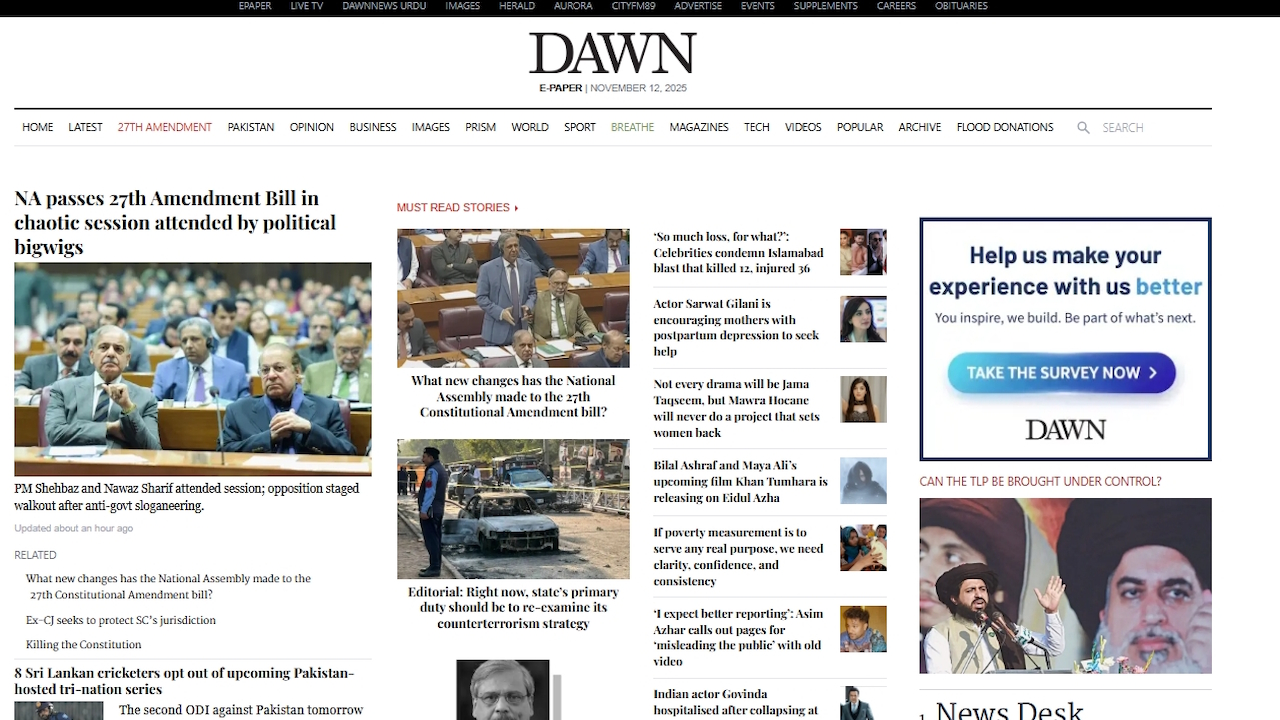

Pakistańska gazeta zwróciła uwagę na rosnący problem niezweryfikowanych wyników sztucznej inteligencji po tym, jak omyłkowo wydrukowała tekst rozmów z chatbota. W swoim wydaniu z 12 listopada firma Dawn zamieściła wiadomość wygenerowaną przez sztuczną inteligencję, aby wyraźnie wygenerowany artykuł był „szybszy”, wymuszając publiczne przeprosiny za złamanie własnych zasad.

Taki błąd nie jest odosobnionym przypadkiem, ale częścią szerszego trendu niepowodzeń sztucznej inteligencji. Od fałszywych źródeł prawnych wykorzystywanych w sądzie po błędne raporty rządowe – pośpiech we wprowadzaniu generatywnej sztucznej inteligencji bez dokładnej kontroli człowieka podważa zaufanie publiczne. Jest to tendencja powodująca poważne problemy w świecie rzeczywistym dla głównych instytucji.

„Czy chcesz, żebym to zrobił dalej?”: publiczna wpadka AI w gazecie

Bardzo szanowana anglojęzyczna gazeta pakistańska Dawn opublikowała artykuł na temat sprzedaży samochodów zakończony dziwacznym, wygenerowanym maszynowo postscriptum. Zamiast końcowego akapitu artykuł zawierał klasyczny fragment bzdur z chatbotem.

Sztuczna inteligencja zapytała użytkownika: „Jeśli chcesz, mogę także stworzyć jeszcze szybszą wersję w stylu pierwszej strony z wyrazistymi statystykami w jednym wierszu i pogrubioną czcionką, Układ gotowy do infografiki — idealny, aby zapewnić maksymalny wpływ na czytelnika. Czy chcesz, żebym to zrobił jako następny?“

Wiem, że dziennikarze wykorzystują sztuczną inteligencję w swojej pracy, ale to trochę za dużo!

Biuro stron biznesowych Dawn powinno przynajmniej poprawić ostatni akapit!

😆😆😆 pic.twitter.com/JWNdHNWvnv

— omar r quraishi (@omar_quraishi) 12 listopada 2025 r.

Gafa szybko zauważona przez czytelników szybko rozprzestrzeniła się w Internecie, co zmusiło gazetę do sprostowania i formalnych przeprosin. W notatce dołączonej do internetowej wersji artykułu redaktor przyznał: „Ten raport prasowy został pierwotnie zredagowany przy użyciu sztucznej inteligencji, co stanowi naruszenie obecnych zasad firmy Dawn dotyczących sztucznej inteligencji. […] Wyrażamy ubolewanie z powodu naruszenia zasad dotyczących sztucznej inteligencji”.

Według doniesień trwa dochodzenie w sprawie incydentu. Oficjalne wytyczne gazety wyraźnie zabraniają używania sztucznej inteligencji do generowania lub edytowania wiadomości bez rygorystycznego nadzoru człowieka.

Chociaż gafa Dawn zapewniła moment publicznego zawstydzenia, służy jako mocny symbol znacznie głębszego i bardziej znaczącego problemu. W różnych branżach przedwczesne wdrożenie generatywnej sztucznej inteligencji bez odpowiedniego nadzoru prowadzi do szeregu głośnych niepowodzeń, podważających standardy zawodowe i zaufanie publiczne.

Problem systemowy: halucynacje AI w kluczowych obszarach

W wielu dziedzinach zawodowych, od prawa po zdrowie publiczne, organizacje na własnej skórze odkrywają, że dużym modelom językowym nie można ufać w przypadku kluczowych zadań. Znane jako halucynacja, zjawisko polegające na tym, że sztuczna inteligencja z pewnością wymyśla fakty, źródła lub dane, okazuje się trwałą i niebezpieczną wadą.

Niedawny i kosztowny przykład pochodzi ze świata konsultingu. Globalna firma Deloitte została zmuszona do zwrotu 97 000 dolarów australijskiemu rządowi po tym, jak odkryto, że sporządzony przez nią raport o wartości 440 000 dolarów był pełen cytatów sfabrykowanych przez sztuczną inteligencję.

W jej raporcie, będącym wrażliwym przeglądem krajowego systemu opieki społecznej, zawarto cytaty z nieistniejących książek i błędnie cytowane orzeczenia prawne. Australijska senator ds. pracy Deborah O’Neill ostro napomniała, stwierdzając: „Deloitte ma problem z ludzką inteligencją. Byłoby to śmieszne, gdyby nie było tak godne pożałowania”.

Poważne problemy pojawiają się także w sektorze publicznym. W lipcu pojawiły się doniesienia, że nowa sztuczna inteligencja „Elsa” amerykańskiej Agencji ds. Żywności i Leków, mająca na celu przyspieszenie zatwierdzania leków, zamiast tego fabrykowała nieistniejące badania medyczne.

Jeden sfrustrowany pracownik FDA określił to narzędzie CNN jako niewiarygodne, stwierdzając, że „wywołuje halucynacje z pewnością”, podczas gdy inny ubolewał: „Marnuję dużo dodatkowego czasu tylko z powodu zwiększonej czujności, którą muszę zachować”.

Podobnie prawnicy firmy Anthropic zajmującej się sztuczną inteligencją musieli formalnie przeprosić sędziego po tym, jak ich własny Claude AI wymyślił cytat prawniczy użyty w pozwie sądowym.

Zwłaszcza w dziennikarstwie powtarzające się przypadki tego przeoczenia. W uderzająco podobnej sprawie z października niemiecki magazyn Der Spiegel musiał poprawić artykuł zawierający zdanie wygenerowane przez sztuczną inteligencję, oferując zmianę tonu tekstu.

Te błędy nie są ograniczają się do farm treści niższego szczebla, ale pojawiają się w szanowanych, uznanych mediach, podkreślając systemowe załamanie w przepływach pracy redakcyjnej.

To nie są odosobnione przypadki. Przełomowe międzynarodowe badanie koordynowane przez BBC i Europejską Unię Nadawców (EBU) ujawniło systemowy charakter tej niewiarygodności.

Po ocenie ponad 3000 odpowiedzi jego ustalenia wykazały, że asystenci AI popełniają istotne błędy w 45% odpowiedzi związanych z wiadomościami. Jak wyjaśnił dyrektor ds. mediów EBU, Jean Philip De Tender: „Badanie niezbicie pokazuje, że te uchybienia nie są odosobnionymi incydentami. Mają one charakter systemowy, transgraniczny i wielojęzyczny, co naszym zdaniem zagraża zaufaniu publicznemu”.

Erupcja zaufania: rzeczywisty koszt niekontrolowanego spadku poziomu AI

Stały spadek dezinformacji generowanej przez sztuczną inteligencję powoduje wymierne szkody w cyfrowym ekosystemie informacyjnym. W przypadku podstawowych platform, takich jak Wikipedia, konsekwencje stają się egzystencjalne.

Fundacja Wikimedia odnotowała niedawno zaskakujący 8% spadek ruchu ludzkiego, bezpośrednio obwiniając narzędzia wyszukiwania AI i chatboty za odprowadzanie odwiedzających poprzez streszczanie ich treści bez podawania źródła.

Ten trend zagraża modelowi encyklopedii opartemu na wolontariuszach. Jak ostrzegł starszy dyrektor ds. produktu Wikimedia, Marshall Miller: „Przy mniejszej liczbie wizyt w Wikipedii mniej wolontariuszy będzie mogło rozwijać i wzbogacać treść, a mniej indywidualnych darczyńców będzie mogło wesprzeć tę pracę”.

Wewnętrznie platforma toczy już bitwę z zgłoszeniami generowanymi przez sztuczną inteligencję, które jeden z wolontariuszy określił jako „istotne zagrożenie”, co skłoniło społeczność do przyjęcia polityki „szybkiego usuwania” w celu usunięcia najgorszych błędów.

Te powtarzające się niepowodzenia ostatecznie dają krytyczną lekcję na temat obecnego stanu sztucznej inteligencji. Nie można zrzucić odpowiedzialności za błędy na maszynę.

Jak zauważyła była główna specjalistka ds. podejmowania decyzji w Google, Cassie Kozyrkov, po tym, jak bot wspierający edytor kodu Cursor AI wymyślił fałszywą politykę firmy: „Tego bałaganu można było uniknąć, gdyby liderzy zrozumieli, że (1) sztuczna inteligencja popełnia błędy, (2) sztuczna inteligencja nie może wziąć odpowiedzialności za te błędy (więc spada to na ciebie) oraz (3) użytkownicy nie lubią, gdy daje się oszukać maszynie udającej człowieka”.

To, co wydarzyło się w Dawn, to po prostu najnowsze przypomnienie, że w dobie sztucznej inteligencji ostatnią, niezbędną warstwą kontroli jakości pozostaje sumienny nadzór człowieka.