IBM zaprezentował dziś swoje procesory kwantowe nowej generacji, przyspieszając harmonogram budowy użytecznego komputera kwantowego.

We wtorek podczas corocznej imprezy dla programistów firma zaprezentowała 120-kubitowy procesor Nighthawk, zbudowany z myślą o rozwiązywaniu bardziej złożonych problemów. Ujawniono także eksperymentalny chip Loon, kluczowy krok w kierunku systemów odpornych na błędy.

Ulepszenia sprzętu oraz nowe postępy w korekcji błędów pozwolą IBM na osiągnięcie „przewagi kwantowej” do 2026 r. i stworzenia maszyny odpornej na awarie do 2029 r. Wiadomość ta podgrzewa wyścig kwantowy po niedawnym poważnym przełomie dokonanym przez konkurencyjnego Google.

Nighthawk i Loon: dwutorowy postęp w projektowaniu procesorów

Dzięki najnowszemu sprzętowi IBM zakłada, że skomplikowana łączność i solidna korekcja błędów prześcigną surową liczbę kubitów u konkurentów. IBM zaprezentował dwa różne procesory, z których każdy rozwiązuje inną część wyzwania kwantowego.

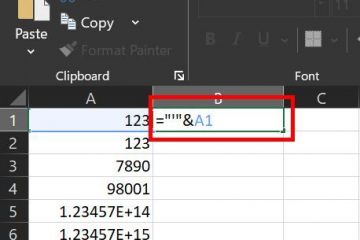

Po pierwsze, IBM Quantum Nighthawk ma zapewnić przewagę kwantową w ciągu najbliższych dwóch lat. Oczekuje się, że będzie on zawierał 120 kubitów połączonych 218 przestrajalnymi sprzęgaczami nowej generacji.

Procesor IBM Nighthawk Quantum (źródło: IBM)

Według IBM ta architektura umożliwi użytkownikom uruchamianie obwodów o 30% większej złożoności niż obecny procesor Heron, przy jednoczesnym zachowaniu niskiego poziomu błędów.

IBM przedstawił także ambitny plan działania w zakresie wydajności dla systemów opartych na Nighthawk, którego celem jest zdolność do obsługi aż do 7500 bramek dwukubitowych do 2026 r. i 15 000 do 2028 r.

Podczas gdy Nighthawk przesuwa granice użyteczności w krótkim czasie, eksperymentalny procesor Loon kładzie podwaliny pod przyszłość komputerów odpornych na awarie.

Loon wprowadza nowatorską architekturę, w której każdy kubit łączy się z sześcioma innymi, w tym pionowo, co jest niespotykaną dotąd możliwością wykazał nadprzewodzący komputer kwantowy. Tak gęsta, trójwymiarowa łączność ma kluczowe znaczenie dla wdrożenia wydajnych kodów korekcji błędów potrzebnych w naprawdę skalowalnych maszynach.

IBM Procesor Loon Quantum (źródło: IBM)

Przez lata niektórzy badacze kwestionowali wykonalność tak skomplikowanych połączeń. Jay Gambetta z IBM zauważył sceptycyzm, stwierdzając New Scientist, że to tak, jakby ludzie mówili: „Jesteś w krainie teorii i nie możesz zdawać sobie z tego sprawy”. I [teraz] jesteśmy wykażę, że [jest to] błędne.”

Przyspieszenie realizacji planu działania: korekcja błędów i produkcja na skalę przemysłową

Pod zapowiedziami procesorów kryje się kluczowy kamień milowy w produkcji. IBM przeniósł swoją główną produkcję płytek kwantowych do zaawansowanego zakładu produkcyjnego o średnicy 300 mm w Albany NanoTech Complex.

Przejście na narzędzia zgodne ze standardami branżowymi już dwukrotnie przyspieszyło cykle badawczo-rozwojowe. Umożliwia tworzenie bardziej złożonych projektów układów scalonych i sygnalizuje przejście od specjalistycznej pracy laboratoryjnej do produkcji na skalę przemysłową, co jest kluczowym krokiem w budowaniu większych systemów.

Dopasowanie tego tempa przemysłowego to znaczący przełom w oprogramowaniu i korekcji błędów. IBM ogłosił, że pomyślnie zademonstrował dekodowanie błędów kwantowych w czasie rzeczywistym przy użyciu zaawansowanych kodów qLDPC na klasycznym sprzęcie, co stanowi kluczowy krok w kierunku odporności na awarie, który udało się osiągnąć cały rok przed planowanym terminem.

Aby udostępnić te korzyści sprzętowe, IBM udoskonala swój stos oprogramowania Qiskit. Nowy interfejs C++ pomoże wypełnić lukę między środowiskami kwantowymi a środowiskami obliczeń o wysokiej wydajności (HPC).

Co więcej, nowe techniki eliminowania błędów oparte na HPC mogą obniżyć koszt wydobywania dokładnych wyników ponad 100-krotnie. W wizji firmy najważniejsze jest skupienie się na kompletnym zestawie sprzętu i oprogramowania.

Jak stwierdził Jay Gambetta, dyrektor ds. badań IBM i członek IBM: „Wierzymy, że IBM jest jedyną firmą, która jest w stanie szybko opracowywać i skalować kwantowe oprogramowanie, sprzęt, produkcję i korekcję błędów w celu odblokowania aplikacji przekształcających”.

Wyścig kwantowy nabiera tempa: strategia IBM w zatłoczonym polu

W branży pełnej konkurencyjnych architektur modułowe podejście IBM ma na celu przede wszystkim zbudowanie niezawodnego fundamentu. Ogłoszenia IBM trafiają w środowisko niezwykle konkurencyjne.

Niedawno w zeszłym miesiącu Google ogłosił, że osiągnął „możliwą do zweryfikowania przewagę kwantową”, podczas gdy konkurent Quantinuum niedawno zaprezentował swój 98-kubitowy System Helios, który nazywa najdokładniejszym komercyjnym komputerem kwantowym na świecie.

Strategia IBM ostro kontrastuje z tymi rywalami oraz innymi firmami, takimi jak Microsoft i Amazon, którzy opracowują zupełnie różne technologie kubitowe.

Big Blue koncentruje się na doskonaleniu swoich nadprzewodzących kubitów poprzez projektowanie lepszej łączności i opracowywanie solidnych struktur korekcji błędów, które mogą działać w hybrydowych systemach klasyczno-kwantowych.

Zmagając się z podstawowymi zagadnieniami wyzwanie, jakim jest niestabilność kubitów, jest przedsięwzięciem obejmującym całą branżę. Niedawny przełom dokonany na Uniwersytecie Princeton, niezwiązany z pracą IBM, ilustruje wagę tego problemu.

Naukowcy tam opracowali nowy projekt kubitu, który pozostaje stabilny 15 razy dłużej niż obecne standardy branżowe.

Andrew Houck z Princeton skomentował ogólny postęp, mówiąc: „Ten postęp przenosi obliczenia kwantowe ze sfery jedynie możliwej do sfery praktycznej. Teraz możemy zacząć osiągać postęp znacznie szybciej”.

Ostatecznie, Ostatni sukces IBM zmienia kluczową część konkursu kwantowego. Nacisk zostaje przesunięty z surowego liczenia kubitów na inżynierię weryfikowalnych, powtarzalnych i praktycznych systemów. Stephen Bartlett z Uniwersytetu w Sydney przedstawił wyważone spojrzenie na nowe procesory, stwierdzając: „To nie jest złoty środek, który rozwiąże wszystkie problemy… tego.”

Pokazując, że można budować i skalować podstawowe komponenty przyszłości odpornej na awarie, IBM znacznie przybliżył tę przyszłość.