Badacze firmy Microsoft szczegółowo opisali nowy atak typu side-channel o nazwie „Whisper Leak”, który może odgadnąć temat zaszyfrowanych czatów AI, odsłaniając podstawowe ryzyko prywatności w branży sztucznej inteligencji.

W raporcie zespół pokazał, jak wzorce wielkości i czasu ruchu sieciowego mogą ujawnić, o czym dyskutują użytkownicy, nawet przy szyfrowaniu TLS. Luka dotyczy 28 głównych modeli sztucznej inteligencji, stwarzając poważne zagrożenie dla prywatności użytkowników na całym świecie. Obserwator w sieci może wykryć drażliwe rozmowy na tematy prawne lub zdrowotne.

Po procesie ujawniania informacji, który rozpoczął się w czerwcu, główni dostawcy, tacy jak OpenAI i Microsoft, zaczęli wdrażać poprawki, ale problem wskazuje na podstawowe ryzyko związane ze strumieniową sztuczną inteligencją.

Jak Whisper Leak podsłuchuje zaszyfrowane czaty AI

Genialność ataku polega na jego zdolności do działania bez łamania podstawowego szyfrowania TLS, które chroni komunikację online. Zamiast tego wykorzystuje metadane, które szyfrowanie zwykle naraża na ryzyko.

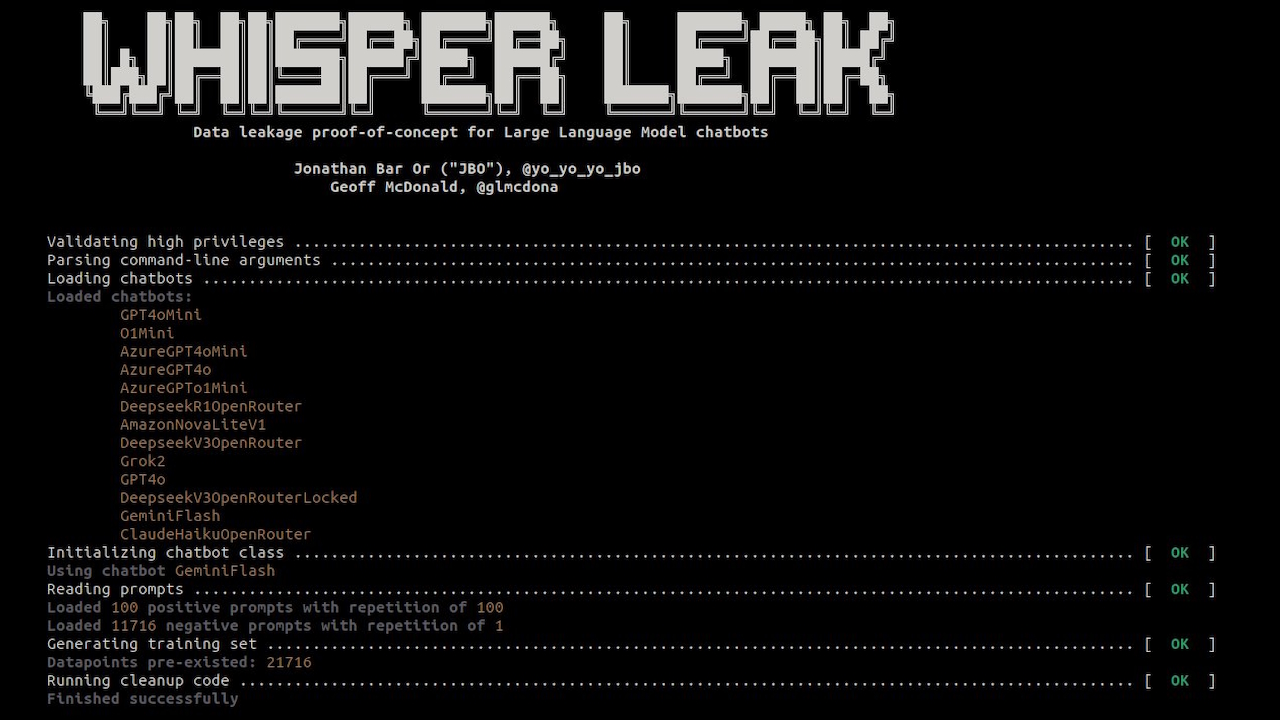

Zgodnie z dokumentacją projektu „Whisper Leak to zestaw narzędzi badawczych, który demonstruje, w jaki sposób zaszyfrowane konwersacje przesyłane strumieniowo z modelami wielkojęzykowymi powodują wyciek szybkich informacji poprzez rozmiary pakietów i czas.”

Metoda ta omija bezpieczeństwo treści, skupiając się na kształcie i rytmie przepływu danych.

Odpowiedzi LLM, generowane token po tokenie, tworzą unikalne sekwencje pakiety danych przesyłane strumieniowo do użytkownika. Każdy temat, od analizy prawnej po swobodną rozmowę, generuje tekst z odrębnym słownictwem i strukturami zdań. Te wzorce językowe tworzą charakterystyczny „cyfrowy odcisk palca” w ruchu sieciowym.

Analizując sekwencje rozmiarów pakietów i czasów między przybyciem, badacze zbudowali klasyfikatory umożliwiające rozpoznawanie tych odcisków palców z dużą dokładnością.

Publiczność projektu Toolkit potwierdza tę metodę, która wykorzystuje modele uczenia maszynowego do uczenia się subtelnych sygnatur różnych typów konwersacji. Nawet w przypadku zaszyfrowanej treści wzorce ruchu zdradzają temat rozmowy.

Błąda występująca w całej branży, wpływająca na 28 głównych modeli sztucznej inteligencji

Wyciek Whisper nie jest odosobnionym błędem, ale luką systemową wpływającą na szeroką gamę branży sztucznej inteligencji. Zespół Microsoftu przetestował 28 dostępnych na rynku LLM i stwierdził, że większość z nich była wysoce podatna.

W przypadku wielu modeli atak został sklasyfikowany niemal idealnie. Badacze zauważyli w poście na blogu: „To mówi nam, że unikalne cyfrowe „odciski palców” pozostawione przez rozmowy na określony temat są na tyle wyraźne, że nasz podsłuchiwacz wykorzystujący sztuczną inteligencję może je niezawodnie wykryć w kontrolowanym teście”.

Dla przedsiębiorstw polegających na sztucznej inteligencji w zakresie poufnej komunikacji odkrycia stanowią nowy i trudny wektor zagrożeń. Badanie wykazało alarmującą precyzję w realistycznych warunkach.

W symulacji ze stosunkiem szumu tła do rozmów docelowych wynoszącym 10 000 do 1 atak zidentyfikował drażliwe tematy ze 100% precyzją w 17 z 28 modeli, jednocześnie wykrywając 5–20% wszystkich docelowych rozmów.

Pasywny przeciwnik sieciowy, taki jak dostawca usług internetowych, agencja rządowa lub osoba atakująca publiczną sieć Wi-Fi, mogłaby niezawodnie identyfikuj użytkowników omawiających poufne kwestie prawne, finansowe lub zdrowotne.

Ta funkcja zamienia zaszyfrowane czaty AI w potencjalne źródło ukierunkowanego nadzoru. Jak stwierdzają badacze: „Ta luka występująca w całej branży stwarza poważne ryzyko dla użytkowników znajdujących się pod nadzorem sieci przez dostawców usług internetowych, rządy lub lokalnych przeciwników.”

Wydajność ataku (AUPRC) w docelowych LLM hostowanych przez określonych dostawców oraz zestawy funkcji i architektura modelu ataku. Wyższe liczby odpowiadają wyższej skuteczności ataku z kanału bocznego. Metryki oblicza się jako medianę z 5 prób, przy czym dla każdej próby przeprowadza się losowy podział. Kolumna „Najlepsza” to także mediana pięciu najlepszych prób z zastosowanych modeli i zestawów funkcji. (Źródło: Microsoft)

Trudne rozwiązanie: środki łagodzące i niespójne reakcje dostawców

Microsoft rozpoczął proces odpowiedzialnego ujawniania informacji w czerwcu 2025 r., powiadamiając wszystkich 28 dostawców, których to dotyczy. Według stanu na listopad reakcje były zróżnicowane.

Chociaż dostawcy tacy jak OpenAI, Microsoft, Mistral i xAI zaczęli łatać tę lukę, w raporcie zauważono, że inni dostawcy odmówili wdrożenia poprawek lub w dalszym ciągu nie reagowali.

Ten incydent uwydatnia niepokojącą niespójność w sposobie, w jaki branża radzi sobie z nowatorskimi zagrożeniami natywnymi dla sztucznej inteligencji. Jest to następstwem październikowej odmowy Google naprawienia krytycznej wady związanej z przemytem ASCII w swoich modelach Gemini, którą sklasyfikowano jako problem socjotechniczny, a nie błąd bezpieczeństwa.

Nawiązuje to również do niedawnej luki w zabezpieczeniach związanej z wyciekiem danych w firmie Anthropic Claude, gdzie firma początkowo odrzuciła zgłoszenie, zanim przyznała się do „czkawki w procesie”.

Jak zauważył w tym przypadku badacz bezpieczeństwa Johann Rehberger, „bezpieczeństwo chroni cię”. przed wypadkami Bezpieczeństwo chroni Cię przed przeciwnikami.” To rozróżnienie ma kluczowe znaczenie, ponieważ agenci sztucznej inteligencji stają się bardziej autonomiczni i zintegrowani z wrażliwymi danymi.

Naprawianie wycieków metadanych nie jest proste. Naukowcy ocenili kilka rozwiązań łagodzących, a każde z nich wiązało się ze znaczącymi kompromisami. Losowe dopełnianie danych, obecnie wdrażane przez niektórych dostawców, zwiększa szum w rozmiarach pakietów, ale tylko częściowo zmniejsza skuteczność ataku.

Inna strategia, grupowanie tokenów, grupuje wiele tokenów przed ich wysłaniem, zasłaniając indywidualne wzorce. Chociaż jest to skuteczne w przypadku większych partii, może pogorszyć działanie chatbota działającego w czasie rzeczywistym, wpływając na wygodę użytkownika.

Trzecia opcja, wstrzykiwanie syntetycznych pakietów „szumu”, może również zaciemniać wzorce ruchu. Takie podejście zwiększa jednak narzut przepustowości, co stanowi znaczny koszt dla dostawców.

Odcinek pokazuje, że w miarę coraz większej integracji sztucznej inteligencji z wrażliwymi przepływami pracy ochrona prywatności użytkowników wymaga wyjścia poza szyfrowanie treści i zabezpieczenia samych wzorców komunikacji cyfrowej