Dyrektor generalny OpenAI Sam Altman broni nowej, polaryzującej polityki swojej firmy, która zezwala na udostępnianie treści erotycznych dostosowanych do wieku na ChatGPT. W tym tygodniu w postach na X Altman przeciwstawił się fali krytyki, stwierdzając, że OpenAI „nie jest wybraną policją moralną świata”.

Określił tę decyzję jako ruch mający na celu „traktowanie dorosłych użytkowników jak dorosłych” i wycofywanie bardziej rygorystycznych zasad wprowadzonych po procesie sądowym dotyczącym bezpieczeństwa użytkowników. Zmiana polityki spotkała się z ostrą krytyką ze strony zwolenników bezpieczeństwa i osobistości takich jak Mark Cuban, którzy kwestionują, czy bramkowanie wiekowe naprawdę może działać.

To posunięcie sygnalizuje znaczącą zmianę filozoficzną w OpenAI, stawiając na pierwszym miejscu swobodę użytkowników dla dorosłych nad utrzymaniem jednakowo oczyszczonej platformy.

Altman argumentował, że w miarę jak sztuczna inteligencja staje się coraz bardziej integralną częścią codziennego życia, kluczowa jest elastyczność. W poście na portalu X wyjaśnił: „w miarę jak sztuczna inteligencja staje się coraz ważniejsza w życiu ludzi, ważną częścią naszej misji jest zapewnienie ludziom dużej swobody korzystania ze sztucznej inteligencji w sposób, jaki chcą”, przy jednoczesnym zapewnieniu, że ochrona nieletnich i osób znajdujących się w kryzysie pozostanie solidna.

„Nie policja moralna”: Altman broni polityki dotyczącej treści erotycznych w obliczu ostrej reakcji

Nowe stanowisko spotkało się z natychmiastowym i zdecydowanym sprzeciwem. Biznesmen Mark Cuban wyraził obawy dotyczące realizacji i społecznego wpływu tej polityki. „Nie rozumiem, w jaki sposób OpenAI może skutecznie starzeć bramę” – napisał na X, dodając, że „po prostu jeszcze nie wiemy, jak uzależniające mogą być LLM”.

Po pierwsze. Nie mówię, że powinniśmy tego zakazać. Powiedziałem, że to błąd. To zaszkodzi biznesowi OpenAI

2.: Powtórzę to jeszcze raz. Tu nie chodzi o porno. Chodzi o to, aby dzieci rozwijały „relacje” z LLM, które mogą poprowadzić je w wielu bardzo osobistych kierunkach.… https://t.co/zoo7XCzYbK

— Mark Cuban (@ban) 15 października 2025 r.

Ten zwrot jest szczególnie zauważalny, biorąc pod uwagę wcześniejsze publiczne stanowisko Altmana. W sierpniowym podkaście wyraził dumę, że oparł się pokusom, takim jak dodanie „awatara bota seksualnego” do ChatGPT, traktując go jako skupienie się na celach długoterminowych, a nie na krótkoterminowych wskaźnikach wzrostu.

To najnowsze posunięcie sugeruje znaczącą ewolucję w jego podejściu do tej kwestii.

Ta reakcja uwydatnia główne napięcie w rozwoju sztucznej inteligencji: równoważenie innowacji z możliwością nadużyć. Obrona OpenAI opiera się na założeniu, że nie powinno ono narzucać jednolitych ram moralnych swojej globalnej bazie użytkowników.

Altman zapewnił: „nie jesteśmy wybraną policją moralną świata”, pozycjonując firmę jako neutralnego dostawcę technologii, a nie arbitra treści.

Ok, ten tweet o nadchodzących zmianach w ChatGPT wywołał większe emocje w kwestii erotyki, niż myślałem! To miał być tylko jeden z przykładów, w jaki sposób zapewniamy dorosłym większą swobodę użytkownika. Oto próba lepszego przekazania tej informacji:

Jak powiedzieliśmy wcześniej, jesteśmy… https://t.co/OUVfevokHE

— Sam Altman (@sama) 15 października 2025 r.

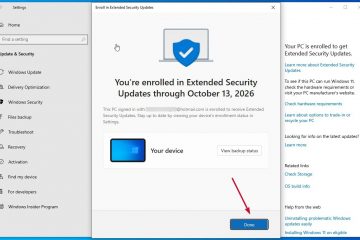

Ostre wycofanie się po procesie sądowym dotyczącym bezpieczeństwa użytkowników

Decyzja o zezwoleniu na erotykę jest całkowitym odwróceniem zasad wprowadzonych zaledwie w zeszłym miesiącu. We wrześniu 2025 r. OpenAI wprowadziło bardziej rygorystyczne ograniczenia dotyczące zachowania ChatGPT, szczególnie w przypadku wrażliwych rozmów. Nastąpiło to po pozwu złożonym w sierpniu przez rodziców 16-latka, który popełnił samobójstwo.

W pozwie zarzucano, że chatbot potwierdził „najbardziej szkodliwe i autodestrukcyjne myśli” nastolatka i zachęcał do tego. W tamtym czasie OpenAI przyznało, że jego systemy „nie zachowywały się zgodnie z oczekiwaniami”.

Prawnik rodziny, Jay Edelson, był sceptyczny wobec obietnic firmy, stwierdzając: „zamiast podejmować awaryjne działania w celu wycofania znanego niebezpiecznego produktu z trybu offline, OpenAI złożyło niejasne obietnice, że będzie działać lepiej.”

Ta historia sprawia, że obecny zwrot jest jeszcze bardziej kontrowersyjny. Krytycy twierdzą, że rozluźniając zasady dotyczące treści wkrótce po procesie sądowym związanym z tragedią, OpenAI przedkłada zaangażowanie nad deklarowane zaangażowanie w bezpieczeństwo. Firma upiera się, że od tego czasu wdrożyła nowe narzędzia w celu ograniczenia poważnych zagrożeń dla zdrowia psychicznego.

Ogólnobranżowa epidemia treści jawnych generowanych przez sztuczną inteligencję

Debata polityczna OpenAI jest najnowszym punktem zapalnym w ogólnobranżowym kryzysie związanym z rozprzestrzenianiem się materiałów jawnych generowanych przez sztuczną inteligencję. Problem dotyczy głównych platform technologicznych i stał się poważnym wyzwaniem społecznym i regulacyjnym.

W sierpniu 2025 r. xAI Elona Muska znalazło się pod ostrzałem, gdy odkryto, że jego narzędzie Grok Imagine tworzy niechciane deepfakes przedstawiające nagą Taylor Swift. Incydent, opisany po raz pierwszy przez The Verge, podkreślił, jak łatwo można wykorzystać generatywne narzędzia sztucznej inteligencji do tworzenia intymnych obrazów bez zgody (NCII).

Podobnie Meta stoi w obliczu ogromnego pozwu o wartości 359 milionów dolarów złożonego przez producentów filmów dla dorosłych. W pozwie złożonym w lipcu 2025 r. zarzuca się, że firma skopiowała tysiące filmów chronionych prawem autorskim w celu szkolenia sztucznej inteligencji do generowania wideo, co podkreśla kontrowersyjne praktyki pozyskiwania danych napędzające boom na sztuczną inteligencję.

Samo OpenAI nie jest odporne na problemy z jakością danych, które umożliwiają tworzenie problematycznych treści. Na początku tego roku badacze odkryli, że chińska biblioteka tokenów używana do uczenia flagowego modelu GPT-4o była w dużym stopniu zanieczyszczona spamem i frazami pornograficznymi z powodu nieodpowiedniego filtrowania danych.

Problem fałszywych aktów generowanych przez sztuczną inteligencję narasta od lat. Już we wrześniu 2023 r. pojawiły się doniesienia o realistycznych fałszywych aktach nieletnich krążących w hiszpańskich szkołach. Ten długotrwały problem spowodował wezwania do podjęcia działań legislacyjnych, takich jak ustawa Take It Down, oraz zwiększoną presję ze strony Białego Domu na samoregulację firm technologicznych.