OpenAI utworzyło nowy panel ekspertów, który ma doradzać w zakresie bezpieczeństwa sztucznej inteligencji. Firma ogłosiła we wtorek utworzenie ośmioosobowej „Rady Ekspertów ds. Dobrego Samopoczucia i Sztucznej Inteligencji”. Grupa pomoże w kierowaniu narzędziami takimi jak ChatGPT i Sora w zakresie zdrowia i dobrego samopoczucia. Posunięcie to stanowi wyraźną reakcję na rosnącą presję społeczną i rządową.

We wrześniu Federalna Komisja Handlu Stanów Zjednoczonych rozpoczęła szeroko zakrojone badanie wpływu sztucznej inteligencji na nastolatki. Firmie grozi także pozew, który łączy jej chatbota z samobójstwem nastolatka. Nowa rada to najnowszy krok OpenAI pokazujący, że poważnie podchodzi do obaw związanych z bezpieczeństwem.

Bezpośrednia odpowiedź na presję regulacyjną i prawną

Moment ogłoszenia nie jest przypadkowy. Następuje po miesiącach intensywnej analizy. szeroko zakrojone dochodzenie FTC w sprawie siedmiu gigantów technologicznych, w tym OpenAI, zasygnalizowało nową erę nadzoru regulacyjnego dla szybko rozwijający się rynek rozwiązań towarzyszących sztucznej inteligencji.

Przewodniczący FTC Andrew N. Ferguson określił śledztwo jako sposób na osiągnięcie równowagi, stwierdzając: „ochrona dzieci w Internecie jest najwyższym priorytetem dla FTC Trump-Vance i dlatego wspiera innowacje w kluczowych sektorach naszej gospodarki.” Ta federalna akcja uświadomiła całej branży, że era działania z kilkoma poręczami dobiegła końca.

Naciski prawne są równie intensywne. W sierpniu OpenAI został pozwany przez rodziców nastolatka, który popełnił samobójstwo. Jego ojciec, Matthew Raine, udzielił ostrej nagany, mówiąc: „Jako rodzice nie możecie sobie wyobrazić, jak to jest czytać rozmowę z chatbotem, który przygotowywał twoje dziecko do odebrania sobie życia”. Sprawa ta wzbudziła zaniepokojenie opinii publicznej i wzmogła wezwania do działania.

Wydarzenia te wpisują się w serię błędów w zakresie bezpieczeństwa, które nękają branżę. Meta stanęła w obliczu podobnego kryzysu po doniesieniach, że sztuczna inteligencja może pomóc nastolatkom zaplanować samookaleczenie. Incydent skłonił Jima Steyera, dyrektora generalnego Common Sense Media, do oświadczenia: „Meta AI stanowi zagrożenie dla nastolatków i należy ją natychmiast wyeliminować”.

Koalicja 44 prokuratorów generalnych stanowych powtórzyła to oburzenie w zjadliwy list, w którym pisze: „Jesteśmy jednakowo oburzeni tym oczywistym lekceważeniem emocjonalnego dobrostanu dzieci…” Powszechne potępienie ze strony władz stanowych i federalnych poziomy zmusiły firmy technologiczne do reakcji.

Poznaj Radę Ekspertów ds. Dobrego samopoczucia i sztucznej inteligencji

Nowa rada OpenAI jest bezpośrednią odpowiedzią na te wyzwania. firma ogłosiła utworzenie ośmioosobowej „Rady Ekspertów ds. dobrego samopoczucia i sztucznej inteligencji”, która ma kierować jej pracami nad produktami takimi jak ChatGPT i Sora. Jej formalnym zadaniem jest doradzanie, zadawanie krytycznych pytań i pomoc w ustaleniu, jak powinny wyglądać zdrowe interakcje ze sztuczną inteligencją dla użytkowników w każdym wieku.

Grupa składa się z czołowych postaci w dziedzinie psychologii, psychiatrii i interakcji człowiek-komputer. Członkami są eksperci tacy jak dr David Bickham z Boston Children’s Hospital, profesor Andrew Przybylski z Uniwersytetu Oksfordzkiego i dr Sara Johansen, założycielka Cyfrowej Kliniki Zdrowia Psychicznego w Stanford.

Według OpenAI rada oficjalnie rozpoczęła pracę od sesji osobistej i będzie brać udział w regularnych meldunkach i spotkaniach. Sesje te będą poświęcone złożonym tematom, takim jak to, jak sztuczna inteligencja powinna zachowywać się w wrażliwych sytuacjach i jakie poręcze mogą najlepiej wspierać użytkowników. Grupa zbada również, w jaki sposób sztuczna inteligencja może pozytywnie przyczynić się do dobrego samopoczucia.

To formalizuje relację, która rozpoczęła się na początku tego roku. OpenAI potwierdziło, że podczas opracowywania niedawno wprowadzonej kontroli rodzicielskiej konsultowało się nieformalnie z wieloma z tych ekspertów. Ich opinie w szczególności pomogły ukształtować ton powiadomień o niebezpieczeństwie, tak aby był „troskliwy i pełen szacunku zarówno dla nastolatków, jak i członków rodziny”.

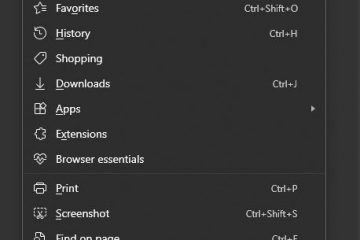

Te kontrole, wprowadzone pod koniec września, były pierwszym krytycznym krokiem. System wykorzystuje model wzajemnej zgody i udostępnia opiekunom pulpit nawigacyjny, w którym mogą ustawiać „ciche godziny”, wyłączać tryb głosowy i wyłączać funkcje pamięci. Kluczową funkcją jest system ostrzegania, który powiadamia rodziców, jeśli po ocenie przez weryfikatorów rozmowa zostanie oznaczona jako zawierająca treści powodujące poważne samookaleczenie.

Szef ds. dobrego samopoczucia młodzieży w OpenAI, Lauren Haber Jonas, wyjaśniła, że celem było znalezienie delikatnej równowagi. „Chcemy zapewnić rodzicom wystarczającą ilość informacji, aby mogli podjąć działania i porozmawiać z nastolatkami, zachowując jednocześnie pewną dozę ich prywatności” – zauważyła. Rada sformalizuje teraz tę rolę doradczą, pomagając kształtować przyszłe funkcje bezpieczeństwa i zasady dotyczące produktów.

Ogólnobranżowe obliczenie bezpieczeństwa sztucznej inteligencji

Wyzwania stojące przed OpenAI nie są wyjątkowe. Odzwierciedlają one szersze, obejmujące całą branżę podejście do psychologicznego wpływu sztucznej inteligencji. Eksperci od dawna ostrzegali przed niebezpieczeństwami związanymi z emocjonalną zależnością od chatbotów zaprojektowanych tak, aby naśladować ludzkie relacje.

Chociaż nowa rada OpenAI i kontrola rodzicielska to znaczące kroki, niektórzy krytycy twierdzą, że nie idą wystarczająco daleko. Opcjonalny charakter kontroli rodzicielskiej nakłada na opiekunów obowiązek ich aktywowania.

OpenAI przyznaje, że to dopiero pierwsze posunięcia. Firma opracowuje także długoterminowy system przewidywania wieku, który domyślnie automatycznie stosuje ustawienia odpowiednie dla nastolatków. Na razie utworzenie rady ekspertów sygnalizuje wyraźne zaangażowanie w kwestie bezpieczeństwa.