Microsoft wprowadza nowe testy porównawcze wdrożenia Copilot na platformie Viva Insights, co pozwala menedżerom monitorować i porównywać sposób, w jaki zespoły korzystają z flagowego asystenta AI firmy.

Ta funkcja umożliwia organizacjom śledzenie wykorzystania w ich własnych działach na podstawie anonimowych danych od podobnych firm.

Chociaż Microsoft twierdzi, że celem jest poprawa zaangażowania, narzędzie to przywołuje wspomnienia jego kontrowersyjny „Wynik Produktywności”. Ta funkcja została ostro skrytykowana w 2020 r. jako narzędzie do monitorowania miejsca pracy, zanim została zmieniona w celu ochrony prywatności pracowników. Nowe testy porównawcze są teraz dostępne w prywatnej wersji zapoznawczej, a pełne wdrożenie spodziewane jest jeszcze w tym miesiącu.

Pomiar wdrożenia sztucznej inteligencji za pomocą nowych testów porównawczych

Nowa funkcja, oficjalnie nazywana Benchmarki są zintegrowane bezpośrednio z panelem kontrolnym Microsoft Copilot w ramach Viva Insights. Viva Insights to firmowa platforma analityczna zaprojektowana do „przechwytywania danych z działań pracowników”, jak to ujęto w jednym z raportów, pomagająca kierownictwu w identyfikowaniu wzorców współpracy, wydajności i potencjalnego wypalenia wśród pracowników.

Ponieważ licencje Copilot stanowią znaczącą ciągłą inwestycję dla przedsiębiorstw, te testy porównawcze zapewniają menedżerom namacalny sposób pomiaru zaangażowania i uzasadnienia wydatków. System umożliwia dwa główne tryby porównań: analizę wewnętrzną i zewnętrzną.

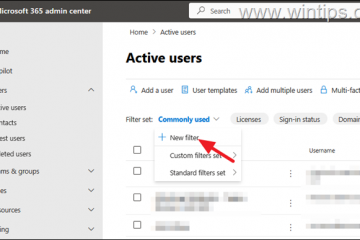

Wewnętrznie menedżerowie mogą porównywać różne „kohorty” w swojej organizacji na podstawie atrybutów, takich jak funkcja stanowiska, region geograficzny lub typ menedżera.

Na pulpicie nawigacyjnym wyświetlane są kluczowe wskaźniki, takie jak odsetek aktywnych użytkowników Copilot, wskaźniki wykorzystania w określonych aplikacjach Microsoft 365 oraz odsetek powracających użytkowników. Na przykład niski odsetek powracających użytkowników może sygnalizować, że pracownicy eksperymentują ze sztuczną inteligencją, ale nie znajdują trwałej wartości w swoich codziennych przepływach pracy.

Funkcja zewnętrznego testu porównawczego wprowadza dynamikę konkurencyjną, umożliwiając firmie zmierzenie wskaźników wykorzystania w porównaniu z anonimowymi kolegami z branży.

Organizacje mogą zobaczyć, jak ich odsetek aktywnych użytkowników wypada na tle „Top 10% i najlepszych” 25%” podobnych firm lub w stosunku do ogólnej średniej wszystkich klientów. Może to wywrzeć presję na zespoły, aby zwiększyły wykorzystanie, aby spełnić lub przekroczyć normy branżowe.

Aby zapewnić przejrzystość, firma Microsoft podaje szczegółową definicję tego, co śledzi. „Aktywny użytkownik Copilot” to osoba, która „wykonała celowe działanie na rzecz funkcji opartej na sztucznej inteligencji” w szerokiej gamie produktów, w tym Teams, Outlook, Word, Excel, PowerPoint, OneNote i Loop.

Firma pozytywnie określa cel narzędzia, stwierdzając, że „te spostrzeżenia pomagają zidentyfikować trendy w zakresie wdrażania oraz zapewniają szerszy kontekst i nowe możliwości poprawy zaangażowania Copilot”.

Déjà Vu? Echa kontrowersji dotyczącej wyniku produktywności

To posunięcie nie dzieje się w próżni. W 2020 r. Microsoft spotkał się ze znacznym sprzeciwem wobec prywatności w związku z „Wynikiem Produktywności” na platformie Microsoft 365. Krytycy i zwolennicy prywatności ostro skrytykowali tę funkcję umożliwiającą monitorowanie poszczególnych pracowników, a niektórzy nazywali ją narzędziem do „nadzorowania miejsca pracy”.

Oryginalny Wynik mógł pokazywać z imienia i nazwiska menedżerów, którzy byli mniej aktywni w kanałach Teams lub w mniejszym stopniu uczestniczyli w udostępnianych dokumentach. Austriacki badacz Wolfie Christl napisał na Twitterze, że „jest to bardzo problematyczne na wielu poziomach”, oddając powszechną obawę, że narzędzie to stanowi krok w kierunku inwazyjnego zarządzania algorytmicznego.

W swoim ówczesnym oświadczeniu Microsoft upierał się, że „wskaźnik produktywności nie jest narzędziem do monitorowania pracy. Wynik produktywności polega na odkrywaniu nowych sposobów pracy, zapewnianiu pracownikom doskonałej współpracy i doświadczeń technologicznych”. Jednak publiczne oburzenie było na tyle duże, że wymusiło zmianę.

Zaledwie tydzień po początkowych kontrowersjach Jared Spataro, wiceprezes Microsoft 365, ogłosił poważne zmiany w narzędziu.

Stwierdził: „Słyszeliśmy opinie i dzisiaj w odpowiedzi wprowadzamy zmiany w produkcie, aby jeszcze bardziej zwiększyć prywatność klientów”, potwierdzając, że Microsoft usunie nazwy użytkowników i skupi się wyłącznie na danych zbiorczych. Ta historia rzuca się w oczy w kontekście nowych testów porównawczych Copilot.

Ochrona prywatności i utrzymujące się obawy

Wygląda na to, że Microsoft wyciągnął wnioski ze swoich błędów w przeszłości i od samego początku uwzględniał kwestie prywatności w nowych wzorcach. Firma twierdzi, że do porównań zewnętrznych stosuje „randomizowane modele matematyczne”, aby mieć pewność, że żadne dane pojedynczej firmy nie zostaną zidentyfikowane.

Ponadto każda zewnętrzna grupa porównawcza składa się z co najmniej 20 różnych firm, co zapewnia kolejną warstwę anonimizacji.

W przypadku porównań wewnętrznych firma Microsoft wyjaśnia, w jaki sposób oblicza oczekiwane wyniki. Według firmy „wynik kohorty uwzględnia skład ról w wybranej grupie i konstruuje średni ważony oczekiwany wynik w oparciu o dopasowanie ról u wszystkich najemców”.

Pomimo tych zabezpieczeń samo istnienie narzędzia rodzi pytania. Podstawową obawą jest to, że menedżerowie mogą błędnie zinterpretować dane, utożsamiając wysokie wykorzystanie Copilota z wysoką wydajnością. Może to skłonić pracowników do „oszukiwania systemu” poprzez wykonywanie powierzchownych działań AI tylko po to, aby poprawić swoje wskaźniki.

Takie zachowanie podważyłoby cel, jakim jest rzeczywisty wzrost produktywności i mogłoby potencjalnie zaszkodzić morale. W miarę jak organizacje radzą sobie z przejściem na sztuczną inteligencję, granica między zachęcaniem do przyjęcia a umożliwieniem nadzoru pozostaje krytyczną i delikatną kwestią, którą Microsoft musi ostrożnie poruszać.