Meta uruchomił nowe narzędzie do tłumaczenia AI, które pomaga twórcom na Facebooku i Instagramie dotrzeć do globalnej publiczności. Funkcja, ogłoszona we wtorek, automatycznie nazywa rolki w nowych językach, jednocześnie zachowując własny głos i ton twórcy. Obejmuje również opcjonalną funkcję synchronizacji warg, dzięki czemu wideo wyglądało bardziej naturalnie.

Początkowo wdrażanie wsparcia angielskiego i hiszpańskiego narzędzie ma na celu rozbić bariery językowe. Aktualizacja jest dostępna na całym świecie dla wszystkich publicznych kont na Instagramie i twórców Facebooka z ponad 1000 obserwujących w regionach, w których oferowana jest Meta AI. Ten ruch sygnalizuje agresywne pchanie Meta do praktycznych aplikacji AI.

Uruchomienie umieszcza meta w bezpośredniej konkurencji z podobnymi narzędziami komunikacyjnymi opartymi na AI z Google i Microsoft, w bitwie OnGoint o dominację na platformach wzmacnianych AI.

Jak Meta Ai Dubbing i Lip-Syncing Works

Głowa Instagram Adam Mosseri Mosseri AI As A Mission do połączenia z Platformami do połączenia z pentyczny ludzie. „Wierzymy, że istnieje wielu niesamowitych twórców, którzy mają potencjalnych odbiorców, którzy niekoniecznie mówią ten sam język”-wyjaśnił w poście. Uważa, że poprzez pomostowanie podziałów językowych narzędzie pomoże twórcom odblokować nowe możliwości rozwoju i zaangażowania na platformie.

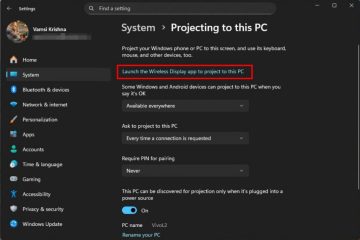

Twórcy mogą aktywować nową funkcję bezpośrednio w ramach przepływu pracy w boleniach, wybierając opcję „Przetłumacz swój głos z Meta AI”. Zgodnie z ogłoszeniem Meta system jest zaprojektowany jako darmowe narzędzie, które po włączeniu automatycznie nazywa treść . AI generuje nową ścieżkę audio, która zachowuje autentyczny dźwięk i ton użytkownika, tworząc bezproblemową wrażenia dla widza. Opcjonalna funkcja synchronizacji warg dodatkowo zwiększa efekt, precyzyjnie dopasowując ruchy ust twórcy do przetłumaczonych słów, sprawiając, że wyglądają tak, jakby płynnie mówią w nowym języku.

Ta technologia, która została po raz pierwszy zapowiedziana na konferencji Meta Connect we wrześniu 2024 r., Kładzie silny nacisk na kontrolę Stwórcy. Użytkownicy mogą zdecydować się na przejrzenie i zatwierdzenie tłumaczeń, zanim zostaną opublikowane, włączając określony przełącznik. Wysyła powiadomienie do twórcy, który może następnie zaakceptować lub odrzucić nazwaną wersję z profesjonalnego pulpitu nawigacyjnego. Meta wyjaśnia, że odrzucenie tłumaczenia nie wpłynie na oryginalną, nietranslacyjną rolkę.

W przypadku przejrzystości widzowie zobaczą powiadomienie wskazujące, że kołowrotek został przetłumaczony z meta AI i może wyłączyć przyszłe tłumaczenia dla określonych języków za pośrednictwem menu Ustawienia.

, aby pomóc twórcom zrozumieć, że wpływ ich nowo globalnej zawartości ma zintegrowanie nowości metrycznych do analizy. Ta funkcja zapewnia rozkład liczby widoków według języka, oferując wyraźny wgląd w sposób, w jaki tłumaczenia występują z nowymi odbiorcami międzynarodowymi. Aby uzyskać lepsze wyniki, Meta doradza twórcom, aby kręcili filmy twarzą w twarz, mówić wyraźnie bez zakrywania ust i minimalizacji hałasu tła lub muzyki. Narzędzie obsługuje obecnie do dwóch głośników, którzy powinni unikać rozmowy o siebie w celu najdokładniejszego tłumaczenia.

Ręczna alternatywa dla wielojęzycznych twórców

dla twórców, którzy wymagają większej szczegółowej kontroli lub pracy w językach, które nie są jeszcze poparte przez AI, meta, meta ma również opcję solidnej ręcznej. Strony na Facebooku mają teraz możliwość przesyłania do 20 własnych wstępnie translacji ścieżek audio do jednego kołowrotka.

Jest to zarządzane w sekcji „Zamknięte podpisy i tłumaczenia” w Meta Business Suite. W przeciwieństwie do przed publikacją przepływu pracy narzędzia AI, te ręcznie przesłane ścieżki można dodać, wymienić lub usunąć zarówno przed, jak i po opublikowaniu kołowrotka, oferując elastyczne rozwiązanie dla profesjonalnych przepływów pracy.

Wyścig zbrojeń AI: Meta vs. konkurencja

Meta narzędzi do FierCely Landscape. Microsoft ogłosił swoją funkcję „Interpretera w zespołach” pod koniec 2024 r., Którego ma na celu klonowanie głosu użytkownika do płynnych tłumaczeń spotkań w czasie rzeczywistym. CMO Microsoftu, Jared Spataro, podkreślił cel, aby komunikacja w języku w języku językiem była bardziej osobistą, prosząc użytkowników o „wyobrażanie sobie, że mogą brzmieć tak jak ty w innym języku.”

W maju 2025 r. Google poszedł za sobą, integrując Gemini Ai z Google Meet na tłumaczenie mowy na żywo. Podejście Google podkreśla zachowanie unikalnych cech wokalnych mówcy, w tym ton i kadencja. Jak zauważył jeden z ekspertów, skupienie się na niuansie ma kluczowe znaczenie: „To nie chodzi tylko o słowa; chodzi o przekazanie intencji. Google skupienie się na niuansie wokalnym może być rewolucyjne dla tego, w jaki sposób rozproszone zespoły łączą się.”

Tymczasem specjalista od tłumaczenia Deepl uruchomił głos Deepp w 2024 r. Jakość i bezpieczeństwo, z których DeEpl jest znane tłumaczeniu mowy w czasie rzeczywistym, były dla nas kolejną granicą jako biznesem i cieszymy się, że możemy w końcu zaprezentować nasze pierwsze produkty. “

Ta lawina innowacji podkreśla znaczące w branży dążenie do demontażu barier językowych przy użyciu wyrafinowanej AI. W przypadku meta uruchamianie pokrywa się również z poważną wewnętrzną restrukturyzacją działu AI, sygnalizując odnowione skupienie się na integracji zaawansowanej AI bezpośrednio z produktami skierowanymi do konsumentów.