Deweloper `CodingMoh` wprowadził Open Codex CLI , interfejs linii poleceń zbudowany jako open source, całkowicie lokalny zastępca oficjalnego kodu Openai. To nowe narzędzie umożliwia wspomaganie kodowania opartego na AI bezpośrednio w terminalu, specjalnie zaprojektowanym do skutecznego użytku z mniejszymi, lokalnie wykonanymi modelami językowymi (LLM).

Projekt powstał z wyzwań programisty w rozszerzeniu narzędzia Openai; `CodingMoh` opisał oficjalną bazę kodową stwierdzając, że „ Ich kod ma kilka wycieków, co utrudniało zachowanie rdzeniowe. Krótko po, po, otwarcie przełomowych zmian. Utrzymanie moich dostosowań. To doświadczenie doprowadziło do naziemnego przepisania w Python.

Koncentracja na lokalnym wykonaniu i mniejszych modelach

Open Codex CLI rozróżnia się poprzez ustalenie priorytetu operacji modelu lokalnego, dążąc do funkcjonowania bez konieczności zewnętrznego, kompletnego serwera wniosków. Jego podstawowe zasady projektowania, jak opisano autor, to: „Napisz narzędzie specjalnie uruchomione _locally_ poza pudełkiem, nie wymaga serwera API wnioskowania.-Użyj modelu bezpośrednio (obecnie dla phi-4-mini za pośrednictwem LLAMA-CPP-Python).-Optymalizuj logikę podpowiedzi i realizacji _per Model_, aby uzyskać najlepszą wydajność.”

Obecnie obsługuje model Phi-4-mini Microsoft, szczególnie za pośrednictwem lmStudio-community/phi-4-4-4-4-4-mini-instruct-gluf-gguf wersja gguf-format dostosowany do uruchamiania LLMS na różnorodne oprogramowanie hardme. Często wymagają innej obsługi niż ich większe odpowiedniki. „Wzorce szybkiego dla małych modeli open source (takich jak Phi-4-Mini) często muszą być bardzo różne-również nie uogólniają się”, zauważył „CodingMoh”. Koncentrując się na bezpośredniej interakcji lokalnej, Open Codex CLI stara się ominąć problemy z kompatybilnością czasami, gdy próbują uruchamiać modele lokalne za pomocą interfejsów zaprojektowanych dla kompleksowych, opartych na chmurze interfejsów API.

Obecnie narzędzie funkcjonuje w trybie „pojedynczych strzałów”: Użytkownicy Wprowadź instrukcje języka naturalnego (np. Anuluj.

Instalacja, interakcja społeczności i umiejscowienie rynku

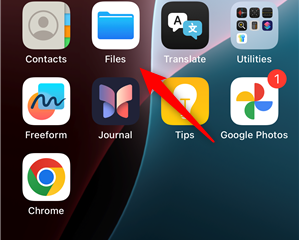

Otwarte Codex CLI można instalować za pomocą wielu kanałów. Użytkownicy macOS mogą korzystać z HomeBrew (`Brew Tap CodingMoh/Open-Codex; Brew Install Open-Codex`), a` PIPX Instalal Open-Codex` zapewnia opcję międzyplatformową. Deweloperzy mogą również sklonować repozytorium MIT-licencjonowane z GitHub i instalować lokalnie za pośrednictwem „instalacji PIP.” W katalogu projektu.

Dyskusje społecznościowe Porównania z oficjalnym narzędziem Openai, które sam Deepseek Coder v2 oraz glm 4 seria .

Niektórzy wczesni użytkownicy zgłosili wyzwania konfiguracyjne, gdy używasz modeli innych niż domyślne phi-4-mini, szczególnie za pośrednictwem Ollama. Kontekstowo Openai promuje własny ekosystem częściowo poprzez inicjatywy takie jak fundusz dotacji w wysokości 1 miliona dolarów oferujący kredyty API dla projektów wykorzystujących ich oficjalne narzędzia.

Ulepszenia planowane dla otwartego Codex CLI

Deweloper przedstawił wyraźną ścieżkę do zwiększenia CLI otwartego CLI. Przyszłe aktualizacje mają na celu wprowadzenie interaktywnego, świadomego kontekstu trybu czatu, prawdopodobnie zawierającego interfejs użytkownika terminala (TUI).

Obsługa zawierająca funkcję, możliwości wejścia głosowego za pomocą szeptu, historii poleceń z funkcjami cofniętymi, a system wtyczek są również częścią przewidywanej mapy drogowej. Ten niezależny projekt wchodzi na tętniący życiem rynek, na którym narzędzia takie jak GitHub Copilot i Platforme Kodowania AI Google coraz częściej zawierają autonomiczne funkcje. Open Codex CLI wyrzeźbia jednak swoją niszę, podkreślając kontrolę użytkowników, przetwarzanie lokalne i optymalizację dla mniejszych modeli typu open source w środowisku terminalnym.