Amazon Web Services (AWS) uruchomił zbiór serwerów open source z wykorzystaniem modelu protokołu kontekstowego (MCP), mającym na celu poprawę sposobu, w jaki asystenci kodowania zasilani sztuczną inteligencją w interakcje z usługami i danymi AWS. Szczegółowe informacje w repozytorium github/mcp i wydane pod adresem , serwery te zapewniają standaryzowanym sposobowi dla agentów AI do uzyskania dokładnego kontekstu AWS w czasie rzeczywistym, potencjalnie przyspieszając przepływy pracy w chmurze i poprawę jakości kodu.

Mostkowanie danych AI i chmurę z otwartym standardem

The Core Technology, protokol kontekstowy modelu , został po raz pierwszy wprowadzony przez antropic w listopadzie 2024 r. Rozwiązuje się do wspólnego wydania modeli AI, które nie mają dostępu do niezbędnych informacji zewnętrznych lub narzędzi. Jak stwierdza oficjalna dokumentacja MCP: „Model Context Protocol (MCP) to otwarty protokół, który umożliwia bezproblemową integrację między aplikacjami LLM a zewnętrznymi źródłami danych i narzędzi… MCP zapewnia znormalizowany sposób łączenia LLM z potrzebnym kontekstem.”

Antropic kontynuuje kierowanie projektem protokołu typu source. Zamiast budować wiele niestandardowych integracji, programiści mogą używać klientów MCP (w AI Asystentom) do połączenia z serwerami MCP przez HTTP, które ujawniają określone funkcje lub punkty dostępu do danych.

Początkowa wersja AWS obejmuje kilka serwerów skupionych na różnych obszarach:

Core MCP Server: działa jako koordynator zarządzania innymi serwerami AWS MCP. ( Dokumenty ) Dokumentacja: zapewnia dostęp do obecnych dokumentów AWS za pośrednictwem oficjalnego interfejsu API wyszukiwania. ( dokumenty ) bazy wiedzy na temat bederock Amazon (Rag). Bedrock to zarządzana usługa AWS dla modeli fundamentów. ( Docs ) AWS CDK & AWS Terraform: Oferuj narzędzia do infrastruktury jako kod (iAC), w tym integrację SecurityOv w analizie Terra Server. ( cdk Docs , ) Analiza kosztów: pozwala na zapytania dotyczące języka naturalnego dotyczące wydatków AWS. ( dokumenty ) Amazon nova canvas: integruje się z modelem generowania obrazu Amazon, częścią jego rodziny nova ai. ( Dokumenty ) AWS Diagram: Pomoc w tworzeniu diagramów architektury za pomocą kodu Python. ( Docs ) AWS Lambda: Pozwól agentom AI Trigger specyficzne funkcje Lambda jako narzędzia. ( dokumenty )

intencja, zgodnie z blogiem AWS, jest to, że ten protokół pozwala asystentom AI na korzystanie ze specjalizacji i dostępu do domenu „

Intep i integracja ekosystemu

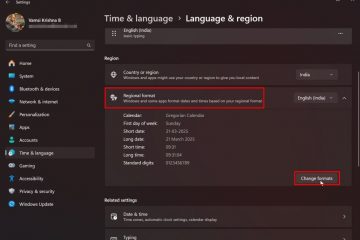

Konfigurowanie tych serwerów wymaga zainstalowania użyteczności `UV` uv` z astral , a także Python 3,10+ jest dostępny i konfigurujący Aws i konfiguruje i konfiguruje Aws i konfiguruje i konfiguruje Aws. referencje. Same serwery są zwykle wykonywane przy użyciu polecenia „uvx` (które uruchamia pakiety w środowiskach tymczasowych) za pośrednictwem pakiety hostowane na PYPI . Konfiguracja ma miejsce w narzędziu klienta, używając plików JSON, takich jak ~/.AWS/Amazonq/mcp.json dla Amazon Q CLI, ~/.cursor/mcp.json dla kursor editor, editor, ~/. Windsurf. AWS wspomina także o poparciu dla aplikacji komputerowej i Cline Claude Anthropic. Deweloperzy mogą znaleźć określone wskazówki konfiguracyjne i próbki kodu w repozytorium.

szersze przyjęcie i rozważania

AWS nie jest to, że buduje się główny producent chmury. Microsoft zintegrował protokół z Azure AI w marcu 2025 r. I opracował oficjalny c# sdk . Microsoft podłączył również MCP z narzędziami takimi jak ramy jądra semantycznego i, zaledwie kilka dni temu 18 kwietnia, podglądał własne serwery MCP dla usług Azure.

Te rosnące punkty wsparcia MCP potencjalnie stają się wspólną warstwą interakcji AI-Cloud. Podczas standaryzacji interfejsu, praktyczne użycie nadal wymaga uwagi na potencjalne opóźnienie HTTP dla niektórych aplikacji oraz potrzeby wdrożenia solidnego obsługi błędów i bezpieczeństwa wokół interakcji serwera. Strategia Amazon wydaje się wieloaspektowa, uzupełniając tę otwartą standardową adopcję z dalszym rozwojem wewnętrznych modeli i narzędzi Nova AI, takich jak Nova Act Sdk.