Openai wydał Codex CLI , asystent kodowania poleceń typu open source, który integruje się bezpośrednio z terminalami programistów. Zbudowany dla uproszczenia i przejrzystości, narzędzie oferuje modele-agnostyczny, lokalnie konfigurowalny alternatywę dla agentów kodujących oparte na subskrypcji. Odzwierciedla przejście Openai w kierunku narzędzi, które programiści mogą w pełni kontrolować-bez polegania na zastrzeżonych IDE lub przepływach pracy tylko w chmurze.

Codex CLI jest licencjonowany w ramach MIT i został uruchomiony cicho za pośrednictwem GitHub bez oficjalnego postu na blogu lub kampanii medialnej. Mimo to narzędzie zwróciło uwagę na usprawnioną konfigurację i elastyczną architekturę. Developers can issue plain language prompts in the terminal, receive AI-generated responses instantly, and integrate Codex CLI into their existing workflows using YAML files and Python hooks.

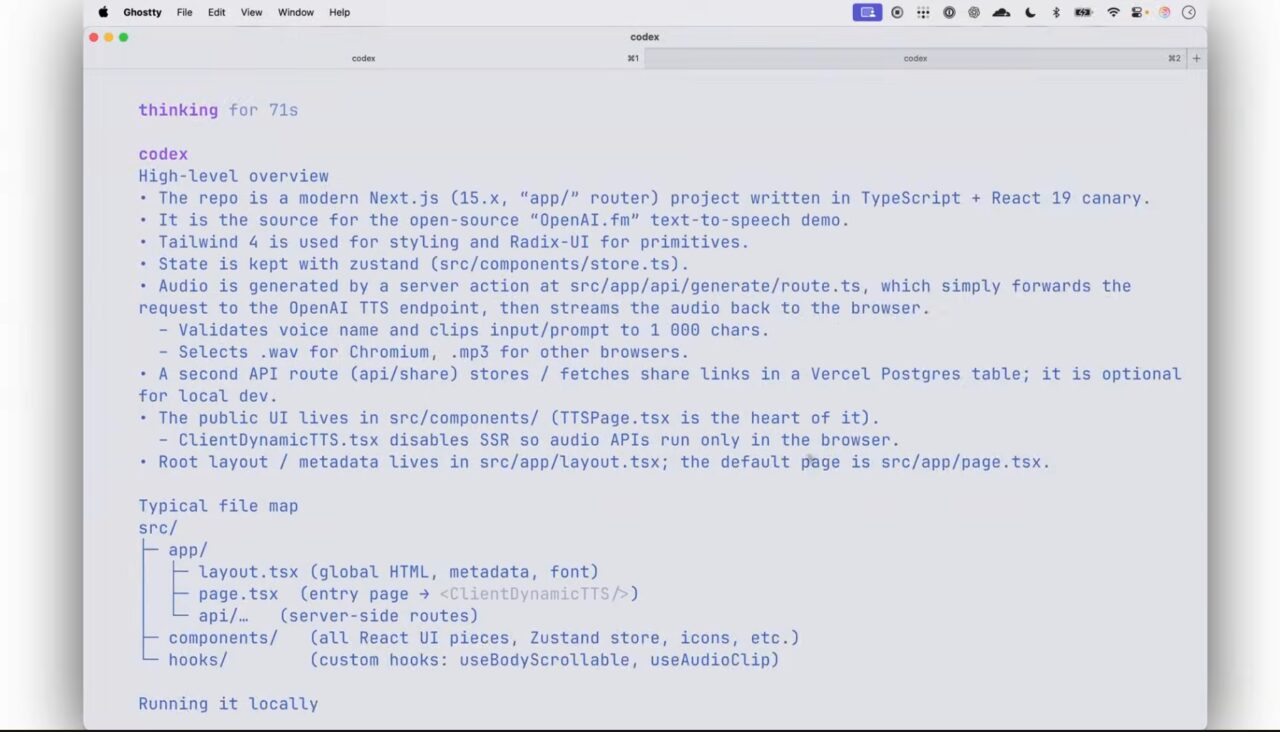

[embedded content]

Built for Speed, Streaming, and Flexibility

Codex CLI is built to operate from the command line using shell comments like # write a function to check for Palindromes. Narzędzie odpowiada poprzez wstrzyknięcie wygenerowanego kodu bezpośrednio do terminala, umożliwiając programistom przegląd, uruchamianie lub modyfikowanie danych wyjściowych. It includes a minimal interface for cycling through completions or editing results before execution.

One of the more developer-friendly features is support for streaming output in the GitHub documentation, which displays code as it’s wygenerowane. Ta informacja zwrotna w czasie rzeczywistym zwiększa użyteczność dla programistów, którzy preferują szybkie, najważniejsze środowisko klawiatury. Konfiguracja odbywa się za pomocą pliku.Codex YAML, z obsługą zmiennych wbudowanych i dostosowywania szablonu.

Domyślnie Codex CLI używa GPT-4-turbo OpenAI, ale użytkownicy mogą wskazać narzędzie do dowolnego kompatybilnego punktu końcowego API. Obejmuje to nowo wydane modele O3 i O4-Mini Openai, które zostały zaprojektowane z myślą o bardziej celowym rozumowaniu i multimodalnym zastosowaniu. Deweloperzy mogą przełączać się między modelami, edytując flagę konfiguracyjną.

multimodalna wejściowa i lokalna adaptabilność

W przeciwieństwie do większości narzędzi opartych na przeglądarce, Codex obsługuje interakcje multimodalne. Według TechCrunch, programiści mogą przekazywać zrzuty ekranu lub szkice do CLI i łączyć je z językiem naturalnym, aby uzyskać sugestie dotyczące kodu według kontekstu wizualnego. Jest to zgodne z możliwościami widocznymi w nowszych modelach Openai, które mogą interpretować obrazy jako część ich danych wejściowych.

CLI można również rozszerzyć za pomocą haków opartych na Pythonie, które przechwytują żądania i odpowiedzi. Deweloperzy zaczęli już budować niestandardowe wtyczki do wyników, stosować formatowanie lub włączyć lokalną integrację LLM za pomocą narzędzi takich jak LLAMA lub Mistral. Ta elastyczność pozycjonuje Codex CLI jako dostosowującą się modułową strukturę-nie tylko interfejs jednorazowy.

Presja konkurencyjna i pozycjonowanie programistów

Czas uwolnienia Codex CLI jest godne uwagi. Przybył zaledwie dwa tygodnie po tym, jak Github rozszerzył ofertę Copilota o tryb agenta i subskrypcję pro+, która pakuje dostęp do modeli premium, takich jak Claude Sonnet, Gemini 2.0 i O3-Mini Openai. Tryb agenta Copilota pozwala asystentowi wykonywać polecenia, edytować pliki i nawigować w projektach autonomicznie.

Natomiast Codex CLI priorytetowo traktuje kontrolę ręczną i unika automatyzacji zadań bez nadzoru użytkownika. Nie ma wbudowanego GUI, nie ma zależności od przechowywania w chmurze i nie ma subskrypcji Paywall. Domyślna konfiguracja jest lokalna, przejrzysta i minimalna-odwołuje się do programistów, którzy wolą dostosowywać automatyzację.

Google również podnosi stawki w kodowaniu AI z FireBase Studio, uruchomione 9 kwietnia. Jest to platforma pełna oparta na przeglądarce z agencyjną obsługą Gemini, hosting narzędzi, generatory schematu, generatory schematu i multimodalne. Ale wymaga to użytkownikom pozostania w ekosystemie Google. Natomiast Codex CLI działa niezależnie od dowolnej usługi chmurowej lub IDE.

Reakcja programisty i wczesna adopcja

Pomimo spokojnego wydania, Codex CLI widzi szybkie przyjęcie. W odniesieniu do Todaz narzędzie Alrez otrzymał ponad 2400 gwiazdek na Github. Wczesni testerzy w Reddit i Hacker News chwalili jego prostotę, szybkość i konfigurację otwartą. Kilku użytkowników zmodyfikowało go już do obsługi lokalnych modeli, takich jak LLAMA lub Mistral, pokazując, jak łatwo można rozszerzyć narzędzie dla środowisk niestandardowych.

Podczas gdy Codex CLI domyślnie polega na dostępie interfejsu API do modeli Openai, jego struktura zachęca do eksperymentowania i samodzielnych alternatyw. Ten modelu-agnosticyzm odróżnia go od narzędzi, które działają tylko w markowych ekosystemach lub wymagają od użytkowników zakupu tokenów lub poziomów użytkowania w celu odblokowania podstawowej funkcjonalności.

Aby zachęcić do dalszego przyjęcia, OpenAI uruchomiła inicjatywę grantu. Firma oferuje do 25 000 USD kredytów API na kwalifikujące się projekty w ramach funduszu o wartości 1 miliona dolarów mającego na celu wspieranie rozwoju Codex CLI i ekosystemu API API Openai.

szerszy wyścig zbrojeń kodowania AI

Codex CLI wdraża przestrzeń rozwijającego się narzędzi deweloperów AI. Większość konkurentów dąży do zwiększenia poziomu autonomii i integracji, od agentów prowadzących polecenia GitHub po asystentów ochrony aplikacji Google. Niektórzy, jak Manus AI, poszli to jeszcze dalej. Agent zbudowany przez chiński jest zaprojektowany do wykonywania zadań przy minimalnym wkładu człowieka, a teraz oferuje ceny wielopoziomowe do 199 USD/miesiąc.

, ale Codex CLI całkowicie unika tego modelu. Nie ma poziomów. Brak pieczonych przepływów pracy. Bez blokad związanych z marką. Nie próbuje przewidzieć następnego ruchu ani podjąć działań dla Ciebie. Zamiast tego oferuje wyraźną ścieżkę do integracji potężnej sztucznej inteligencji z przepływami pracy programistów-na warunkach programisty.

Takie podejście może spodobać się programistom, którzy chcą uniknąć interfejsów tylko w chmurze i zamkniętych ekosystemów.