Wydaje się, że Openai przygotowuje się do wprowadzenia znaczącej nowej przeszkody dla programistów, którzy chcą mieć dostęp do swoich najpotężniejszych przyszłych modeli AI za pośrednictwem API: potencjalny wymóg, aby organizacje poddały się weryfikacji tożsamości za pomocą identyfikatorów rządowych.

Szczegóły wyłaniające się z Strona wsparcia Openai W zeszłym tygodniu opisz proces „zweryfikowanej organizacji”, otoczony przez firmę jako niezbędny krok w celu przeciwdziałania niewłaściwego użycia i promowania odpowiedzialnego wdrożenia AI. Openai sugeruje to, że jest to skierowane do „niewielkiej mniejszości” celowo naruszającymi zasady użytkowania, mające na celu „złagodzenie niebezpiecznego użycia AI, jednocześnie udostępnianie zaawansowanych modeli dla szerszej społeczności programistów.”

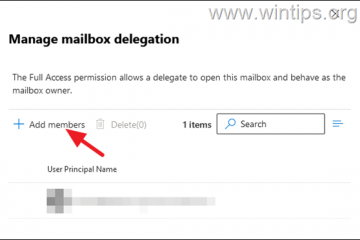

Ta weryfikacja łączy autoryzowaną osobistą osobę osobistą osobistą identyfikatorem rządu z jego organizacji, z jego organizacją, z jego organizacją do interpretacji API organizacji, a nie jest to gwarancja, nie jest to gwarancja, nie jest to gwarancja, która nie jest w stanie uwierzytelniona, nie jest to gwarancja dla wszystkich osób, która jest przeznaczona do wszystkich osób, na całą osobę. Zadratowanie pytań dotyczących konkretnych kryteriów.

Proponowany system już generuje dyskusję wśród deweloperów online. Obawy dotyczące dodatkowego tarcia operacyjnego, względy prywatności polegającego na przedstawieniu identyfikacji rządu, potencjalne wykluczenie użytkowników w regionach poza lista obsługi API openai z obsługiwanych krajów interfejsów API. Śledzenie i zwiększona kontrola nad dostępem do platformy, zwłaszcza biorąc pod uwagę wcześniejsze działania, takie jak blok API w Chinach lub dochodzenia w sprawie domniemanych niewłaściwych danych przez Deepseek i innych.

Nowe modele mogą wydawać nowe elementy sterujące

To potencjalne warstwy weryfikacyjne przechodzi, gdy openai przygotowuje się do tego, co sugerują źródło, które sugerują nowe modele AI-same systemy, które można znaleźć w tym, co może jeździć, być może łączące dostęp do sprzedaży. Podkreślając czas ujawnienia polityki. Nowe premiery mogą się zdarzyć już w tym tygodniu, w tym GPT-4.1 jako aktualizację modelu multimodalnego GPT-4O, a także specjalistyczne modele rozumowania oznaczone O3, O4-Mini i O4-Mini-High.

Strategia wdrażania modelu Openai dostosowuje się do znaczącego strategicznego dostosowania strategicznego. Ogłaszając „zmianę planów”, Altman priorytetowo wydał wydanie modeli O3 i O4-Mini „prawdopodobnie za kilka tygodni”, jednocześnie przesuwając debiut bardzo oczekiwanych modeli GPT-5 przez „kilka miesięcy.”

Wskazał, że chęć „odchylania modeli rozumowania i czatu/ukończenia” i tweetowanego entuzjazmu O3, sugerował, że opóźniał opóźnienie w GPT, zezwoli na opóźnienie firmy “. Spraw, aby GPT-5 był znacznie lepszy niż pierwotnie [t]. ” To odwróciło plan od lutego 2025 r. Do potencjalnie złożyć zdolności O3 na GPT-5.

Potrzeba różnych modeli rozumowania była widoczna nawet po pod koniec lutego uruchomienia GPT-4.5, który własny Openai

Przybycie tych silniejszych systemów, szczególnie modele rozumowania zapoczątkowane o mocnych wynikach porównawczych, ale potencjalnie wysokie koszty obliczeniowe, zapewnia kontekst dla zwiększonej kontroli dostępu. Jednak uzasadnienie bezpieczeństwa Openai dla weryfikacji ID kontrastuje gwałtownie z doniesieniami, że okresy oceny bezpieczeństwa dla tych samych modeli zostały drastycznie skrócone. Operacje Operacje Openai rzekomo obniżyły terminy testowania bezpieczeństwa dla modeli takich modeli od miesięcy w dół do czasem mniej niż tydzień, napędzane przez intensywne presję na konkurencję. To przyspieszenie podobno zaniepokoiło niektóre zaangażowane w proces oceny. Metodologie specyficznych testów są również pod ostrzałem. Krytycy wskazują na brak opublikowanych wyników do niewłaściwego wykorzystania potencjalnych testów za pomocą dokładnego dostrajania-dalsze szkolenie specjalistycznych danych w celu zbadania niebezpiecznych możliwości pojawiających się-w najnowszych, najbardziej zdolnych modelach, takich jak O1 lub O3-Mini. Były badacz Bezpieczeństwa Openai Steven Adler, który szczegółowo opisał widoki W poście na blogu argumentowałem, że może to prowadzić laboratoria do niedoceniania niebezpieczeństw, Mówienie czasów finansowych , „Nie wykonanie takich testów może oznaczać Openai, a inne firmy AI są podlegające najgorszemu projektowi z ich modeli. Wzbudzono również obawy dotyczące testowania wersji modeli pośredniego lub punktów kontrolnych, zamiast końcowego kodu wysłanego do publiczności. „Złą praktyką jest uwolnienie modelu, który różni się od tego, który oceniłeś”-były członek personelu technicznego wspomniany Ft. Szef systemów bezpieczeństwa, Johannes Heidecke, przeciwdziałał tym punktom, „mamy dobrą równowagę, jak szybko się poruszamy i jak dokładni jesteśmy”, przypisując prędkość automatyzacji i wyznaczał testowe punkty kontrolne “. To pozorne tarcie między prędkością rozwoju a ostrożnością bezpieczeństwa nie jest nowym terytorium dla Openai. Wewnętrzne nieporozumienia zostały podkreślone przez odejście Jana Leike w maju 2024 r., Wraz z kolacją długoterminowego zespołu ds. Nadalania zorientowanego na ryzyko, który publicznie stwierdził, że „kultura bezpieczeństwa i procesy zajęły miejsce na błyszczące produkty.” Dodając kolejny wymiar do wewnętrznej dynamiki firmy, byłych pracownikom OpenAi, którzy wpisały amicus w kwietniu. Krótkie przekazanie przesunięcia Openai w kierunku struktury ograniczonej z organizacji odbiega od jego założycielskiej misji non-profit, potencjalnie wpływając na zobowiązania bezpieczeństwa i alokacja zasobów. Potencjalna polityka weryfikacji identyfikatorów rozwija się, gdy konkurenci produkują różnorodne gesty publiczne w kierunku bezpieczeństwa i przejrzystości. Struktura bezpieczeństwa AGI. Dzieje się tak na tle powstających regulacji, takich jak UE AC AC, trwające odkrycia modelu luki i techniki jailbrainowe oraz własne Openai To może być obsługiwana obsługa, która może być obsługiwana, co może być obsługiwane afektywne, które mogą być obsługiwane. Stabilność podczas nowych wdrażania. Pytania bezpieczeństwa szybkie wydania

Wewnętrzne napięcia i tło branżowe