Nvidia ogłosiła pakiet narzędzi odpowiadający na rosnące zapotrzebowanie na zaufanie, bezpieczeństwo i niezawodność w agentowych systemach sztucznej inteligencji.

Nowa oferta znana jako Nvidia Inference Microservices (NIM) mają na celu pomóc przedsiębiorstwom we wdrażaniu aplikacji AI zgodnych z wytycznymi dotyczącymi bezpieczeństwa i zapobiegających niezamierzonym skutkom.

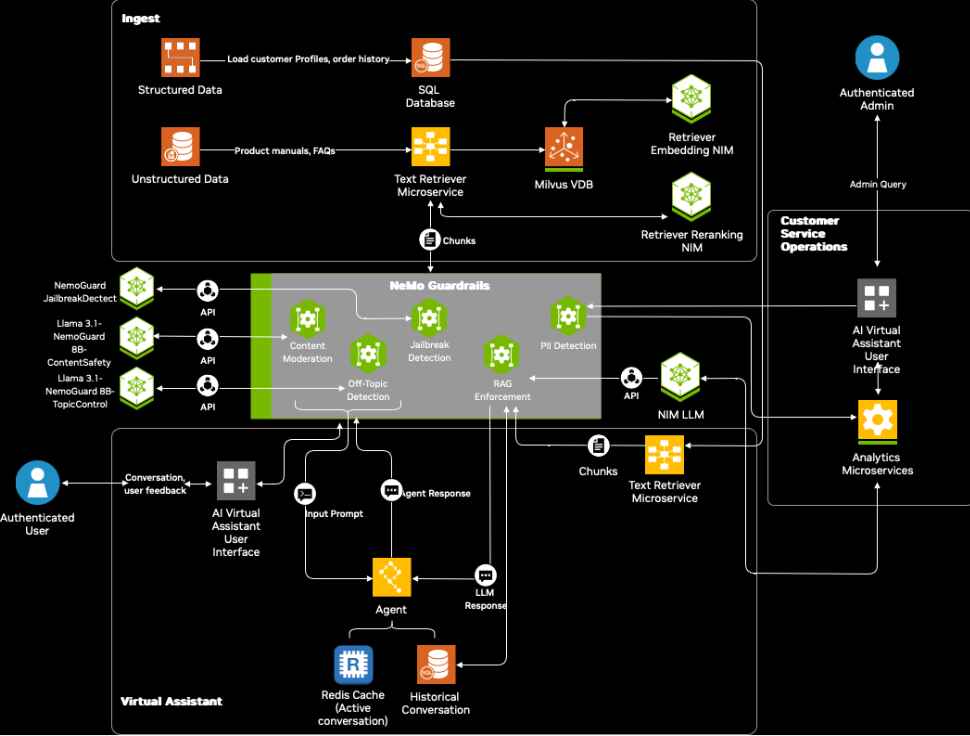

W ramach struktury NeMo Guardrails te mikrousługi zapewniają wyspecjalizowane rozwiązania do moderowania treści, utrzymywania granice konwersacji i wykrywanie prób ominięcia zabezpieczeń.

Kari Briski, wiceprezes ds. korporacyjnych modeli AI w firmie Nvidia, podkreśliła znaczenie zapewnienia bezpieczeństwa sztucznej inteligencji we współczesnych aplikacjach. „Agenci sztucznej inteligencji szybko przekształcają branże, automatyzując interakcje, ale zapewnienie ich bezpieczeństwa i wiarygodności ma kluczowe znaczenie” – stwierdziła w oficjalnym ogłoszeniu.

[treść osadzona]

Sprostanie wyzwaniom związanym z bezpieczeństwem sztucznej inteligencji za pomocą wyspecjalizowanych mikrousług

Agentyczna sztuczna inteligencja, forma sztucznej inteligencji, która samodzielnie wykonuje zadania, jest coraz częściej stosowana w takich branżach, jak handel detaliczny, opieka zdrowotna i motoryzacja

Chociaż systemy te zwiększają wydajność i zaangażowanie klientów, budzą one również obawy dotyczące szkodliwych wyników, prywatności danych i luk w zabezpieczeniach NVIDII mają na celu ograniczenie tego ryzyka za pomocą trzech ukierunkowanych rozwiązań:

Content Safety NIM, przeszkolony w zakresie zastrzeżonego oprogramowania Aegis Content Safety Zbiór danych ma na celu wykrywanie i blokowanie niewłaściwych lub szkodliwych wyników systemów sztucznej inteligencji. Ten zbiór danych, który składa się z ponad 35 000 próbek z adnotacjami ludzkimi, umożliwia modelom skuteczne identyfikowanie toksycznych treści i reagowanie na nie.

Powiązane: NVIDIA rozwija agentyczną sztuczną inteligencję z modelami Lamy i kosmicznych Nemotronów

Nvidia planuje udostępnić publicznie zbiór danych za pośrednictwem Hugging Face jeszcze w tym roku, rozszerzając swoją dostępność dla programistów i badaczy.

The Topic Control NIM gwarantuje, że interakcje generowane przez sztuczną inteligencję pozostają w określonych granicach, zapobiegając dryfowaniu systemów na nieistotne lub nieautoryzowane tematy. To narzędzie jest szczególnie przydatne w scenariuszach obsługi klienta, gdzie niezbędne są spójne i odpowiednie do kontekstu odpowiedzi.

NIM z funkcją Jailbreak Detection rozwiązuje rosnący problem ataków kontradyktoryjnych. Analizując dane wejściowe na podstawie zbioru danych zawierającego 17 000 znanych prób jailbreak, mikrousługa identyfikuje i blokuje złośliwe monity mające na celu obejście zabezpieczeń systemu.

Schemat blokowy zabezpiecz inteligentnych wirtualnych asystentów AI do obsługi klienta za pomocą NeMo Guardrails (Zdj.: Nvidia)

Schemat blokowy zabezpiecz inteligentnych wirtualnych asystentów AI do obsługi klienta za pomocą NeMo Guardrails (Zdj.: Nvidia)

Briski podkreślił skuteczność tych narzędzi, stwierdzając: „Małe modele, takie jak te z kolekcji NeMo Guardrails, zapewniają mniejsze opóźnienia, umożliwiając bezproblemową integrację ze środowiskami o ograniczonych zasobach, takimi jak magazyny czy szpitale”.

Równowaga bezpieczeństwa i wydajności AI

Kluczowym aspektem podejścia Nvidii jest zrównoważenie potrzeby bezpieczeństwa z zapotrzebowaniem na wysoką wydajność. Według Nvidii wczesne testy wskazują, że nowe mikrousługi dodają tylko około pół sekundy opóźnienia, jednocześnie poprawiając środki bezpieczeństwa o 50%.

Powiązane: NVIDIA przedstawia model sztucznej inteligencji Fugatto dla muzyki, głosów i efektów dźwiękowych

Ten poziom optymalizacji rozwiązuje jeden z najczęstszych problemów związanych ze sztuczną inteligencją w przedsiębiorstwach —zapewniając szybki czas reakcji bez narażania bezpieczeństwa.

„W zależności od interakcji użytkownika można utworzyć wiele różnych LLM lub interakcji i trzeba chronić każdą z nich” – powiedziała Kari Briski.

Przykłady zastosowań w przedsiębiorstwach i zastosowanie w branży

Kilka dużych przedsiębiorstw włączyło już NeMo Guardrails do swoich procesów AI, aby zwiększyć bezpieczeństwo i niezawodność, z których korzysta na przykład Lowe’s, sprzedawca artykułów wyposażenia wnętrz te narzędzia poprawiają interakcje z klientami i zapewniają dokładność odpowiedzi generowanych przez sztuczną inteligencję

Cerence AI, lider sztucznej inteligencji w motoryzacji, wykorzystuje mikrousługi do zasilania technologii asystentów samochodowych. „NeMo Guardrails pomaga nam dostarczać wiarygodne, przemyślane i wolne od halucynacji reakcje, zabezpieczając nasze modele przed szkodliwymi skutkami” – wyjaśnił Nils Schanz, wiceprezes wykonawczy ds. produktów i technologii w Cerence AI.

Powiązane: Microsoft ogranicza zamówienia na karty Nvidia GB200, nadając priorytet GB300 w obliczu opóźnień w produkcji

Dodatkowo firmy takie jak Amdocs i Taskus wykorzystują te narzędzia do tworzyć bezpieczniejsze i bardziej niezawodne systemy sztucznej inteligencji umożliwiające zaangażowanie i wsparcie klientów. Amdocs, globalny dostawca oprogramowania dla komunikacji i mediów, wykorzystuje NeMo Guardrails do usprawniania interakcji z klientami opartych na sztucznej inteligencji.

Inicjatywy dotyczące otwartego oprogramowania i szersze implikacje

Aby wesprzeć programistów w testowaniu i zwiększaniu bezpieczeństwa sztucznej inteligencji, Nvidia wprowadziła Garak, zestaw narzędzi typu open source do identyfikacji luki w systemach AI.

Garak symuluje scenariusze kontradyktoryjne, w tym natychmiastowe wstrzyknięcia i próby jailbreakowania, umożliwiając organizacjom wzmacnianie swoich modeli sztucznej inteligencji potencjalne zagrożenia.

Programiści mogą również uzyskać dostęp do szczegółowe samouczki i projekty referencyjne usprawniające wdrażanie poręczy NeMo i mikrousługi. Zasoby te dotyczą różnych przypadków użycia, od chatbotów obsługi klienta po automatycznych asystentów w placówkach handlu detalicznego i opieki zdrowotnej.