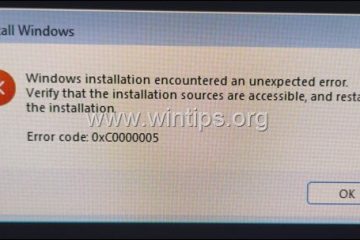

OpenAI odebrało dostęp do interfejsu API programiście, który wykorzystał interfejs API Realtime do zasilania autonomicznego systemu karabinowego. Projekt, który obejmował zrobotyzowaną wieżę wyposażoną w karabin, mógł interpretować polecenia słowne i wykonywać symulowane akcje strzelania.

Incydent uwydatnia rosnące obawy dotyczące potencjalnego niewłaściwego wykorzystania sztucznej inteligencji przy opracowywaniu broni autonomicznej, co rodzi pytania dotyczące etyki sztucznej inteligencji i jej bezpieczeństwa.

Programista znany w Internecie jako „STS Innovations LLC” udostępnił w Internecie filmy przedstawiające system, demonstrując jego funkcjonalność. W jednym klipie programista wydał polecenie: „ChatGPT, jesteśmy pod kontrolą atak z przodu i z lewej strony w prawo”, na co wieża natychmiast zareagowała, obracając się i strzelając ślepakami w określonych kierunkach.

Symulacja celowania/strzelania za pomocą lasera #robotics #elektronika

Zsyntetyzowany głos dodał: „Jeśli potrzebujesz dalszej pomocy, po prostu daj mi znać”. Ta mrożąca krew w żyłach demonstracja pokazała, jak narzędzia sztucznej inteligencji klasy konsumenckiej można łatwo dostosować do potencjalnie szkodliwych zastosowań.

Aktualizacja systemu śledzenia #robotyka #wizja #elektronika

Szybkie egzekwowanie zasad OpenAI

OpenAI, znane ze swoich rygorystycznych zasad zakazujących korzystania z jego technologii w zakresie uzbrojenia, zareagowały natychmiast. Rzecznik powiedział firmie Futurism: „Proaktywnie zidentyfikowaliśmy to naruszenie naszych zasad i powiadomiliśmy dewelopera do zaprzestania tej działalności przed otrzymaniem Twojego zapytania.”

Firma podkreśliła swój zakaz używania swoich narzędzi do tworzenia lub obsługi broni lub systemów automatyzacji, które mogłyby stwarzać ryzyko dla bezpieczeństwa osobistego.

System zarządzania odrzutem, szybkie demo #robotics #elektronika #cnc

Realtime API, narzędzie przeznaczone do interaktywne aplikacje umożliwiły programiście przekształcenie poleceń w języku naturalnym w praktyczne dane wejściowe dla automatycznej wieży.

Chociaż interfejs API jest przeznaczony do korzystnych zastosowań, takich jak zwiększanie dostępności lub ulepszanie interakcji z klientami, to niewłaściwe użycie pokazuje wyzwania związane z regulacją technologii podwójnego zastosowania.

Powiązane: Partnerstwo OpenAI i Anduril Forge na rzecz amerykańskiej wojskowej obrony przed dronami

Szersze implikacje dla sztucznej inteligencji i uzbrojenia

Sprawa została wznowiona debaty na temat etyki broni autonomicznej. Systemy te, zdolne do wybierania i atakowania celów bez nadzoru człowieka, stwarzają złożone wyzwania prawne i moralne.

Organizacja Narodów Zjednoczonych od dawna opowiada się za bardziej rygorystycznymi przepisami dotyczącymi sztucznej inteligencji podczas działań wojennych, ostrzegając, że systemy autonomiczne mogą naruszać prawo międzynarodowe i zmniejszać odpowiedzialność.

Powiązane: Anthropic Współpracują z Palantir, AWS na rzecz sztucznej inteligencji w amerykańskim wywiadzie i wojsku

Niedawny raport Washington Post szczegółowe niepokojące przykłady rozmieszczenia sztucznej inteligencji w wojsku operacji, w tym twierdzeń, że Izrael używał sztucznej inteligencji do wybierania celów bombardowań.

W raporcie zauważono, że „w niektórych momentach jedynym wymaganym potwierdzeniem było to, że celem był mężczyzna”. Takie przypadki uwydatniają ryzyko polegania na sztucznej inteligencji przy podejmowaniu decyzji dotyczących życia lub śmierci oraz możliwość masowego podejmowania decyzji przemoc.

Powiązane: Zielony Beret użył ChatGPT do wybuchu Cybertruck, policja publikuje dzienniki rozmów

Rola OpenAI w obronie Technologie

Chociaż OpenAI egzekwuje zasady zakazujące stosowania broni, jego partnerstwo z Anduril Industries — firmą specjalizującą się w rozwiązaniach obronnych opartych na sztucznej inteligencji — rodzi pytania dotyczące jej stanowiska

Współpraca ma na celu ulepszenie wywiadu pola bitwy i ulepszenie systemów obrony przed dronami. OpenAI opisuje te wysiłki jako defensywne, ale krytycy twierdzą, że przyczyniają się one do szerszej militaryzacji technologii sztucznej inteligencji.

Amerykański sektor obronny, wspierany przez z rocznym budżetem bliskim 1 biliona dolarów w coraz większym stopniu opiera się na zaawansowanych technologiach w celu uzyskania strategicznej przewagi. To rosnące połączenie firm zajmujących się sztuczną inteligencją i zastosowaniami wojskowymi uwypukla wyzwania związane z zrównoważeniem innowacji technologicznych ze względami etycznymi.

Powiązane: Nowe konsorcjum AI Palantir-Anduril w celu usunięcia luk w danych dotyczących obronności USA

Zagrożenia związane z bronią i dostępnością typu „zrób to sam”

Łatwość, z jaką pojedyncze osoby mogą niewłaściwe wykorzystanie narzędzi sztucznej inteligencji i innych technologii, takich jak druk 3D, pogłębia problem. Organy ścigania zetknęły się już z przypadkami samodzielnego wytwarzania broni, takimi jak rzekome działania Luigiego Mangione, który podobno używał części wydrukowanych w 3D do montażu broni palnej. Technologie te zmniejszają bariery dla jednostek w tworzeniu autonomicznych systemów o śmiercionośnym potencjale.

Projekt STS 3D pokazuje, jak dostępne narzędzia sztucznej inteligencji można dostosować do niezamierzonych celów. Zdecydowane działanie OpenAI w tym przypadku pokazuje jej zaangażowanie w zapobieganie nadużyciom, ale podkreśla także trudność w pełnej kontroli sposobu wdrażania jej technologii po wejściu do domeny publicznej.

Incydent rodzi szersze pytania dotyczące zarządzania Technologie sztucznej inteligencji. Zwolennicy regulacji podkreślają potrzebę jasnych światowych standardów zapewniających zgodność rozwoju sztucznej inteligencji z zasadami etycznymi. Jednak osiągnięcie konsensusu między narodami o różnych interesach i priorytetach pozostaje trudnym zadaniem.