OpenAI rozszerzyło swoją ofertę dla programistów, udostępniając pełną wersję swojego modelu o1 za pośrednictwem interfejsu API. Ten zaawansowany model wnioskowania, który doskonale radzi sobie ze złożonymi, wieloetapowymi zadaniami, wprowadza nowe funkcje, które mogą zmienić sposób, w jaki programiści tworzą aplikacje oparte na sztucznej inteligencji.

Aktualizacja jest częścią serii ogłoszeń „12 dni OpenAI”, podczas których firma udostępnia nowe funkcje i aktualizacje swoich głównych produktów.

Oprócz modelu o1, OpenAI ma ogłosił także ulepszenia interfejsu API Realtime do interakcji głosowych i nową metodę dostrajania preferencji, zapewniając programistom niespotykaną dotąd elastyczność.

Model o1-2024-12-17 zastępuje wprowadzoną na początku tego roku wersję o1-preview. Według OpenAI zaktualizowany model oferuje „bardziej wszechstronne i dokładnych odpowiedzi, zwłaszcza na pytania dotyczące programowania i biznesu, i jest mniej prawdopodobne, że błędnie odrzuci prośby”.

Te ulepszenia w połączeniu z 60% redukcją użycia tokenów wnioskowania sprawiają, że model o1 jest szybszy, wydajniejszy i bardziej wszechstronny.

[treść osadzona]

Udoskonalanie rozumowania poprzez API z modelem o1

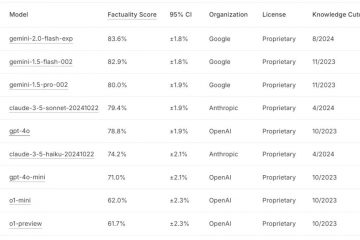

Model o1 OpenAI został zaprojektowany do rozwiązywania zadań wymagających spójności logicznej i głębi analitycznej, przewyższając poprzednie iteracje w testach porównawczych, takich jak SWE-Bench Verified i AIME.

OpenAI podaje, że dokładność zadań programistycznych wzrosła z 52,3% do 76,6%, podczas gdy wydajność rozwiązywania problemów matematycznych wzrosła z 42% do prawie 80%.

Źródło: OpenAI

Jedną z wyróżniających się funkcji jest obsługa ustrukturyzowanych wyników, umożliwiająca programistom generowanie odpowiedzi w predefiniowanych formatach, takich jak JSON.

Zapewnia to bezproblemową integrację z systemami zewnętrznymi, takimi jak interfejsy API i bazy danych, dzięki czemu model idealnie nadaje się do zastosowań w obsłudze klienta, logistyce i analizie danych.

Model wprowadza również możliwości wnioskowania wizualnego, umożliwiając analizę obrazów do zadań takich jak debugowanie lub badania naukowe. Na przykład programiści mogą teraz wprowadzać dane wizualne, takie jak zeskanowane dokumenty lub plany, i otrzymywać odpowiedzi zależne od kontekstu.

Dodatkowo nowy parametr „wysiłek rozumowania” pozwala programistom kontrolować czas, jaki model spędza na każdym zadaniu, równoważąc precyzję i wydajność.

OpenAI wyjaśniło na swoim blogu: „Wprowadzamy zmiany stopniowo ograniczaj dostęp, jednocześnie pracując nad rozszerzeniem dostępu do dodatkowych poziomów użytkowania i zwiększeniem limitów szybkości.”

Ulepszanie interakcji głosowych za pomocą interfejsu API w czasie rzeczywistym

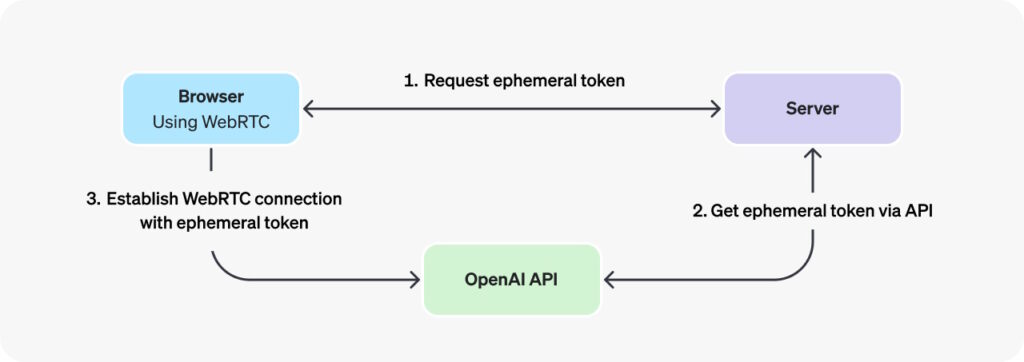

OpenAI również wniosło znaczący wkład aktualizacje interfejsu API Realtime, który umożliwia interakcje głosowe w czasie rzeczywistym. Dodanie WebRTC, Web Real-Time Communication — protokołu komunikacji o niskim opóźnieniu — umożliwia programistom tworzenie płynnych aplikacji głosowych dla wirtualnych nauczycieli, asystentów i narzędzi tłumaczeniowych. Umożliwia połączenia peer-to-peer (P2P) bez konieczności stosowania dodatkowych wtyczek lub oprogramowania.

OpenAI podkreśliło zalety WebRTC, stwierdzenie: „W scenariuszach, w których chcesz połączyć się z modelem Realtime z niezabezpieczonego klienta przez sieć (np. przeglądarkę internetową), zalecamy użycie połączenia WebRTC metoda. WebRTC jest lepiej przygotowany do obsługi zmiennych stanów połączenia i zapewnia szereg wygodnych interfejsów API do przechwytywania danych wejściowych audio użytkownika i odtwarzania zdalnych strumieni audio z modelu.“

Implementacja WebRTC wykorzystuje tak zwane tokeny efemeryczne, tymczasowe klucze API zaprojektowane specjalnie do bezpiecznego uwierzytelniania aplikacji po stronie klienta podczas łączenia się z interfejsem API OpenAI Realtime przez WebRTC. Ich celem jest zapewnienie bezpiecznego, krótkotrwałego mechanizmu uwierzytelniania, który pozwala uniknąć ujawniania wrażliwych standardowych kluczy API bezpośrednio w środowiskach klienckich, takich jak przeglądarki internetowe.

Obraz: OpenAI

Obraz: OpenAI

Aktualizacje API Realtime uprościć proces programowania, redukując kod wymagany dla aplikacji głosowych, jednocześnie poprawiając jakość dźwięku i dokładność odpowiedzi. Programiści mogą teraz tworzyć aplikacje, które rozpoczynają formułowanie odpowiedzi, gdy użytkownicy jeszcze mówią, co poprawia czas reakcji.

Dostosowanie cen sprawia, że aplikacje głosowe są bardziej dostępne. Koszt tokenów audio GPT-4o został obniżony o 60%, podczas gdy tokeny wejściowe buforowane są teraz o 87,5% tańsze. OpenAI wprowadziło także GPT-4o mini, opłacalną opcję dla programistów poszukujących niedrogich alternatyw, wycenioną na 10 dolarów za milion tokenów wejściowych.

Udoskonalanie zachowania AI dzięki dostrajaniu preferencji

Dostrajanie preferencji to nowa metoda dostosowywania, która umożliwia programistom udoskonalanie zachowania modelu w oparciu o sparowane porównania odpowiedzi. W przeciwieństwie do tradycyjnego dostrajania, które opiera się na dokładnych parach wejście-wyjście, dostrajanie preferencji uczy model rozróżniania pomiędzy preferowanymi i mniej pożądanymi reakcjami.

OpenAI opisuje tę metodę jako szczególnie skuteczną w przypadku zadań subiektywnych, takich jak jako dostosowanie tonu i stylu twórczego pisania lub zapewnienie zgodności z określonymi wymaganiami dotyczącymi formatowania. Według OpenAI pierwsi użytkownicy, tacy jak firma zajmująca się analityką finansową, zgłosili, że dostrajanie preferencji poprawiło dokładność odpowiedzi o 5% w przypadku złożonych zapytań spoza dystrybucji.

„Zaczęliśmy testować dostrajanie preferencji od zaufanym partnerom, którzy jak dotąd zaobserwowali obiecujące wyniki. Na przykład Rogo AI(otwiera się w nowym oknie) tworzy asystenta AI dla analityków finansowych, który dzieli złożone zapytania na podzapytania.

Korzystając z opracowanego przez ekspertów testu porównawczego Rogo-Golden, odkryli, że podczas gdy dział Supervised Fine-Tuning borykał się z wyzwaniami związanymi z rozszerzaniem zapytań poza dystrybucją – takimi jak brakujące wskaźniki, takie jak ARR, w przypadku zapytań typu „jak szybko jest firma X rośnie” — funkcja Preference Fine-Tuning rozwiązała te problemy, poprawiając wydajność z 75% dokładności w modelu podstawowym do ponad 80%.”

Rozszerzanie opcji SDK dla Programiści

Aby obsługiwać szerszą gamę środowisk programistycznych, OpenAI wprowadziło także oficjalne pakiety SDK dla Idź i Java, obok niejistniejące biblioteki dla Pythona, Node.js i.NET. Te zestawy SDK upraszczają integrację, umożliwiając programistom wdrażanie modeli AI w skalowalnych systemy zaplecza lub aplikacje korporacyjne.

Go SDK jest przeznaczony do lekkich i wydajnych aplikacji po stronie serwera, podczas gdy Java SDK obsługuje rozwiązania klasy korporacyjnej, oferując mocne pisanie i solidną obsługę projektów na dużą skalę. Dokumentacja OpenAI zawiera szczegółowe wskazówki dotyczące wykorzystania tych nowych narzędzi.

Poprzednie ogłoszenia podczas „12 dni OpenAI”

16 grudnia OpenAI udostępniło ChatGPT funkcja wyszukiwania w Internecie na żywo dostępna dla wszystkich użytkowników, umożliwiająca każdemu pobieranie aktualnych informacji bezpośrednio z Internetu.

14 grudnia wprowadził nowe opcje dostosowywania do ChatGPT, umożliwiając użytkownikom usprawniaj zadania i skutecznie zarządzaj projektami. Aplikacja Projects umożliwia użytkownikom grupowanie czatów, plików i niestandardowych instrukcji w dedykowanych folderach, tworząc zorganizowaną przestrzeń roboczą do zarządzania zadaniami i przepływami pracy.

Jest to ogromne ulepszenie zaawansowanego trybu głosowego dla aplikacji. 12 grudnia ChatGPT, OpenAI dodało funkcje wizyjne, umożliwiając użytkownikom udostępnianie wideo na żywo i ekranów w celu analizy i pomocy w czasie rzeczywistym.

11 grudnia OpenAI w pełni udostępniło Canvas, wspólny obszar roboczy do edycji, który oferuje zaawansowane narzędzia do udoskonalania tekstu i kodu, wprowadzone początkowo w wersji beta w październiku 2024 r., Canvas zastępuje standardowy interfejs ChatGPT projektem z podzielonym ekranem, umożliwiając użytkownikom pracę nad tekstem lub kodem podczas wymiany konwersacyjnej z sztuczną inteligencją.

Dodanie wykonywania języka Python to wyjątkowa funkcja Canvas, umożliwiająca programistom pisanie, testowanie i debugowanie skryptów bezpośrednio na platformie. OpenAI zademonstrowało swoją użyteczność podczas wydarzenia na żywo, używając języka Python do generowania i udoskonalania wizualizacji danych. OpenAI opisało tę funkcję jako „zmniejszanie tarcia między generowaniem pomysłu a jego wdrożeniem”.

9 grudnia OpenAI oficjalnie uruchomiło Sora, swoje zaawansowane narzędzie AI do generowania filmów na podstawie podpowiedzi tekstowych, sygnalizując nową erę kreatywnej sztucznej inteligencji. Zintegrowana z płatnymi kontami ChatGPT, Sora umożliwia użytkownikom animowanie nieruchomych obrazów, rozszerzanie istniejących filmów i łączenie scen w spójną narrację.

Wydano 7 grudnia wydanie Reinforcement Fine-Tuning jako nowa platforma zaprojektowana w celu umożliwienia dostosowywania modeli sztucznej inteligencji do zastosowań specyficznych dla branży. Jest to najnowsze podejście OpenAI do ulepszania modeli sztucznej inteligencji poprzez uczenie ich za pomocą zbiorów danych dostarczonych przez programistów i systemów oceniania, w przeciwieństwie do tradycyjnego uczenia się pod nadzorem, które koncentruje się na replikowanie pożądanych wyników

5 grudnia OpenAI zaprezentowało ChatGPT Pro, nowy poziom subskrypcji premium w cenie 200 USD miesięcznie, skierowany do profesjonalistów i przedsiębiorstw poszukujących zaawansowanych możliwości sztucznej inteligencji do przepływy pracy o wysokich wymaganiach.