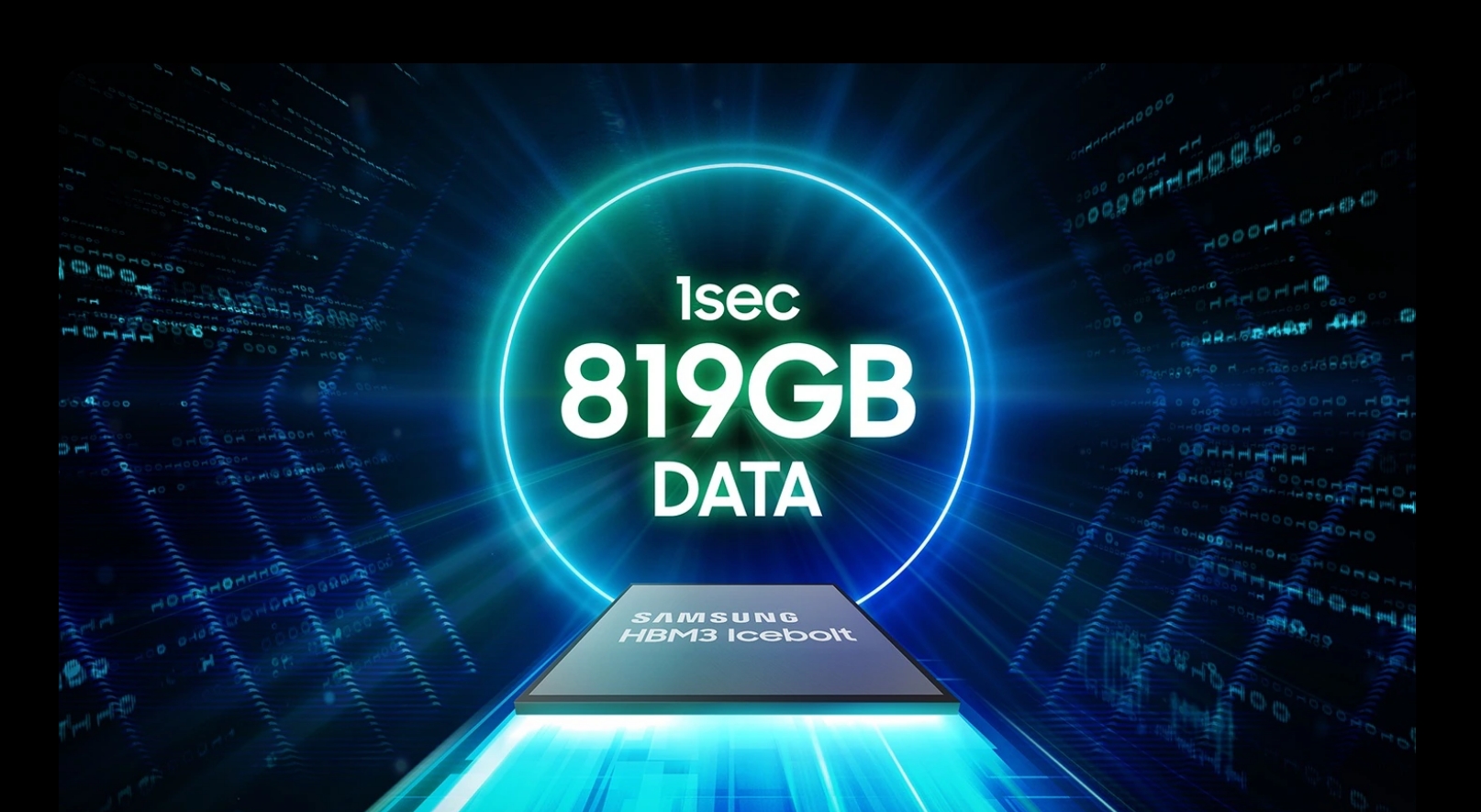

Chipy DRAM HBM3 firmy Samsung, zaprojektowane do użytku w akceleratorach AI firmy Nvidia, napotkały problemy z wydajnością podczas testowanie. Główne obawy dotyczą nadmiernego wytwarzania ciepła i dużego zużycia energii, co wzbudziło wątpliwości co do ich przydatności do potrzeb firmy Nvidia w zakresie obliczeń o wysokiej wydajności. HBM oznacza pamięć o dużej przepustowości i wykorzystuje konstrukcję chipa, która zapewnia większą przepustowość niż moduły DDR4 lub GDDR5, zużywając przy tym mniej energii i w znacznie mniejszej obudowie. Osiąga się to poprzez połączenie maksymalnie ośmiu DRAM matryce i opcjonalną matrycę podstawową, która może zawierać obwody buforowe i logikę testową.

Obawy dotyczące zużycia ciepła i energii

Zgłaszane problemy ze zużyciem ciepła i energii nie dotyczą samych chipów HBM3. Podobne problemy występują także w chipach HBM3E firmy Samsung, które zostały zaprezentowane kilka miesięcy temu. Problemy te stały się oczywiste, gdy w kwietniu 2024 r. opublikowano wyniki badań 8-warstwowych i 12-warstwowych chipów HBM3E firmy Samsung.

Z kolei SK Hynix rozpoczęło dostarczanie chipów HBM3E firmie Nvidia w marcu 2024 r., pozycjonując się jako kluczowym graczem na rynku HBM. SK Hynix jest obecnie największym dostawcą dla Nvidii chipów HBM, które są niezbędne do funkcjonowania akceleratorów AI. Dominacja Nvidii na rynku sztucznej inteligencji (80% udziału) sprawia, że jej certyfikacja jest kluczowa dla każdego producenta chipów HBM.

Wysiłki optymalizacyjne firmy Samsung

Samsung uznał potrzebę optymalizacji w połączeniu z wymaganiami klientów. Firma blisko współpracuje z klientami, aby rozwiązać te problemy i od ponad roku stara się przejść rygorystyczne testy Nvidii. Niedawne zmiany na kierownictwie firmy Samsung, w tym mianowanie byłego eksperta w dziedzinie rozwoju pamięci DRAM i NAND flash, podkreślają jej zaangażowanie w rozwiązywanie tych wyzwań.

Certyfikat wydany przez firmę Nvidia ma kluczowe znaczenie dla ambicji firmy Samsung na rynku HBM. Nierozwiązane problemy związane ze zużyciem ciepła i energii rzuciły cień na perspektywy Samsunga. Nie ma pewności, czy problemy te uda się szybko rozwiązać. Poparcie dyrektora generalnego Nvidii, Jensena Huanga dla chipa pamięci HBM3E 12H (12-warstwowego) firmy Samsung na konferencji GTX AI 2024, gdzie napisał on na chipie „Jensen Approved”, podkreśla znaczenie tego partnerstwa.

Zdolność Samsunga do przezwyciężenia tych wyzwań ma kluczowe znaczenie nie tylko dla jego działalności, ale także dla szerszej branży. Zarówno AMD, jak i Nvidia pragną, aby Samsung rozwiązał te problemy, aby zapewnić stabilne dostawy chipów HBM od wielu dostawców, co pomogłoby utrzymać konkurencyjne ceny. Samsung dostarcza już chipy HBM firmie AMD, co jeszcze bardziej podkreśla potrzebę niezawodnych i wydajnych rozwiązań pamięciowych.

Samsung zamierza rozpocząć masową produkcję chipów HBM3E przed końcem drugiego kwartału roku wysiłki mające na celu optymalizację chipów HBM we współpracy z klientami odzwierciedlają determinację firmy w zapewnieniu sobie oparcia na konkurencyjnym rynku sprzętu AI. Wynik tych wysiłków będzie miał znaczący wpływ na przyszły krajobraz akceleratorów AI i obliczeń o wysokiej wydajności.