niedawne ujawnienie MLPerf Inference v3.1 przyniosło nowe standardy dla dużych Modele językowe (LLM) i rekomendacje oznaczające znaczący postęp w testowaniu sztucznej inteligencji. Testy porównawcze MLPerf — opracowane przez MLCommons, konsorcjum akademickich liderów AI, laboratoria badawcze i całą branżę — mają na celu zapewnienie bezstronnej oceny wydajność szkoleń i wnioskowania w zakresie sprzętu, oprogramowania i usług.

W nowej wersji zaobserwowano bezprecedensowy poziom uczestnictwa, z ponad 13 500 wynikami wydajności, co oznacza wzrost wydajności aż do 40%. Różnorodność udziału jest widoczna w przypadku 26 różnych zgłaszających, w tym największych firm technologicznych, takich jak Google, Intel i NVIDIA, a także uczestników po raz pierwszy, takich jak Connect Tech, Nutanix, Oracle i TTA.

David Kanter, dyrektor wykonawczy MLCommons, podkreślił znaczenie tego wkładu, stwierdzając: „Przesłanie zgłoszenia do MLPerf nie jest trywialne… Wymaga prawdziwej pracy inżynieryjnej i jest świadectwem do zaangażowania naszych zgłaszających w sztuczną inteligencję, ich klientów i ML.”

@MLCommons, właśnie udostępniliśmy! Nowość @MLPerf Wyniki wnioskowania i przechowywania. Rekordowy udział w MLPerf Inference v3.1 i pierwsze wyniki MLPerf Storage v0.5 podkreślają rosnące znaczenie GenAI i przechowywanie. Zobacz wszystkie wyniki i dowiedz się więcej https://t.co/7eycrrmOdw

— MLCommons (@ MLCommons) 11 września 2023 r.

Wyniki testów porównawczych

Głównym celem wnioskowania MLPerf jest zmierzenie szybkości, z jaką systemy AI mogą uruchamiać modele w różnych scenariuszach wdrażania. Obejmują one zaawansowane chatboty generujące sztuczną inteligencję, a także funkcje bezpieczeństwa pojazdów, takie jak automatyczne utrzymywanie pasa ruchu i interfejsy zamiany mowy na tekst. W tej wersji nacisk położony jest na wprowadzenie dwóch punktów odniesienia:

LLM wykorzystujący model referencyjny GPT-J do podsumowywania artykułów informacyjnych CNN, odzwierciedlający szybkie przyjęcie generatywnej sztucznej inteligencji u 15 uczestników. Zaktualizowany test porównawczy rekomendacji, bardziej zgodny ze standardami branżowymi, wykorzystujący model referencyjny DLRM-DCNv2 i większe zbiory danych, otrzymał dziewięć zgłoszeń.

Wyniki MLPerf Inference v3.1 i MLPerf Storage v0.5 są interesujące i obejmują:

Wyniki: jak szybko system może wygenerować dane wejściowe z wyuczonego modelu.

Dominacja NVIDIA i bliski pościg Intela

Zaawansowane chipy NVIDIA okazały się głównymi pretendentami w testach na modelu wielojęzycznym, a sprzęt Intela tuż za nimi. Firma MLCommons, znana z neutralnych testów porównawczych wydajności chipsetów AI, ogłosiła wyniki swoich nowych testów porównawczych MLPerf Inference 3.1.

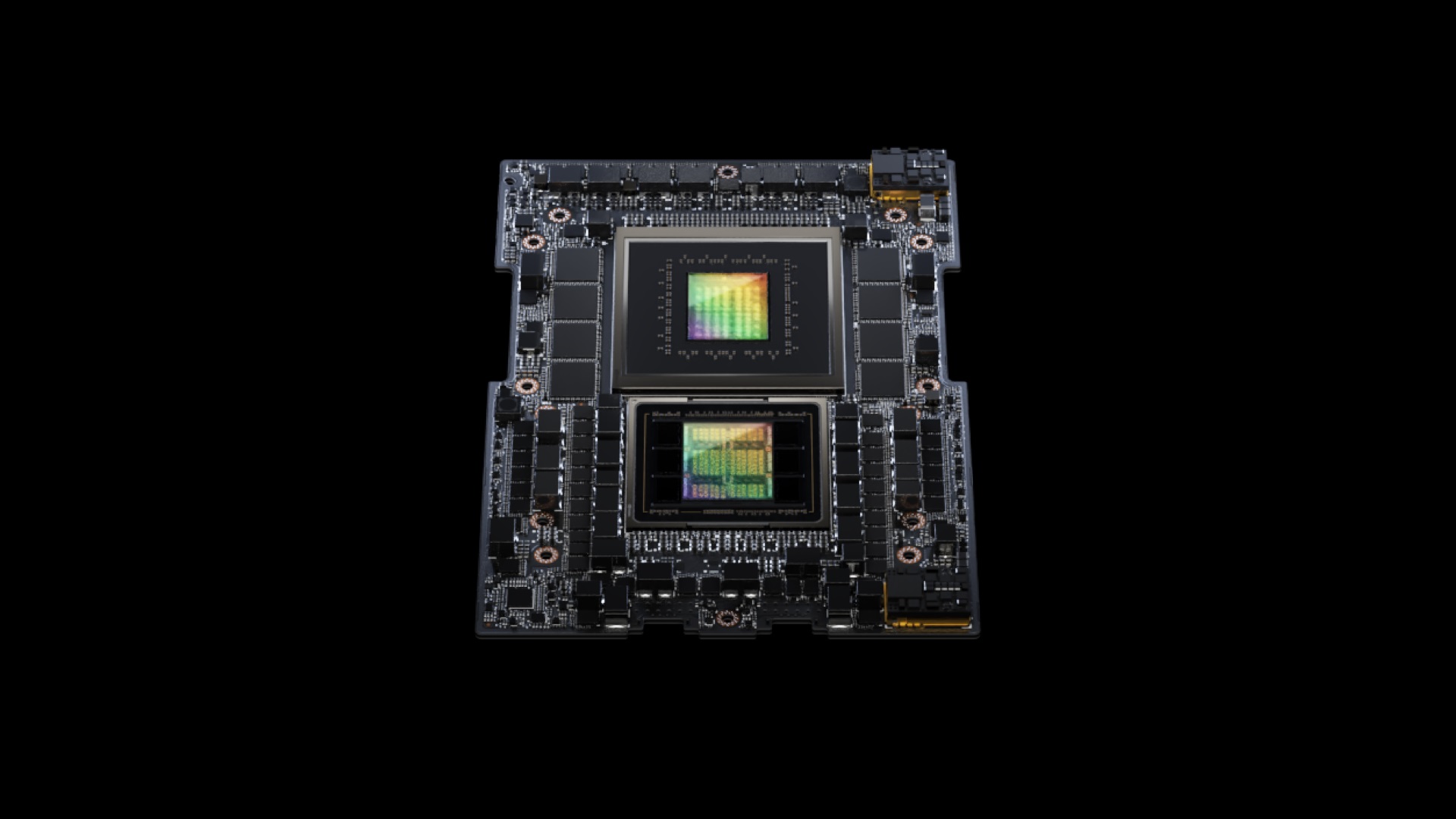

NVIDIA zaprezentowała swój GH200 Grace Hopper Superchip, który łączy jednostkę przetwarzania graficznego Hopper z jednostką centralną Grace, oferując zwiększoną pamięć, przepustowość i możliwości przenoszenia zadań pomiędzy GPU i procesor oparty na ARM. Ten chipset był lepszy od systemu HGX 100 firmy NVIDIA o około 17%. Jednak akceleratory akceleratory Intel Habana Gaudi2 nie pozostały daleko w tyle, wykazując opóźnienie w wydajności wynoszące zaledwie 10% w porównaniu z systemami NVIDIA.

W tym tygodniu Nvidia ogłosiła nową aktualizację oprogramowania, która skutecznie podwaja wydajność procesora graficznego H100 AI. Nowe oprogramowanie firmy TensorRT-LLM o otwartym kodzie źródłowym, którego premiera zaplanowana jest na nadchodzące tygodnie, wykazało znaczny wzrost wydajności.

W testy z użyciem modelu GPT-J 6B, zaktualizowany system wykazał ośmiokrotną poprawę wydajności w porównaniu z A100, co stanowi znaczący skok w porównaniu z poprzednią czterokrotną przewagą. Co więcej, w ocenie na platformie Llama2 LLM firmy Meta, H100 wzmocnione TensorRT-LLM przewyższyły A100 4,6 razy, co stanowi wyraźną poprawę w porównaniu z 2,6-krotnością przed aktualizacją.