Anthropic kunngjorde torsdag at de utvider Claude-chatbotens vedvarende minnefunksjon til alle betalte abonnenter, og intensiverer konkurransen med rivalene OpenAI og Google.

Fra og med 23. oktober ruller oppgraderingen ut til Pro-og Max-brukere, og utvider et verktøy som tidligere var eksklusivt for bedriftskunder som lar AI-en automatisk huske konteksten fra tidligere samtaler. I

i et strategisk grep for å oppmuntre til brukermigrering, lanserte Anthropic også en ny funksjon for import og eksport av minner, som direkte adresserer bekymringer om plattformlåsing og posisjonerer Claude som et mer åpent alternativ i det overfylte AI-markedet.

Fra Enterprise Exclusive til alle abonnenter

Anthropic utvider seg utover det opprinnelige bedriftsfokuset, og gjør nå sin vedvarende minnefunksjon for alle betalinger til en standard kunder.

Oppdateringen, som begynte å rulle ut til Claude Max-abonnenter umiddelbart og vil nå Pro-brukere i løpet av de kommende dagene, markerer en betydelig utvidelse av verktøyet.

Tidligere var denne automatiske tilbakekallingsmuligheten begrenset til brukere på Team-og Enterprise-planene siden lanseringen i september.

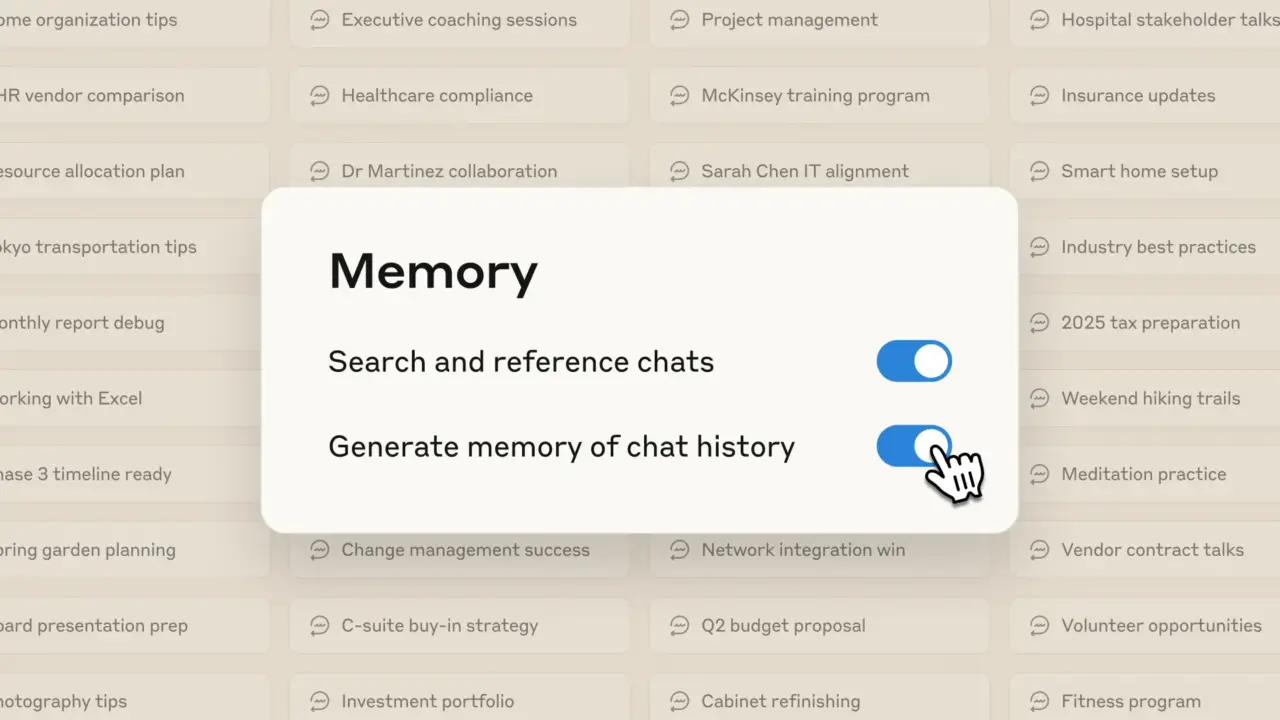

Funksjonens utviklingstilnærming fremhever deliberate, phase’s anthropic. Det dukket først opp i august som et manuelt, brukerinitiert tilbakekallingssystem der AI bare ville søke i tidligere chatter når det ble eksplisitt bedt om det.

Den gangen la antropiske talsperson Ryan Donegan vekt på systemets kontrollerte natur, og sa:”Claude vil bare hente og referere dine tidligere chatter når du ber det om det, og det bygger ikke en brukerprofil på,

vedvarende hukommelse som aktivt lærer av interaksjoner, et avgjørende skritt for å gjøre chatboten til en mer effektiv langsiktig samarbeidspartner.

Dette skiftet fra et manuelt søkeverktøy til en automatisk tilbakekallingsmotor tar for seg et viktig produktivitetsproblem for de som er engasjert i komplekse prosjekter med flere økter, noe som gir mulighet for en mer sømløs og intelligent arbeidsflyt.

Som en direkte utfordring til konkurrentenes inngjerdede hager, introduserer den nye oppdateringen også en kraftig import-og eksportfunksjon.

Brukere kan nå bringe samtalehistoriene sine fra andre AI-assistenter, som ChatGPT eller Gemini, inn i Claude ved å kopiere og lime inn teksten, i henhold til offisiell dokumentasjon.

Omvendt kan de eksportere hele Claude-minnet sitt når som helst, for å sikre at leverandøren deres er portabel og at dataforblir lock-in.

Dette trekket er et strategisk spill for å senke barrieren for brukere som vurderer å bytte fra etablerte rivaler.

Det er en smart måte å redusere friksjon på og motvirker direkte”klebrigheten”som konkurrentene har bygget gjennom sitt eget minne.

Med brukerens personvern som kjerneprinsippet i strategien, sørger Anthropic for at brukeren har kontroll over

. stresser målet er «fullstendig åpenhet», slik at brukere kan se, redigere eller slette spesifikke minner gjennom naturlig samtale, en nøkkelfunksjon som er fremhevet i kunngjøringen.

For å forhindre at konteksten blør mellom ulike oppgaver, oppretter Claude distinkte, isolerte minneplasser for hvert «Prosjekt».

Denne granulære kontrollen gjør det mulig å opprettholde et separat prosjekt uten personlig kontekst. overlapp. Hele funksjonen er valgfri og kan deaktiveres når som helst.

Å komme etter i AI Memory Arms Race

Anthropics lansering er en kritisk, om enn noe forsinket, inngang til AI Memory Arms Race. Evnen til å huske kontekst på tvers av økter er en nøkkeldriver for brukerlojalitet, og alle større spillere har nå en eierandel i spillet.

OpenAI begynte å rulle ut en lignende funksjon for ChatGPT Plus-brukere tilbake i mai 2024, og Google la til minne for krysschat til Gemini-assistenten sin i februar. Selv Elon Musks xAI ble med i kampen, og la til minne til Grok-chatboten sin i april.

Ved å gjøre minnefunksjonen robust og allment tilgjengelig, utjevner Anthropic spillefeltet på en nøkkelfunksjon, samtidig som de dobler ned på sine kjernedifferensiatorer.

Selskapet har utsatt funksjonen for omfattende sikkerhetstesting, spesielt for å forhindre skadelig eller gjenvinnende skade. mønstre.

Denne forsiktige, sikkerhet først tilnærmingen er et kjennetegn på Anthropics strategi, som tar sikte på å bygge tillit med en profesjonell brukerbase som verdsetter pålitelighet og forutsigbarhet.

Den bredere visjonen strekker seg utover enkel prosjektkontinuitet. Mike Krieger, Anthropics Chief Product Officer, sa:”Vi bygger mot at Claude forstår hele arbeidskonteksten din og tilpasser seg automatisk. Minnet starter med prosjektkontinuitet, men det handler egentlig om å skape vedvarende tenkepartnerskap som utvikler seg over uker og måneder.”

Denne ambisjonen støttes av en fleksibel prisstruktur for de mest avanserte brukerne. Claude Max-planen tilbyr to nivåer: et «Utvidet bruk»-alternativ til $100 per måned for fem ganger bruken av Pro-nivået, og et «Maksimal fleksibilitet»-alternativ til $200 per måned for tjue ganger så mange brukere som brukerne. interaksjoner med AI.

Når markedet for personlig tilpassede AI-assistenter modnes, satser Anthropic på at blandingen av avansert kapasitet og gjennomsiktig brukerkontroll vil gi gjenklang hos bedrifter som leter etter en pålitelig, trygg og kraftig partner.