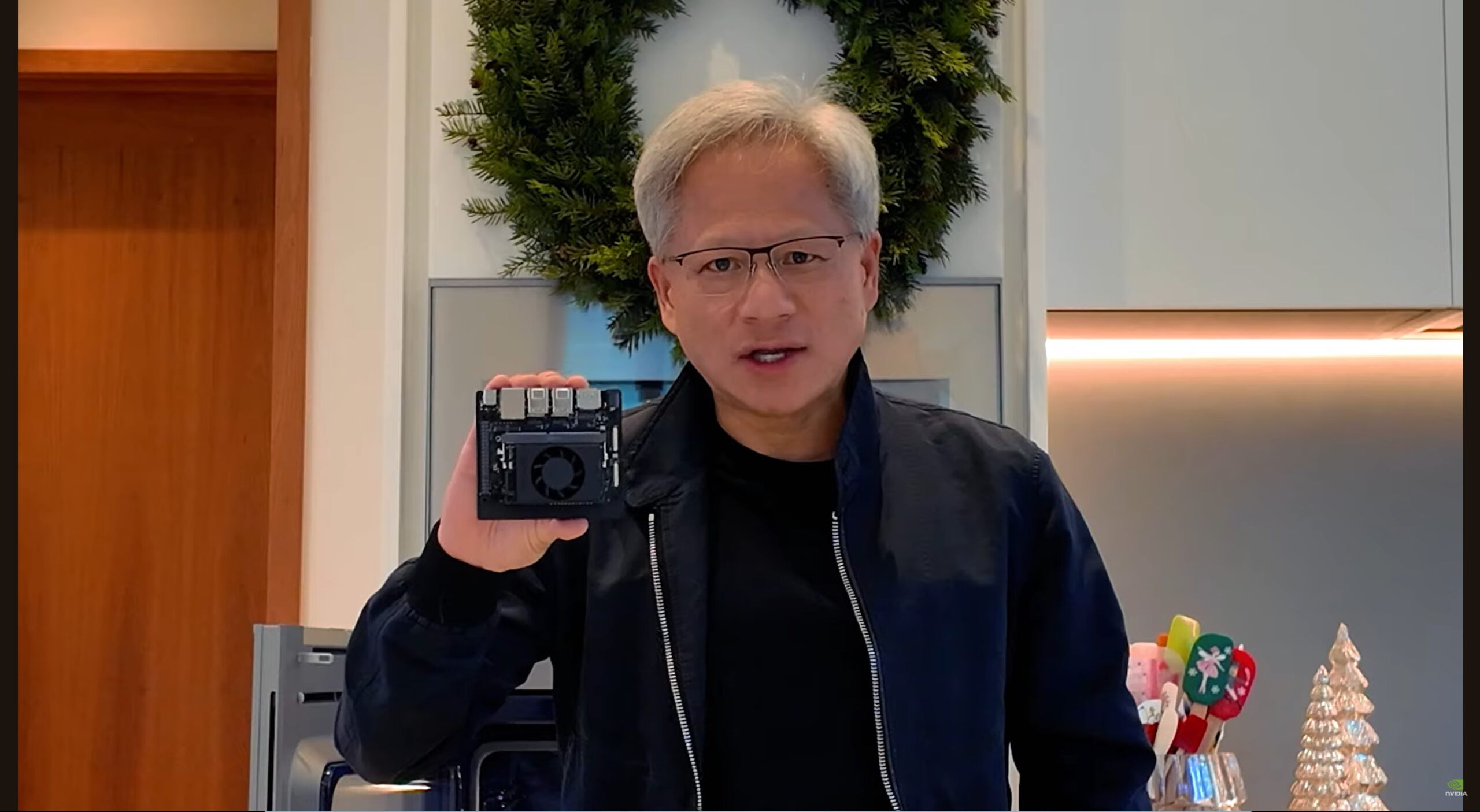

Nvidia har introdusert Jetson Orin Nano Super Developer Kit, en høyytelses AI-plattform som gir en 70 % økning i generativ AI-slutningshastighet samtidig som minnebåndbredden dobles sammenlignet med forgjengeren.

Priset til $249, tilbyr settet utviklere, forskere og studenter et kostnadseffektivt verktøy for å bygge og distribuere avanserte AI-applikasjoner på kanten.

NVIDIA Jetson Orin Nano superutvikleren Settet er et kompakt AI-kort designet for å lage AI-drevne enheter på startnivå som roboter, droner og intelligente kameraer.

Kombinasjonen av forbedret maskinvareytelse og bakoverkompatible programvareoptimaliseringer posisjonerer den som en attraktiv løsning for robotikk, datasyn og sanntidsgenerative AI-arbeidsbelastninger – områder der beregningskraft må møte energi-og plassbegrensninger.

Jetson Orin Nano Super Developer Kit-konfigurasjonssammenligning

(original)NVIDIA Jetson Orin Nano Super Developer KitGPU NVIDIA Ampere-arkitektur

1 024 CUDA-kjerner

32 tensorkjerner

635 MHz

NVIDIA Ampere-arkitektur

1 024 CUDA Kjerner

32 tensorkjerner

1020 MHz

AI PERF40 INT8 TOPS (Sparse)

20 INT8 TOPS (Tett)

10 FP16 TFLOPs

67 TOPS (Sparse)

33 TOPS (Tett)

17 FP16 TFLOP-er

CPU6-core Arm Cortex-A78AE v8.2 64-bit CPU

1,5 GHz

6-kjerners Arm Cortex-A78AE v8.2 64-bit CPU

1,7 GHz

Minne8 GB 128-bits LPDDR5

68 GB/s

8 GB 128-biters LPDDR5

102 GB/s

MODULKRAFT7W | 15W7W | 15W | 25W

Rimelig AI-ytelsesgevinst for Edge Computing

Jetson Orin Nano Super bygger på Nvidias Ampere GPU-arkitektur, som har vært en hjørnestein i deres AI-tilbud på tvers av datasentre, sky og nå edge computing. Utviklersettet inneholder Jetson Orin Nano 8GB system-on-module (SoM) og gir økt effektivitet for oppgaver som transformatorbaserte modeller, språkmodeller og robotsimuleringer.

Nvidia rapporterer en 1,7x økning i generativ AI-slutningsytelse, muliggjort av maskinvareoppgraderinger og programvareoptimalisering. Spesielt oppnår det nye systemet 67 TOPS (billioner operasjoner per sekund) sparsom dataytelse – opp fra 40 TOPS i den forrige Orin Nano-serien – og øker minnebåndbredden til 102 GB/s, et betydelig sprang over de tidligere 68 GB/s.

I følge Nvidia beholder utviklersettet den samme kompakte formfaktoren samtidig som den gir større effektivitet. Deepu Talla, Nvidias visepresident for Embedded and Edge Computing, bemerket oppgraderingens innvirkning og sa:”Det er som om vi har tatt Orin Nano og gitt den en superheltkappe.”

Disse forbedringene gir utviklere mulighet til å håndtere AI oppgaver som tidligere var begrenset til skysystemer, for eksempel å kjøre kompakte store språkmodeller (LLM) som Llama-3.1 og Gemma-2 mindre, optimaliserte modeller for å kjøre lokalt, Jetson Orin Nano Super reduserer avhengigheten av skyressurser og ventetid – kritisk for robotikk, autonome maskiner og andre sanntidsapplikasjoner.

[innebygd innhold]

Programvare Oppdateringer utvider ytelsesgevinster til eksisterende enheter

Sammen med maskinvareutgivelsen introduserte Nvidia en JetPack SDK-oppdatering som er til fordel for hele Jetson Orin-familien, inkludert eldre Orin Nano-og NX-modeller. Denne oppdateringen låser opp Super Mode, en høyere-modus. strøminnstilling som øker GPU-og CPU-klokkefrekvensene for å forbedre ytelsen.

Utviklere kan aktivere Super Mode ved å bruke Nvidias Power Mode Selector-verktøy, tilgjengelig via kommandolinjen eller det grafiske grensesnittet. Med denne funksjonen kan eksisterende maskinvare oppnå ytelsesgevinster som ligner på Jetson Orin Nano Super uten ekstra investering.

Ved å sikre programvareparitet på tvers av Orin-serien, maksimerer Nvidia livssyklusen og verdien av sine avanserte AI-plattformer, noe som gjør det enklere for utviklere å skalere prosjektene sine.

Reelle applikasjoner: Robotikk, Visjonsmodeller og Generative AI

Nvidias Jetson Orin Nano Super er spesialbygget for edge-applikasjoner som krever effektiv AI-behandling. Sentrale fokusområder inkluderer robotikk, datasyn og generativ kunstig intelligens:

I robotikk, Nvidias Isaac-plattformen tilbyr simuleringsverktøy og syntetisk datagenerering for å akselerere utviklingen. For eksempel gjør Isaac Sim det mulig for utviklere å prototype robotsystemer i virtuelle miljøer før de distribueres i den virkelige verden. På samme måte letter Nvidias Omniverse Replicator å lage syntetiske data av høy kvalitet for trening av AI-modeller.

For datasyn støtter Jetson Orin Nano Super transformatorbaserte modeller som Metas DINOv2 selvstyrte synstransformatormodell og CLIP, som gir forbedret nøyaktighet for bildegjenkjenning, klassifisering og objektgjenkjenning.

Disse modellene gjør det mulig for systemer å analysere bilder og video med høy oppløsning. strømmer med større effektivitet, noe som gjør enheten ideell for applikasjoner som automatisert kvalitetskontroll, overvåking og autonom navigering.

Generative AI-arbeidsbelastninger drar også nytte av plattformens muligheter. Ved å kjøre kompakte LLM-er lokalt – for eksempel Llama-3.1 8B eller Googles Gemma-2 – utviklere kan implementere applikasjoner som chatboter for gjenfinningsforsterket generasjon (RAG) eller sanntidsinnhold oppsummering.

Kombinasjonen av lav ventetid og redusert strømforbruk gjør Jetson Orin Nano Super godt egnet for edge-miljøer der båndbredde og skytilgang er begrenset.

Utviklerøkosystem og Langt-Term Support

Nvidia sier det er forpliktet til å støtte Jetson-fellesskapet gjennom omfattende ressurser og verktøy. Jetson AI Lab gir utviklere forhåndsbygde beholdere, distribusjonsveiledninger og opplæringsprogrammer for implementering av AI-modeller. Eksempler inkluderer integrering av Ollama for chatbot-distribusjon og utnyttelse av rammeverk fra Hugging Face, Google, Microsoft og Meta.

Utviklersettet er også har støtte for opptil fire kameraer, som muliggjør multi-stream-behandling for visjonsbaserte oppgaver – kritisk for robotikk og autonome systemer.

For å sikre langsiktig stabilitet, har Nvidia utvidet Jetson Orin-produktlivssyklus gjennom 2032, noe som gir utviklere og bedrifter tillit til plattformens tilgjengelighet for fremtidige distribusjoner.

Et skritt fremover for Edge AI

Med Jetson Orin Nano Super, Nvidia kombinerer forbedret AI-ytelse med rimelighet, og dekker det økende behovet for sanntidsdatabehandling på enheten. Plattformens evne til å kjøre kompakte generative AI-modeller, behandle bilder med høy oppløsning og akselerere utvikling av robotikk gjør den til et viktig verktøy for utviklere som jobber med avanserte løsninger.

Ved å tilby maskinvareforbedringer sammen med programvareoptimaliseringer som gjelder eksisterende enheter, har Nvidia skapt et robust økosystem for avansert AI-utvikling.