Microsoft utvikler tilsynelatende nye programvareverktøy for å kjøre NVIDIAs AI-programvare på rimeligere AMD-brikker, ifølge kommentarer fra en påstått ansatt som dukket opp denne uken.

Å kutte de høye kostnadene ved AI-arbeidsbelastninger, også kjent som inferens, ville direkte utfordre NVIDIAs langvarige dominans.

Slike verktøy for konvertering av NVIDIA ville rapportert at NVIDIAs verktøy var proprietære. til AMDs åpen kildekode ROCm-format. Hvis den stemmer, vil strategien speile en bredere bransjetrend, ettersom teknologigiganter som Oracle og OpenAI øker avhengigheten av AMD-maskinvare for å fremme konkurranse.

Et hemmelig våpen mot NVIDIAs AI-dominans?

Påstandene om det nye verktøysettet stammer fra en transkripsjon som sirkulerer på nettet som, selv om den ikke er bekreftet av Microsoft, ser ut til å være fra

I transkripsjonen target=”share7939450000″via skjermbilde på X, hevdet foredragsholderen eksistensen av interne prosjekter designet for å takle denne utfordringen direkte.

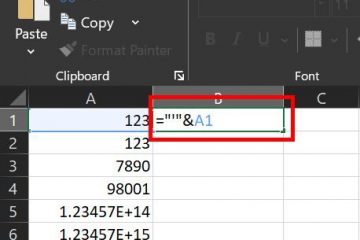

“De siste tre til fire månedene har det vært mye mer interesse for å spare kostnader med inferencing. Vi bygde noen verktøysett for å hjelpe til med å konvertere som CUDA-modeller til ROCm, slik at du kunne bruke det på en AMD, som vi har hatt mange i 3-30 ganger. om hva som er vår vei med AMD, 400X og 450X Vi jobber aktivt med AMD for å se hvordan vi kan maksimere det. Den største utfordringen jeg vil si at vi står overfor akkurat nå, spesielt med nyere servere, er å finne ut tettheten ved racket og få flytende kjøling ved racket. Verktøysettet ville effektivt fungere som et oversettelseslag, slik at AI-modeller som opprinnelig ble bygget for NVIDIAs økosystem, kan kjøre på AMDs maskinvare uten å kreve en fullstendig og kostbar omskriving.

I årevis har NVIDIAs CUDA-plattform vært både et kraftig verktøy og et gullbur for AI-utviklere. Som en parallell dataplattform hvis robuste biblioteker har gjort den til industristandarden, har CUDA skapt en kraftig «gravgrav» som gjør det vanskelig for konkurrenter å ta markedsandeler.

Hvis det bekreftes, vil Microsofts innsats være et direkte angrep på den vollgraven. Selv om AMDs ROCm er et kapabelt alternativ med åpen kildekode, vil en pålitelig konverteringsbane tillate Microsofts Azure-kunder å få kostnadsfordelene ved AMD-maskinvare uten å forlate det kjente CUDA-miljøet.

Alternativer for å kjøre CUDA med AMD-brikker er allerede tilgjengelige, for eksempel SCALE-verktøy. Effektivitetstapet på grunn av konvertering fortsetter imidlertid å være en pågående hindring som Microsoft tilsynelatende ønsker å takle.

A Cost-Saving Play for the AI Inference Boom

Drivet av de høye kostnadene ved AI-operasjoner, jobber teknologigigantene nå aggressivt med kostnadsbesparende tiltak. Foredragsholderen i transkripsjonen fremhevet at den primære motivasjonen bak det påståtte verktøysettet er økonomisk, spesielt for slutningsstadiet av AI, der trente modeller settes i gang.

Når AI-tjenester skaleres til millioner av brukere, står slutninger for en enorm del av driftskostnadene.

En økende interesse for kostnadseffektivitet gjør AMDs til et mer konkurransedyktig prisalternativ til NVIDIA til et mer konkurransedyktig pris. maskinvare, forutsatt at programvarebarrieren kan overvinnes.

Utover programvare-og brikkekostnader, er fysiske datasenterbegrensninger i ferd med å bli en kritisk flaskehals. Kilden i transkripsjonen bemerket at den grunnleggende utfordringen ikke lenger bare er å sikre nok elektrisitet, men å administrere den effektivt.

Dens fokus på krafttetthet og væskekjøling fremhever de enorme kravene til neste generasjons AI-akseleratorer.

The Industry-Wide Push to Break the CUDA Stranglehold-strategien med et betydelig, bransjedekkende press for å dyrke en mer konkurransedyktig AI-maskinvareforsyningskjede. For NVIDIA, hvis markedslederskap er bygget like mye på programvaren som silisiumet, representerer denne trenden en langsiktig trussel.

Oracle, en nøkkelaktør innen skyinfrastruktur, annonserte nylig et stort partnerskap for å distribuere 50 000 AMD AI-brikker. Karan Batta, Senior Vice President i Oracle Cloud, pekte eksplisitt på verdien av dette alternativet for kostnadssensitive arbeidsbelastninger.

Den ledende AI-forskningslaben OpenAI tar også avgjørende grep for å diversifisere datagrunnlaget sitt. Den inngikk en definitiv multi-milliard dollar-avtale med AMD om å distribuere 6 gigawatt av sine GPU-er.

Dens partnerskap inkluderer en unik warrant for opptil 160 millioner aksjer, noe som kan gi OpenAI en eierandel på omtrent 10 % i brikkeprodusenten, noe som i dybden justerer målene deres til «co-opetric» til og med trenden.

“

“rivaler. Intel er i samtaler om å produsere brikker for AMD, og understreker den strategiske viktigheten av en diversifisert halvlederforsyningskjede.

Hvis påstandene om Microsofts verktøysett er nøyaktige, jobber selskapet ikke bare med å løse et internt kostnadsproblem, men bidrar til en bredere markedsutvikling. Et vellykket konverteringsverktøy kan signalisere en fremtid med maskinvare-agnostisk AI-utvikling, og frigjøre utviklere fra leverandørlåsing.

Et slikt potensielt skifte vil markere en ny modningsfase for hele AI-industrien, og gå fra en hektisk databehandling til et mer strategisk, multipolart økosystem.