Microsoft-forskere har detaljert et nytt sidekanalangrep kalt”Whisper Leak”som kan gjette emnet for krypterte AI-chatter, og avsløre en grunnleggende personvernrisiko på tvers av AI-industrien.

I en nettverksrapport viser hvor stor trafikk og hvor mange brukere er, og hvor mange timer det er diskutere, selv med TLS-kryptering. Feilen påvirker 28 store AI-modeller, og skaper en alvorlig personvernrisiko for brukere globalt. En observatør på et nettverk kan oppdage sensitive samtaler om juridiske eller helsemessige emner.

Etter en avsløringsprosess som startet i juni, har store leverandører som OpenAI og Microsoft begynt å distribuere rettelser, men problemet peker på en kjernerisiko ved strømming av AI.

Hvordan Whisper Leak avlytter krypterte AI-chatter

Angrepets oppfinnsomhet ligger i dets evne til å fungere uten å bryte TLS-krypteringene. I stedet utnytter den metadataene som kryptering iboende etterlater.

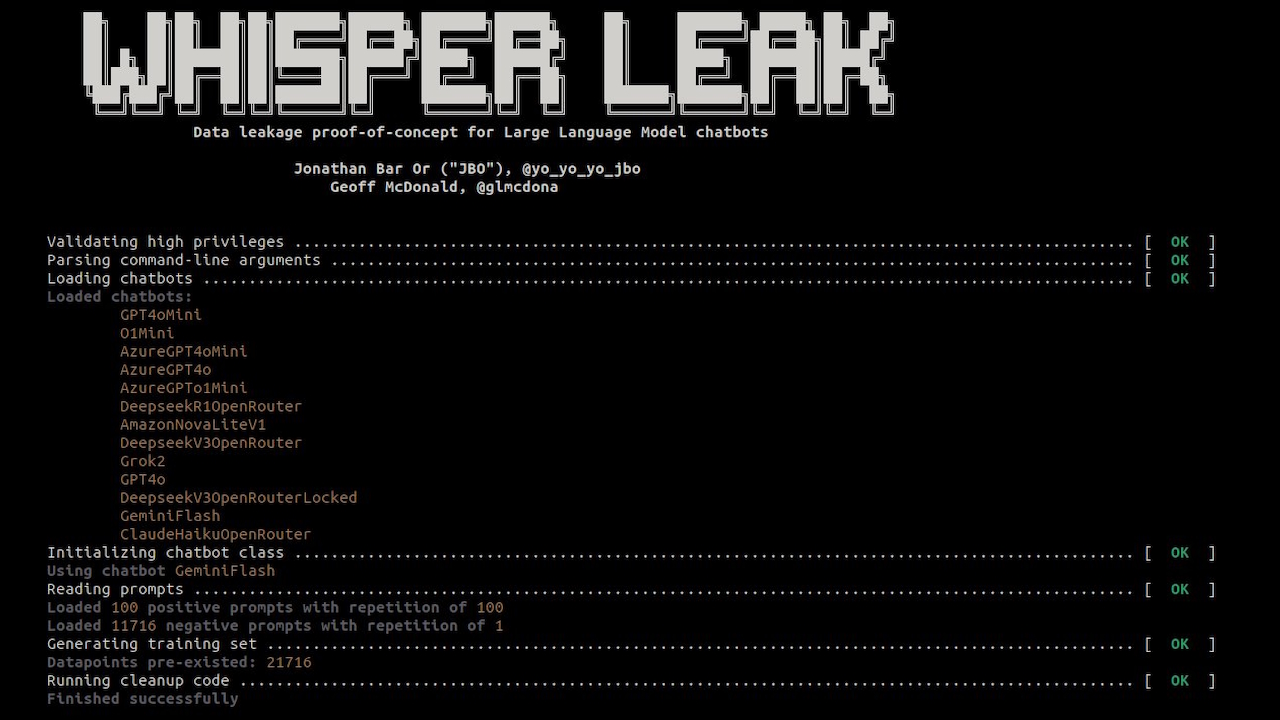

I følge prosjektets dokumentasjon er”Whisper Leak et forskningsverktøysett som demonstrerer hvordan krypterte, streamende samtaler med store språkmodeller lekker raskt informasjon gjennom pakkestørrelser og timing.”

Metoden omgår sikkerhetens form og fokus ved å omgå sikkerheten. flyt.

LLM-svar, generert token-by-token, skaper unike sekvenser av datapakker når de strømmes til en bruker. Hvert emne, fra juridisk analyse til uformell samtale, genererer tekst med distinkte ordforråd og setningsstrukturer. Disse språklige mønstrene produserer et karakteristisk”digitalt fingeravtrykk”i nettverkstrafikken.

Forskerne analyserte sekvenser av pakkestørrelser og tider mellom ankomst og bygde klassifikatorer for å gjenkjenne disse fingeravtrykkene med høy nøyaktighet.

En bransjebrist som påvirker 28 store AI-modeller

Whisper Leak er ikke en isolert feil, men en systemisk sårbarhet som påvirker et bredt spekter av AI-industrien. Microsoft-teamet testet 28 kommersielt tilgjengelige LLM-er, og fant at flertallet var svært mottakelige.

For mange modeller oppnådde angrepet nesten perfekt klassifisering. Forskere bemerket i et blogginnlegg,”Dette forteller oss at de unike digitale”fingeravtrykkene”som etterlates av samtaler om et spesifikt emne, er tydelige nok til at vår AI-drevne avlytting kan plukke dem ut på en pålitelig måte i en kontrollert test. Forskningen demonstrerte alarmerende presisjon under realistiske forhold.

I en simulering med et forhold på 10 000 til 1 mellom bakgrunnsstøy og målsamtaler, identifiserte angrepet sensitive emner med 100 % presisjon for 17 av de 28 modellene, samtidig som det ble oppdaget 5–20 % av alle målsamtaler, som f.eks. eller en angriper på et offentlig Wi-Fi-nettverk, kan pålitelig identifisere brukere som diskuterer konfidensielle juridiske, økonomiske eller helsemessige forhold.

Denne funksjonen gjør krypterte AI-chatter til en potensiell kilde for målrettet overvåking. Som forskerne uttaler:”Denne sårbarheten for hele bransjen utgjør betydelig risiko for brukere under nettverksovervåking av Internett-leverandører, myndigheter eller lokale motstandere.”

Angrepsytelse (AUPRC) angitt av funksjoner som er angitt av vertene angitt av LLMs og vertene. arkitektur. Høyere tall tilsvarer en høyere effektivitet av sidekanalangrepet. Beregninger beregnes som en median over 5 forsøk, hvor en tilfeldig splittelse utføres per forsøk.’Best’-kolonnen er også den beste 5 prøvemedianen fra modellene og funksjonssettene som er brukt. (Kilde: Microsoft)

En vanskelig løsning: avbøtende og inkonsekvente leverandørrespons

Microsoft startet en ansvarlig avsløringsprosess i juni 2025, og varslet alle 28 berørte leverandører. Fra og med november har svarene vært blandede.

Mens leverandører som OpenAI, Microsoft, Mistral og xAI flyttet for å rette opp feilen, bemerker rapporten at andre leverandører har avslått å implementere rettelser eller ikke har reageret.

Denne hendelsen fremhever en urovekkende inkonsekvens i hvordan industrien håndterer nye trusler. Den følger etter at Google i oktober nektet å fikse en kritisk”ASCII-smugling”-feil i Gemini-modellene, som den klassifiserte som et sosialt ingeniørproblem i stedet for en sikkerhetsfeil.

Det gjenspeiler også en nylig sårbarhet for dataeksfiltrering i Anthropics Claude, der selskapet først avviste rapporten før de erkjente en”Sikkerhetsforskning ikke Rehberg>”.

i så fall”beskytter sikkerhet deg mot ulykker. Sikkerhet beskytter deg mot motstandere.”Skillet er kritisk ettersom AI-agenter blir mer autonome og integrert med sensitive data.

Å fikse metadatalekkasjer er ikke enkelt. Forskerne evaluerte flere avbøtende tiltak, hver med betydelige avveininger. Tilfeldig datautfylling, nå implementert av enkelte leverandører, legger til støy til pakkestørrelser, men reduserer bare delvis angrepssuksess.

En annen strategi, token-batching, grupperer flere tokens før de sendes, og skjuler individuelle mønstre. Selv om dette er effektivt ved større batchstørrelser, kan dette forringe sanntidsresponsen til en chatbot, og påvirke brukeropplevelsen.

Et tredje alternativ, å injisere syntetiske «støy»-pakker, kan også fordunkle trafikkmønstre. Denne tilnærmingen øker imidlertid båndbredden, noe som er en betydelig kostnadsbetraktning for leverandørene.

Episoden viser at etter hvert som AI blir mer integrert i sensitive arbeidsflyter, krever beskyttelse av brukernes personvern at man ser utover innholdskryptering for å sikre selve mønstrene for digital kommunikasjon