OpenAI lanserte onsdag gpt-oss-safeguard, en ny familie med åpenvekts AI-modeller designet for å la utviklere håndheve sine egne sikkerhetsregler for innhold.

Selskapet gjorde to modellstørrelser tilgjengelige på Hugging Face under en tillatende Apache 2.0-lisens, noe som tillater gratis kommersiell bruk.

I motsetning til disse modellene, bruker de tradisjonelle sikkerhetsverktøyene for å utvikle og skrive bruk av sikkerhetsverktøy i en sikkerhetspolicy. sanntid. Denne tilnærmingen gir plattformer en mer fleksibel og gjennomsiktig metode for innholdsmoderering.

Utgivelsen kommer mens OpenAI jobber for å styrke sikkerheten på tvers av produktene sine midt i økende offentlig og regulatorisk gransking. Navnet gpt-oss-safeguard-120b og gpt-oss-safeguard-20b, er de nye modellene spesialiserte versjoner av selskapets gpt-oss-familie, som markerte dens tilbakevending til den åpne 2.->august. Tilnærming: Reasoning-Based Safety for Developers

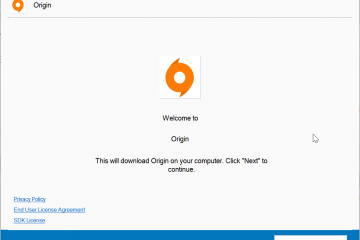

Skifter fra tradisjonelle metoder, de nye modellene introduserer en resonnementbasert tilnærming til innholdsklassifisering. Standard sikkerhetsklassifiserere er vanligvis trent på tusenvis av manuelt merkede eksempler på trygt og usikkert innhold.

De lærer å utlede en policy, men ser aldri reglene direkte, noe som gjør dem rigide og vanskelige å oppdatere uten omfattende omskolering.

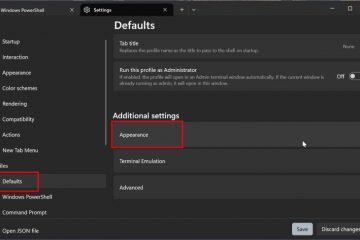

gpt-oss-safeguard fungerer annerledes. Det krever to innganger på en gang: en utviklerskrevet policy og innholdet som skal bedømmes mot det.

Ved hjelp av en tankekjede prosess, resonnerer modellen gjennom policyen for å komme frem til en klassifisering. Utviklere kan gjennomgå dette resonnementet, og gir et tydelig revisjonsspor for moderasjonsbeslutninger. Dette gjør systemet svært tilpasningsdyktig for nyanserte eller raskt utviklende sikkerhetsutfordringer der store merkede datasett ikke eksisterer.

For eksempel kan et spillforum bruke det til å flagge diskusjoner om juks, eller et anmeldelsesnettsted kan undersøke for falske attester ved å bruke sine egne unike kriterier.

OpenAI antyder at denne metoden er spesielt kraftig enn der hvor produserbar sikkerhet er mindre kritisk, og forklaringstiden er mindre kritisk. Å velge Apache 2.0-lisensen er også et betydelig grep, ettersom dens tillatelige natur oppmuntrer til bred adopsjon og kommersiell bruk, og fjerner barrierer som eksisterer med mer restriktive lisenser.

Community Collaboration and the Path to Open Safety

I et betydelig grep for åpen kildekode-fellesskapet, har OpenAI utviklet sikkerhet og sikkerhet, inkludert flere organisasjoner og organisasjoner. Discord, SafetyKit og ROOST (Robust Open Online Safety Tools). Denne partnerskapstilnærmingen tar sikte på å bygge sikkerhetsverktøy med direkte innspill fra utøverne som vil bruke det daglig.

Som en del av lanseringen etablerer ROOST ROOST Model Community (RMC), et nytt initiativ på GitHub designet for å bringe forskere og sikkerhetseksperter sammen.

Målet er å dele beste praksis og forbedre AI-modeller med åpen kildekode. Vinay Rao, CTO hos ROOST, berømmet modellens design.”gpt-oss-safeguard er den første resonneringsmodellen med åpen kildekode med en”bring dine egne retningslinjer og definisjoner av skade”-design.”

Han la til:”I testingen vår var den dyktig til å forstå forskjellige retningslinjer, forklare resonnementene og vise nyanser i bruken av retningslinjene, som vi tror vil være fordelaktige for byggherrer og sikkerhetsteam.”uttalte:”Når AI blir kraftigere, må sikkerhetsverktøy og grunnleggende sikkerhetsforskning utvikle seg like raskt-og de må være tilgjengelige for alle.”

Kontekst er nøkkelen: A Timely Release Amid Safety Scrutiny

På et bakteppe av intenst regulatorisk press, er selskapets utgivelse av et nytt sikkerhetsverktøy bare én dag etter en dag.

avslørt at hundretusenvis av brukerne har samtaler som involverer selvskading eller psykose med ChatGPT hver uke, og lanseringen adresserer direkte krav om en større sikkerhetsoppdatering.

Med en verdi på $500 milliarder og en brukerbase på over 800 millioner ukentlige aktive brukere, er omfanget av OpenAIs sikkerhetsutfordring enormt.-

nytt for selskapet. OpenAI avslørte at den bruker et lignende, kraftigere internt verktøy kalt Safety Reasoner som en kjernekomponent i sin egen”defense in depth”sikkerhetsstabel.

Dette interne systemet hjelper til med å beskytte avanserte modeller som GPT-5 og Sora 2 ved dynamisk å evaluere innhold mot utviklende retningslinjer i sanntid.

åpen versjon av denne tilnærmingen, vi gjør en åpen tilnærming. del av den interne sikkerhetsstrategien som er tilgjengelig for det bredere utviklerøkosystemet.

Begrensninger og veien videre

Til tross for sin innovative tilnærming, er OpenAI åpen om modellenes begrensninger. For komplekse risikoer bemerker selskapet at en dedikert klassifikator som er trent på titusenvis av merkede prøver av høy kvalitet, fortsatt kan oppnå høyere ytelse.

Resonneringsprosessen er også mer tid-og datakrevende enn tradisjonelle metoder, noe som kan utgjøre en utfordring for plattformer som trenger å moderere massive innholdsvolumer med svært lav ventetid.

reduserer denne klassen raskere, ved å bruke mindre AI-klassifisering. først identifisere potensielt problematisk innhold, som deretter sendes til den kraftigere Safety Reasoner for detaljert analyse. Denne lagdelte tilnærmingen er en modell for utviklere.

Foreløpig markerer utgivelsen av gpt-oss-safeguard et kritisk skritt mot å bygge mer transparente, tilpasningsdyktige og fellesskapsdrevne AI-sikkerhetssystemer, og gir utviklere et kraftig nytt verktøy i den pågående kampen for nettsikkerhet.