Google omfavner en”mindre er mer”-filosofi med sin siste AI-utgivelse, og lanserer den hypereffektive Gemma 3 270M Open Model. Med bare 270 millioner parametere er denne kompakte modellen konstruert for at utviklere skal lage spesialiserte, finjusterte applikasjoner som kan kjøres direkte på enheter som smarttelefoner eller til og med i en nettleser.

Målet er å aktivere en ny klasse med raske, private og lave kostnader AI-løsninger ved å gi det”riktige verktøyet for jobben”. I stedet for å stole på massive skybaserte systemer, fokuserer Gemma 3 270M på ekstrem krafteffektivitet for veldefinerte oppgaver, noe Target=”_ blank”> utvide”gemmaverse”av åpne modeller . Den følger den første debuten til Gemma 3-serien i mars, utgivelsen av QAT-versjoner for forbruker GPUer i april, og lanseringen av den mobile første Gemma 3N i juni.

Denne strategien stemmer overens med et bredere bransjeskifte mot små språkmodeller (SLM). Selskaper som Microsoft med sin PHI-serie, Mistral AI med sin lille 3-modell, og klemmer ansiktet med Smolvlm-modellene, investerer alle i effektiv AI.

Lanseringen representerer en strategisk pivot i AI Arms Race, og prioriterer kirurgisk presisjon over brute kraft. Det understreker en voksende bransjetrend der mindre, spesialiserte modeller blir viktige verktøy for praktisk, virkelighetsutplassering.

et”riktig verktøy for jobb”-filosofi

i en strategisk avgang fra bransjens besettelse med rå kraft, Google posisjonerer Gemma 3 270M Ikke som en rival til massiv, generell-purposemodeller, men som en høykvalitets fundament for det det en”General-Purpose Models, men som en høykvalitets fundament for å kalle en”Fly-purposemodell, men som en høykvalitets grunnlag for å kalle en”Flean-modeller. Selskapets offisielle kunngjøring påkaller et klassisk ingeniørprinsipp: Du vil ikke bruke en slegge til å henge en bilderamme. Denne modellen legemliggjør dette”riktig verktøyet for jobben”filosofi

Kraften i denne spesialiserte tilnærmingen er allerede påvist i den virkelige verden. Google fremhever arbeidet med adaptiv ML med SK Telecom, der en finjustert Gemma-modell fikk i oppgave å ha nyansert, flerspråklig innholdsmoderasjon. Resultatene var sterke: den spesialiserte modellen møttes ikke bare, men overgikk mye større proprietære systemer på sin spesifikke oppgave. Denne suksesshistorien fungerer som en praktisk blåkopi for hvordan utviklere kan utnytte Gemma 3 270Ms effektivitet.

Ved å starte med en kompakt og dyktig base, kan utviklere bygge produksjonssystemer som er raskere og dramatisk billigere å betjene. Denne strategien retter seg direkte mot det økende behovet for kostnadseffektiv AI som kan distribueres i skala uten å pådra massive inferenskostnader. Modellens lille størrelse gir mulighet for rask iterasjon, slik at finjustering av eksperimenter kan fullføres i timer, ikke dager. For visse høyt spesialiserte roller, for eksempel rollespill-NPC-er eller tilpassede journalføringsboter, blir modellens evne til å”glemme”generell kunnskap gjennom overmontering en funksjon, og sikrer at den forblir laserfokusert på den utpekte funksjonen.

Dette store ordforrådet er nøkkelen til spesialiseringsdrivende. Det gjør at modellen kan håndtere sjeldne, spesifikke og tekniske symboler med høy troskap, noe som gjør den til et usedvanlig sterkt fundament for finjustering i nisjedomener som lov, medisin eller finans. Ved å forstå bransjespesifikk sjargong fra begynnelsen, krever det at mindre treningsdata blir en ekspert. Dette kompletteres med et respektabelt 32K-token-kontekstvindu, slik at det kan behandle betydelige spørsmål og dokumenter.

For å sikre øyeblikkelig brukbarhet, slipper Google både forhåndsutdannede og instruksjonsstemte sjekkpunkter. Selskapet er tydelig på at Gemma 3 270M ikke er designet for komplekse, åpne samtalebrukssaker som en chatbot. I stedet er den instruksjonsinnstilte versjonen konstruert for å følge strukturerte spørsmål og kommandoer effektivt rett ut av boksen, og gir en pålitelig base for videre tilpasning.

Denne robuste designen er validert av ytelsen på bransjens benchmarks. På IFeVal-testen, som måler en modells evne til å følge verifiserbare instruksjoner, oppnår Gemma 3 270M en poengsum på 51,2 prosent. Denne poengsummen er høyere enn andre lette modeller som har flere parametere, og viser at den slår godt over vekten. Selv om det forutsigbart faller til milliardparametermodeller, er ytelsen bemerkelsesverdig konkurransedyktig for sin brøkstørrelse.

Ekstrem effektivitet for AI

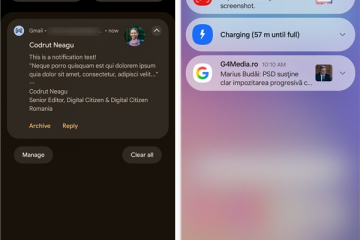

En viktig fordel med Gemma 3 270m er dets lave strømforbruk. Interne tester på en Pixel 9 Pro viste en Int4-Quantized Model som ble brukt bare 0,75% av enhetens batteri for 25 samtaler, noe som gjorde det til Googles mest strømpeffektive Gemma-modell til dags dato.

Denne ekstreme effektiviteten er kritisk for applikasjoner på enheten der batteriets levetid og termisk ytelse er Paramount. Det sikrer også brukerens personvern, ettersom sensitiv informasjon kan behandles lokalt uten noen gang å bli sendt til skyen.

For å lette dette, gir Google Production-Ready Quantization-Aware Trained (QAT) sjekkpunkter. Dette gjør at utviklere kan kjøre modellene med INT4-presisjon med minimal ytelsesnedbrytning, en avgjørende funksjon for distribusjon på ressursbegrenset maskinvare.

for utviklere, Gemma 3 270M er Tilgjengelig nå gjennom populære plattformer som Hugging Face , Ollama, og Kaggle, med Integration som Hugging Face . Denne brede tilgjengeligheten, berømmet av utviklere som Simon Willison som kalte en tidligere Gemma-utgivelse”Den mest omfattende Day One-lanseringen jeg har sett for enhver modell,”er nøkkelen til å fremme et pulserende økosystem rundt disse mindre, mer praktiske AI-verktøyene.