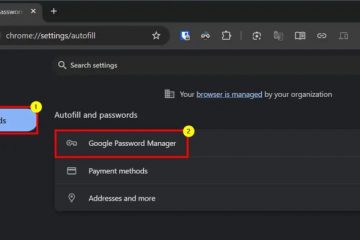

Openai står overfor spisse spørsmål om sikkerhetsprotokollene etter en

Med henvisning til åtte kilder som er kjent med selskapets virksomhet, sier rapporten at testing av tidslinjer, som tidligere spente måneder, har blitt komprimert til bare dager. Denne akselerasjonen kommer når Openai forbereder seg på en overhengende lansering, muligens neste uke, av nye modeller inkludert den resonnementfokuserte O3, og etterlater noen tredjepart og interne testere mindre enn en uke for viktig Hastigheten har imidlertid løftet alarmer blant de som har til oppgave å evaluere modellene. “We had more thorough safety testing when [the technology] was less important,”one individual currently assessing the upcoming o3 model told the Financial Times. They warned that as AI capabilities grow, so does the “potential Våpenisering”og karakteriserte den nåværende tilnærmingen som”uvøren”, og legger til,”men fordi det er mer etterspørsel etter det, vil de ha det raskere. Den nåværende situasjonen:”De prioriterer bare ikke offentlig sikkerhet i det hele tatt.”Daniel Kokotajlo, en tidligere Openai-forsker, fremhevet miljøet som muliggjorde dette hastverket:”Det er ingen forskrift som sier at [selskaper] må holde publikum informert om alle de skumle evnene… og de er også under press for å rase hverandre, slik at de ikke kommer til å slutte å gjøre dem mer dyktige.” dette sikkerhetsdebatten med et redning. Administrerende direktør Sam Altman bekreftet en”planendring”4. april, og sa at selskapet ville gi ut O3 og O4-mini-resonnementsmodellene”sannsynligvis om et par uker,”presset den etterlengtede GPT-5-lanseringen tilbake med”noen måneder.” Dette reverserte en tidligere plan fra februar til å konsolidere kapasiteter til GPT-5. Altman forklarte at avgjørelsen delvis var”koble fra resonnementsmodeller og chat/fullføringsmodeller,”la via X til at”vi er spente på ytelsen vi ser fra O3 internt”og at forsinkelsen ville tillate GPT-5 å være”mye bedre enn vi opprinnelig, da ingeniøren.”. `O4-mini`, og` o4-mini-høye `i en chatgpt weboppdatering. Samtidig antyder rapporter en oppdatert multimodal modell, foreløpig kalt GPT-4.1, nærmer seg også utgivelsen. Utover den komprimerte planen, har spesifikke bekymringer om dybden av Openais testing surfaced. Kritikere stiller spørsmål ved selskapets forpliktelse til å vurdere misbrukspotensial, som å hjelpe biowapon-oppretting, gjennom finjustering. Denne prosessen innebærer å trene en modell på spesialiserte datasett (som virologi) for å se om den utvikler farlige evner. Likevel, ifølge den tidligere Openai-sikkerhetsforskeren Steven Adler og andre sitert av FT, har denne detaljerte testen vært begrenset, først og fremst ved bruk av eldre modeller som GPT-4O, uten publiserte resultater for merkert, mer capabababababable modeller som O1. I følge Adler, hvis synspunkter ble detaljert I et bloggpost “Mangelen på rapportering på nyere modeller. Tester kan bety at Openai og de andre AI-selskapene undervurderer den verste risikoen ved modellene sine.”En annen kritikk innebærer å teste tidligere modellversjoner, eller”sjekkpunkter”, i stedet for den endelige koden som ble utgitt for publikum.”Det er dårlig praksis å gi ut en modell som er forskjellig fra den du evaluerte,”sa en tidligere Openai-teknisk medarbeider til FT. Openai forsvarer dens praksis, og siterer effektivitet som er oppnådd gjennom automatisering og uttrykker tillit til metodene. Selskapet uttalte at sjekkpunktene var”i utgangspunktet identiske”med endelige utgivelser, og at modeller er grundig testet, spesielt for katastrofale risikoer. Johannes Heidecke, Openais sjef for sikkerhetssystemer, hevdet:”Vi har en god balanse på hvor raskt vi beveger oss og hvor grundige vi er.” Selskapet lanserte også nylig sin forsterkning finjustering (RFT) -en teknikk for å lage spesialiserte”ekspertmodeller”på teller. Dette initiativet virker imidlertid forskjellig fra de grunnleggende, forkortede sikkerhetsevalueringene før utgivelse. Spenningen mellom produkthastighet og sikkerhetsprotokoller på Openai er ikke ny. I mai 2024 fokuserte Jan Leike, og ledet selskapets superalignasjonsteam på langsiktig AI-risiko, og uttalte offentlig at”Sikkerhetskultur og prosesser har tatt en baksete til skinnende produkter.”Hans avgang og senere sammenføyning av antropisk signaliserte dype uenigheter om ressurser og prioriteringer angående langsiktig AI-sikkerhetsforskning. Spesielt hadde Openai kunngjort dannelsen av en styret ledet sikkerhets-og sikkerhetsutvalg bare dager tidligere, som har til oppgave å ha en 90-dagers periode for å evaluere og utvikle sikkerhetsprosesser og komme med anbefalinger.

dinkende spørsmål om testpraksis

En historie med interne sikkerhetsdebatter

Bransjestivaler legger vekt på gjennomsiktighet og styring

Openais rapporterte gjennomgangskontrast med nyere offentlige stanser fra nøkkel. Den 28. mars detaljerte Anthropic sitt tolkbarhetsramme, et”AI-mikroskop”ved bruk av Dicts for å dissekere sin klaude Modells Reasicing Reseancing Reseancing Modelling Reseancing Modelling Resefe Resefe Resecing”Diksjonslæring prøver å reversere ingeniørens interne beregninger og kartlegge dem til forståelige konsepter. Antropisk innrammet dette som essensielt for tillit. Tilsvarende foreslo Google DeepMind et globalt AGI-sikkerhetsrammeverk 3. april, og gikk inn for internasjonalt tilsyn og behandling av avanserte AI-risikoer som øyeblikkelig. Dette forslaget fulgte dannelsen av DeepMinds egen AI-sikkerhets-og justeringsorganisasjon tidligere i 2024.

regulatorisk landskap og pågående risikoer

Det bredere industrien landskap viser kompleksiteter. Antropisk, mens de presset på for sterkere regjeringens AI-regler i begynnelsen av mars, fjernet også rolig noen av sine egne tidligere frivillige sikkerhetsforpliktelser som ble gjort under et initiativ i White House, som illustrerer spenningen mellom offentlig posisjonering og operasjonelt press. Openai selv er part i frivillige forpliktelser med Storbritannia og amerikanske regjeringer angående tilgang til ekstern sikkerhetstesting, som nevnt i FT-rapporten.

I mellomtiden er regulatoriske rammer strammere, med EUs AI-lov nå i kraft, og mandat til strengere transparens og risiko for høyrisiko. Behovet for robust testing understrekes av pågående sårbarhetsfunn, for eksempel utnyttelsen av”forsinket verktøy”-utnyttelse som ble funnet i Google Geminis minne i februar, eller vedvarende jailbreaking-teknikker som påvirker flere ledende modeller. Openais raske utvikling fortsetter til tross for altman Anerkjenner potensielle kapasitetsutfordringer Tidligere denne måneden, som kan påvirke tidsledninger og tjenestestabilitet.