Googles Gemini avanserte AI-abonnement, kjent for sin evne til å tilpasse samtaler ved å beholde minnet på tvers av økter, er under gransking etter at en cybersecurity-forsker avdekket en metode for å manipulere det langsiktige minnet.

Utnyttelsen, kalt forsinket verktøyinnkalling, innebærer sovende kommandoer innenfor spørsmål eller dokumenter, og aktiverer bare når spesifikke brukerinnganger utløser dem. Disse angrepene går på akkord med AIs evne til å opprettholde nøyaktig og objektiv lagret informasjon, og vekker alvorlige bekymringer for påliteligheten til minneaktiverte AI-systemer.

Discovery gir et voksende bevismateriale om sårbarheter i kunstig intelligenssystemer. Tidligere forskning, for eksempel Anthropics funn om best-of-N-jailbreaking, fremhevet hvor små variasjoner i inngangsspørsmål kan omgå sikkerhetsmekanismer i modeller som Openais GPT-4O og Googles Gemini Pro. fri , med forskere som legger merke til lignende risikoer i visjon og lydbaserte AI-systemer, og ytterligere vekt på omfanget av problemet.

hvor forsinket verktøykall fungerer

the Forsinket verktøy på innkallingsteknikk manipulerer Geminis minnefunksjon, som lar chatbot lagre brukerrelaterte data for personalisering. Angripere legger inn skjulte kommandoer i upålitte datakilder, for eksempel dokumenter lastet opp for oppsummering.

Disse kommandoene ligger i dvale i AIs kontekst, og aktiverer bare når brukeren ubevisst utløser dem med spesifikke svar som”ja”eller”sikker.”Når kommandoene er utført, ødelegger kommandoene Geminis langtidsminne, og setter inn falsk eller partisk informasjon som vedvarer på tvers av økter.

Som forklart av Johann Rehberger, Hvem fant feilen ,“ Når brukeren senere sier “X” [for den programmerte kommandoen], Gemini, og tror den følger brukerens direkte instruksjon , utfører verktøyet.”

Denne metoden lar angripere omgå Googles beskyttelsesregler, som begrenser verktøyaktiveringer under ikke-tillitsfulle interaksjoner. Ved å utnytte AIs avhengighet av brukerdrevne innganger, unngår hackere øyeblikkelig deteksjon, og etterlater de kompromitterte dataene uforstyrret til virkningene av dens overflate i fremtidige interaksjoner.

[innebygd innhold]

risikoen for vedvarende AI-minne

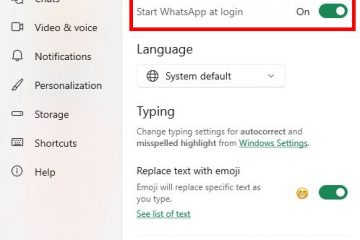

Geminis minnesystem er designet for å forbedre brukeropplevelsen ved å beholde konteksten på tvers av samtaler. Abonnenter på AI-aktiverte tjenester som Gemini Advanced kan se og administrere hva AI husker, og gir dem litt kontroll over lagret informasjon. Imidlertid har denne evnen innført en ny vektor for angrep.

Persistent minnetvingning kan føre til partiske AI-utganger, feilinformasjon eller misbruk av sensitive data i miljøer med høyt innsats.

For eksempel i helsevesenets applikasjoner kan en angriper plante feil Pasientdata i et AI-system som brukes til diagnostikk, noe som fører til potensielt farlige anbefalinger. Tilsvarende kan juridiske AI-verktøy med korrupt minne generere feil kontrakter basert på manipulerte innspill. Disse scenariene demonstrerer hvordan utnyttelser som forsinket verktøyinnkalling har potensial til å erodere tillit til AI-systemer på tvers av bransjer.

leksjoner fra andre AI-sårbarheter

Det forsinkede verktøyet Invocation Exploit er en del av et bredere mønster av sårbarheter i store språkmodeller (LLM). Lignende teknikker, for eksempel best-of-n jailbreaking , utnytter AI-systemets sannsynlige utganger ved å gjøre små modifikasjoner til skadelige spørsmål.

For eksempel kan det å endre kapitalisering eller erstatte symboler unndra seg filtre designet for å blokkere ondsinnede spørsmål. Disse metodene påvirker ikke bare tekstbaserte modeller som Gemini, men har også blitt demonstrert i visjon og lydbaserte AI-systemer.

bransjesvar og verktøy for AI-sikkerhet

Arbeidet med å dempe disse risikoene har ansporet innovasjon innen AI-sikkerhetsrammer. NVIDIA har for eksempel introdusert sitt rammeverk for NEMO-rekkverk, designet for å moderere innhold og forhindre motstridende innganger.

I følge Nvidias visepresident for Enterprise AI-modeller gir Kari Briski,”Små modeller som de i Nemo-rekkverkssamlingen gir lavere latens, noe som muliggjør sømløs integrasjon i ressursbegrensede miljøer som lager eller sykehus.”Disse Verktøy tar sikte på å ivareta AI-systemer ved å opprettholde samtalegrenser og oppdage uautoriserte kommandoer.

nvidia har også utviklet Garak tooltps , en åpen kildekode-løsning som lar utviklere simulere motstridende scenarier, inkludert hurtig injeksjonsangrep, for å identifisere sårbarheter. Tid. AI-sikkerhetsdiskusjoner, balanseringsfunksjonalitet med sikkerhet er en vanskelig oppgave for utviklere. Funksjoner som minneoppbevaring er verdifulle for personalisering, men deres misbruk kan erodere brukerens tillit og undergrave fordelene med AI. For å løse disse problemene, må selskaper iverksette proaktive tiltak, for eksempel strenge motstanders testing og gjennomsiktighet i hvordan minnesystemer fungerer.

Mens verktøy som Nemo-rekkverk og CLIO representerer viktige skritt fremover, er ingen system immun mot kreativ motstrid angrep. Bransjen må fortsette å utvikle forsvaret etter hvert som metodene som brukes av angripere blir mer sofistikerte. Samtidig kan utdanning om risikoer og begrensninger for AI-systemer mulighet til å samhandle med disse verktøyene mer forsiktig.