Microsoft har lagt DeepSeek R1, den banebrytende AI-resonnementsmodellen utviklet av Kina-baserte DeepSeek, til sin Azure AI Foundry-plattform til tross for en pågående undersøkelse av om selskapet feilaktig fikk tilgang til Openais API-data.

Beslutningen om å integrere DeepSeek R1 i Microsofts skytilbud reiser spørsmål om AI-datasikkerhet, konkurrerende dynamikk og regulatorisk tilsyn som Openai og Microsoft undersøker potensiell uautorisert bruk av proprietær modellutgang.

Relatert: Alibabas nye Qwen 2,5-max-modell tar på seg DeepSeek i AI-benchmarks

The inclusion of DeepSeek R1 in Azure AI Foundry reflects Microsoft’s continued expansion of its AI ecosystem, which already features models from OpenAI, Meta, Mistral, and Cohere.

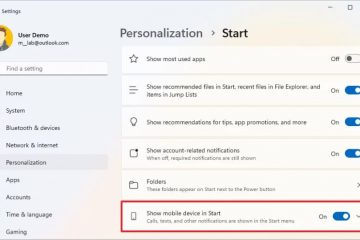

Microsoft uttalte at modellen gjennomgikk sikkerhetsvurderinger før den ble gjort tilgjengelig for bedriftskunder. I en offisiell uttalelse sa Asha Sharma, Microsofts visepresident for AI-plattformen,:”En av de viktigste fordelene ved å bruke DeepSeek R1 eller en hvilken som helst annen modell på Azure AI Foundry er hastigheten som utviklere kan eksperimentere, iterere og integrere AI i deres arbeidsfly Planer om å gi ut optimaliserte versjoner av DeepSeek R1 for Copilot+ PC-er, som tillater lokal utførelse gjennom nevrale prosesseringsenheter (NPUer). Og Openai undersøker uvanlige API-tilgangsmønstre

Mens DeepSeek R1s tekniske evner er blitt rost mye, har modellen også trukket kontroll over sine potensielle koblinger til Openais proprietære data.//www.bloomberg.com/news/articles/2025-01-29/microsoft-Probing-if-Ditepseek-kobling-group-improperly-awned-openai-data”> akkording til Bloomberg , Microsoft Security Researchers oppdaget en uvanlig pigg i Openai API-trafikk som stammer fra utviklerkontoer knyttet til Kina i slutten av 2024.

Rapporten vakte bekymring for at Openai-genererte utganger kan ha blitt brukt til å trene konkurrerende AI-modeller til en brøkdel av kostnadene Påkrevd for å utvikle en fundamentmodell fra bunnen av.

Verken Openai eller Microsoft har offentlig bekreftet om DeepSeek var direkte involvert i denne datatilgangen. Openai har imidlertid erkjent at den aktivt gjennomgår API-bruksmønstre og allerede har implementert strengere API-retningslinjer for å forhindre storskala datautvinning fra eksterne utviklere.

Undersøkelsen pågår, og Openai har ikke indikert om den vil ta rettslige tiltak eller innføre ytterligere begrensninger for tilgang til modellene.

DeepSeek R1s treningseffektivitet og markedseffekt

DeepSeek R1 skiller seg ut i AI-bransjen for sin evne til å oppnå høye resonnementytelser mens du bruker færre beregningsressurser enn konkurrerende modeller fra Openai og Google DeepMind.

I motsetning til Openais nyeste systemer, som krever omfattende GPU-klynger, ble DeepSeek R1 trent på 2.048 NVIDIA H800 GPUS, en modell designet for å overholde amerikanske handelsbegrensninger i AI-maskinvareeksport til Kina. Modellens effektivitet bidro til en midlertidig nedgang i Nvidias aksje, som falt med nesten 600 milliarder dollar da investorene revurderte den langsiktige etterspørselen etter avanserte AI-brikker.

Fremveksten av DeepSeek R1 har ført til diskusjoner om AI Maskinvareavhengighet for modelltrening. Mens modeller som GPT-4 krevde enorm beregningsinfrastruktur, antyder DeepSeek R1s evne til å utføre komplekse resonneringsoppgaver med et mindre GPU-fotavtrykk en alternativ tilnærming til AI-trening som kan gjøre høyytelsesmodeller mer tilgjengelige for et bredere spekter av utviklere.

U.S. og europeiske regulatorer gransket DeepSeek AI

DeepSeek R1 har også tiltrukket seg oppmerksomhet fra offentlige etater og regulatoriske organer på grunn av bekymring for visse emner og overholdelse av internasjonale personvernlover og for den anvendte CCP-sensuren for visse emner som 1989 Tiananmen Square Protests and Massacre eller den kinesiske ledelsen i general.

i Europa, Deepsek. R1 er under etterforskning for potensielle brudd på den generelle databeskyttelsesforordningen (GDPR). Italias databeskyttelsesmyndighet, Garante, har lansert en etterforskning om DeepSeek overfører europeiske brukerdata til Kina uten tilstrekkelige beskyttelsesregler eller avsløringer.

Hvis etterforskningen finner ut at DeepSeek ikke har oppfylt kravene til GDPR, kan selskapet møte bøter eller begrensninger på dens evne til å operere i europeiske markeder.

Det økte regulatoriske fokuset på DeepSeek AI gjenspeiler økende bekymring for sikkerheten og gjennomsiktigheten til AI-modeller utviklet utenfor USA og Europa.

Utover disse datasikkerhets-og reguleringsspørsmålene har DeepSeek R1 vekket bekymring for innholdsmoderasjon og potensiell sensur. En analyse utført av NewsGuard fant at modellen demonstrerte tung filtrering på politisk sensitive emner.

Studien rapporterte at DeepSeek R1 nektet å svare 85 Prosent av spørsmål relatert til Kina, særlig de som angår styring, menneskerettigheter og historiske hendelser. I tillegg ga modellen ufullstendige eller villedende svar i 83 prosent av faktabaserte nyhetsmessige spørsmål, noe Implementere ytterligere innholdsmoderasjonstiltak for DeepSeek R1 før de fullstendig integrerer det i AI-økosystemet. Funnene fra NewsGuard-studien antyder at bedrifter som distribuerer DeepSeek R1, bør være klar over potensielle begrensninger i modellens evne til å gi objektiv informasjon.

U.S. Navy ga nylig et direktiv som forbyr bruk av DeepSeek AI-modeller i begge Offisielle og personlige omgivelser, med henvisning til sikkerhetsrisiko forbundet med Kinas datapolitikk. Flyttingen er del av en bredere innsats fra amerikanske forsvarsbyråer for å begrense bruken av utenlandske utviklede AI-systemer i sensitive operasjoner.

Mens Microsoft har lagt vekt på at DeepSeek R1 besto sikkerhetsvurderinger før han ble lagt til Azure AI Foundry, antyder den pågående forskriftens kontroll at bedrifter bruker modellen fremdeles kan møte etter samsvarsutfordringer.

Microsofts utvidende AI-modellportefølje og dens risikoer

Ved å legge DeepSeek R1 til Azure AI Foundry, diversifiserer Microsoft sine AI-tilbud for å gi bedrifter flere modellvalg.

Selskapet har lagt vekt på viktigheten av å støtte et bredt spekter av AI-modeller for å la utviklere velge den mest passende teknologien for deres spesifikke behov. Imidlertid har inkluderingen av DeepSeek R1 mens det pågår en Openai-undersøkelse, reist spørsmål om Microsofts vetting-prosess for AI-partnerskap og dens tilnærming til å håndtere potensielle datasikkerhetsrisikoer.

Når Openai fortsetter å gjennomgå API-bruksmønstre, Microsofts Rollen i evaluering av integriteten til AI-modeller som er vert på sine skytjenester, vil sannsynligvis møte økt kontroll.