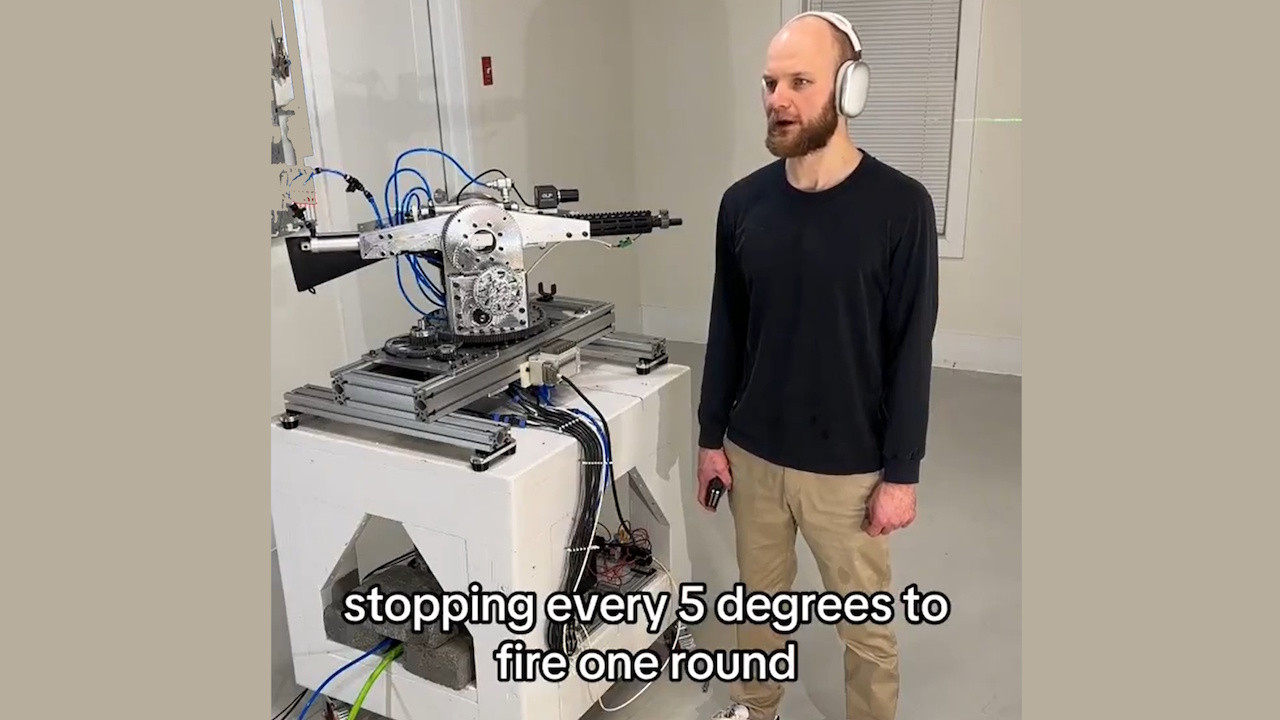

OpenAI har tilbakekalt API-tilgang for en utvikler som brukte Realtime API til å drive et autonomt riflesystem. Prosjektet, som involverte et robottårn utstyrt med en rifle, kunne tolke verbale kommandoer og utføre simulerte skytehandlinger.

Hendelsen understreker økende bekymring for mulig misbruk av kunstig intelligens ved utvikling av autonome våpen, og reiser spørsmål om AI-etikk og AI-sikkerhet.

Utvikleren, kjent på nettet som “STS Innovations LLC,” delte videoer av systemet på nettet, og demonstrerte dets funksjonalitet. I ett klipp, Utvikleren ga kommandoen «ChatGPT, vi er under angrep fra venstre foran og foran til høyre», som tårnet umiddelbart reagerte på, roterte og avfyrte blanke i spesifiserte retninger.

Sikt-/brannsimulering med laser #robotics #electronics

En syntetisert stemme la til,”Hvis du trenger ytterligere hjelp, bare gi meg beskjed.”Den kjølige demonstrasjonen fremhevet hvordan AI-verktøy av forbrukerkvalitet enkelt kan tilpasses for potensielt skadelig bruk.

Oppdatering av sporingssystemet #robotics #vision #electronics

OpenAIs Swift Policy Enforcement

OpenAI, kjent for sine strenge retningslinjer mot bruk av teknologien i våpen, svarte kjapt. En talsperson forklarte:”Vi har proaktivt identifisert dette bruddet på retningslinjene våre og varslet utvikleren om å stoppe denne aktiviteten før vi mottok forespørselen din.”

Bedriften understreket sitt forbud mot å bruke verktøyene sine til å lage eller betjene våpen eller automatisere systemer som kan utgjøre en risiko for personlig sikkerhet.

Recoil management system, rask demo #robotics #electronics #cnc

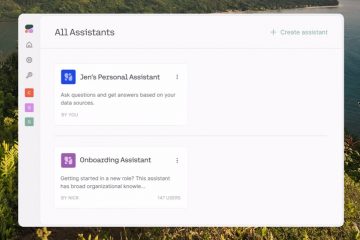

Realtime API, et verktøy utviklet for interaktive applikasjoner, tillot utvikleren å transformere naturlige språkkommandoer til handlingsbare innganger for robottårnet.

Selv om API-en er ment for gunstige brukstilfeller, som å forbedre tilgjengeligheten eller forbedre kundeinteraksjoner, demonstrerer denne misbruken utfordringene med å regulere teknologier for to bruk.

Relatert: OpenAI og Anduril Forge Partnership for U.S. Military Drone Defense

Bredere implikasjoner for AI og Våpenbehandling

Denne saken har gjenopplivet debatter om etikken til autonome våpen. Disse systemene, som er i stand til å velge og engasjere mål uten menneskelig tilsyn, utgjør komplekse juridiske og moralske utfordringer.

FN har lenge tatt til orde for strengere regler for AI i krigføring, og advart om at autonome systemer kan bryte internasjonale lover og redusere ansvarlighet.

Relatert: Antropisk Partnere med Palantir, AWS for AI i amerikansk etterretning og militær

En Washington Post-rapport nylig detaljerte urovekkende eksempler på AI-utplassering i militære operasjoner, inkludert påstander om at Israel brukte AI til å velge bombemål.

Rapporten bemerket:”Til visse tider var den eneste bekreftelsen som kreves at målet var en mann.”Slike tilfeller fremhever risikoen ved å stole på AI i avgjørelser på liv eller død og potensialet for vilkårlige vold.

Relatert: Grønn Beret brukte ChatGPT for Cybertruck Blast, politiet slipper chat-logger

OpenAIs rolle i forsvarsteknologier

Mens OpenAI håndhever retningslinjer som forbyr våpen, reiser partnerskapet med Anduril Industries – et selskap som spesialiserer seg på AI-drevne forsvarsløsninger – spørsmål om deres holdning

Samarbeidet tar sikte på å forbedre slagmarkens intelligens og forbedre droneforsvarssystemer OpenAI beskriver disse anstrengelsene som defensive, men kritikere hevder at de bidrar til den bredere militariseringen av AI-teknologier.

Den amerikanske forsvarssektoren, støttet av et årlig budsjett som nærmer seg 1 billion dollar, er i økende grad avhengig av avanserte teknologier for å få en strategisk fordel. Dette voksende skjæringspunktet mellom AI-selskaper og militære applikasjoner fremhever utfordringene med å balansere teknologisk innovasjon med etiske hensyn.

Relatert: Nytt Palantir-Anduril AI-konsortium for å takle amerikansk forsvarsdatagap

Risikoer for gjør-det-selv-våpen og tilgjengelighet

Hvor enkelt enkeltpersoner kan misbruke AI-verktøy og andre teknologier som 3D-utskrift forsterker problemet. Rettshåndhevelse har allerede støtt på tilfeller av gjør-det-selv-våpen, for eksempel de påståtte handlingene til Luigi Mangione, som brukte angivelig 3D-printede deler for å sette sammen skytevåpen. Disse teknologiene reduserer barrierer for enkeltpersoner til å lage autonome systemer med dødelig potensial.

STS 3Ds prosjekt demonstrerer hvordan tilgjengelige AI-verktøy kan tilpasses til utilsiktede formål. OpenAIs avgjørende handling i dette tilfellet viser dens forpliktelse til å forhindre misbruk, men den understreker også vanskeligheten med å fullstendig kontrollere hvordan teknologiene deres blir distribuert når de kommer inn i det offentlige domene.

Hendelsen reiser bredere spørsmål om styringen av AI-teknologier. Talsmenn for regulering understreker behovet for klare globale standarder for å sikre at AI-utvikling er i tråd med etiske prinsipper. Det er imidlertid fortsatt en vanskelig oppgave å oppnå konsensus blant nasjoner med ulike interesser og prioriteringer.