OpenAI har utvidet sine utviklertilbud ved å rulle ut fullversjonen av sin o1-modell gjennom API-en. Denne avanserte resonneringsmodellen, som utmerker seg ved komplekse, flertrinnsoppgaver, introduserer nye funksjoner som lover å omforme hvordan utviklere bygger AI-drevne applikasjoner.

Oppdateringen er en del av «12 Days of OpenAI»-serien med kunngjøringer, der selskapet slipper nye funksjoner og oppdateringer for sine hovedprodukter.

I tillegg til o1-modellen har OpenAI annonserte også forbedringer av Realtime API for stemmeinteraksjoner og en ny preferansefinjusteringsmetode, som gir utviklere enestående fleksibilitet.

o1-2024-12-17-modellen erstatter o1-forhåndsversjonen som ble lansert tidligere i år, den oppdaterte modellen tilbyr”mer omfattende og nøyaktige svar, spesielt for spørsmål knyttet til programmering og virksomhet, og er mindre sannsynlig å feilaktig avslå forespørsler.”

Disse forbedringene, kombinert med en 60 % reduksjon i bruk av resonnementtokener, gjør o1-modellen raskere, mer effektiv og mer allsidig.

[innebygd innhold]

Avanserende resonnement via API med o1-modellen

OpenAIs o1-modell er designet for å takle oppgaver som krever logisk konsistens og analytisk dybde, overgå tidligere iterasjoner på benchmarks som SWE-Bench Verified og AIME.

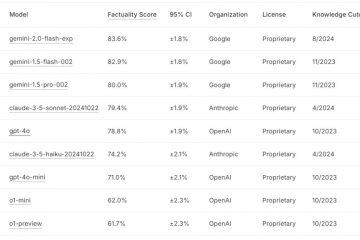

OpenAI rapporterer at nøyaktigheten for programmeringsoppgaver har økt fra 52,3 % til 76,6 %, mens ytelsen på matematiske problemer hoppet fra 42 % til nesten 80 %.

Kilde: OpenAI

En fremtredende funksjon er strukturert utdatastøtte, som lar utviklere generere svar i forhåndsdefinerte formater som JSON.

Dette sikrer sømløs integrasjon med eksterne systemer som APIer og databaser, noe som gjør modellen ideell for applikasjoner innen kundestøtte, logistikk og dataanalyse.

Modellen introduserer også visuelle resonneringsmuligheter, muliggjør analyse av bilder for oppgaver som feilsøking eller vitenskapelig forskning. For eksempel kan utviklere nå legge inn visuelle data, for eksempel skannede dokumenter eller tegninger, og motta kontekstbevisste svar.

I tillegg lar en ny”resonneringsinnsats”-parameter utviklere kontrollere hvor lang tid modellen bruker på hver oppgave, og balanserer presisjon og effektivitet.

OpenAI forklarte i bloggen sin,”Vi ruller ut tilgang trinnvis mens du jobber med å utvide tilgangen til flere bruksnivåer og øke hastighetsgrensene.”

Forbedre stemmeinteraksjoner med sanntid API

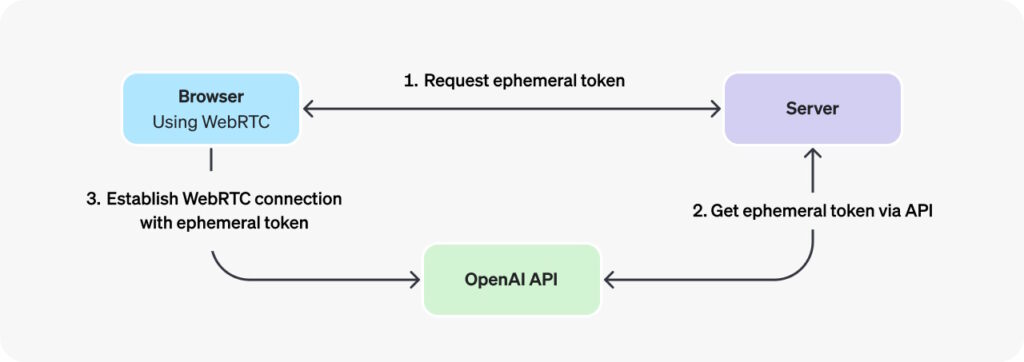

OpenAI har også gjort betydelige oppdateringer til Realtime API, som driver sanntids stemmeinteraksjoner. Tillegget av WebRTC, Web Real-Time Communication – en protokoll for kommunikasjon med lav latens – gjør det mulig for utviklere å lage sømløse taleapplikasjoner for virtuelle veiledere, assistenter og oversettelsesverktøy. Den muliggjør peer-to-peer (P2P)-tilkoblinger uten å kreve ekstra plugins eller programvare.

OpenAI fremhevet fordelene med WebRTC, som sier,”I scenarier der du ønsker å koble til en sanntidsmodell fra en usikker klient over nettverket (som en nettleser), anbefaler vi å bruke WebRTC tilkoblingsmetode. WebRTC er bedre rustet til å håndtere variable tilkoblingstilstander, og gir en rekke praktiske API-er for å fange opp brukerlydinnganger og spille av eksterne lydstrømmer fra modellen.»

Implementeringen av WebRTC bruker såkalte flyktige tokens, midlertidige API-nøkler spesielt designet for sikker autentisering av klientsideapplikasjoner når du kobler til OpenAI Realtime API over WebRTC. Formålet deres er å sikre en sikker, kortvarig autentiseringsmekanisme som unngår å eksponere sensitive standard API-nøkler direkte i klientmiljøer som nettlesere.

Bilde: OpenAI

Bilde: OpenAI

Oppgraderingene til Realtime API forenkle utviklingsprosessen, redusere koden som kreves for taleapplikasjoner, samtidig som lydkvaliteten og responsnøyaktigheten forbedres. Utviklere kan nå bygge applikasjoner som begynner å formulere svar mens brukerne fortsatt snakker, noe som øker responsen.

Prisjusteringer gjør taleapplikasjoner mer tilgjengelige. Kostnaden for GPT-4o-lydtokens er redusert med 60 %, mens bufrede input-tokens nå er 87,5 % billigere. OpenAI har også introdusert GPT-4o mini, et kostnadseffektivt alternativ for utviklere som leter etter rimelige alternativer, priset til $10 per million input tokens.

Foredling av AI-atferd med preferansefinjustering

Preferansefinjustering er en ny tilpasningsmetode som lar utviklere avgrense modellatferd basert på sammenlikninger av svar. I motsetning til tradisjonell finjustering, som er avhengig av eksakte input-output-par, lærer preferansefinjustering modellen å skille mellom foretrukne og mindre ønskelige svar.

OpenAI beskriver denne metoden som spesielt effektiv for subjektive oppgaver, som f.eks. som å skreddersy tone og stil i kreativ skriving eller å sikre samsvar med spesifikke formateringskrav. I følge OpenAI rapporterte tidlige brukere som et finansanalysefirma at preferansefinjustering forbedret svarnøyaktigheten med 5 % for komplekse spørringer utenfor distribusjon.

“Vi begynte å teste Preference Fine-Tuning med pålitelige partnere som har sett lovende resultater så langt. For eksempel bygger Rogo AI(åpnes i et nytt vindu) en AI-assistent for finansanalytikere som bryter ned komplekse søk i undersøk.

Ved å bruke deres ekspertbygde benchmark, Rogo-Golden, fant de ut at mens Supervised Fine-Tuning møtte utfordringer med utvidelse av søk utenfor distribusjon – for eksempel manglende beregninger som ARR for søk som «hvor raskt er selskapet X vokser”—Preference Fine-Tuning løste disse problemene, og forbedret ytelsen fra 75 % nøyaktighet i basismodellen til over 80 %.”

Utvider SDK-alternativer for utviklere

For å støtte et bredere spekter av programmeringsmiljøer, har OpenAI også introdusert offisielle SDK-er for Gå og Java, ved siden av dets eksisterende biblioteker for Python, Node.js og.NET. Disse SDK-ene forenkler integrasjonen, og gjør det mulig for utviklere å distribuere AI-modeller i skalerbare backend-systemer eller bedriftsapplikasjoner.

Go SDK er designet for lette og effektive server-side-applikasjoner, mens Java SDK henvender seg til bedriftsbaserte løsninger, og tilbyr sterk skriving og robust støtte for store prosjekter. OpenAIs dokumentasjon gir detaljert veiledning for å utnytte disse nye verktøyene.

Tidligere kunngjøringer under «12 Days of OpenAI»

16. desember laget OpenAI sin ChatGPT funksjonen for live nettsøk tilgjengelig for alle brukere, slik at alle kan hente oppdatert informasjon direkte fra nettet.

14. desember førte til nye tilpasningsalternativer ChatGPT, som lar brukere strømlinjeforme oppgaver og administrere prosjekter på en effektiv måte, lar brukere gruppere chatter, filer og tilpassede instruksjoner i dedikerte mapper, og skaper et organisert arbeidsområde for administrasjon av oppgaver og arbeidsflyter.

Som en enorm forbedring. avansert stemmemodus for ChatGPT, OpenAI 12. desember la til synfunksjoner, slik at brukere kan dele live video og skjermer for sanntidsanalyse og assistanse.

11. desember lanserte OpenAI Canvas, et samarbeidsredigeringsarbeidsområde som tilbyr avanserte verktøy for både tekst-og kodeforbedring. Canvas ble opprinnelig lansert i betaversjon i oktober 2024, og erstatter ChatGPTs standardgrensesnitt med et delt-. skjermdesign, slik at brukere kan jobbe med tekst eller kode mens de deltar i samtaleutveksling med AI.

Tillegget av Python utførelse er en fremtredende funksjon i Canvas, som gjør det mulig for utviklere å skrive, teste og feilsøke skript direkte på plattformen. OpenAI demonstrerte nytten sin under et live-arrangement ved å bruke Python til å generere og avgrense datavisualiseringer. OpenAI beskrev funksjonen som «redusere friksjon mellom idégenerering og implementering».

Den 9. desember lanserte OpenAI offisielt Sora, dets avanserte AI-verktøy for å generere videoer fra tekstmeldinger, som signaliserer en ny æra for kreativ AI. Integrert i betalte ChatGPT-kontoer, lar Sora brukere animere stillbilder, utvide eksisterende videoer og slå sammen scener til sammenhengende fortellinger.

Utgitt 7. desember ble Reinforcement Fine-Tuning som et nytt rammeverk designet for å muliggjøre tilpasning av AI-modeller for bransjespesifikke applikasjoner. Det er OpenAIs siste tilnærming til å forbedre AI-modeller ved å trene dem med utviklerleverte datasett og karaktersystemer. I motsetning til tradisjonell overvåket læring, som fokuserer på å gjenskape ønskede resultater

5. desember avduket OpenAI ChatGPT. Pro, et nytt premium abonnementsnivå priset til $200 per måned, rettet mot profesjonelle og bedrifter som søker avanserte AI-funksjoner for arbeidsflyter med høy etterspørsel.