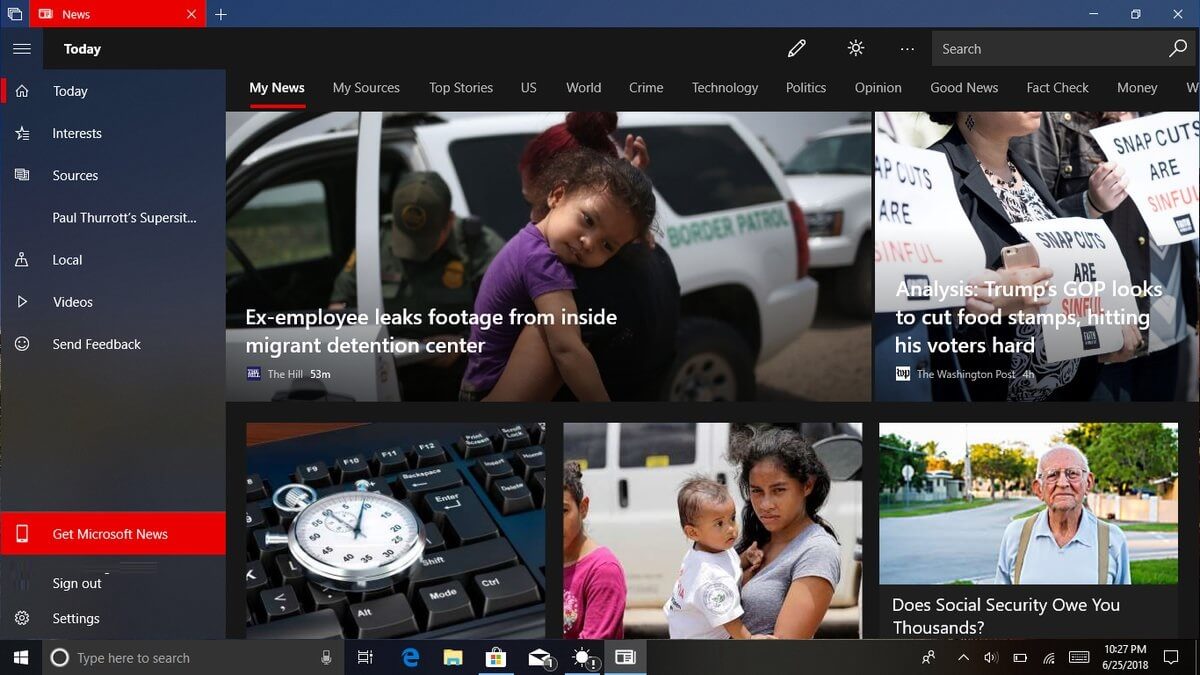

Microsofts MSN-nyhetsportal er under gransking etter å ha publisert en AI-generert artikkel som merket den nylig avdøde NBA-spilleren, Brandon Hunter, som «ubrukelig». gikk viralt, noe som førte til omfattende kritikk.

Artikkelen, som tilsynelatende var AI-generert, beskrev den 42 år gamle tidligere NBA-spillerens bortgang på en usmakelig måte, med setninger som”utlevert”og”fremført i 67 videospill.”Denne hendelsen har skapt bekymring for påliteligheten og sensitiviteten til AI-generert innhold, spesielt når det gjelder sensitive emner som nekrologer.

En tidligere NBA-spiller dør ung, og AI skriver denne overskriften:

“Brandon Hunter useless at 42”

Og sjekk den prosaen:

“Tidligere NBA-deltaker Brandon Hunter som på forhånd opptrådte for Boston Celtics og Orlando Magic, har gitt seg i en alder av 42.”https://t.co/xEvVVHo9DP pic.twitter.com/EiKlZEhluS

— Joshua Benton (@jbenton) 14. september 2023

Tidligere AI-ulykker hos Microsoft

Dette er ikke første gang Microsoft News AI-initiativer kommer under ild. I august 2023 anbefalte en AI-generert reiseguide på MSN-nyhetsportalen på en bisarr måte en lokal matbank i Ottawa, Canada, som en turistattraksjon. Til tross for disse gjentatte tabberne, fortsetter Microsoft å stole sterkt på AI-generert innhold.

I 2020 avskjediget selskapet til og med teamet av MSN-journalister, noe som førte til en økning i AI-genererte artikler på plattformen. Noen av disse artiklene har blitt kritisert for å være faktisk unøyaktige, dårlig komponert eller til og med plagiert.

The Broader Impplications of AI in Journalism

De nylige kontroversene rundt Microsofts AI-genererte innhold fremhever de bredere utfordringene og implikasjonene ved å integrere AI i journalistikk. Selv om AI kan generere innhold raskt og i stor skala, mangler den den menneskelige berøringen, følsomheten og dømmekraften som kreves for visse emner.

Hendelsen med Brandon Hunters nekrolog fungerer som en sterk påminnelse om de potensielle fallgruvene ved å stole på også tungt på AI for innholdsgenerering. Ettersom AI fortsetter å spille en mer fremtredende rolle i journalistikk, er det avgjørende for utgivere å finne den rette balansen mellom automatisering og menneskelig tilsyn for å opprettholde tillit og troverdighet.

Microsoft utnytter den samme AI-innholdsgenereringen som underbygger Bing Chat AI-søk chatbot. Dette kan være problematisk fordi Bing Chat er en svært upålitelig informasjonskilde. Jeg har sluttet å bruke Bing Chat som noen form for passende søke-/forskningsverktøy. Microsofts chatbot er rett og slett for tilfeldig med sannheten, inkludert å gi falske sitater, finne opp navn og generelt få mindre – men viktige – detaljer feil.

Bing Chat dobler også ned på unøyaktighetene, argumenterer og blir lett veldig forvirret. Dette er viktig fordi det betyr at brukere må mikroadministrere boten, bruke veldig klare instruksjoner og være villige til å faktasjekke alt den produserer. Dette er tidkrevende og lite effektivt for det som skal være et søkeverktøy.

Hvis resultatene av søk ikke kan stole på, hva er vitsen med å bruke Bing Chat? Det er en lignende situasjon med å bruke den til enhver form for innholdsskaping. Hvis det er nødvendig å faktasjekke alt og bruke flere meldinger, hjelper disse verktøyene oss virkelig?