Kuaishou, en fremtredende kort videoplattform basert i Beijing, avduket sin egenutviklede store språkmodell kalt KwaiYii til offentligheten forrige uke, ifølge en rapport fra TechNode. Videre avduket selskapet også sin forskning på Spiking Neural Networks og utviklingen av SpikeGPT.

Denne utgivelsen kommer etter en beta-testfase for en ChatGPT-lignende tjeneste for Android-enheter som startet 18. august. Dialogtjenesten, som kan skryte av 13 milliarder parametere forankret i KwaiYii, konkurrerer med OpenAI GPT-3.5 i sin kapasitet for innholdsoppretting, konsultasjon og problemløsning.

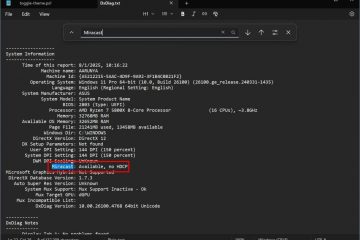

LLM er detaljert på KwaiYiis GitHub-side. Den primære applikasjonen for Kuaishous AI-chatbot har vært søk, ved å bruke originalt innhold fra plattformen for å adressere AI-“hallusinasjoner”– unøyaktigheter som følge av utilstrekkelig dataopplæring.

SpikeGPT: A Leap in Energy Efficiency

Kuaishou posisjonerer seg som en stor kraft i AI-forskning og-utvikling, både i offentlige mainstream-produkter og FoU-prosjekter. KwaiYii er et eksempel på mainstream offentlig AI, mens Kuaishou også denne uken diskuterte SpikeGPT, et eksempel på AI-forskningsinnsatsen.

Beregningskravene av moderne store språkmodeller (LLMs) er betydelige. Imidlertid har Spiking Neural Networks (SNNs) blitt identifisert som en mer energi-effektivt alternativ til konvensjonelle kunstige nevrale nettverk, selv om deres effektivitet i språkgenereringsoppgaver forblir ukjent.

Et forskningssamarbeid mellom University of California og Kuaishou Technology har introdusert SpikeGPT (via Synced Review), den første generative spiking neural network (SNN) språkmodell. Denne modellen, med sin 260M parameterversjon, matcher ytelsen til dypnevrale nettverk (DNN) ) samtidig som den beholder de energibesparende fordelene med spikebaserte beregninger.

SpikeGPT er en generativ språkmodell preget av rene binære, hendelsesdrevne spikeaktiveringsenheter. Den integrerer gjentakelse i en transformatorblokk, noe som gjør den kompatibel med SNN-er. Denne integrasjonen eliminerer ikke bare den kvadratiske beregningskompleksiteten, men letter også representasjonen av ord som hendelsesdrevne topper.

Modellen kan behandle strømming av data ord for ord, og starte beregning selv før dannelsen av en hel setning, mens de fortsatt fanger langdistanseavhengighetene i intrikate syntaktiske strukturer. Forskerteamet har også innlemmet ulike teknikker for å forbedre SpikeGPTs ytelse, for eksempel et binært innebyggingstrinn, en token shift-operatør og en vanilje RWKV for å erstatte den tradisjonelle selvoppmerksomhetsmekanismen.

Forstå spiking. Nevrale nettverk

Spiking neurale nettverk (SNN) er en type kunstig nevrale nettverk som er inspirert av måten biologiske nevroner fungerer på. I SNN-er kommuniserer nevronene med hverandre ved å sende pigger, som er korte utbrudd av elektrisk aktivitet. Piggene er ikke kontinuerlige, men oppstår snarere med diskrete tidsintervaller. Dette er i motsetning til tradisjonelle kunstige nevrale nettverk, som bruker kontinuerlige verdier for å representere aktiveringen av nevroner.

SNN-er har flere potensielle fordeler fremfor tradisjonelle kunstige nevrale nettverk. For det første er de mer energieffektive. Dette er fordi piggene bare sendes når det er nødvendig, i stedet for kontinuerlig. For det andre er SNN-er mer biologisk realistiske. Dette gjør dem til et godt valg for applikasjoner som krever høy grad av realisme, som robotikk og medisinsk bildebehandling.

SNN har imidlertid også noen utfordringer. En utfordring er at de er vanskeligere å trene enn tradisjonelle kunstige nevrale nettverk. Dette er fordi toppene er diskrete hendelser, noe som gjør det vanskelig å forplante feilen tilbake gjennom nettverket. En annen utfordring er at SNN-er ikke er like godt forstått som tradisjonelle kunstige nevrale nettverk. Dette gjør det vanskelig å designe og optimalisere SNN-er for spesifikke oppgaver.

Hvordan SpikeGPT presterer

I en empirisk studie ble SpikeGPT trent med tre forskjellige parameterskalaer (45M, 125M og 260M parametere) og ble benchmarked mot transformatorbaselinjer som Reformer, Synthesizer, Linear Transformer og Performer ved å bruke Enwik8-datasettet. Resultatene avslørte at SpikeGPT leverte sammenlignbare resultater med 22 ganger færre synaptiske operasjoner (SynOps).

Denne forskningen understreker potensialet ved å trene store SNN-er for å utnytte fremskritt innen transformatorer, noe som antyder en betydelig reduksjon i LLMs beregningsbehov ved å bruke hendelsesdrevne spikeaktiveringer på språkgenerering. Forskerne har uttrykt sin intensjon om å fortsette å foredle modellen sin og vil oppdatere sitt forhåndstrykk tilsvarende. Koden for SpikeGPT er tilgjengelig på prosjektets GitHub, og papir som beskriver modellen er tilgjengelig på arXiv.