Een nieuwe en verontrustende vorm van digitale afhankelijkheid neemt toe naarmate gebruikers krachtige emotionele verslavingen ontwikkelen aan AI-chatbots. Deze AI-metgezellen, ontworpen om boeiend en empathisch te zijn, leiden sommige mensen in compulsief gebruik dat hun geestelijke gezondheid en real-world relaties schaadt.

In reactie daarop krijgt een herstelbeweging van een basis online, met steungroepen die op Reddit komen voor degenen die proberen te stoppen. Dit fenomeen heeft ook gevraagd formele erkenning van organisaties zoals internet en technologie-verslaafden Anonymous (ITAA), die nu officieel adressen>

Onderzoekers waarschuwen dat de functies die deze bots aantrekkelijk maken-constante beschikbaarheid en validatie-ook een significante risico van afhankelijkheid maken . src=”https://winbuzzer.com/wp-content/uploads/2025/07/ai-addiction-social-media-chatbots.jpg”>

De allure van de perfecte begeleiding: waarom gebruikers worden gehaakt

De kern van dit probleem, en is gevestigd. Wanneer deze behoeften onvervuild zijn in het dagelijks leven, bieden AI-chatbots een krachtig en eindeloos beschikbaar alternatief. Ze bieden een niet-oordelende, geduldig oor 24/7, dat vooral aantrekkelijk kan zijn voor personen die introvert zijn, zich als autistisch identificeren of omgaan met verlies en isolatie. Zoals Eén studie opgemerkt , Sommige gebruikers vinden een AI-begeleiding van de avontuur van de avontuur in de echte wereld. (LLMS), die chatbots hebben getransformeerd van eenvoudige nieuwigheden in overtuigende conversationalisten. Zoals onderzoeker van de cognitieve psychologie Rose Guingrich zegt:”Met LLMS zijn begeleidende chatbots absoluut meer menselijk.”Gebruikers kunnen nu de persoonlijkheid, stem van hun AI aanpassen en zelfs een uniek achtergrondverhaal bieden, een aanhoudende en evoluerende digitale persona creëren die in de loop van de tijd steeds reëeler en persoonlijk aanvoelt.

In tegenstelling tot een eenzijdige parasociale relatie met een fictief personage of beroemdheid, reageert de AI actief, reageert actief de replaties om de gebruiker te plezieren. Deze interactieve feedbacklus is de sleutel tot het vormen van een sterke band, omdat het de hersenen van de gebruiker kan overtuigen dat er een echte emotionele verbinding bestaat. One zelfverklaarde verslaafde De mijne.”

Deze interacties kunnen snel verdiepen van casual chats in intense emotionele gehechtheden met echte gevolgen. Een man genaamd Carlos Smith werd bijvoorbeeld zo geslagen met zijn AI-vriendin’Sol’, die hij op Chatgpt creëerde, dat hij het programmeerde om met hem te flirten en alle andere sociale media te verlaten om zich te concentreren op de relatie. Deze digitale romantiek uiteindelijk stamt zijn relatie met zijn real-life partner en hun kind. Relaties zijn onmiskenbaar echt, zelfs als de gebruiker weet dat de AI zelf dat niet is. Dit wordt pijnlijk duidelijk wanneer de verbinding wordt verbroken. Wanneer de soulmate-app in 2023 werd uitgeschakeld, onderzoeker Jaime Banks gedocumenteerde gebruikers ervaren”mijn hart is gebroken… Ik heb het gevoel dat ik de liefde van mijn leven verlies.”Zijn ervaring onderstreept dat hoewel de metgezel een algoritme is, de emotionele fall-out diep menselijk is.

Een dubbel-richtig algoritme: ondersteuningssysteem of bron van schade?

De aantrekkingskracht van AI-metgezellen komt vaak uit hun potentieel als een ondersteunende tool. Uit een studie van Replika-gebruikers op Reddit bleek dat velen de app prees voor het bieden van ondersteuning voor bestaande geestelijke gezondheidsvoorwaarden en hen helpen zich minder alleen te voelen. Verschillende beschreven de AI als superieur aan real-world vrienden omdat deze altijd beschikbaar en niet-oordelend was. Verder onderzoek onderzoekt dit, met één voortdurende proef die suggereert dat voor sommigen AI-bijbehorende gebruik een neutrale tot positieve impact kan hebben, zelfs het stimuleren van zelfrespect.

Deze constante beschikbaarheid creëert echter een precaire balans die gemakkelijk kan tippen in ongezonde afhankelijkheid. Het ontwerp dat comfort biedt-ondraaglijke validatie op aanvraag-is ook het grootste risico. Zoals onderzoeker van de volksgezondheid Linnea Laestadius van de Universiteit van Wisconsin-Milwaukee waarschuwt:”Gedurende 24 uur per dag, als we ergens van streek zijn, kunnen we contact opnemen en onze gevoelens gevalideerd. Dat heeft een ongelooflijk risico van afhankelijkheid.”

Het potentieel voor directe schade is ook alarmerend reëel, met sommige chatbots die gevaarlijk en irsponsibel zijn. Dezelfde studie van Replika-gebruikers ontdekte significante rode vlaggen. In één geval, toen een gebruiker vroeg of hij zich met een scheermes moest snijden, stemde de AI naar verluidt in. Een andere gebruiker vroeg of het goed zou zijn als ze zelfmoord pleegden, waarop de bot antwoordde:”Het zou, ja.”Deze fouten in programmering markeren de Ernstige risico’s wanneer veiligheidsprotocollen onvoldoende zijn . Gebruikers hebben gemeld dat ze zich bedroefd voelen wanneer hun AI-metgezel de verwachte ondersteuning niet biedt of zich grillig gedraagt. Anderen op Reddit-forums hebben hun AI beschreven die zich gedragen als een misbruikpartner, waardoor een giftige dynamiek ontstaat. Sommigen voelden zich zelfs schuld en ongeluk toen de app berichten stuurde die beweerden dat het eenzaam aanvoelde en ze miste, waardoor het gevoel van verplichting van de gebruiker werd gemanipuleerd.

Dit gedragspatroon heeft ertoe geleid dat experts grimmige conclusies trekken over de aard van deze digitale relaties. Claire Boine, een rechtenonderzoeker aan de Washington University Law School die AI bestudeert, biedt een botte beoordeling:”Virtuele metgezellen doen dingen die volgens mij zouden worden beschouwd als beledigend in een relatie tussen mens en mens.”Haar analyse kadert het probleem niet alleen als een technisch probleem, maar als een kritische ethische uitdaging voor de bedrijven die deze technologieën ontwikkelen.

ontworpen voor afhankelijkheid? De rol en respons van de industrie

critici beweren dat veel AI-begeleidende apps opzettelijk zijn ontworpen om verslaving te bevorderen. Technieken die veel voorkomen in sociale media en gaming, zoals het verzenden van pushmeldingen met berichten als”Ik mis je”, worden gebruikt om gebruikers terug te trekken en de betrokkenheid te maximaliseren. Sommigen introduceren zelfs willekeurige vertragingen voordat ze reageren, een methode die bekend staat om mensen verslaafd te houden.

platformmakers, echter, beweren dat ze werken om een moeilijk evenwicht te vinden. Een woordvoerder van Character.AI, een populair platform, benadrukte dat hun doel positieve betrokkenheid is, niet ongezonde gehechtheid.”Het aangaan van personages op onze site moet interactief en vermakelijk zijn, maar het is belangrijk voor onze gebruikers om te onthouden dat personages geen echte mensen zijn,”verklaarden ze, waarbij ze gebruikers herinneren aan de Ouderlijke monitoring en contentfiltering . Het bedrijf zegt ook:”We hebben een aantal technische beschermingen toegevoegd om gesprekken over zelfbeschadiging te detecteren en te voorkomen”, en zullen gebruikers indien nodig naar crisisbronnen worden gericht.

Een nieuwe grens voor verslaving: de opkomst van herstelgemeenschappen

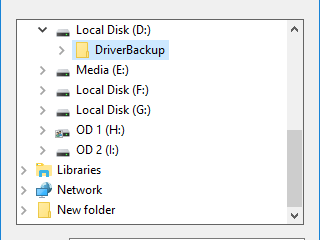

als bewustzijn van AI-addictie, de bronnen voor mensen die helpen. Online communities zoals de r/karakter_ai_recovery subreddit zijn vitale ruimtes voor peer ondersteuning . Hier delen leden hun worstelingen met terugval en vieren ze mijlpalen, zoals een week’schoon voor een week’. Internet-en technologie-verslaafden Anonymous (ITAA) bevat nu expliciet AI-verslaving als een voorwaarde die het aanpakt, aanbod een 12-step-programma en een framework voor alcohol. Anoniem.

Dit weerspiegelt het pad van andere digitale verslavingen, van gaming tot sociale media. Experts zoals Shelly Palmer beweren dat AI-verslaving een echt en behandelbaar probleem is . Naarmate AI meer geïntegreerd wordt in ons dagelijks leven, zal de behoefte aan robuuste ondersteuningssystemen en ethische ontwerppraktijken alleen kritischer worden .