Om de wrijving tussen academische integriteit en geautomatiseerde kostenbesparingen aan het licht te brengen, hebben studenten van de Staffordshire University in Groot-Brittannië een opstand gelanceerd tegen een codeermodule die voornamelijk wordt onderwezen door’hallucinerende’algoritmen.

Opnames die deze week zijn opgedoken onthullen lezingen van AI-voice-overs die accenten veranderen en irrelevante Amerikaanse wetgeving citeren, wat aanleiding geeft tot beschuldigingen van een’dubbele standaard’.

Hoewel de universiteit dreigt met uitzetting van studenten die tools als ChatGPT gebruiken, verdedigt ze haar eigen geautomatiseerde instructie als een geldig ‘framework’, waarbij de grote kloof wordt benadrukt tussen de ‘empowerment van docenten’ die wordt beloofd door leveranciers als OpenAI en de realiteit van lage kwaliteit van de implementatie.

De opstand: ‘luie’ AI in de collegezaal

De implementatie van AI in het door de overheid gefinancierde stageprogramma van Staffordshire lijkt niet louter te zijn gedreven door pure De cursus is ontworpen om professionals om te scholen tot software-ingenieurs volgens door de overheid gefinancierde leerlingnormen en werd snel ontrafeld toen studenten tijdens de eerste lezing het gebruik van generatieve tools “vrijwel onmiddellijk” ontdekten.

De deelnemers werden niet begroet door een menselijke expert, maar door een PowerPoint-presentatie vergezeld van een gesynthetiseerde voice-over die de tekst woordelijk voorleest, gerapporteerd door The Guardian.

Technische problemen brachten al snel de gebrek aan menselijk toezicht. In een bijzonder schokkend voorbeeld, vastgelegd op video, veranderde de voice-over op onverklaarbare wijze gedurende 30 seconden van een Brits naar een Spaans accent voordat het terugkeerde, een duidelijk artefact van het ongecontroleerd genereren van tekst-naar-spraak.

Naast de audiodefecten had het leerplan zelf last van ‘hallucinaties’ – de neiging van Large Language Models (LLM’s) om feiten te verzinnen. Het cursusmateriaal was bedoeld om studenten voor te bereiden op de Britse arbeidsmarkt en citeerde vaak irrelevante Amerikaanse wetgeving, een veel voorkomende fout als modellen niet goed zijn gebaseerd op lokale gegevens.

Onafhankelijke analyse met behulp van detectietools Winston AI en Originality AI bevestigde later een “zeer grote waarschijnlijkheid” dat opdrachten en presentaties door machines werden gegenereerd.

De frustraties kwamen over in een opgenomen sessie in oktober 2024 waarin een student de docent rechtstreeks confronteerde. Hij eiste de verwijdering van het geautomatiseerde materiaal en zei:”Ik weet dat deze dia’s door AI zijn gegenereerd… Ik heb liever dat je deze dia’s gewoon schrapt. Ik wil geen les krijgen van GPT.”

In reactie op de confrontatie lachte de docent ongemakkelijk voordat hij toegaf dat hij op”korte termijn”een tutorial had gemaakt met behulp van ChatGPT.

Studenten beschreven het resulterende materiaal als”algemene, oppervlakkige informatie”, en schatten dat alleen maar “5% bestond uit nuttige nuggets”, terwijl de rest uit repetitieve opvulling bestond. Eén student merkte de ironie van de situatie op:”Er zit wat goud op de bodem van deze pan. Maar vermoedelijk zouden we het goud zelf kunnen krijgen door het aan ChatGPT te vragen.”

De dubbele integriteitsnorm

Wat de frustratie nog groter maakt, is de grimmige hypocrisie van de handhaving van academische normen door de universiteit. Publieke richtlijnen stellen expliciet dat studenten die werk uitbesteden aan AI of gegenereerde inhoud als hun eigen afspiegeling zien, worden uitgesloten van academisch wangedrag.

Toch uploadde de administratie tegelijkertijd een beleidsverklaring naar de cursussite waarin ze haar eigen methoden rechtvaardigde onder een “raamwerk voor academische professionals die gebruik maken van AI-automatisering.”

Een woordvoerder van de universiteit verdedigde de praktijk en beweerde dat “AI-hulpmiddelen elementen van voorbereiding kunnen ondersteunen, maar ze vervangen de academische expertise niet en moeten altijd worden gebruikt op manieren die de academische wereld hoog houden integriteit.”

Het bewijsmateriaal – met name het gebruik van AI-voice-overs voor daadwerkelijke levering in plaats van alleen maar voorbereiding – suggereert een directe vervanging van menselijke arbeid.

Studenten beweren dat dit een schending van het onderwijscontract inhoudt. De student merkte op dat hij het gevoel had dat hij “twee jaar” van zijn leven had besteed aan een “goedkope” oplossing. In een poging de opstand te onderdrukken schakelde de regering menselijke docenten in voor de laatste sessie, een stap die studenten afdeden als ‘te weinig, te laat’.

Dergelijke wrijvingen gelden niet alleen voor Staffordshire. Uit bredere Britse gegevens uit het rapport over de studentenperceptie uit 2025 van Jisc blijkt dat, hoewel 86% van de universiteiten AI-richtlijnen heeft ingevoerd, de toepassing van deze regels vaak bestraffend aanvoelt voor studenten, terwijl ze tolerant zijn voor het personeel.

Financieel gezien zijn de implicaties aanzienlijk: studenten op door de overheid gefinancierde trajecten voelen de gevolgen Het instituut steekt het verschil tussen het collegegeld voor mensen en de exploitatiekosten van AI in zijn zak.

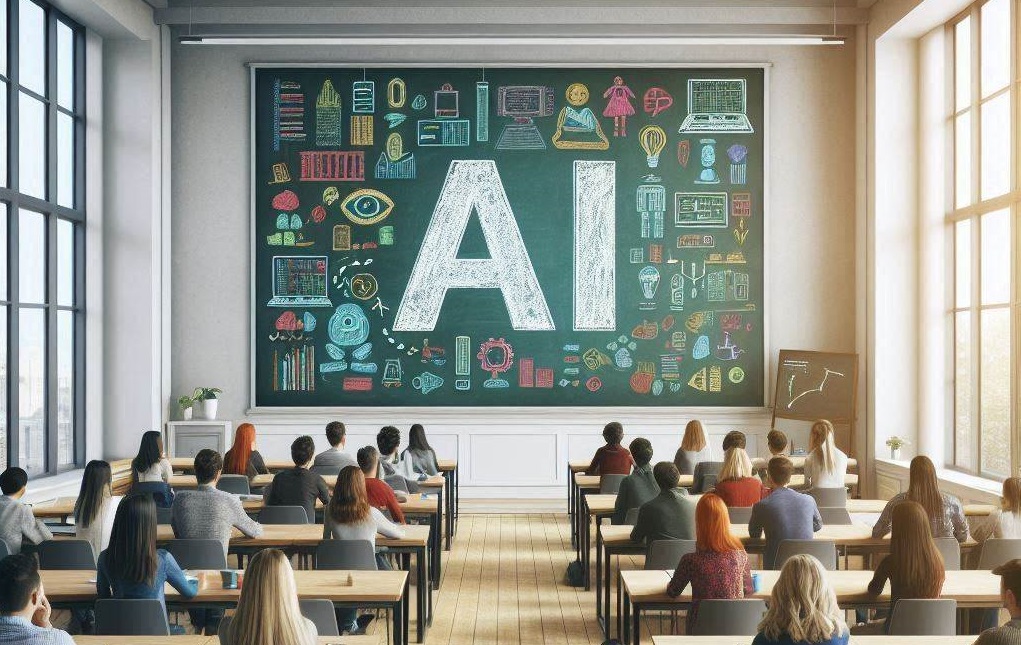

Marktcontext: bedrijfspush versus realiteit in de klas

Terwijl Silicon Valley deze tools als hulpmiddel voor ‘empowerment’ opvoert, dient de zaak Staffordshire als een grimmig tegenverhaal voor de marketing die momenteel de EdTech-sector overspoelt. Deze week nog lanceerde OpenAI ‘ChatGPT for Teachers’, waarmee de tool tot 2027 gratis wordt aangeboden aan onderwijzers in het basis-en voortgezet onderwijs, in een enorme strategie voor verliesleiders.

OpenAI VP Leah Belsky stelt dat “het doel hier is om ervoor te zorgen dat leraren toegang hebben tot AI-tools en een leraargerichte ervaring, zodat ze het gebruik van AI echt kunnen begeleiden.”

Toch gaat de realiteit ter plaatse vaak over in totale automatisering van het onderwijs. syllabus, zoals te zien in Staffordshire. Deze kloof benadrukt het risico van een “luie” implementatie, waarbij instellingen de instrumenten gebruiken om arbeid te vervangen in plaats van deze te vergroten.

Concurrenten strijden ook om deze ruimte. Google heeft onlangs Gemini for Education gelanceerd, hoewel hun betaalde model ($20-24/gebruiker) onder druk staat van het vrije niveau van OpenAI.

De verstoring hervormt de economie van de sector al, wat blijkt uit de ineenstorting van het personeelsbestand van Chegg eerder dit jaar, omdat studenten de traditionele hulpmiddelen omzeilen.

Het probleem van de’hallucinatie’– duidelijk zichtbaar in de Staffordshire-cursus over wetten van verkeerde landen – blijft echter een kritieke aansprakelijkheid voor betaalde onderwijsproducten. Nu universiteitsleiders een ‘Gouden Eeuw’ van technisch ondersteund onderwijs voorstaan, duidt de ervaring van studenten op een steeds groter wordende kloof tussen bestuurlijk optimisme en onderwijskwaliteit.