Minder dan vier maanden na de onthulling van het videogerichte Segment Anything Model 2 heeft Meta SAM 3 en SAM 3D uitgebracht, waarmee de geavanceerde computer vision-modellen onmiddellijk worden ingezet in consumentenproducten zoals Facebook Marketplace en Instagram.

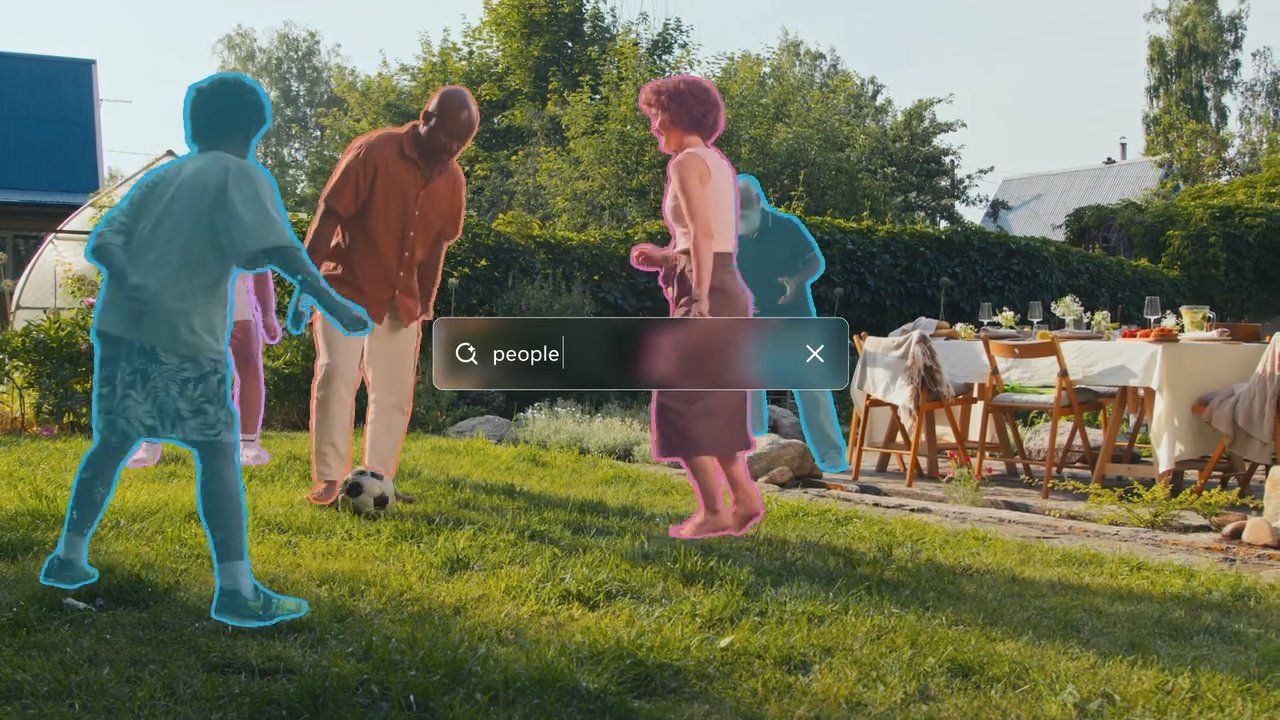

Beide tools geven computers een veel beter begrip van waar ze naar kijken. Met SAM 3 kunnen gebruikers een beschrijving typen en de AI onmiddellijk elk passend object in een foto of video laten vinden en markeren.

SAM 3D gaat een stap verder door een plat, tweedimensionaal beeld te nemen en te voorspellen hoe het object er vanuit andere hoeken uitziet, waardoor een standaardfoto effectief wordt omgezet in een roteerbaar 3D-model.

Terwijl eerdere iteraties grotendeels binnen het onderzoeksdomein bleven, markeert deze update een snelle verschuiving naar toegepaste bruikbaarheid, waarbij functies worden aangestuurd waarmee gebruikers meubels in hun huis kunnen visualiseren of effecten kunnen toepassen op specifieke objecten in video’s.

De nieuwe modellen introduceren’Promptable Concept Segmentation’, waardoor gebruikers in staat worden gesteld meubels in hun huis te visualiseren of effecten toe te passen op specifieke objecten in video’s.

De nieuwe modellen introduceren’Promptable Concept Segmentation’, waardoor gebruikers hun meubels in hun huizen kunnen visualiseren of effecten kunnen toepassen op specifieke objecten in video’s. tekstgestuurde identificatie van alle overeenkomende objecten in een scène, en hifi 3D-reconstructie uit afzonderlijke 2D-afbeeldingen – mogelijkheden die Meta beweert ruimschoots beter te presteren dan bestaande benchmarks.

De release van SAM 2 uit 2024 was sterk gericht op de efficiëntie van videosegmentatie, maar de aankondiging van vandaag breidt de reikwijdte aanzienlijk uit naar semantisch begrip en 3D-generatie.

Van onderzoek naar product: onmiddellijk Integratie

Meta doorbreekt de traditionele cyclus van onderzoek naar product en omzeilt de typische incubatiefase door SAM 3 rechtstreeks in zijn vlaggenschipapplicaties te integreren.

Facebook Marketplace-gebruikers zullen nu een’View in Room’-functie tegenkomen, mogelijk gemaakt door SAM 3D, waarmee potentiële kopers kunnen visualiseren hoe meubelitems er in hun eigen woonruimte uit zouden zien voordat ze tot een aankoop overgaan.

Deze applicatie maakt gebruik van de mogelijkheid van het model om reconstrueer 3D-objecten uit afzonderlijke 2D-afbeeldingen, waarmee een veelvoorkomend knelpunt in de online handel wordt aangepakt.

Tegelijkertijd gebruiken Instagram’s”Edits”-app en de”Vibes”-functie binnen Meta AI SAM 3 om nauwkeurige, objectspecifieke video-effecten mogelijk te maken. Makers kunnen nu aanpassingen zoals spotlighting of bewegingssporen toepassen op specifieke onderwerpen binnen een videoframe, taken waarvoor voorheen complexe maskering in professionele bewerkingssoftware nodig was.

Bekijken op Threads

Door deze processen te automatiseren, wil Meta geavanceerde visuele effecten tot een standaard maken, waardoor ze toegankelijk worden als standaardhulpprogramma’s voor informele gebruikers.

Om bredere experimenten mogelijk te maken, heeft het bedrijf de’Segment Anything Playground’gelanceerd, een webgebaseerde interface waarmee het publiek deze modellen kan testen zonder technische expertise.

Gebruikers kunnen afbeeldingen of video’s uploaden en het systeem voorzien van tekstbeschrijvingen om de segmentatiemogelijkheden in realtime te zien. Deze strategie staat in schril contrast met de uitrol van SAM 2, dat in de eerste plaats een hulpmiddel bleef voor de computer vision-onderzoeksgemeenschap.

De onmiddellijke implementatie in consumentenapps suggereert een strategische spil om AI-verbeteringen te benutten voor gebruikersbehoud en betrokkenheid in het sociale ecosysteem van Meta.

Technische sprong: conceptsegmentatie en 3D

SAM 3 introduceert een belangrijke mogelijkheid die’Promptable Concept Segmentation'(PCS) wordt genoemd. In tegenstelling tot zijn voorgangers, die zich richtten op het segmenteren van afzonderlijke objecten op basis van visuele aanwijzingen zoals klikken of vakjes, kan SAM 3 alle exemplaren van een concept dat door tekst wordt beschreven identificeren en maskeren.

Een gebruiker kan het model bijvoorbeeld aanwijzen met een’rode baseballpet’, en elk overeenkomend item in het frame zal worden gesegmenteerd. Deze verschuiving vereist dat het model zowel semantisch begrip van de tekst als nauwkeurige lokalisatiemogelijkheden bezit.

Om dit te bereiken, koppelt de architectuur herkenning los van lokalisatie met behulp van een’aanwezigheidstoken’. Dit mechanisme bepaalt eerst of een concept binnen het frame bestaat voordat het model het probeert te segmenteren, waardoor valse positieven worden verminderd en de algehele detectienauwkeurigheid wordt verbeterd.

Volgens het Meta Research Team “verdubbelt SAM 3 de nauwkeurigheid van bestaande systemen in zowel beeld-als video-PCS, en verbetert het eerdere SAM-mogelijkheden op het gebied van visuele segmentatietaken.”

Deze dubbele aanpak stelt het model in staat complexe zoekopdrachten af te handelen terwijl de hoge prestaties bij standaard segmentatietaken behouden blijven.

Meta Sam 3 Segment Anything with Concepten

Bij het genereren van 3D maakt SAM 3D de reconstructie van objecten en scènes uit één enkel 2D-beeld mogelijk, een taak waarvoor traditioneel meerdere gezichtspunten of dieptegegevens nodig waren. Meta beweert dat dit nieuwe model aanzienlijk beter presteert dan bestaande methoden.

Het Meta AI-team merkt op dat”in onderlinge menselijke voorkeurstests het een winstpercentage van ten minste 5:1 behaalt ten opzichte van andere toonaangevende modellen.”Dit is met name relevant voor toepassingen in augmented reality en gaming, waarbij snelle activageneratie cruciaal is.

Bekijk op Threads

Prestatiestatistieken vrijgegeven door Meta geven aan dat SAM 3 zeer efficiënt is. Het Meta Research Team stelt ook dat “SAM 3 in 30 milliseconden draait voor een enkel beeld met meer dan 100 gedetecteerde objecten op een H200 GPU.” Een dergelijke snelheid is essentieel voor real-time toepassingen op consumentenapparaten, waar latentie de gebruikerservaring kan verslechteren.

Voor menselijke reconstructie maakt SAM 3D Body gebruik van een nieuw open-sourceformaat.

“SAM 3D Body… maakt gebruik van een nieuw open source 3D mesh-formaat genaamd Meta Momentum Human Rig (MHR), dat verbeterde interpreteerbaarheid biedt door de skeletstructuur en de vorm van zacht weefsel te scheiden.”

Deze scheiding zorgt voor meer realistische en aanpasbare menselijke modellen, wat gevolgen zou kunnen hebben voor virtuele avatars en animaties.

Ondanks deze verbeteringen is het model niet zonder beperkingen. Het Meta AI-team geeft toe dat “SAM 3 moeite heeft om op een zero-shot-manier te generaliseren naar fijnmazige concepten buiten het domein, zoals het identificeren van specifieke termen waarvoor domeinkennis vereist is, zoals ‘bloedplaatjes’.”

Dit suggereert dat, hoewel het model robuust is voor gewone objecten, het wellicht verfijning of aanvullende gegevens nodig heeft om gespecialiseerde of zeldzame categorieën effectief te kunnen verwerken.

Data Engine en benchmarking

By Door gebruik te maken van een hybride data-engine kon Meta zijn trainingsgegevens aanzienlijk schalen. Het bedrijf ontwikkelde een systeem dat gebruik maakt van op lama’s gebaseerde “AI-annotators” om maskers te verifiëren en te controleren op volledigheid, een taak die alleen voor mensen onbetaalbaar traag zou zijn.

Meta legt uit dat “door bepaalde taken te delegeren aan AI-annotators – modellen die de menselijke nauwkeurigheid evenaren of overtreffen – we de doorvoer ruimschoots verdubbelen in vergelijking met een annotatiepijplijn die alleen door mensen wordt uitgevoerd.”

Deze aanpak maakte de creatie van de SA-Co-dataset mogelijk, die meer dan 4 miljoen unieke concepten bevat. en 52 miljoen maskers, die een rijk oefenterrein bieden voor de nieuwe modellen.

Naast de modellen heeft Meta de benchmark “Segment Anything with Concepts”(SA-Co) uitgebracht. Deze dataset bevat 207.000 unieke concepten die zijn ontworpen om de herkenningsmogelijkheden van open woordenschat te testen, waardoor de industriestandaard voor evaluatie wordt verlegd.

De data-engine ontgint ook iteratief’harde negatieven'(zinnen die niet in een afbeelding voorkomen maar in strijd zijn met het model) om de robuustheid tegen valse positieven te verbeteren.

Naast consumentenapps vindt de technologie ook toepassingen in wetenschappelijk onderzoek. Een partnerschap met Conservation X Labs heeft SAM 3 toegepast op de SA-FARI-dataset, wat helpt bij de geautomatiseerde monitoring van wilde dieren door middel van videosegmentatie. Deze use case demonstreert de potentiële bruikbaarheid van het model bij het verwerken van grote hoeveelheden niet-gecureerde videogegevens voor onderzoeksdoeleinden.

De release omvat modelgewichten, code en evaluatiedatasets, waarmee Meta’s strategie van open-sourcing van belangrijke AI-technologieën wordt voortgezet. Door deze tools beschikbaar te stellen, wil Meta industriestandaarden stellen en verdere ontwikkeling binnen de AI-gemeenschap aanmoedigen.

Toekomstig werk zal zich richten op het verbeteren van het vermogen van het model om complexe redeneervragen af te handelen door SAM 3 te combineren met Multimodal Large Language Models (MLLM’s), waardoor potentieel nog geavanceerdere interacties mogelijk worden.