Microsoft-onderzoekers hebben een nieuwe zijkanaalaanval beschreven, genaamd’Whisper Leak’, die het onderwerp van gecodeerde AI-chats kan raden, waardoor een fundamenteel privacyrisico in de AI-industrie wordt blootgelegd.

In een rapport liet het team zien hoe patronen in de grootte en timing van netwerkverkeer kunnen onthullen wat gebruikers bespreken, zelfs met TLS-codering. De fout treft 28 grote AI-modellen, waardoor een ernstig privacyrisico ontstaat voor gebruikers over de hele wereld. Een waarnemer op een netwerk kan gevoelige gesprekken over juridische of gezondheidsonderwerpen opmerken.

Na een openbaarmakingsproces dat in juni begon, zijn grote providers zoals OpenAI en Microsoft begonnen met het implementeren van oplossingen, maar het probleem wijst op een kernrisico bij het streamen van AI.

Hoe Whisper Leak Afluistert gecodeerde AI-chats af

De vindingrijkheid van de aanval ligt in het vermogen om te werken zonder de onderliggende TLS-codering te verbreken die de online communicatie beschermt. In plaats daarvan maakt het gebruik van de metagegevens die encryptie inherent bloot laat.

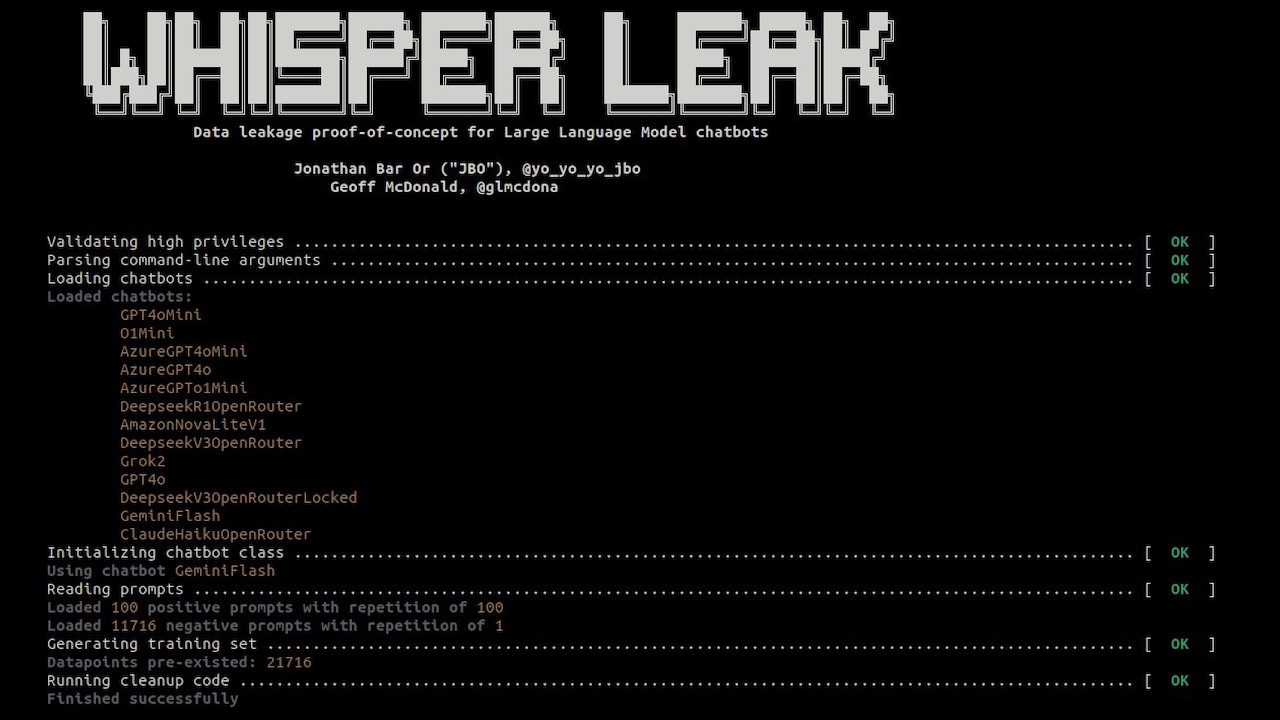

Volgens de projectdocumentatie is”Whisper Leak een onderzoekstoolkit die aantoont hoe gecodeerde, streaming gesprekken met grote taalmodellen promptinformatie lekken via pakketgroottes en timing.”

De methode omzeilt de inhoudbeveiliging door zich te concentreren op de vorm en het ritme van de gegevensstroom.

LLM-reacties, token-voor-token gegenereerd, creëren unieke reeksen datapakketten wanneer naar een gebruiker gestreamd. Elk onderwerp, van juridische analyse tot informele gesprekken, genereert tekst met verschillende woordenschat en zinsstructuren. Deze taalpatronen produceren een karakteristieke “digitale vingerafdruk” in het netwerkverkeer.

Door reeksen pakketgroottes en inter-aankomsttijden te analyseren, bouwden de onderzoekers classifiers om deze vingerafdrukken met hoge nauwkeurigheid te herkennen.

De openbare toolkit van het project bevestigt deze methode, die machine learning-modellen gebruikt om de subtiele handtekeningen van verschillende gesprekstypen te leren. Zelfs bij gecodeerde inhoud verraden de verkeerspatronen het onderwerp van het gesprek.

Een branchebrede fout die 28 grote AI-modellen beïnvloedt

Whisper Leak is geen op zichzelf staande bug, maar een systemische kwetsbaarheid die een groot deel van de AI-industrie treft. Het Microsoft-team testte 28 in de handel verkrijgbare LLM’s en ontdekte dat de meerderheid zeer gevoelig was.

Voor veel modellen bereikte de aanval een vrijwel perfecte classificatie. Onderzoekers merkten in een blogpost op: “Dit vertelt ons dat de unieke digitale ‘vingerafdrukken’ die zijn achtergelaten door gesprekken over een specifiek onderwerp duidelijk genoeg zijn voor onze AI-aangedreven afluisteraar om ze betrouwbaar te kunnen onderscheiden in een gecontroleerde test.”

Voor bedrijven die afhankelijk zijn van AI voor gevoelige communicatie, vormen de bevindingen een nieuwe en uitdagende bedreigingsvector. Het onderzoek toonde alarmerende precisie aan onder realistische omstandigheden.

In een simulatie met een verhouding van achtergrondgeluid tot doelgesprekken van 10.000: 1, identificeerde de aanval gevoelige onderwerpen met 100% nauwkeurigheid voor 17 van de 28 modellen, terwijl nog steeds 5-20% van alle doelgesprekken werd gedetecteerd.

Een passieve netwerkvijand, zoals een ISP, overheidsinstantie of een aanvaller op een openbaar Wi-Fi-netwerk, zou dit kunnen doen identificeer op betrouwbare wijze gebruikers die vertrouwelijke juridische, financiële of gezondheidskwesties bespreken.

Deze mogelijkheid maakt van gecodeerde AI-chats een potentiële bron voor gerichte surveillance. Zoals de onderzoekers stellen:”Deze sectorbrede kwetsbaarheid brengt aanzienlijke risico’s met zich mee voor gebruikers die onder netwerktoezicht staan door ISP’s, overheden of lokale tegenstanders.”

Aanvalsprestaties (AUPRC) voor doel-LLM’s die worden gehost door de gespecificeerde providers en functiesets en aanvalsmodelarchitectuur. Hogere cijfers komen overeen met een hogere effectiviteit van de zijkanaalaanval. Metrieken worden berekend als een mediaan over vijf onderzoeken, waarbij per proef een willekeurige verdeling wordt uitgevoerd. De kolom ‘Beste’ is ook de beste vijf proefmediaan van de gebruikte modellen en functiesets. (Bron: Microsoft)

Een moeilijke oplossing: mitigatie en inconsistente reacties van leveranciers

Microsoft begon in juni 2025 met een verantwoord openbaarmakingsproces, waarbij alle 28 betrokken providers op de hoogte werden gesteld. Vanaf november waren de reacties gemengd.

Terwijl providers als OpenAI, Microsoft, Mistral en xAI actie ondernamen om de fout te patchen, merkt het rapport op dat andere leveranciers hebben geweigerd oplossingen te implementeren of niet hebben gereageerd.

Dit incident benadrukt een verontrustende inconsistentie in de manier waarop de industrie omgaat met nieuwe, AI-native bedreigingen. Het volgt op de weigering van Google in oktober om een kritieke “ASCII-smokkel”-fout in zijn Gemini-modellen op te lossen, die het classificeerde als een social engineering-probleem in plaats van een beveiligingsbug.

Het weerspiegelt ook een recente kwetsbaarheid voor data-exfiltratie in Claude van Anthropic, waar het bedrijf het rapport aanvankelijk verwierp voordat het een “procesprobleem” erkende.

Zoals beveiligingsonderzoeker Johann Rehberger in dat geval opmerkte: “veiligheid beschermt je tegen ongelukken. Beveiliging beschermt je. van tegenstanders.”Het onderscheid is van cruciaal belang naarmate AI-agenten autonomer worden en worden geïntegreerd met gevoelige gegevens.

Het oplossen van metadatalekken is niet eenvoudig. De onderzoekers evalueerden verschillende maatregelen, elk met aanzienlijke compromissen. Willekeurige gegevensopvulling, die nu door sommige providers wordt geïmplementeerd, voegt ruis toe aan de pakketgrootte, maar vermindert slechts gedeeltelijk het succes van aanvallen.

Een andere strategie, token batching, groepeert meerdere tokens voordat ze worden verzonden, waardoor individuele patronen worden verdoezeld. Hoewel dit effectief is bij grotere batchgroottes, kan dit het realtime, responsieve gevoel van een chatbot verslechteren, waardoor de gebruikerservaring wordt beïnvloed.

Een derde optie, het injecteren van synthetische’ruis’-pakketten, kan ook verkeerspatronen verdoezelen. Deze aanpak verhoogt echter de bandbreedteoverhead, een aanzienlijke kostenoverweging voor providers.

De aflevering laat zien dat naarmate AI steeds meer geïntegreerd raakt in gevoelige workflows, het beschermen van de privacy van gebruikers vereist dat er verder wordt gekeken dan content-encryptie om de patronen van digitale communicatie te beveiligen